随着以 GPT-4 和 OpenAI Deep Research 为代表的大规模语言模型(LLMs)及具备推理能力的 AI 智能体呈指数级发展,通用人工智能(AGI)的实现时间表被大幅提前,其能力正以前所未有的速度扩展。在我们站在有望于不远将来实现 AGI 的门槛之际,对齐问题——即确保这些系统保持真实、具备复杂推理能力,并符合人类价值观——正变得愈发关键。

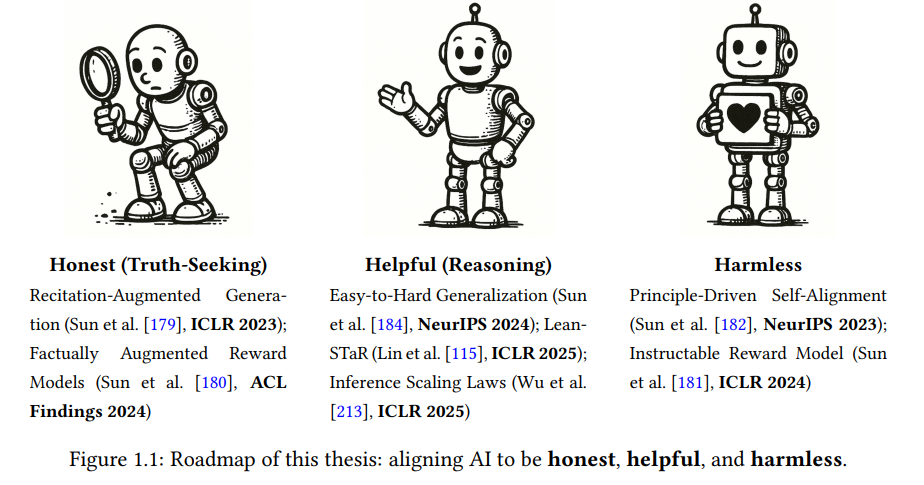

本论文提出了一系列创新方法,旨在应对面向超人类能力系统的基本对齐挑战。不同于传统范式(如监督微调 SFT 和基于人类反馈的强化学习 RLHF),我们提出了一种基于原则驱动的对齐方法(Principle-Driven Alignment),并在 AI 反馈强化学习(RLAIF)框架中实现了可扩展的对齐机制。该方法在模型能力扩展的条件下展现出对系统可靠性显著的提升。

为了减少生成内容中的事实性错误,我们引入了复述增强(Recitation Augmentation)与事实增强型 RLHF(Factually Augmented RLHF),这两种方法在大型语言模型和多模态模型中表现出强健的效果。此外,我们提出了**由易到难泛化(Easy-to-Hard Generalization)**框架,该方法基于“模型在评估解法方面通常比生成更可靠”的洞见,系统性地将简单问题训练出的奖励模型应用于复杂推理任务,从而实现高质量监督。

同时,我们还提出了Lean-STaR 框架,该方法通过引导模型在生成正式解答前先进行非正式思考,有效提升了模型在定理证明中的表现。这一过程展示了“思维链推理(Chain-of-Thought Reasoning)”在增强自主决策能力及提高模型推理透明度方面的潜力。 本研究在 AI 发展的关键方向上作出了重要贡献,建立了在系统能力持续提升背景下维护对齐性的严谨理论与实践框架。实验结果表明,这些方法在保持模型性能可靠性的同时,能够有效对齐 AI 系统与基本人类价值观。这些框架为构建可扩展的对齐解决方案奠定了坚实基础,将深刻影响未来先进 AI 系统的设计与发展。

引言

人工智能领域正处于其演进过程中的关键节点,大规模语言模型(LLMs)与具备推理能力的 AI 智能体的指数级发展标志着这一转折点。GPT-4 和 OpenAI Deep Research 等系统的出现展现了前所未有的理解、推理与决策能力,加速了通用人工智能(Artificial General Intelligence, AGI)的发展进程 [23, 36, 140, 141, 191]。随着这些系统在多领域中展现出日益复杂的能力,一个关键挑战也随之浮现:在能力持续快速扩展的背景下,如何确保 AI 系统保持真实、具备稳健的决策能力,并与人类价值观保持根本一致。 传统的对齐方法,主要包括监督微调(Supervised Fine-Tuning, SFT)和基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF),在应对 AI 能力扩展方面面临显著限制 [144, 178]。其核心问题在于对人类监督与标注的高度依赖——而这种依赖,在面向可能在多个领域超越人类水平的系统时,尤为突出 [24]。这一局限凸显出迫切需要能够随着 AI 能力增长而有效扩展的新型对齐方法。 本论文提出了多个新颖的框架,以在 AI 能力接近甚至超过人类水平时维持系统的对齐性。我们的研究超越了传统的人类监督范式 [11, 16, 17, 38, 141, 144, 146],在对齐的多个维度上引入了可扩展的解决方案。 * 在第 2 章中,我们展示了基于原则驱动的上下文内对齐(principle-driven in-context alignment)在性能上可与传统的 SFT/RLHF 方法相媲美; * 第 3 章确立了 AI 反馈强化学习(Reinforcement Learning from AI Feedback, RLAIF)作为 RLHF 的可行替代方案,提升了对齐性与模型能力; * 第 4 章开创性地将上下文对齐用于减少大语言模型输出中的“幻觉”; * 第 5 章将该方法拓展至多模态领域,通过事实增强的奖励模型提高生成真实性; * 第 6 章提出了由易到难泛化(Easy-to-Hard Generalization)框架,用于增强自主推理能力; * 第 7 章则发展了 LeanSTaR 框架,通过融合非正式的“思维链”推理过程,提升定理证明的表现。

随着 AGI 潜在的出现,建立健全的对齐机制变得尤为关键。我们的研究预见了这一未来,提出的各类框架不仅应对了当前的对齐挑战,还为在 AI 能力持续提升的背景下实现可控性和有益性奠定了基础。这些工作旨在引导未来 AI 系统的发展方向,使其在超越人类能力的同时,始终与人类的价值观和目标保持一致,从而推动人工智能技术在社会中安全且有益的发展。