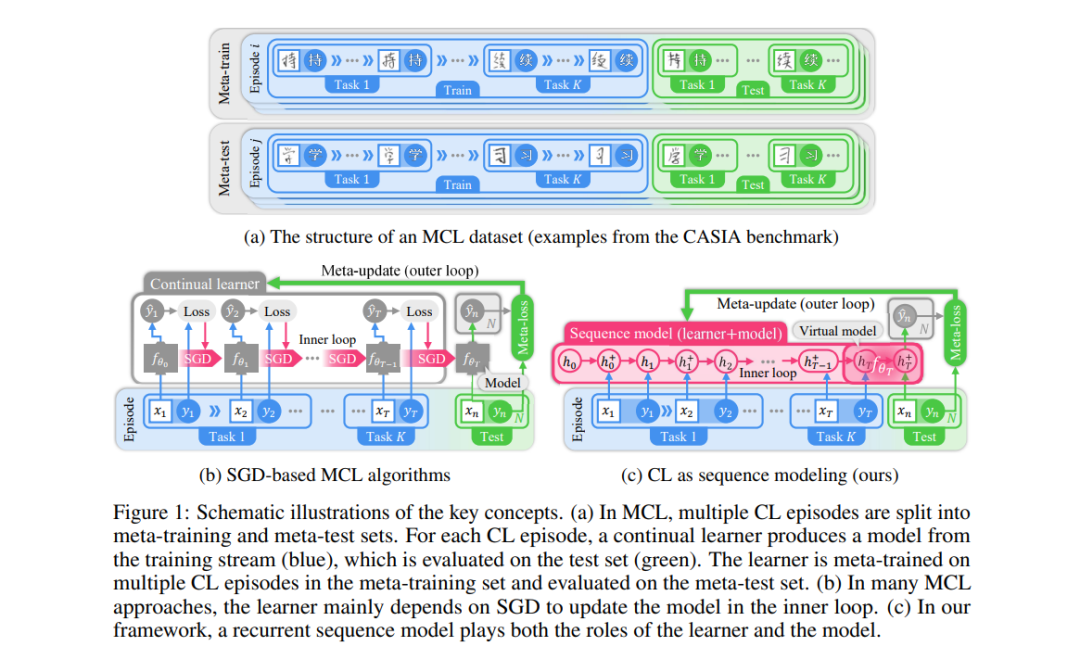

在这项工作中,我们旨在在两大重要的机器学习研究领域之间建立紧密联系:持续学习和序列建模。也就是说,我们建议将持续学习表述为一个序列建模问题,从而允许使用先进的序列模型来进行持续学习。在此表述下,持续学习过程变成了序列模型的前向传递。通过采用元持续学习(MCL)框架,我们可以在元级上训练序列模型,处理多个持续学习情节。作为我们新表述的一个具体示例,我们展示了Transformers及其高效变体作为MCL方法的应用。我们在七个基准测试上的实验,涵盖了分类和回归,显示序列模型可以成为一般MCL的有吸引力的解决方案。

https://www.zhuanzhi.ai/paper/94502ea5795b6b063f921a4b9876c8bd

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

221+阅读 · 2023年4月7日