抽象知识深植根于许多基于计算机的应用中。人工智能(AI)的一个重要研究领域是从数据中自动推导知识。机器学习提供了相应的算法。其中一个研究领域是生物启发学习算法的开发。各自的机器学习方法都是基于神经学概念,因此它们可以系统地从数据中获取知识并存储它。一种可以归类为深度学习模型的机器学习算法被称为深度神经网络(DNNs)。DNN由多层排列的多个人工神经元组成,通过反向传播算法进行训练。这些深度学习方法在从高维数据推断和存储复杂知识方面表现出惊人的能力。

然而,DNN会受到一个问题的影响,即无法将新知识添加到现有的知识库中。不断积累知识的能力是促进进化的重要因素,因此是发展强大人工智能的先决条件。所谓的“灾难性遗忘”(CF)效应导致DNN在对新数据分布进行几次训练迭代后,立即失去已经派生的知识。只有用过去和新数据的联合数据分布进行昂贵的再训练,才能抽象出整个新知识集。为了抵消这种影响,各种旨在缓解甚至解决CF问题的技术已经并且仍在开发中。这些已发表的CF回避研究通常暗示他们的方法对各种持续学习任务的有效性。

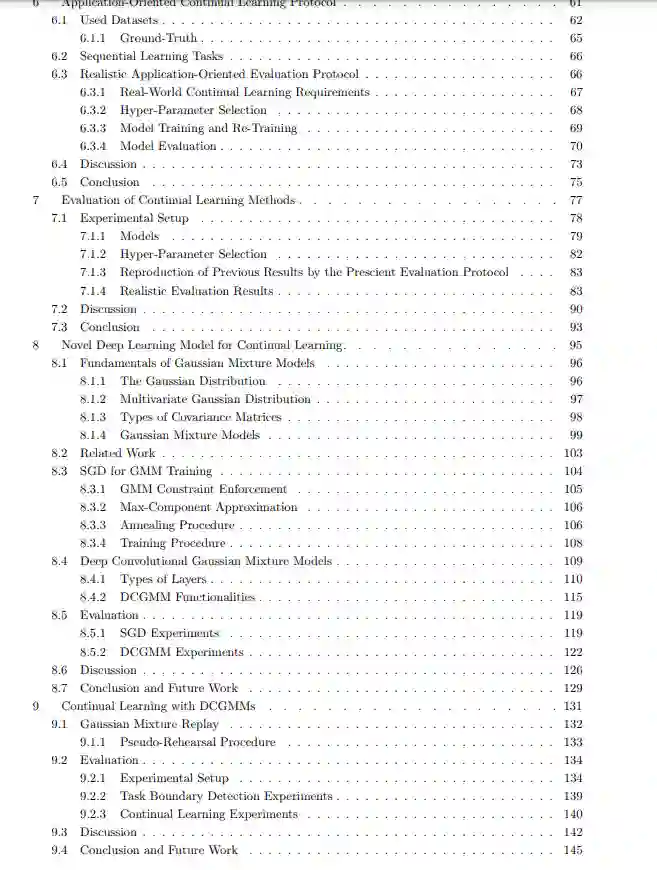

本文的研究背景是基于深度学习方法的持续机器学习。第一部分是面向实际应用的评估协议的开发,该协议可以用于研究不同的机器学习模型对协同效应的抑制。在第二部分,综合研究表明,在面向应用的需求下,所研究的模型都不能表现出令人满意的持续学习效果。第三部分提出了一种新的深度学习模型——深度卷积高斯混合模型(deep Convolutional Gaussian Mixture Models, DCGMMs)。DCGMMs建立在无监督高斯混合模型(GMMs)的基础上。gmm不能被认为是深度学习方法,它必须在训练前以数据驱动的方式进行初始化。这些方面限制了gmm在持续学习场景中的使用。本文提出的训练过程使使用随机梯度下降(SGD)(应用于dnn)来训练GMMs成为可能。集成退火方案解决了数据驱动的初始化问题,这是GMM训练的先决条件。实验证明,新的训练方法在不迭代其缺点的情况下,可以得到与传统方法相当的结果。另一个创新是GMM以层的形式排列,这类似于DNN。将GMM转换为层使其能够与现有层类型相结合,从而构建深层体系结构,从而可以用较少的资源派生出更复杂的知识。

在本工作的最后一部分,研究DCGMM模型的持续学习能力。为此,提出一种称为高斯混合重放(GMR)的重放方法。GMR利用DCGMM的功能来描述数据样本的生成和重现。与现有CF回避模型的比较表明,在面向应用的条件下,GMR可以取得类似的持续学习效果。总之,所提出的工作表明,确定的面向应用的需求仍然是“应用”持续学习研究方法的开放问题。此外,新的深度学习模型为许多其他研究领域提供了一个有趣的起点。