大语言模型在执行需要自主决策的任务时,若缺乏充分的工具支持、提示工程或微调,通常表现不佳。尽管研究表明领域相关的程序性性知识能显著提升规划效率,但关于其如何改善LLM在可能需要隐式规划的自主任务上性能的评估研究仍较为缺乏。本文正式定义、实现并评估了一种利用分层任务网络形式的程序性知识的智能LLM工作流。实证结果表明,手动编码的分层任务网络能显著提升LLM在自主任务上的性能,使用分层任务网络可使200亿或700亿参数的LLM性能超越远大于其的1200亿参数LLM基线。此外,由LLM创建的分层任务网络也能提升整体性能,尽管效果稍逊。这些结果说明,利用来自人类、文档或LLM的专业知识来整理程序性知识,将成为改进LLM工作流的另一重要工具。

程序性知识通常描述了解决问题的步骤序列,并在人工智能领域扮演重要角色。例如,在近50年的自动规划研究中,程序性知识已有效应用于诸多领域,包括将抽象任务分解为具体行动(27;2)、搜索控制规则(1)、学习宏操作符(6)、计划识别(7)、基于知识的规划(18)以及规划与执行(8)等,仅举几例。程序性知识在认知系统(17)中也居于核心地位,系统中的特定模块会管理并应用此类知识进行问题求解。近来,程序性知识被用作一种元策略来辅助解决复杂问题。

尽管LLM已展现出令人印象深刻的能力,但它们在规划问题上通常表现较差(13),并且正如后续将展示的,LLM的性能通常随任务复杂度的增加而下降。在复杂的自主任务中,成功完成任务往往依赖于一个规定了采取何种行动以及按何种顺序执行的隐式计划,而当前LLM常常无法稳定正确地完成这种能力。部分差距在于LLM主要基于预测下一个词元来构建,而规划则需要管理跨越不同时间范围和不同抽象层次的细节。LLM缺乏清晰易懂的方式来追踪在现实世界中采取行动所引发的变化。

相比之下,本文研究了提供显式程序性知识是否能改善LLM在自主任务上的性能。为提供一个直观示例(在第3节形式化),考虑预订旅行行程的任务。有经验的旅行者会遵循如下序列:预订航班、预订酒店、预约景点或餐厅。该序列可能因情况而异,但其存在使得问题更易解决。该序列管理着依赖关系(例如,在预订酒店前确认航班),并且每一步都缩小了后续步骤中需要考虑的细节。但使用抽象序列需要一个过程来:1)追踪整体流程的进展,2)维护跨步骤的状态变化,3)采取行动完成每一步,4)在继续之前验证每一步是否完成。

在解决此类旅行问题时,LLM缺乏同时追踪这些层次的能力,导致工作流低效或失败。例如,LLM可能在确认航班时间之前就预订了目的地的餐厅,结果只能回溯处理此类可预见的冲突。通过将复杂任务视为一系列独立决策而非关注相互关联的依赖关系,LLM难以利用程序性知识。

在本文中,探讨两个问题:能否将程序性知识嵌入LLM工作流?程序性知识是否会提升LLM性能?将证明这两个问题的答案都是肯定的!为此:

• 将该问题形式化为一个马尔可夫决策过程,并使用分层任务网络集成程序性知识,其中抽象任务被分解为全序子任务。分层任务网络确保逻辑一致性和资源可用性。

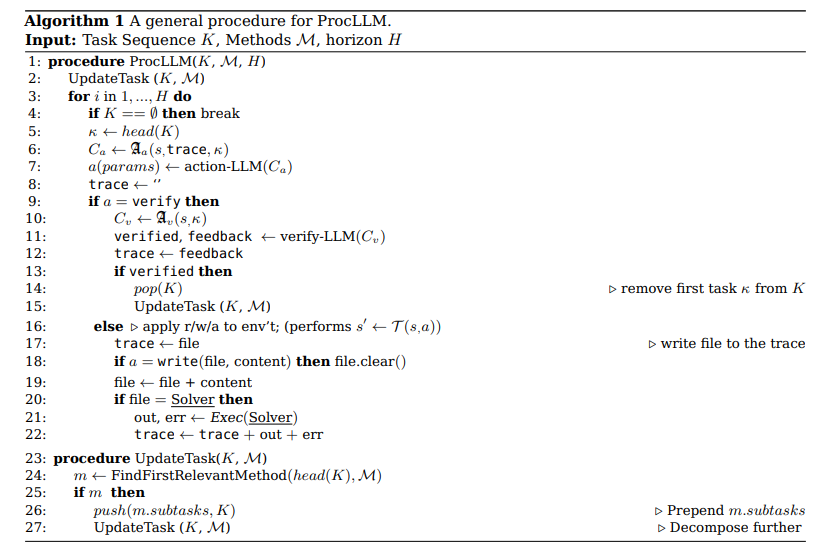

• 描述并实现了一个混合LLM-分层任务网络系统ProcLLM,该系统在智能LLM工作流中使用分层任务网络。重要的是,该工作流与任何LLM兼容。

• 在四个基准问题上评估了ProcLLM的运行时间、成功率和循环次数,其中两个问题来自文献,两个为合成问题。对于研究的问题和分层任务网络,分层任务网络知识总能提升LLM性能,且通常提升显著。

• 证明了较小的LLM能从此工作流中获益更多,并且在某些情况下性能超过了没有分层任务网络知识的远大于其的LLM。

• 最后,表明由LLM创建的分层任务网络也能提升性能,尽管与手动编码的分层任务网络相比结果好坏参半。

总体而言,这些发现表明LLM工作流可以显著受益于程序性知识,不仅体现在整体性能上,还体现在为达到相同性能水平所需模型规模的减小和响应时间的改善上。尽管实现使用了带有分层任务网络知识的智能LLM工作流,但该过程直接,结果最终可能推广到其他LLM工作流,因此最后提出了一些可能的未来研究方向。

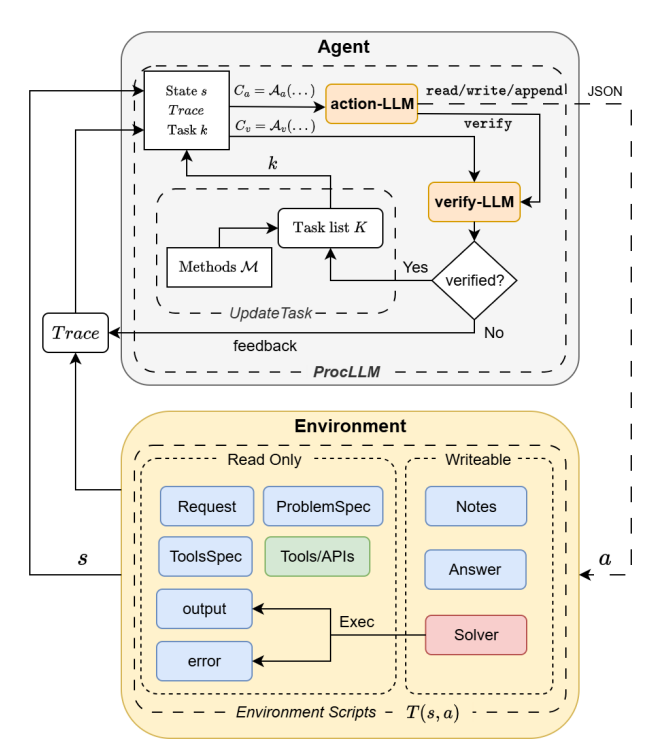

图2:系统概览(标注了MDP的组成部分)。蓝色框体表示文本文件,橙色框体表示大语言模型,红色框体表示Python文件,绿色框体表示API文件(脚本/数据库等)。