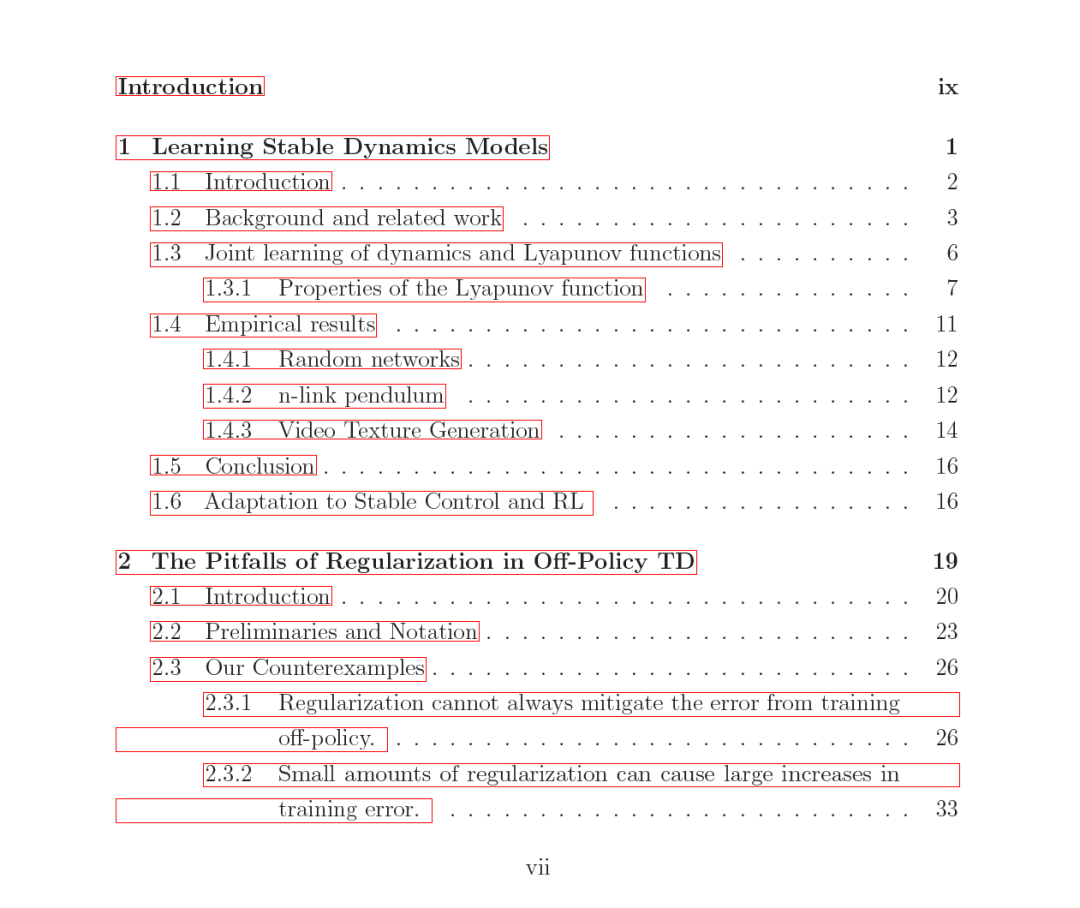

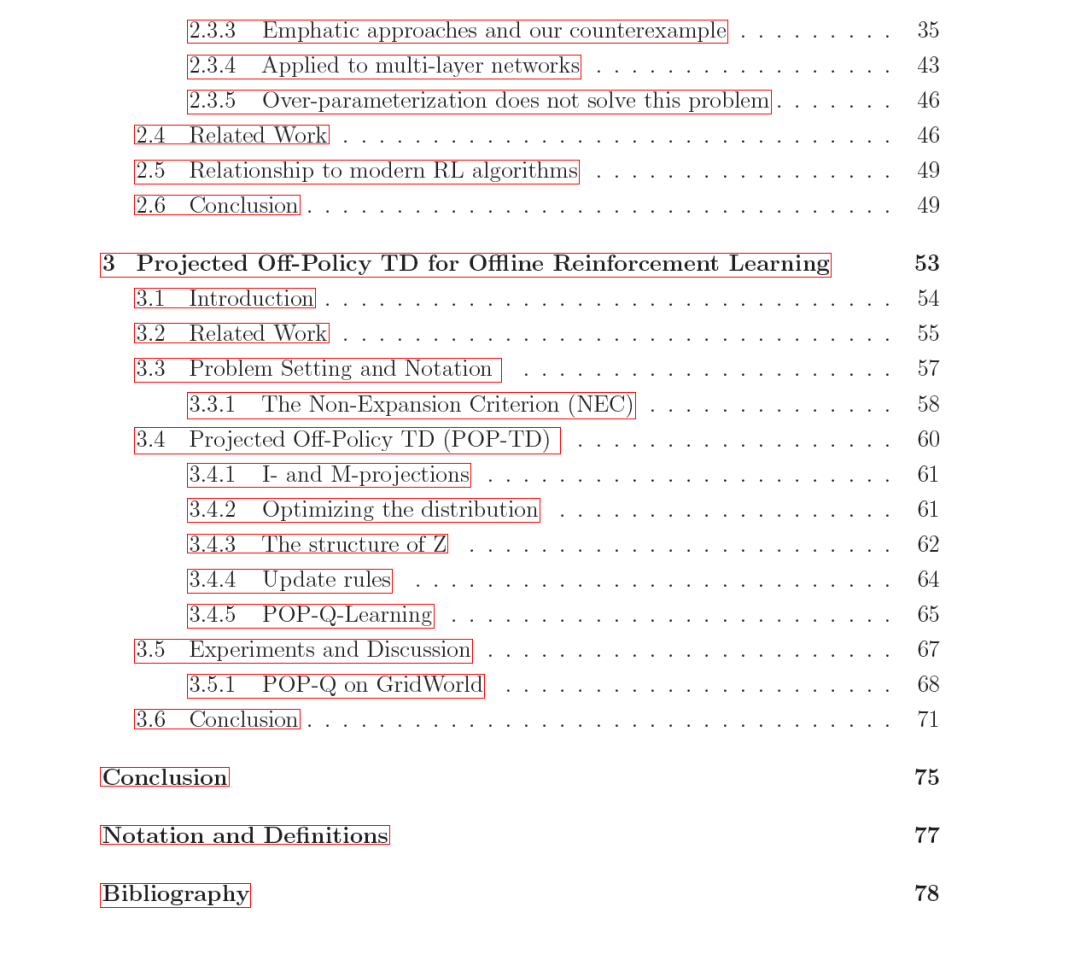

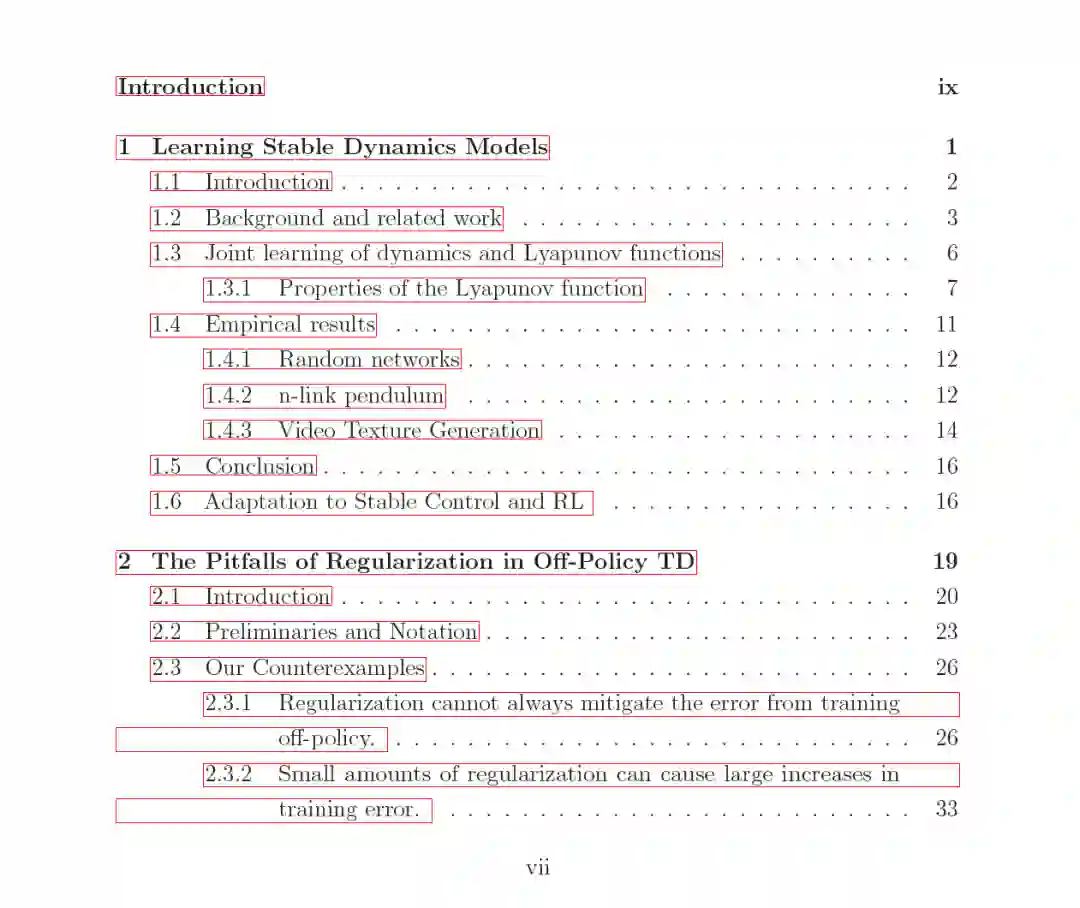

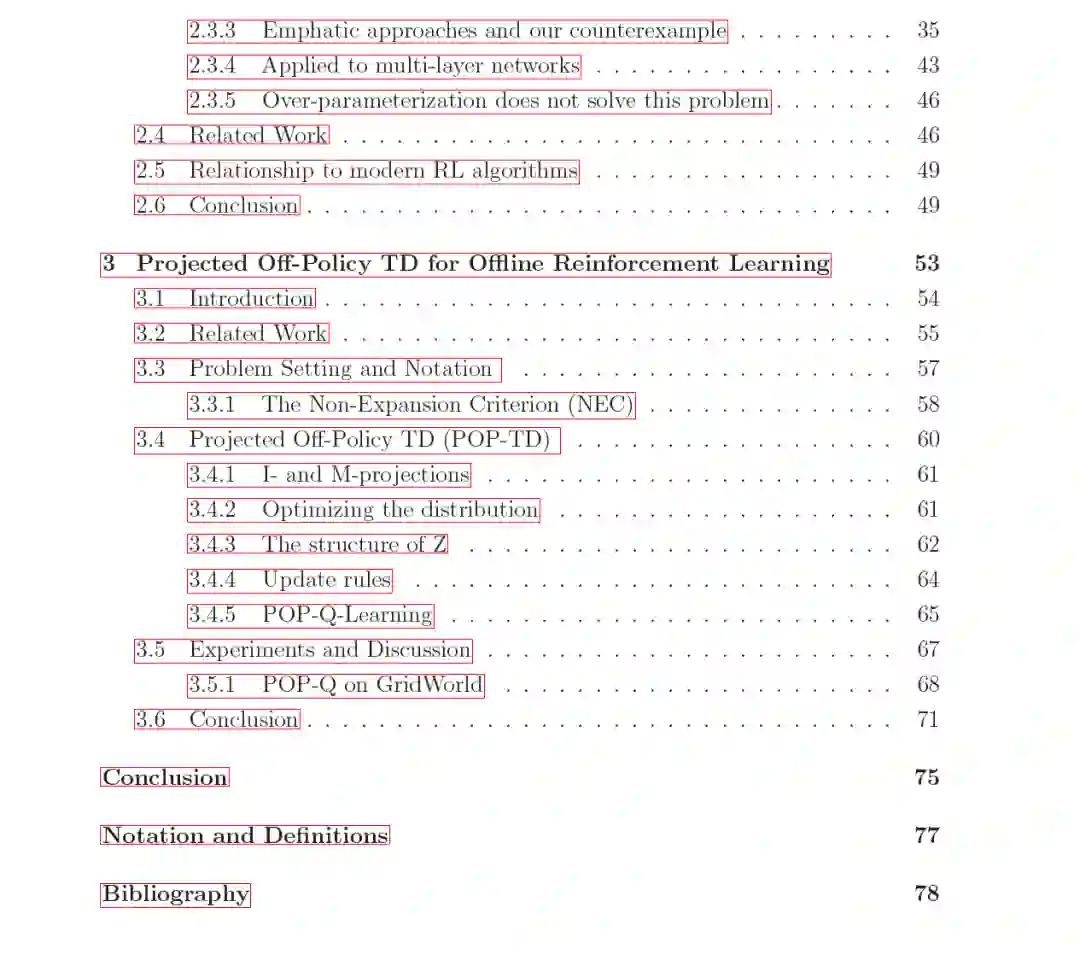

在这篇论文中,我们研究了稳定性的两个不同方面:神经网络动态模型的稳定性和强化学习算法的稳定性。在第一章中,我们提出了一种新的学习方法,可以构造出稳定的Lyapunov动态模型,即使在随机初始化时也是稳定的。我们通过对阻尼多连杆摆进行实验,展示了这种方法的有效性,并展示了如何用它来生成高保真的视频纹理。在第二章和第三章中,我们关注强化学习(RL)的稳定性。在第二章中,我们展示了正则化,一种常见的解决不稳定性的方法,在RL环境中的反直觉行为。它不仅有时无效,而且可能导致不稳定性。我们在线性和神经网络环境中都证明了这种现象。此外,标准的重要性采样方法也容易受到这种影响。 在第三章中,我们提出了一种通过重新采样来稳定离策略强化学习的机制。这种方法被称为投影离策略TD(POP-TD),它将TD更新重新采样为来自“安全”分布的凸子集,而不是(如在其他重新采样方法中)重新采样为在策略分布。我们展示了这种方法如何在一个设计为最大化此类转换的离线RL任务中缓解分布转换问题。总的来说,这篇论文提出了动态模型稳定性和强化学习训练稳定性的新方法,对该领域的现有假设提出了质疑,并指出了模型和强化学习稳定性的有前景的研究方向。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

153+阅读 · 2023年3月29日