【ACL2020】不要停止预训练:根据领域和任务自适应调整语言模型,Don't Stop Pretraining: Adapt Language Models to Domains and Tasks

题目: Don't Stop Pretraining: Adapt Language Models to Domains and Tasks

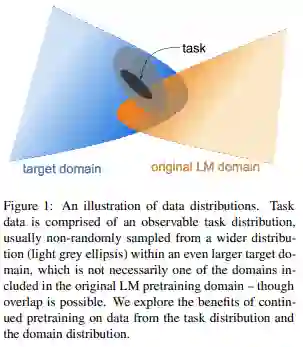

摘要: 语言模型预先从各种来源的文本训练,形成了今天的自然语言处理的基础。鉴于这些广泛覆盖模型的成功,我们研究了将一个预训练的模型裁剪到目标任务的领域是否仍然有帮助。我们提出了一项涉及四个领域(生物医学和计算机科学出版物、新闻和评论)和八个分类任务的研究,表明在高资源和低资源环境下,领域内的第二阶段训练(领域自适应训练)可提高性能。此外,适应任务的未标记数据(任务自适应预训练)甚至可以提高域自适应预训练后的性能。最后,我们证明使用简单的数据选择策略来适应扩充的任务语料库是一种有效的替代方法,特别是在域自适应预训练资源可能不可用的情况下。总的来说,我们一致发现,多相适应性训练在任务效果方面提供了很大的提高。

成为VIP会员查看完整内容

相关内容

Arxiv

7+阅读 · 2019年2月3日