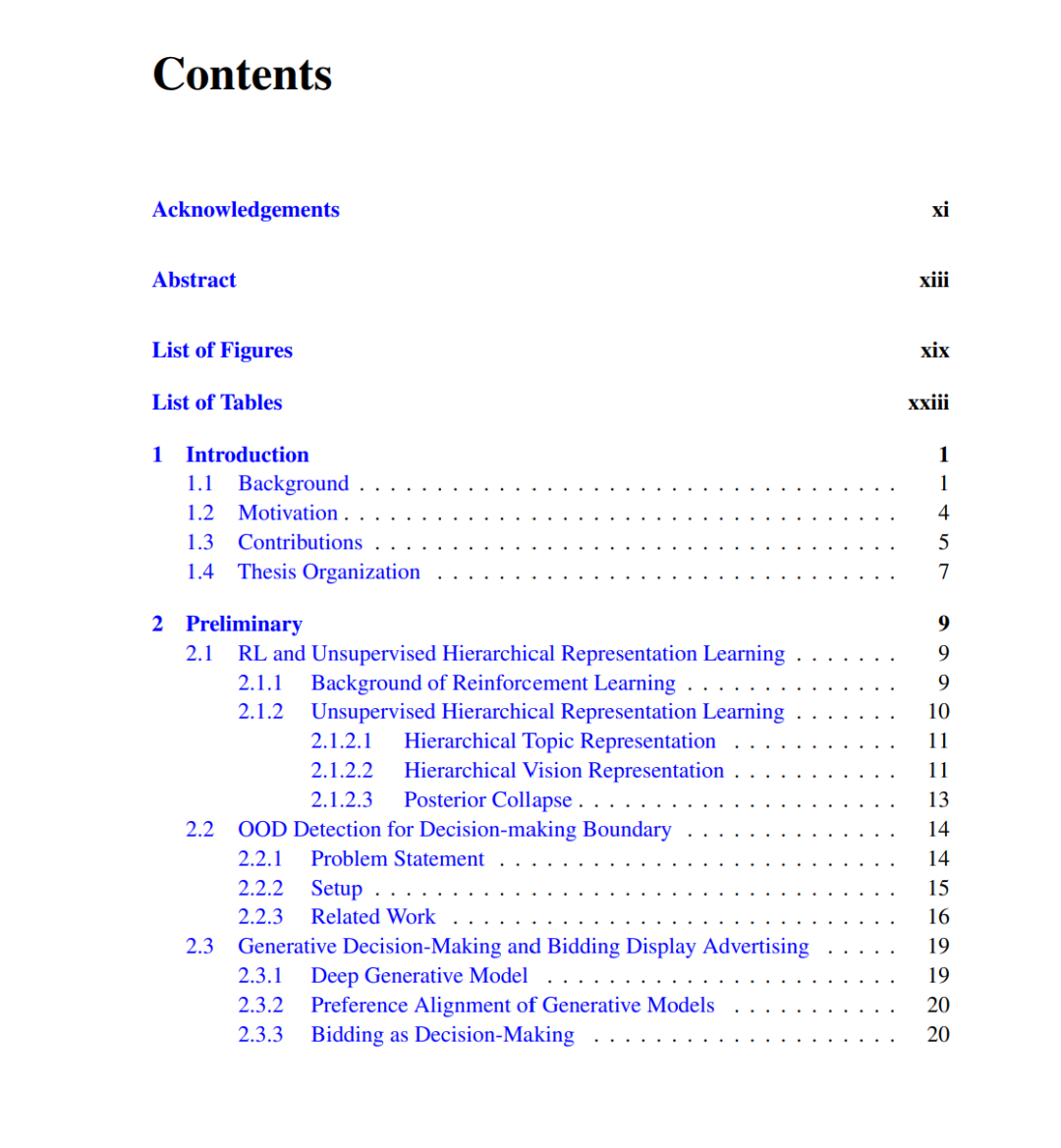

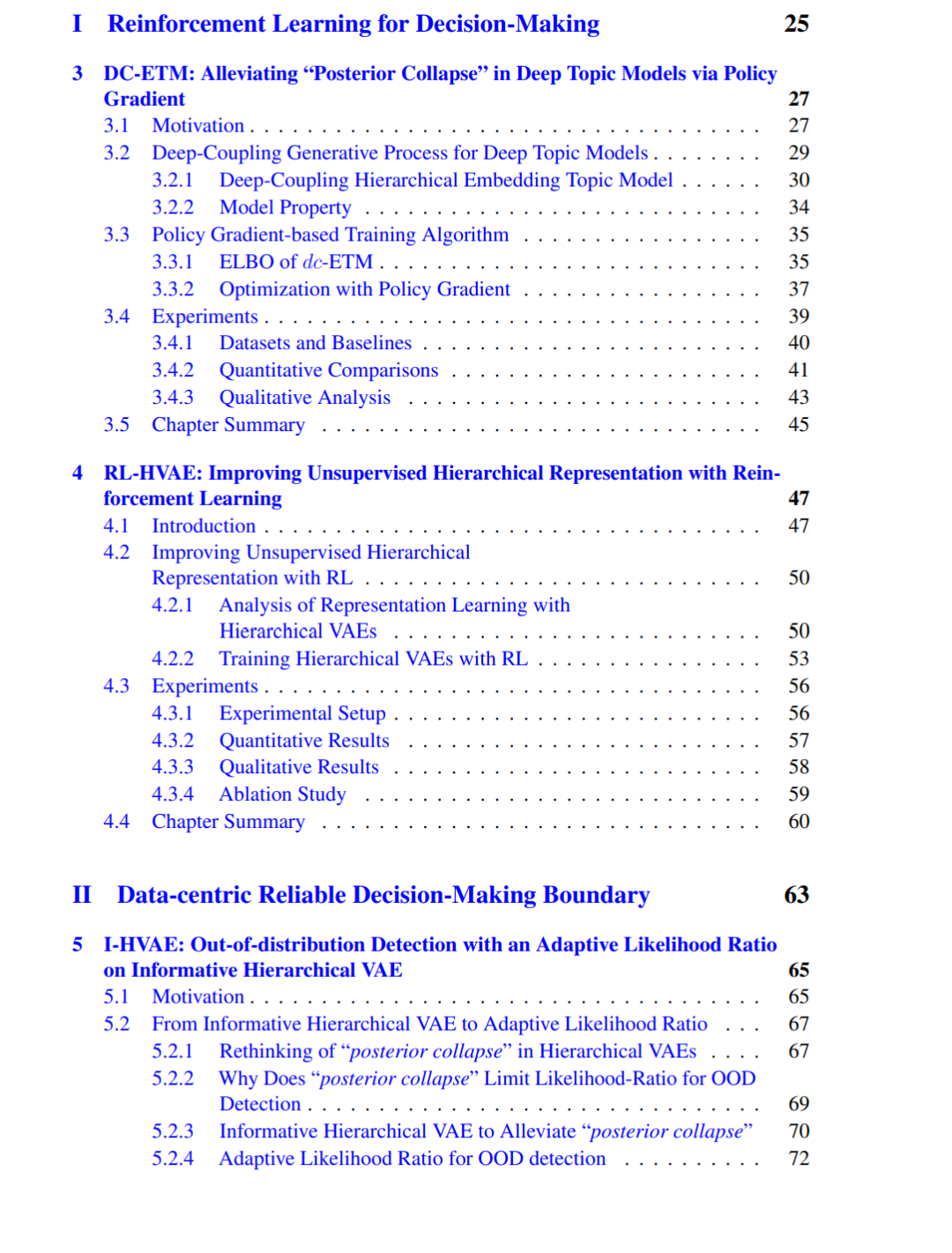

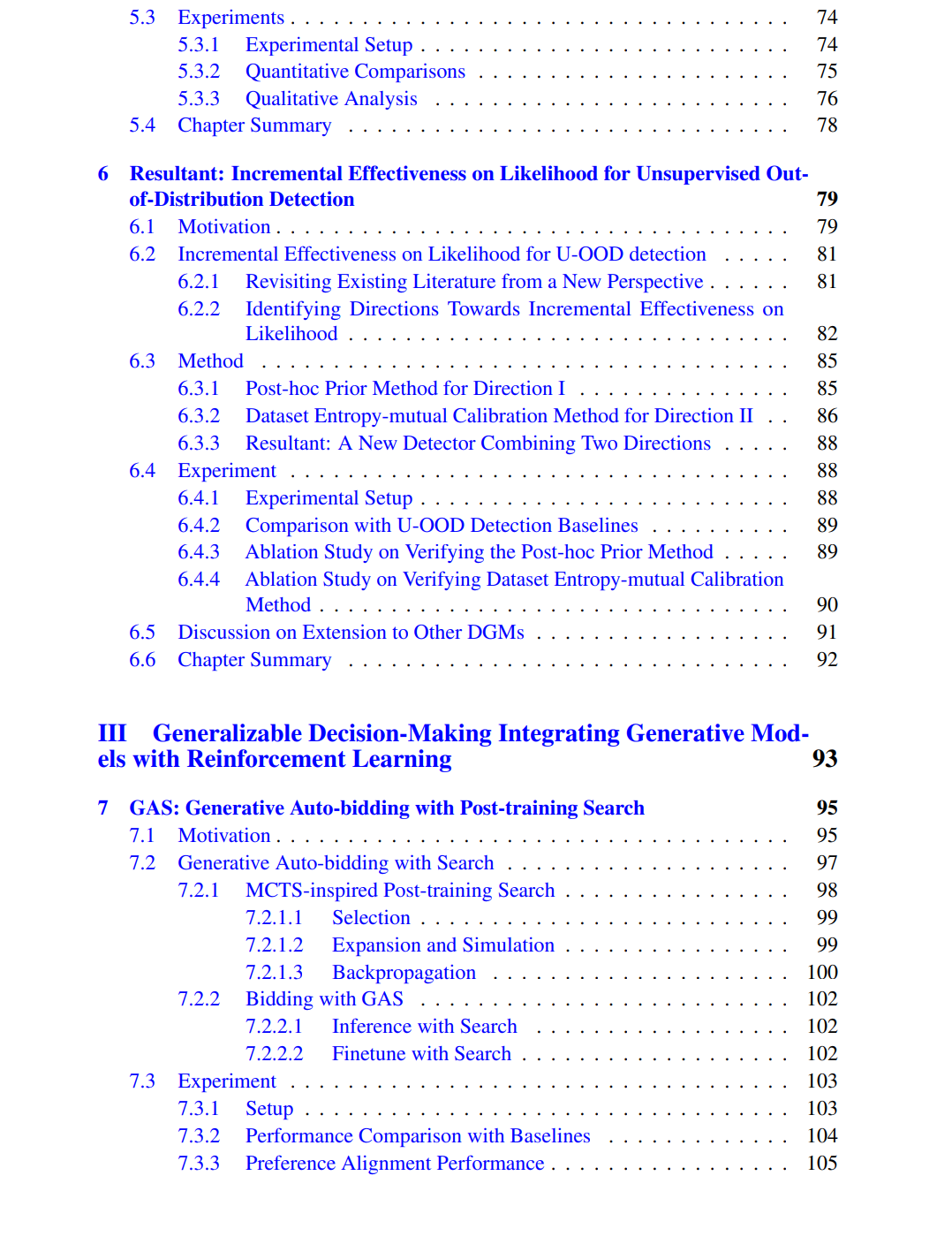

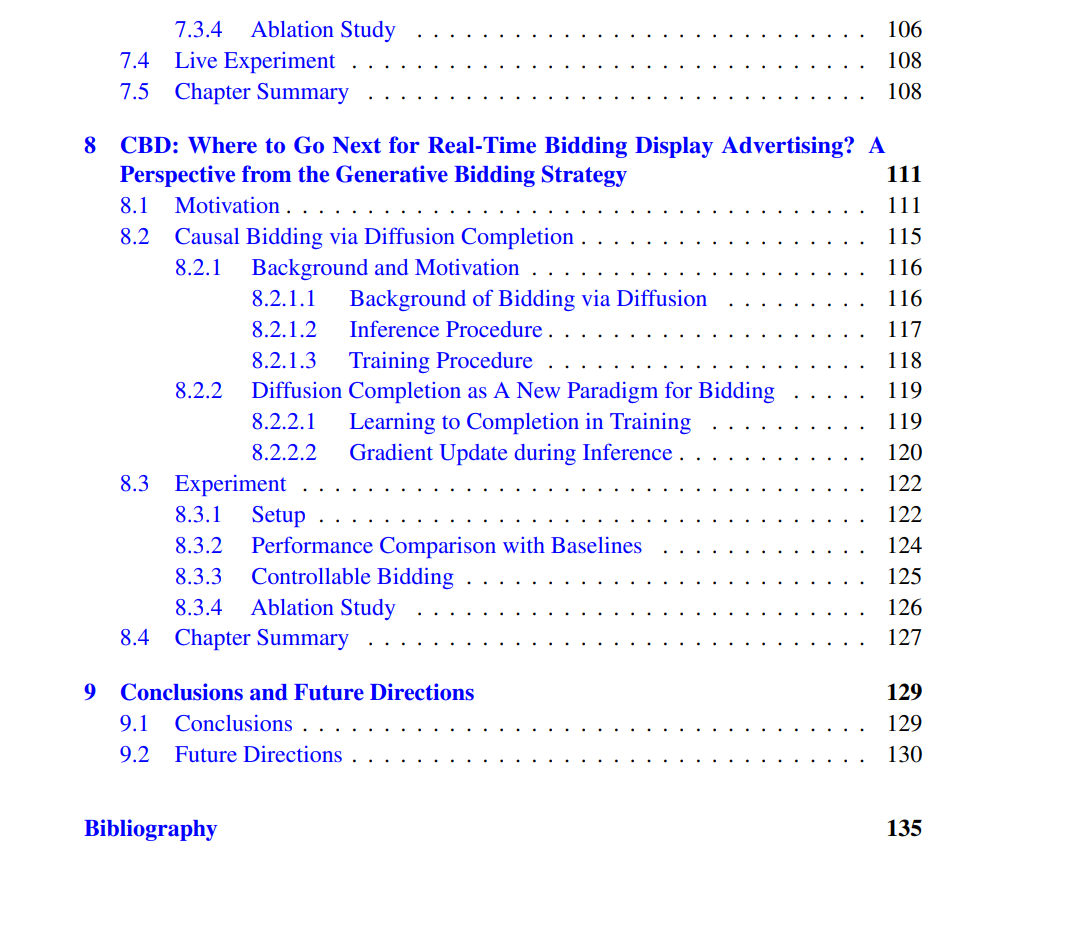

决策的目标是在有限观测的基础上采取最优行动以实现特定目标,它在战略博弈、金融投资方案以及公共政策等诸多领域中都发挥着关键作用。然而,在复杂环境中进行决策面临巨大挑战,其原因在于:环境观测与行动的高维不确定性、分布外(out-of-distribution, OOD)场景,以及多样化的目标偏好。这些复杂性引发了关于可靠性与泛化能力的担忧。可靠性要求决策算法在每一步都能表现良好并保持安全,而泛化能力则要求其在多样化场景中依然有效。因此,本论文聚焦于发展可靠且可泛化的决策算法。研究内容首先从设计稳定的强化学习(Reinforcement Learning, RL)方法入手,以提升高维环境中的序列决策性能;随后从数据中心化的视角,基于生成模型研究决策的安全边界;最后探索结合生成模型与强化学习的生成式决策方法,以突破决策边界并在多样化场景下实现高效表现。 RL 为解决序列决策任务提供了一种直接途径,但在高维随机序列推理任务中的应用依旧具有挑战。层次化无监督表征学习便是这样一类任务,它需要学习一系列高维层次表征,并且层级之间的转移遵循随机分布映射。这些表征的高维性与不确定性使得 RL 的应用尤为困难。为应对这一问题,我们提出 DC-ETM,其核心是设计了一种新的 RL 训练范式:通过引入源自原始训练目标的逐层奖励信号,并采用策略梯度方法进行训练。在此基础上,我们进一步提出一种更高效且更通用的 RL 训练过程,称为 RL-HVAE,其核心思想是强调信息传播,利用灵活的跳跃式生成路径技术保留最大化的历史信息,从而改进决策过程。实验结果表明,这些方法在解决序列表征推理过程中的坍塌问题方面表现出显著优势,凸显了 RL 在高维复杂决策任务中的可靠性与优越性。 可靠性问题不仅源自任务复杂性,还与部署挑战相关,尤其是在训练与部署环境存在差异时。这种差异常常导致模型在未知场景下性能退化。因此,识别决策的安全边界至关重要。我们的方法从模型输入数据出发,聚焦于识别训练数据分布边界,并拒绝超出该分布范围的决策。生成模型可通过最大化训练数据的似然性来帮助识别该边界,低似然数据则被视为 OOD。然而,已有研究广泛观察到生成模型可能会对 OOD 数据给出意外的高似然估计。为此,我们提出了一种实用方法 I-HVAE,通过自适应的对数似然比度量来衡量 OOD 程度,其核心思想是利用隐变量的后验分布与先验分布之间的一致性。此外,我们还探究了生成模型似然高估的根本原因,发现其源于 (i) 过于简化的先验分布设置和 (ii) 数据集熵。针对这两个因素,我们提出 Resultant 方法,并给出理论保证。通过识别决策的安全边界,这些方法从数据中心化的视角提升了决策模型的可靠性。 除了可靠性,实现跨任务设定的泛化能力同样重要。受大型生成模型(如 GPT 系列)成功的启发,我们探索了将这些模型与强化学习相结合以提升生成式决策的潜力。竞价任务是检验泛化能力的理想真实应用场景,因为其在开发生成式决策方法时面临偏好错位与解释能力不足的问题。在此背景下,我们提出了基于决策 Transformer 与后训练搜索的生成式竞价方法 GAS,用于解决偏好对齐问题。具体而言,该搜索基于 Q-learning,并采用 Q-voting 技术以增强性能。为了进一步提升方法的可解释性,我们又提出了基于扩散模型的生成式竞价方法 CBD。该方法通过生成未来轨迹并据此执行行动来完成决策,其中扩散器采用新颖的补全过程范式来处理竞价中的因果性问题,并结合轨迹级别的回报模型以提升决策表现。大量实验结果(包括真实部署结果)表明,上述两种方法均具有显著的有效性。