题目

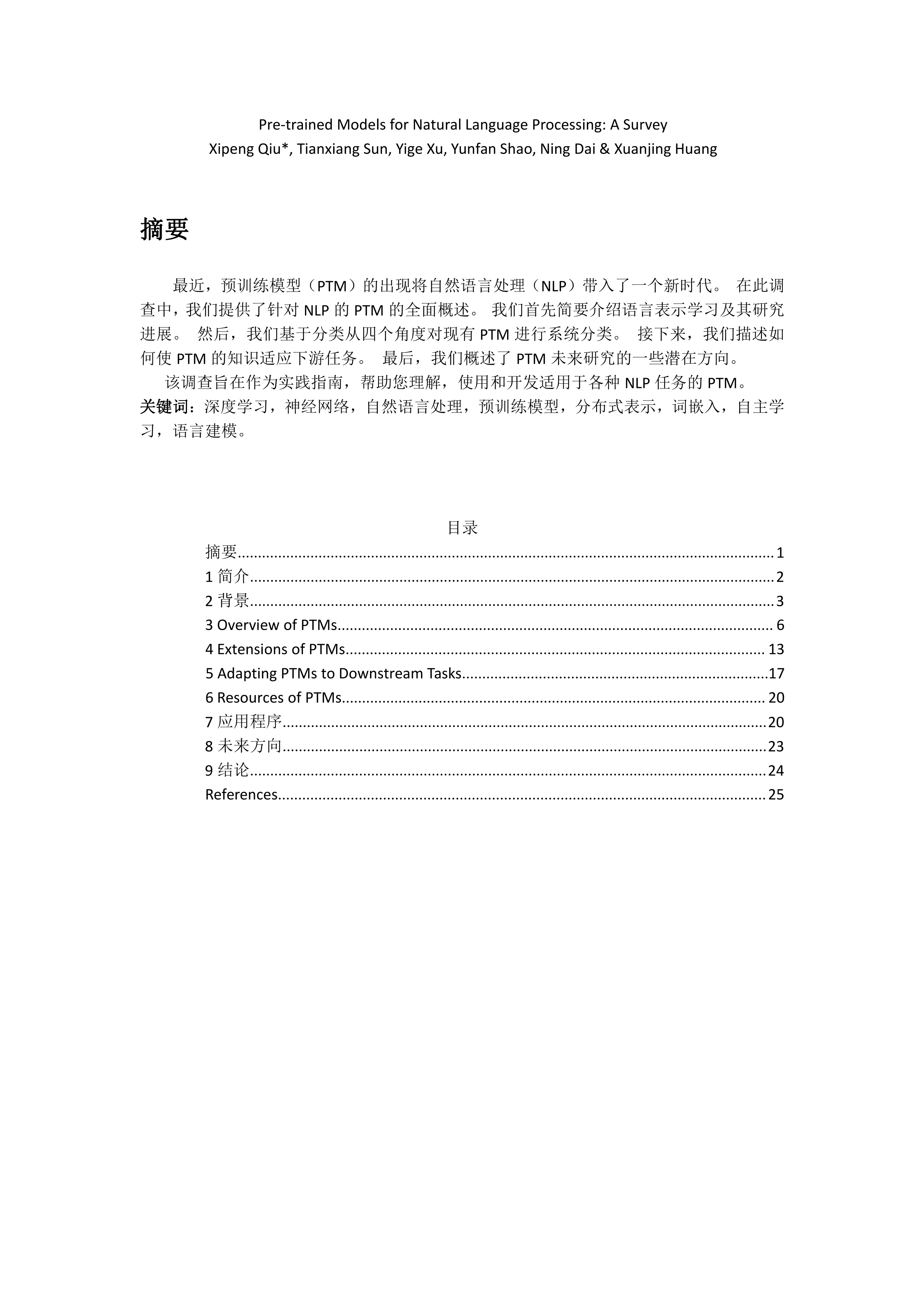

Pre-trained Models for Natural Language Processing: A Survey

关键词

预训练语言模型,深度学习,自然语言处理,BERT,Transfomer,人工智能

简介

最近,预训练模型(PTM)的出现将自然语言处理(NLP)带入了一个新时代。 在此调查中,我们提供了针对NLP的PTM的全面概述。 我们首先简要介绍语言表示学习及其研究进展。 然后,我们基于分类从四个角度对现有PTM进行系统分类。 接下来,我们描述如何使PTM的知识适应下游任务。 最后,我们概述了PTM未来研究的一些潜在方向。该调查旨在作为实践指南,帮助您理解,使用和开发适用于各种NLP任务的PTM。

作者

Xipeng Qiu, Tianxiang Sun, Yige Xu, Yunfan Shao, Ning Dai ,Xuanjing Huang

译者

专知成员,范志广

成为VIP会员查看完整内容

相关内容

专知会员服务

140+阅读 · 2020年7月10日

【ACL2020】不要停止预训练:根据领域和任务自适应调整语言模型,Don't Stop Pretraining: Adapt Language Models to Domains and Tasks

专知会员服务

46+阅读 · 2020年4月25日

专知会员服务

80+阅读 · 2020年3月5日

专知会员服务

58+阅读 · 2019年12月2日

Arxiv

4+阅读 · 2019年12月12日