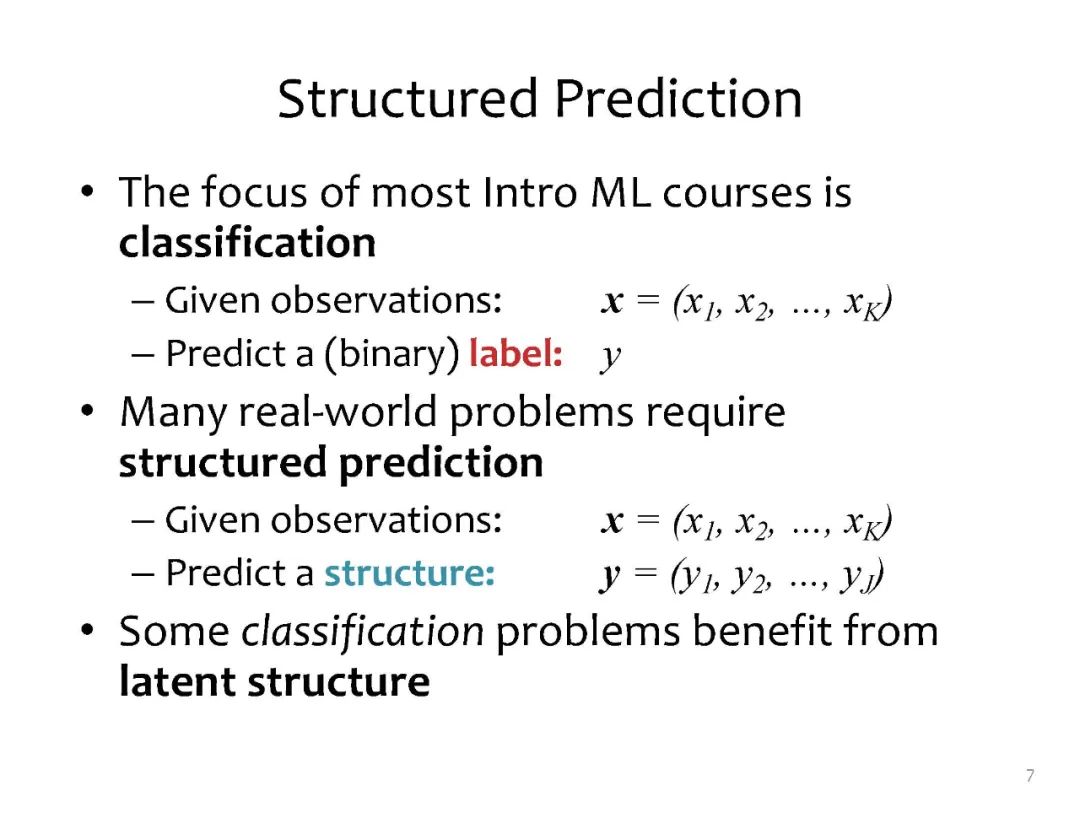

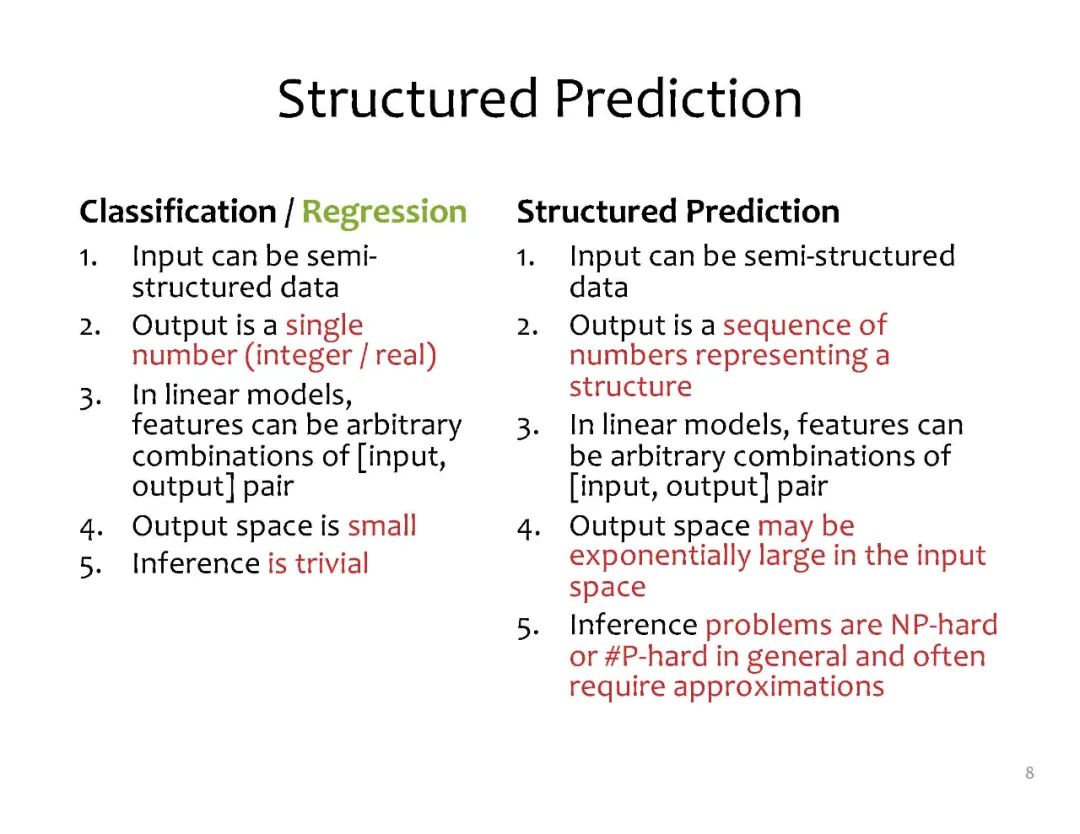

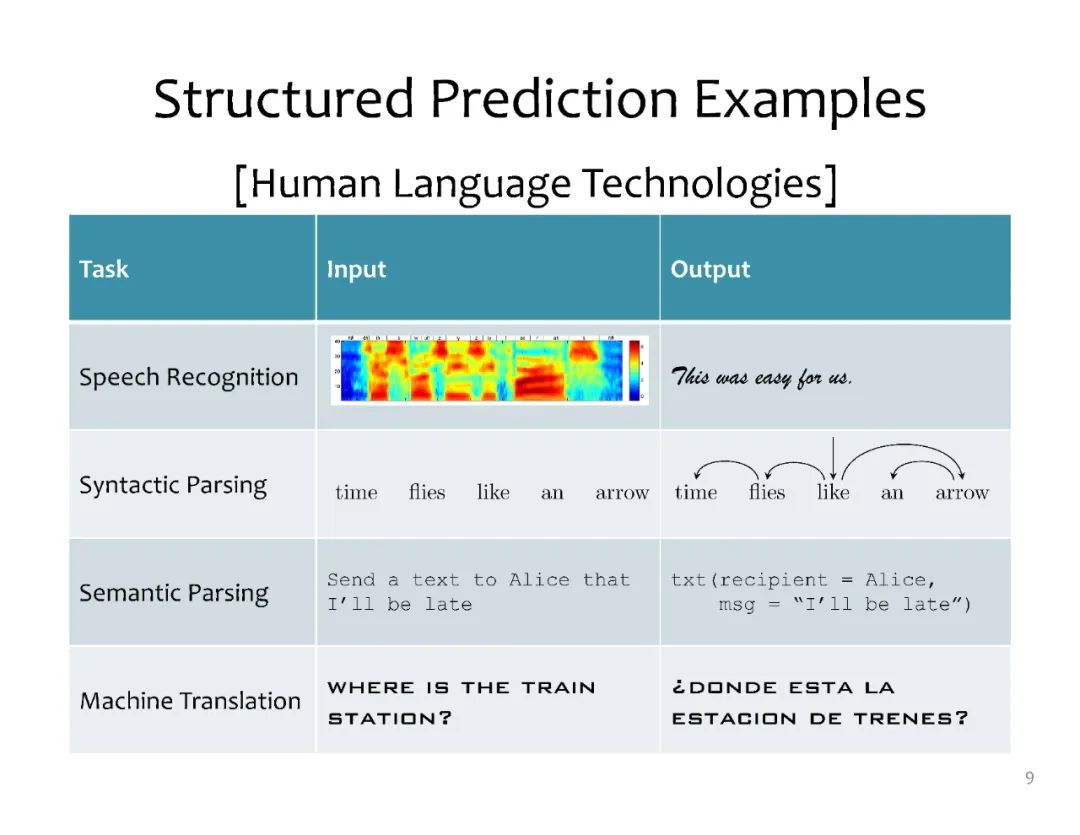

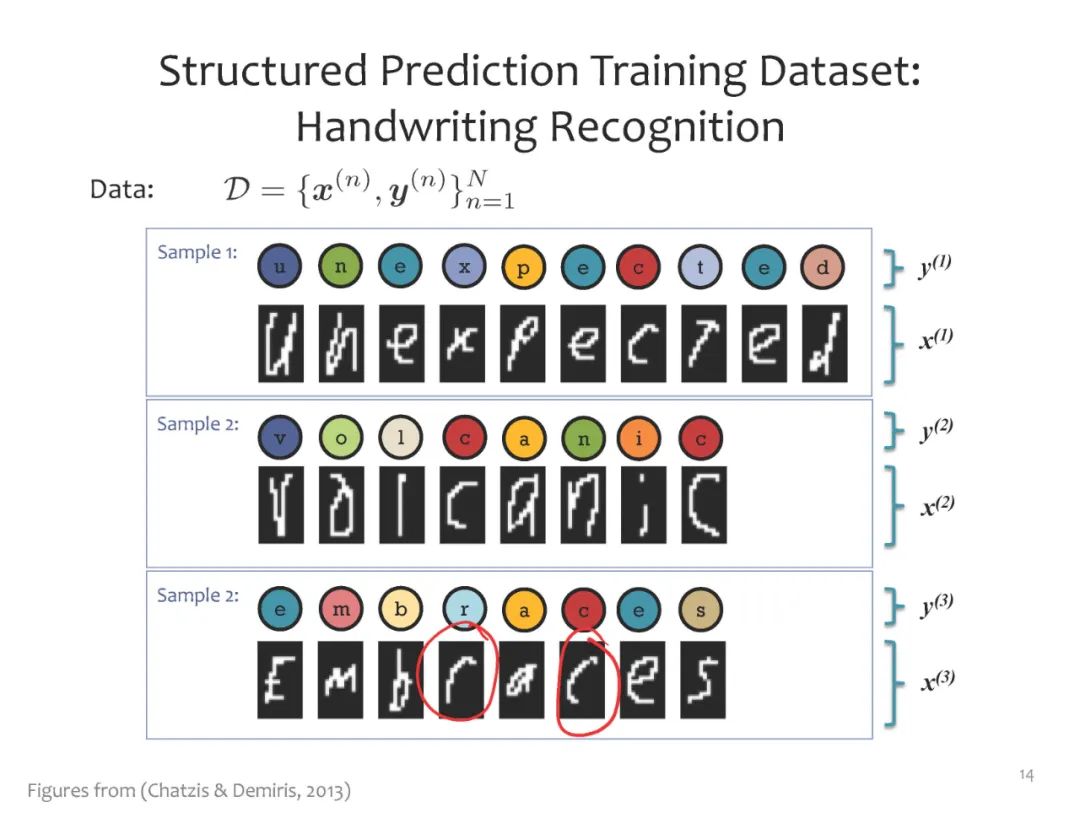

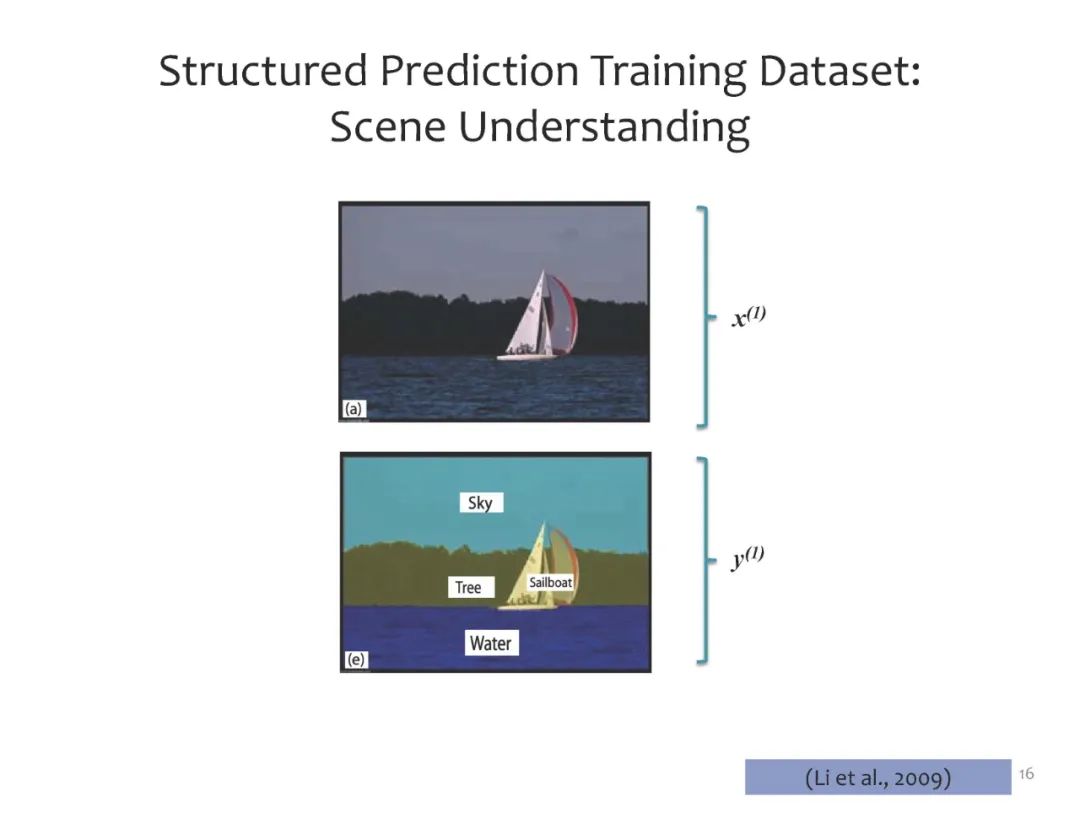

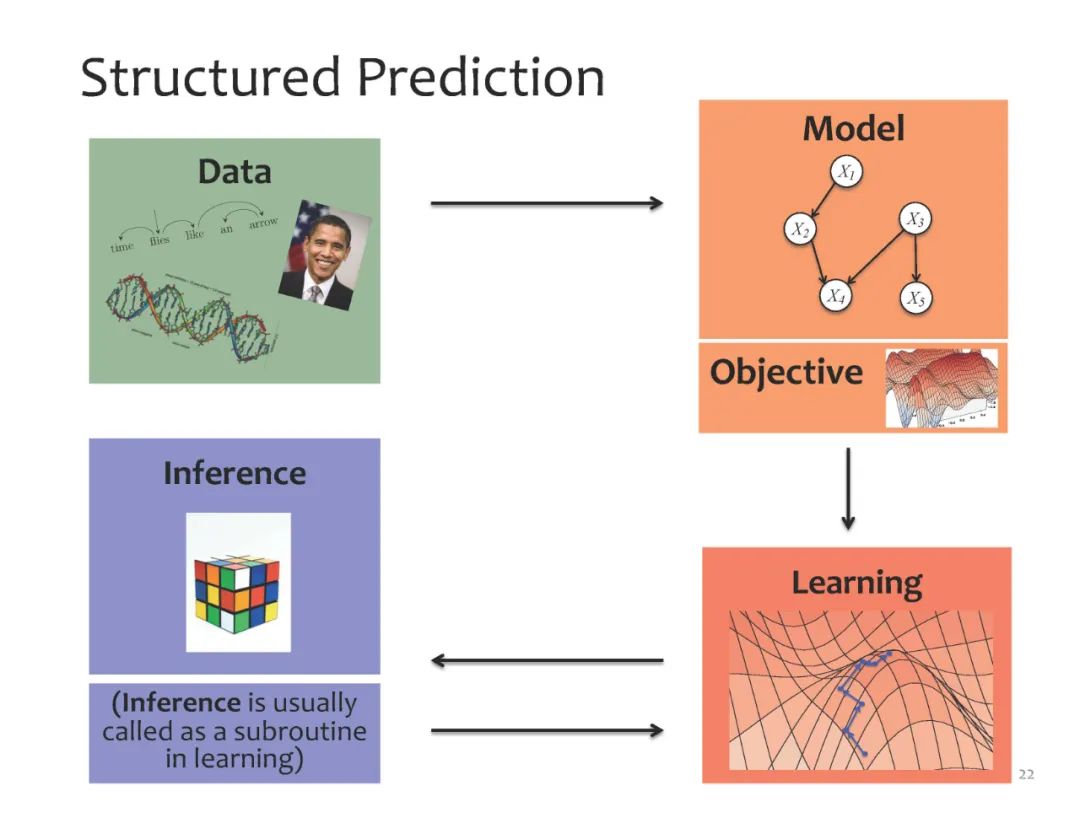

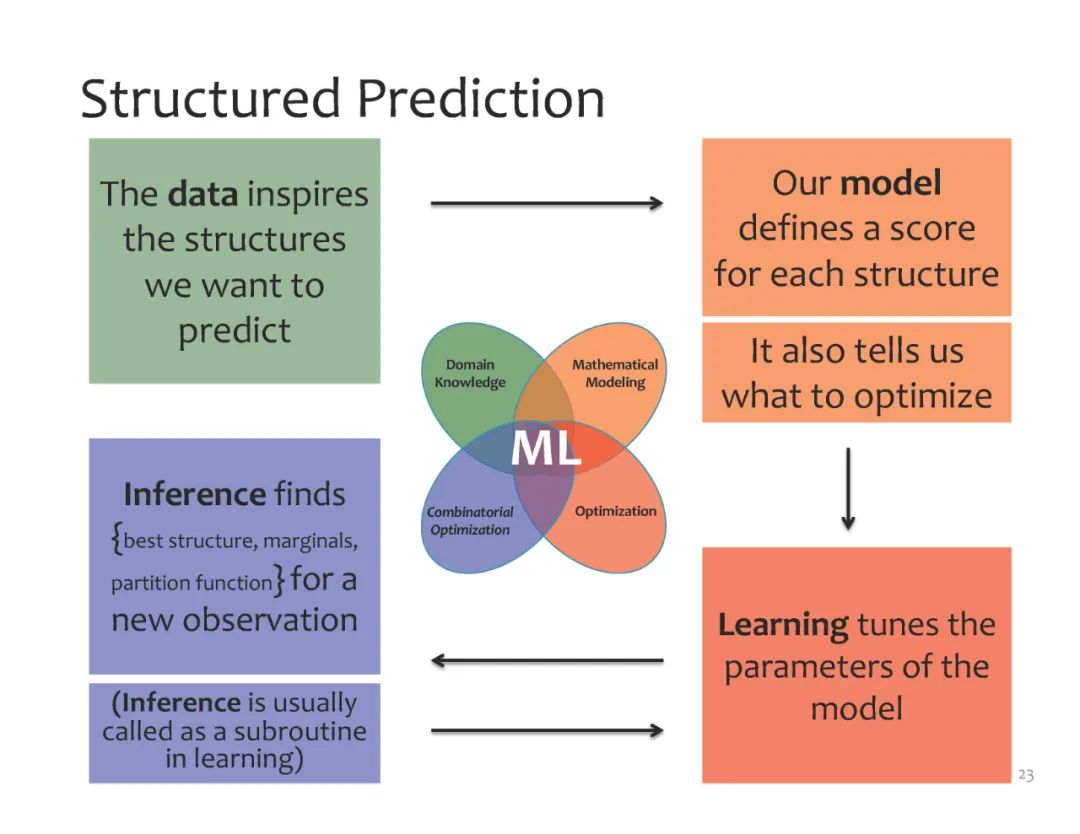

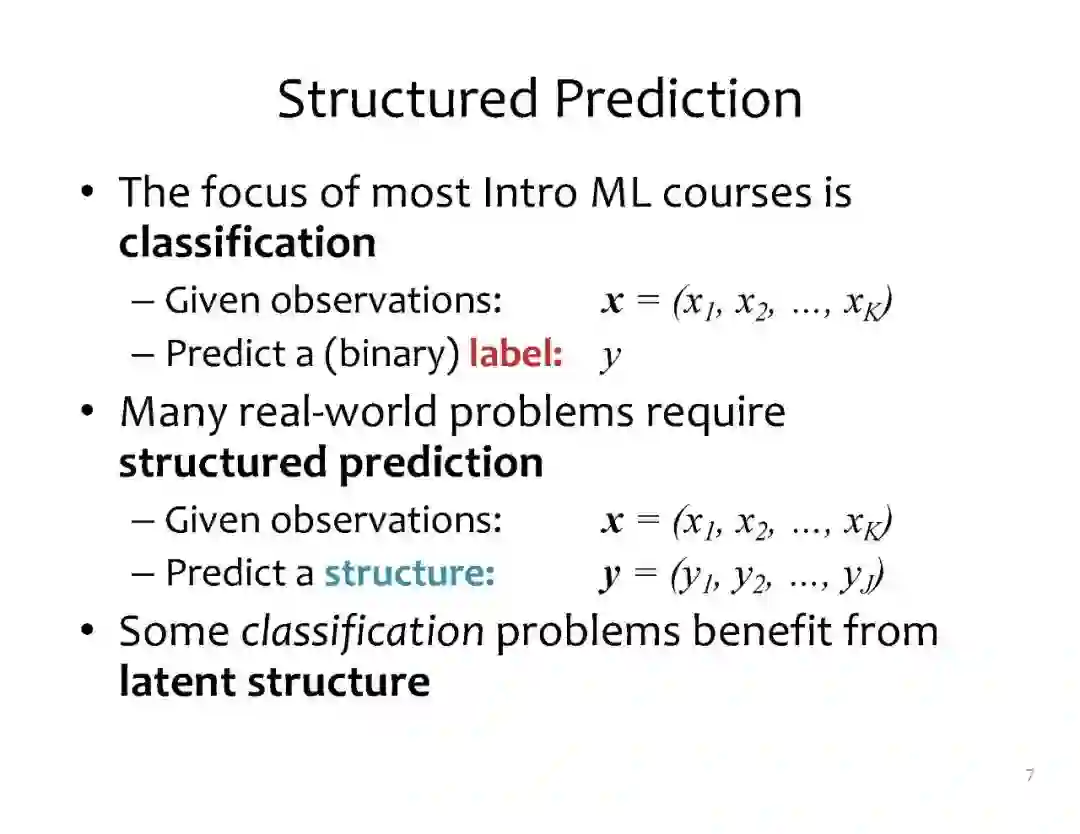

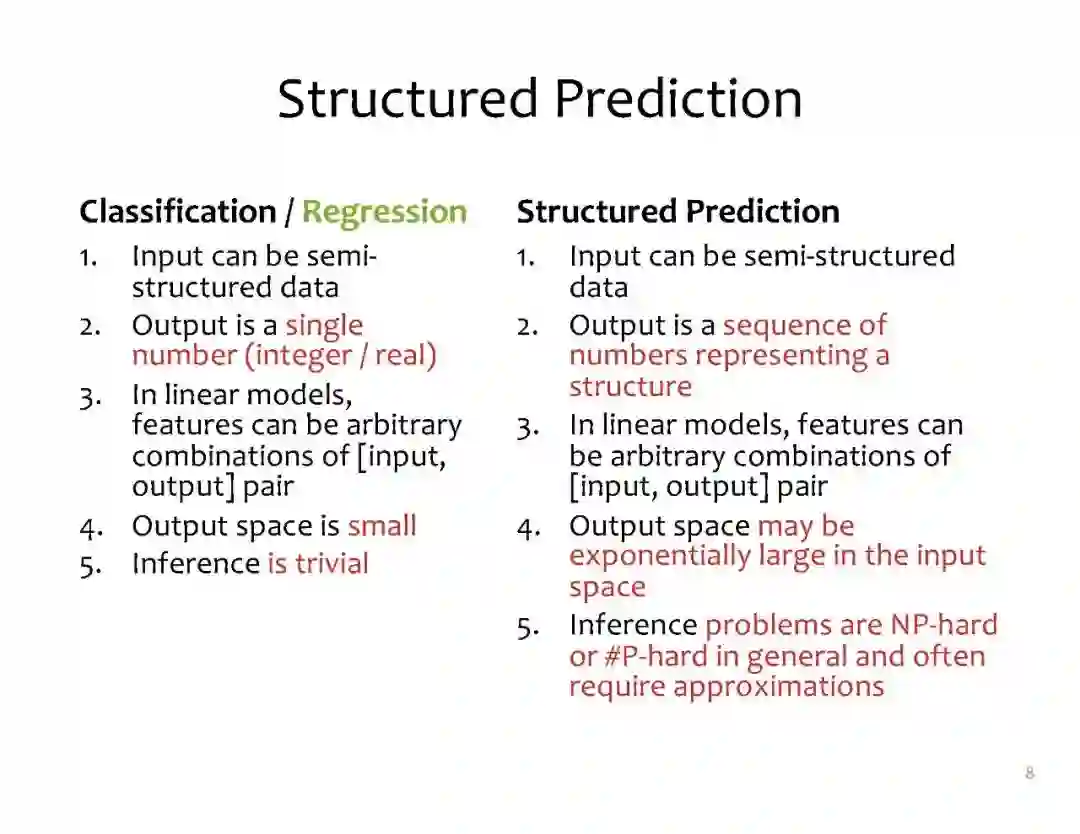

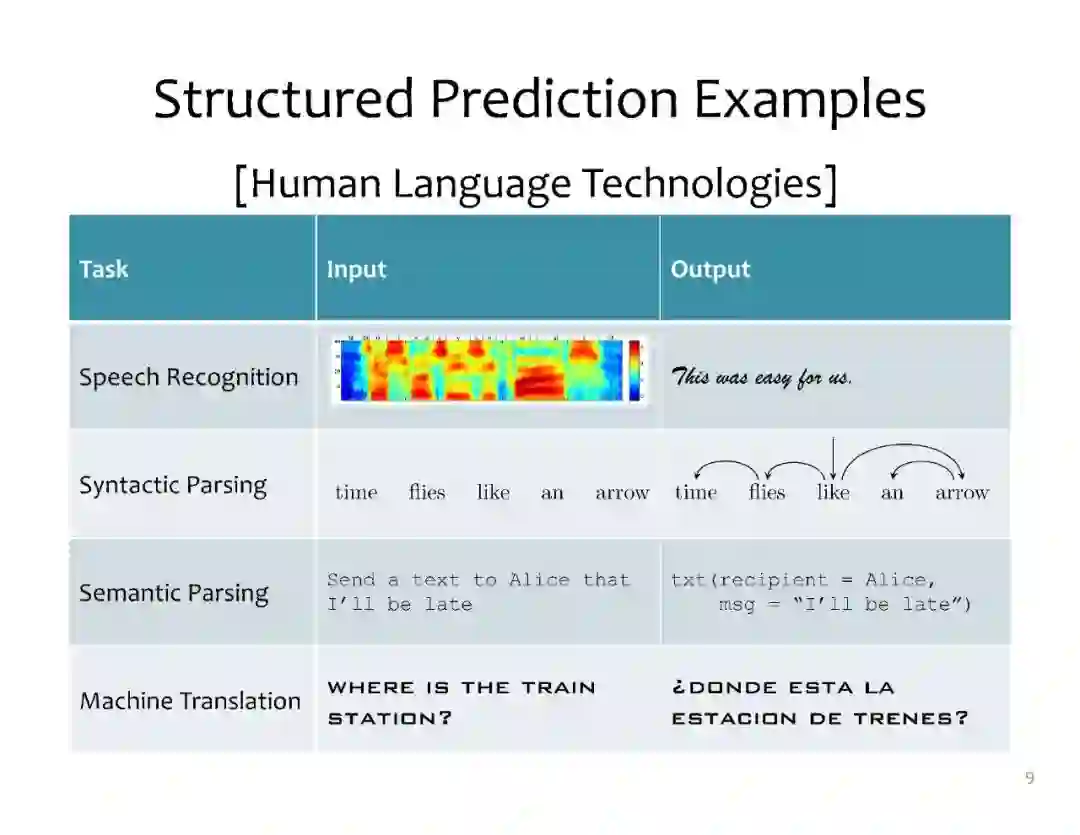

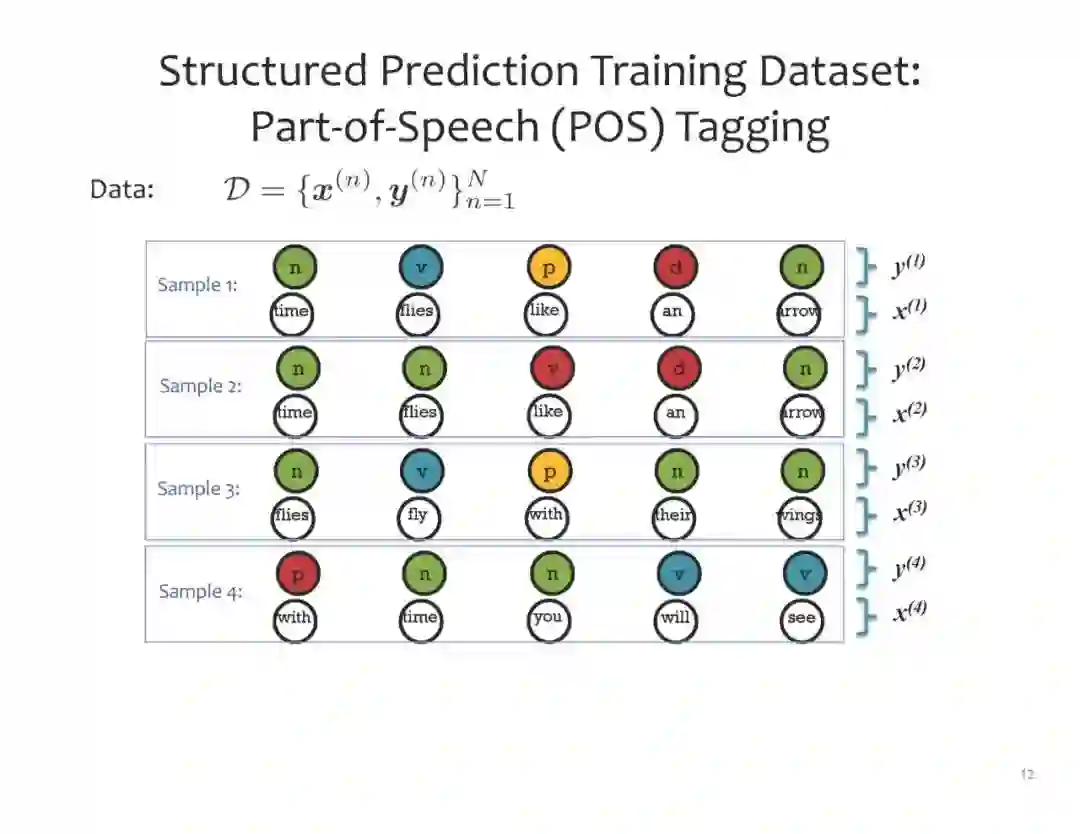

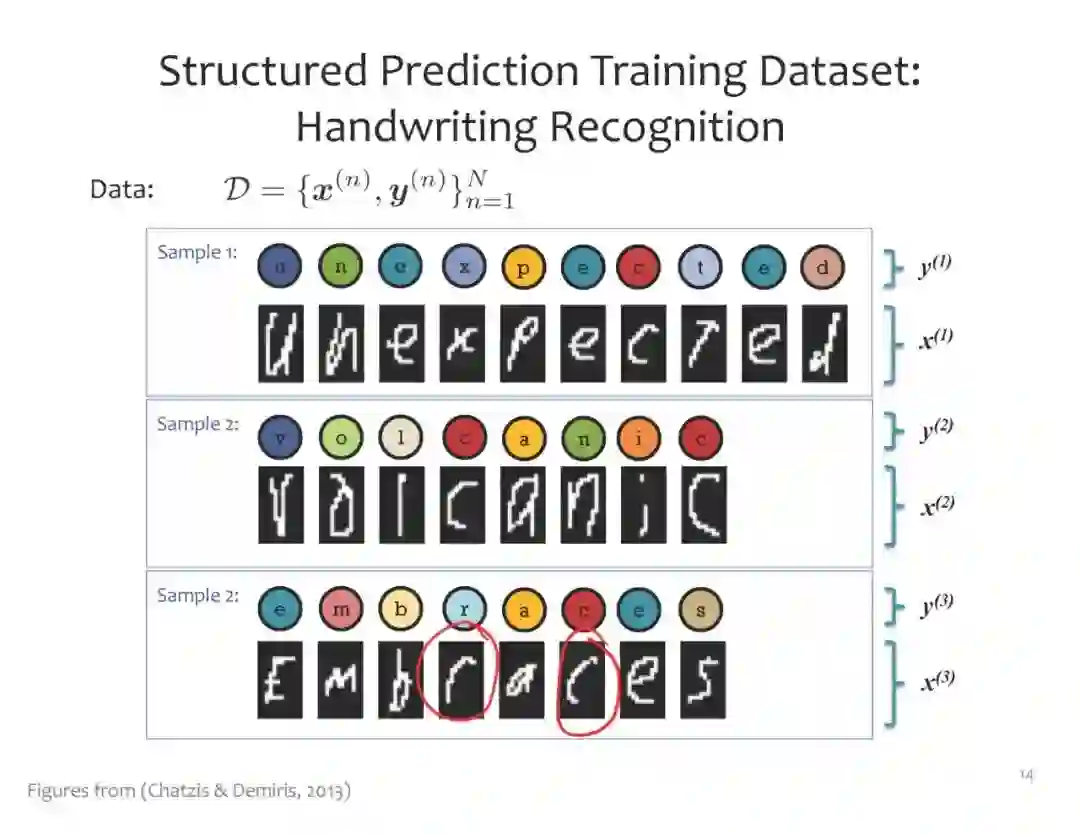

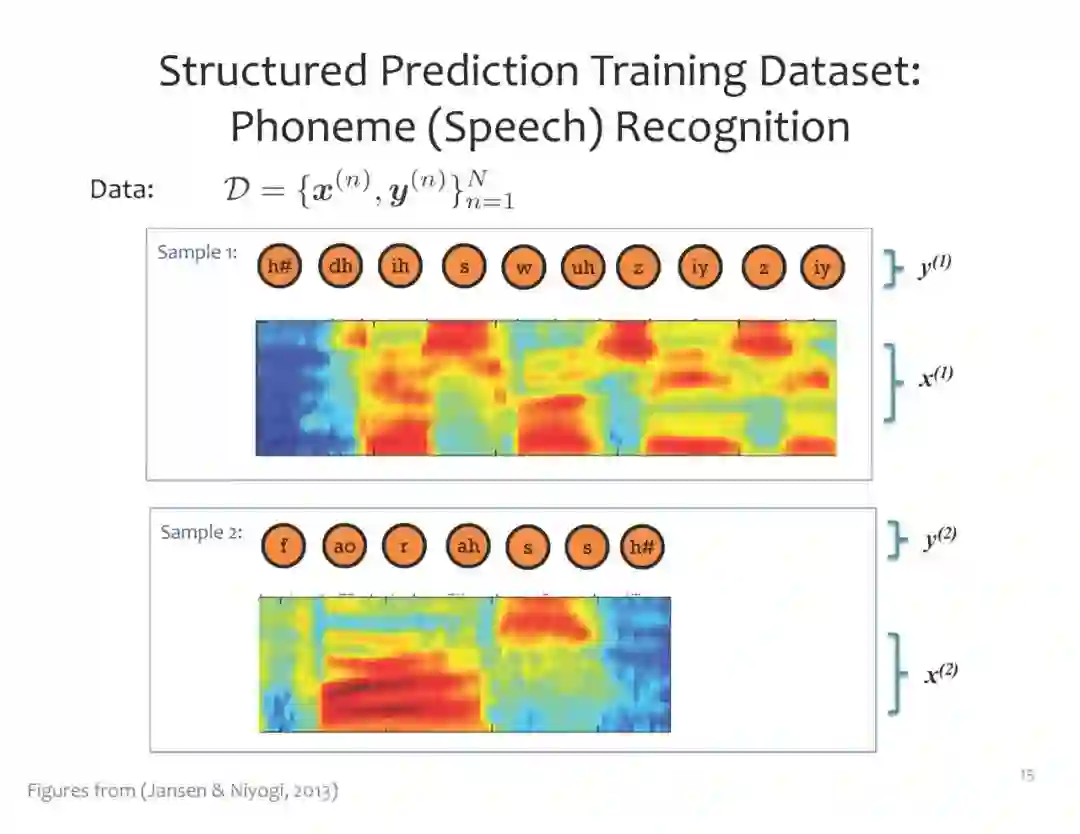

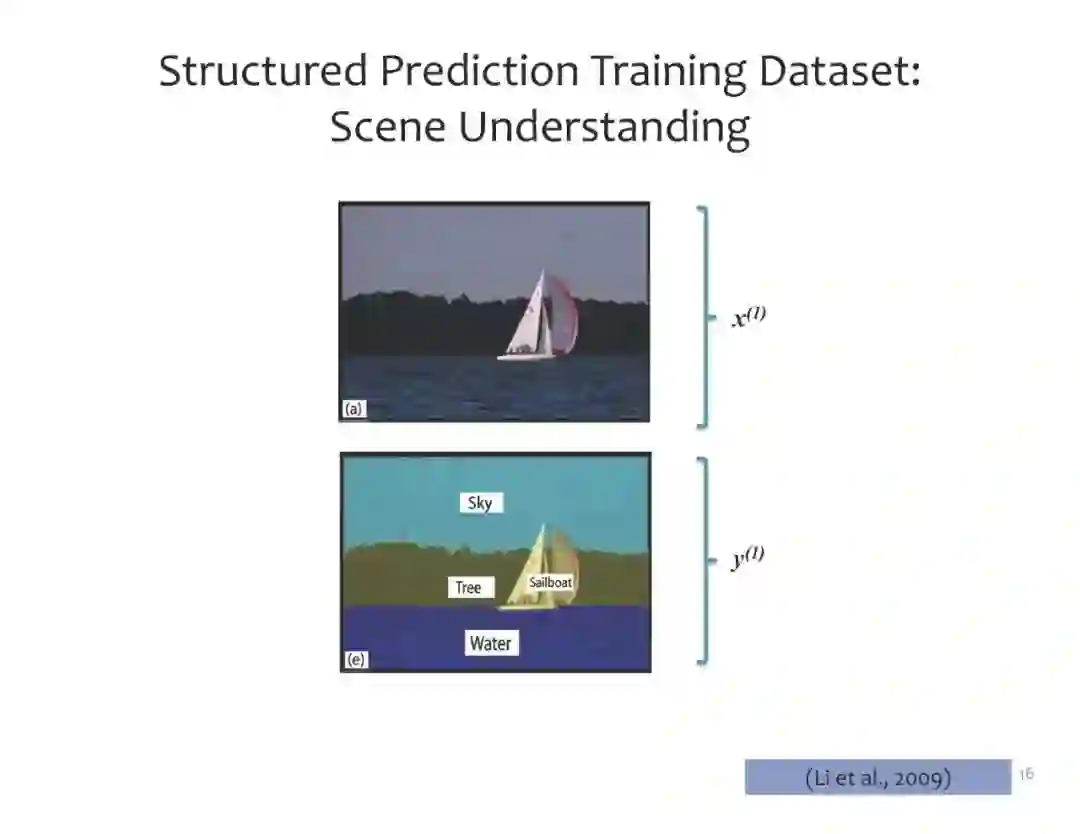

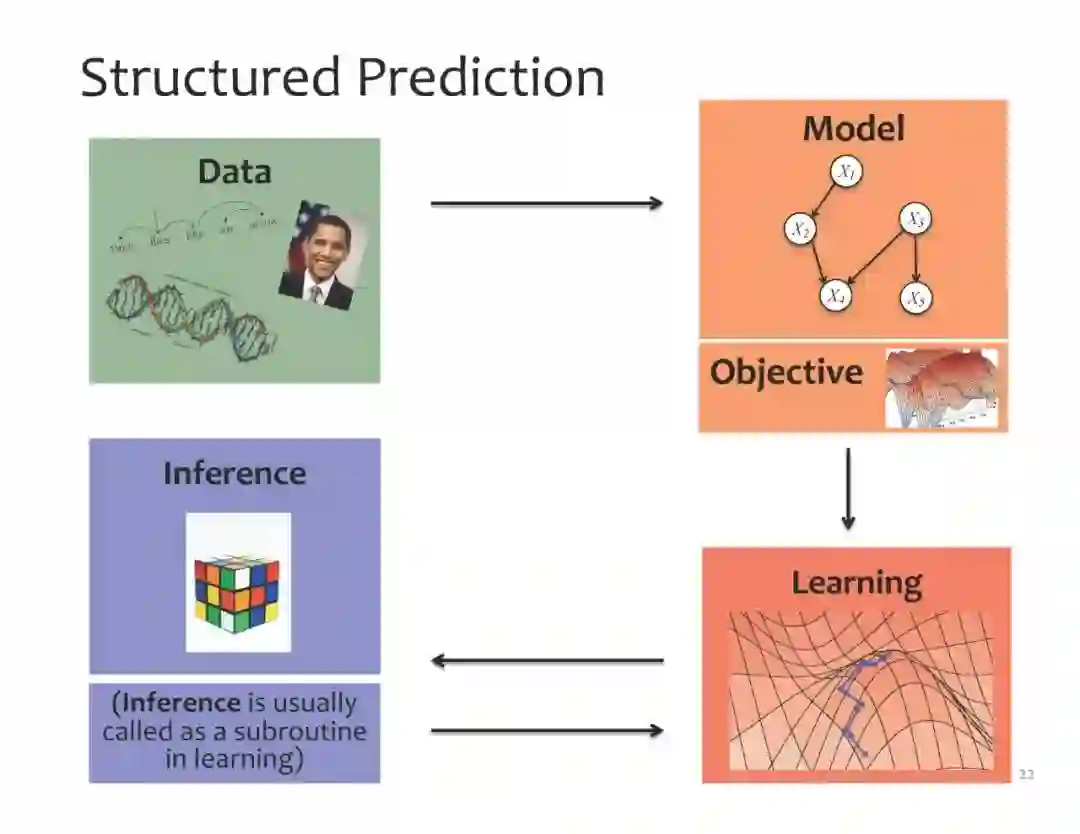

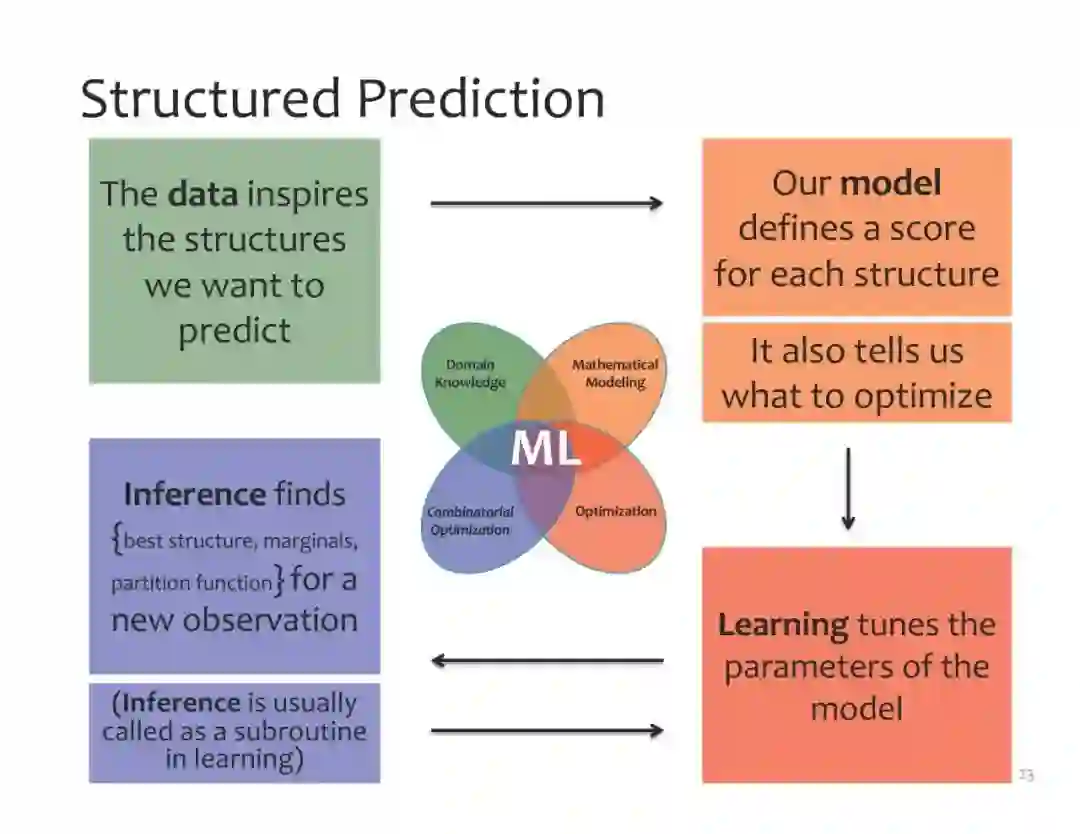

机器学习的一个关键挑战是结构化预测:将非结构化数据作为输入并产生结构化输出。结构化预测问题在自然语言处理、语音处理、计算生物学、计算机视觉、医疗保健等应用领域中比比皆是。在本课程中,我们将研究建立在概率图模型、深度学习和搜索基础上的结构化预测的现代方法。本课程将关注三个关键方面:模型、推理和学习。我们考虑的模型将集中于生成和判别模型,如贝叶斯网络、马尔可夫随机场(MRFs)、条件随机场(CRFs)和深度神经网络,包括卷积神经网络(CNNs)和循环神经网络(RNNs),以及图形模型和神经网络的混合。本课程将探讨精确推理和近似推理的方法:连接树算法、马尔科夫链蒙特卡罗(MCMC)和变分方法的近似边际推理、整数线性规划(ILP)和搜索的近似MAP推理。我们将使用学习问题的不同形式来探索无监督、半监督和监督学习:MLE、贝叶斯推理、结构化感知器、M3Ns、搜索学习和自动编码器。涵盖的应用将包括机器翻译,语音识别,DNA序列分析,场景理解,医疗诊断。这门课程被交叉列为10-418和10-618;注册10-618的学生将做一个课程项目。

学习成果:

在本课程结束时,学生应该能够…… * 将新任务形式化为结构化预测问题。 * 通过整合关于输出之间的约束或交互的领域知识,开发新的图模型 * 结合深度神经网络和图形模型 * 为概率图形模型确定适当的推理方法,精确的或近似的 * 采用学习算法,充分利用可用数据 * 为结构化预测模型从头开始实现最先进的学习和推理方法

成为VIP会员查看完整内容

相关内容

卡耐基梅隆大学(Carnegie Mellon University)坐落在宾夕法尼亚州的匹兹堡,是一所享誉世界的私立顶级研究型大学,学校面积不大,学科门类不多,但在其所设立的几乎所有专业都居于世界领先水平。卡内基梅隆大学享誉全国的认知心理学、管理和公共关系学、写作和修辞学、应用历史学、哲学和生物科学专业。它的计算机、机器人科学、理学、美术及工业管理都是举世公认的一流专业。

Arxiv

20+阅读 · 2021年5月27日