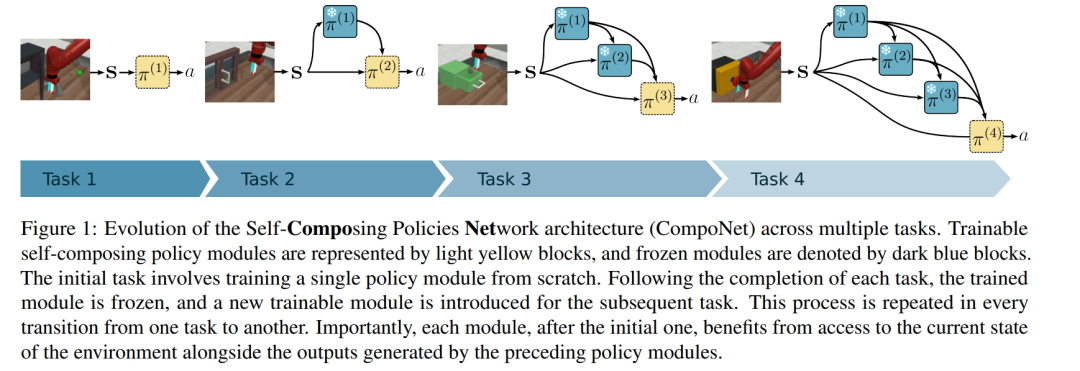

本研究提出了一种可增长且模块化的神经网络架构,可在持续强化学习中自然地避免灾难性遗忘与任务间干扰。该架构中每个模块的结构支持将先前策略与当前模块内部策略进行选择性组合,从而加速当前任务的学习过程。与以往的可增长神经网络方法不同,我们证明该方法的参数数量随着任务数量线性增长,同时在扩展性方面不以牺牲可塑性为代价。在标准的连续控制与视觉任务基准上进行的实验表明,该方法相比其他方法在知识迁移能力与性能表现上均取得了更优结果。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

213+阅读 · 2023年4月7日

Arxiv

81+阅读 · 2023年4月4日

Arxiv

145+阅读 · 2023年3月29日