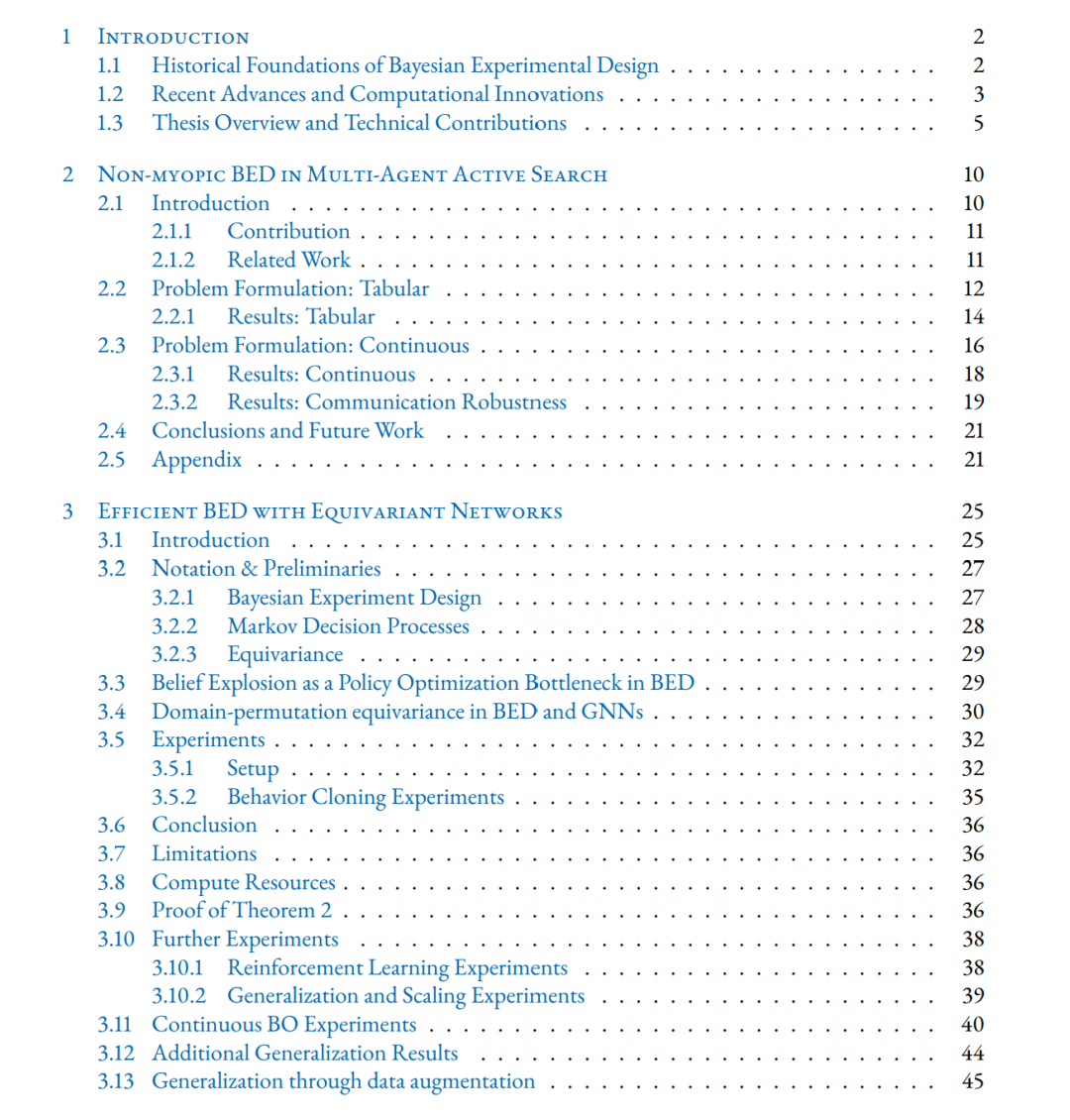

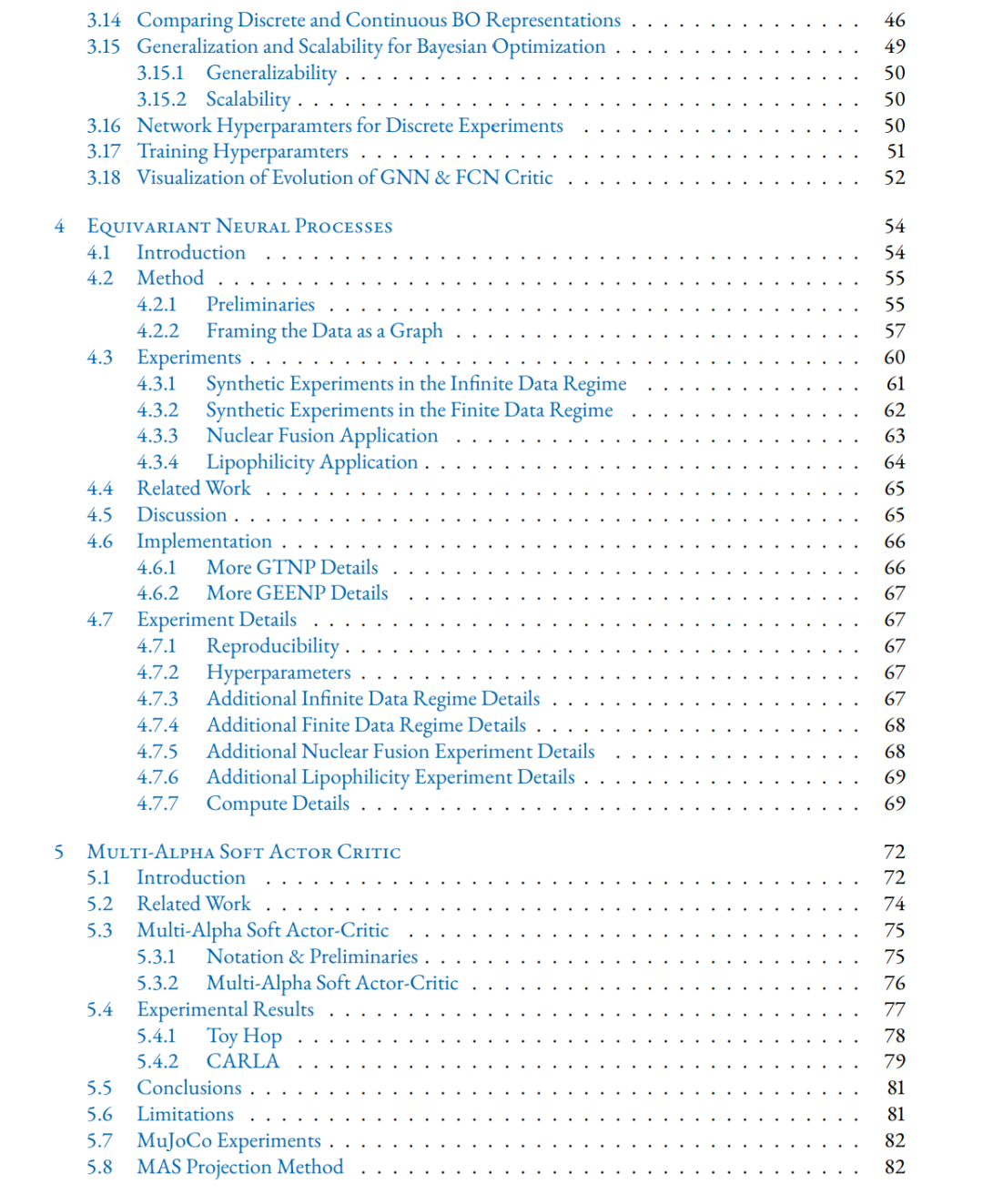

贝叶斯实验设计(Bayesian Experimental Design, BED) 已成为一种优雅的形式化方法,用于理解在实验代价不可忽视且高效设计至关重要的情境下,不同实验设计的价值。值得注意的是,近年来,采用深度学习与深度强化学习(D(R)L)技术来获取有效实验设计的研究兴趣日益增长。驱动这些技术参与的主要动机在于:它们有潜力在无需高昂测试时计算成本的情况下,提供高信息量的实验设计。 尽管近年来关于 D(R)L 在 BED 中的探索显示出良好的初步前景,但本文的一个核心观察是:训练性能良好的 BED 策略仍然极具挑战性。具体来说,我们发现即便在中等规模的问题上,BED 智能体也需要大量样本才能学到有效的策略。我们将这种学习困难归因于:在自适应实验过程中,随着推理的推进,后验信念空间的爆炸性增长,这使得泛化变得极为困难。如何设计能高效应对这种信念爆炸的智能体,迄今在 BED 文献中鲜有涉及,而这正是本文的主要研究重点。 我们展示了 BED 文献中常用的标准状态表示和网络架构选择——例如全连接网络、卷积架构和 Transformers——在面对信念爆炸时并不适合高效学习。为此,我们提出利用等变网络(equivariant networks),以利用 BED 任务中固有的对称性与结构。我们为离散信念状态和连续信息集表示分别开发了专门的等变架构,并表明在这两种场景中,这些网络都显著优于标准基线。值得注意的是,这些等变网络还在测试时展现了对新的、更大规模 BED 域的稳健泛化能力——这是诸如 Transformers 等传统架构所难以实现的。 我们的研究还揭示了 BED 等变性的一些结构性细节,可能为未来进一步提升样本效率提供启发。例如,除了全局等变性,我们还在更深的 BED 轨迹中观察到丰富的子空间等变性。虽然我们的连续信息集模型并未直接利用这些更深层的子空间等变性,但我们展示了:在离散化信念空间的等变网络中利用这些结构是直接可行的。 除 BED 场景之外,在论文的最后部分,我们还探讨了如何训练等变网络,以在提供后验预测不确定性时显著提升样本效率,相较以往的神经过程模型(Neural Process)。我们提出了图 Transformer 神经过程(Graph Transformer Neural Process),作为一种针对平稳随机过程的高效模型。实验表明,它在样本效率上远超此前的神经过程模型,同时在测试时的分布偏移下也表现得更为稳健。 最后,我们概述了若干未来工作方向——其中最重要的包括:开发能同时保留全局等变性和离散模型所捕获的更深子空间等变性的连续信息集网络;克服连续 BED Q 函数景观中的策略优化难题;以及开发更稳健的策略,用于在异质任务族之间摊销 BED 策略。通过证明等变性在训练高效 BED 策略中的重要性,本研究为将 BED 扩展到更复杂、更结构化的任务环境奠定了坚实基础,在这些环境中,数据效率与泛化仍然是关键约束。