【导读】一年一度的全球学术大会EMNLP是计算机语言学和自然语言处理领域最受关注的国际学术会议之一,由国际语言学会(ACL)旗下SIGDAT组织。据悉,EMNLP 2020共收到有效投稿3114篇,录用602篇长文和150篇短文。近期,所有Paper list 放出,也包括(Findings of EMNLP),知识图谱补全特别是时序知识图谱补全(KGC)相关的接受paper很多,希望大家多多关注。

为此,这期小编为大家奉上EMNLP 2020必读的五篇知识图谱补全(Knowledge Graph Completion (KGC))相关论文——知识图谱补全数据集、少样本知识图谱补全、时序知识图谱补全

EMNLP 2020 Accepted Papers : https://2020.emnlp.org/papers/main

EMNLP2020CI、EMNLP2020KG、ICLR2020CI、ICML2020CI

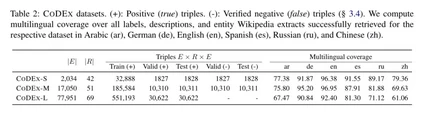

1. CODEX: A Comprehensive Knowledge Graph Completion Benchmark

作者:Tara Safavi, Danai Koutra

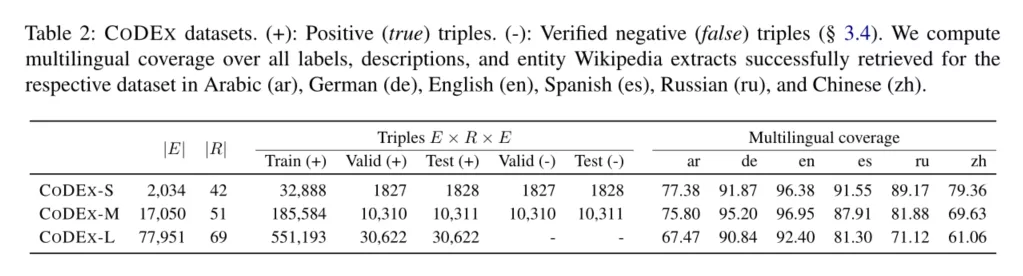

摘要:我们提出了CODEX,这是一组从Wikidata和Wikipedia提取的知识图谱补全(knowledge graph completion)数据集,它们在难度和范围上改进了现有知识图谱补全基准。就范围而言,CODEX包括三个大小和结构各异的知识图谱,实体和关系的多语言描述,以及成千上万个合理但被证实为假的难负样本(hard negative)三元组。为了表征CODEX,我们提供了详尽的经验分析和基准测试。首先,我们根据逻辑关系模式分析每个CODEX数据集。接下来,我们针对五个经过广泛调整的KG嵌入模型在CODEX上报告基准链接预测和三元组分类结果。最后,我们通过显示CODEX涵盖了更多样化和可解释的内容,并且它是一个更困难的链接预测基准,将CODEX与流行的FB15K-237知识图谱补全数据集区分开。

网址: https://www.aclweb.org/anthology/2020.emnlp-main.669/

2. Adaptive Attentional Network for Few-Shot Knowledge Graph Completion

作者:Jiawei Sheng, Shu Guo, Zhenyu Chen, Juwei Yue, Lihong Wang, Tingwen Liu, Hongbo Xu

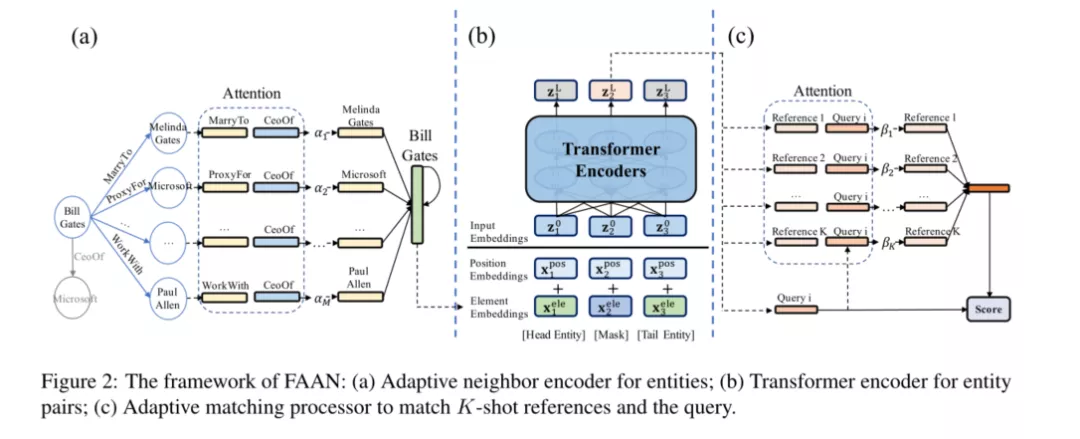

摘要:少样本知识图谱(KG)的补全是当前研究的重点,其中每个任务旨在根据给定的少样本参考实体对(reference entity pairs),来查询关系中未知的事实。最近的尝试通过学习实体和参考的静态表示来解决这个问题,而忽略了它们的动态属性,即,实体可能在任务关系中发挥不同的作用,并且参考可能对查询做出不同的贡献。这项工作提出了自适应注意力网络,通过学习自适应实体和参考表示来实现少样本KG补全。具体而言,实体由自适应邻居编码器建模以识别其面向任务的角色,而参考则由自适应查询感知聚合器建模以区分其贡献。通过注意力机制,实体和参考都可以捕获其细粒度的语义,从而呈现更具表达力的表示形式。在少数情况下,这对于知识获取将更具预测性。对两个公共数据集的链接预测的评估表明,我们的方法以不同的少样本数量获得了最新的最新结果。

代码: https://github.com/JiaweiSheng/FAAN

网址: https://www.aclweb.org/anthology/2020.emnlp-main.131/

3. DyERNIE: Dynamic Evolution of Riemannian Manifold Embeddings for Temporal Knowledge Graph Completion

作者:Zhen Han, Peng Chen, Yunpu Ma, Volker Tresp

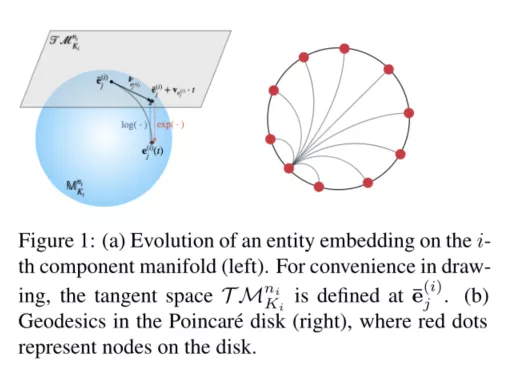

摘要:最近,人们对学习时序知识图谱(KG)表示的兴趣日益浓厚,这些知识记录了实体之间随时间的动态关系。时序KG经常表现出多个同时的非欧几里德结构,例如层次结构和循环结构。但是,现有的时序KG嵌入方法通常会在欧几里得空间中学习实体表示及其动态演化,这可能无法很好地捕获此类内在结构。为此,我们提出了DyERNIE,这是一种非欧几里得的嵌入方法,它可以学习黎曼流形(Riemannian manifolds)乘积中的演化实体表示,其中的组合空间是根据基础数据的截面曲率估算的。这使我们的方法能够更好地反映时间KG上的各种几何结构。此外,为了捕获时间KG的演化动力学,我们让实体表示根据每个时间戳处切线空间中定义的速度矢量进行演化。我们详细分析了几何空间对时序KG表示学习的贡献,并评估了我们在时序知识图补全任务上的模型。在三个真实世界的数据集上进行的大量实验表明,性能得到了显着改善,这表明可以通过黎曼流形上的嵌入演化来更正确地建模多关系图数据的动力学。

网址: https://arxiv.org/abs/2011.03984

4. Temporal Knowledge Base Completion: New Algorithms and Evaluation Protocols

作者:Prachi Jain, Sushant Rathi, Mausam, Soumen Chakrabarti

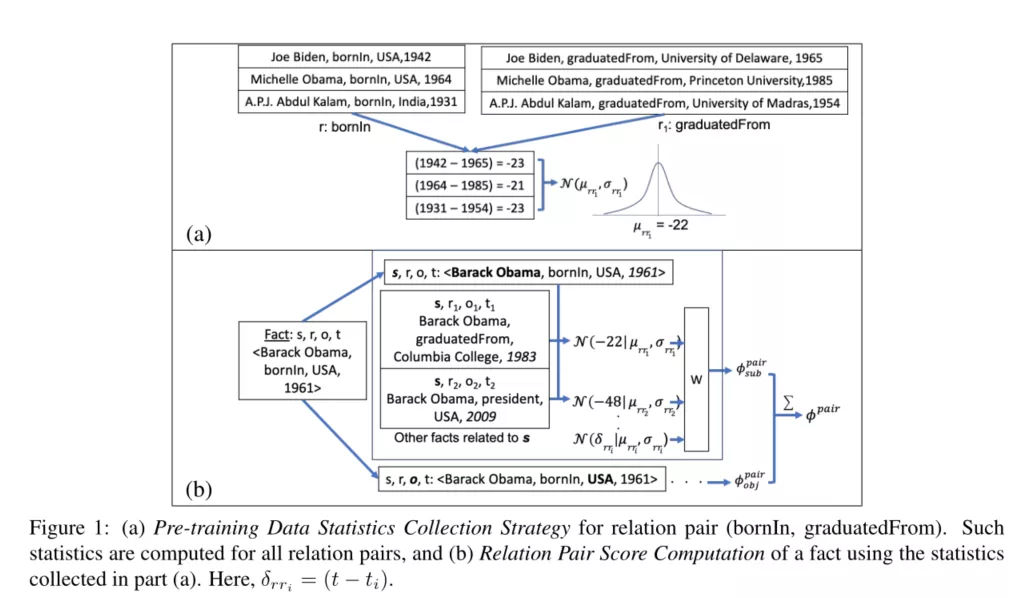

摘要:将关系事实(s,r,o)与有效时间段(或时间瞬间)相关联的时序知识库的研究仍处于早期阶段。我们的工作将预测缺失的实体(链接预测)和缺失的时间间隔(时间预测)视为联合的时序知识库补全(TKBC)任务,并提出了TIMEPLEX,这是一种新颖的TKBC方法,其中实体,关系和时间都嵌入统一的兼容空间。TIMEPLEX利用某些事实/事件的经常性和关系对之间的时间交互作用,在两个预测任务上都产生了最新的结果。

我们还发现,由于评估机制不完善,现有的TKBC模型严重高估了链接预测性能。作为回应,我们针对链接和时序预测任务提出了改进的TKBC评估协议,处理了黄金实例和系统预测中时间间隔的部分重叠引起的细微问题。

网址: https://www.aclweb.org/anthology/2020.emnlp-main.305/

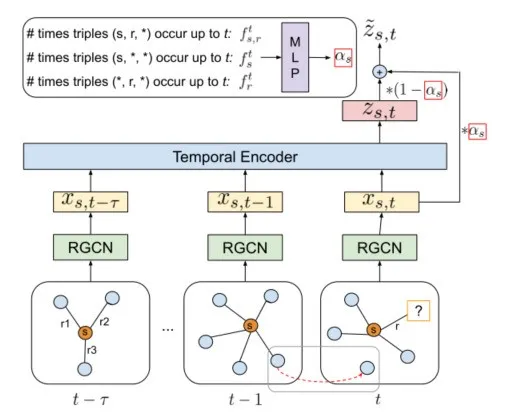

5. TeMP: Temporal Message Passing for Temporal Knowledge Graph Completion

作者:Jiapeng Wu, Meng Cao, Jackie Chi Kit Cheung, William L. Hamilton

摘要:在时序知识图谱中(TKG)推断缺失的事实是一项基本且具有挑战性的任务。以前的工作通过扩展静态知识图的方法来利用时间相关表示来解决此问题。但是,这些方法没有显式地利用时间步骤中的多跳结构信息和时间事实来增强其预测。此外,现有工作未明确解决TKG中实体分布的时间稀疏性和可变性。我们提出了时间信息传递(TeMP)框架,通过结合图神经网络,时间动力学模型,数据缺失处理和基于频率的门控技术来应对这些挑战。在标准TKG任务上进行的实验1表明,与以前的最新技术水平相比,我们的方法可带来可观的收益,在三个标准基准中,Hits @ 10的平均相对改进为10.7%。我们的分析还揭示了TKG数据集内和TKG数据集之间可变性的重要来源,并且我们引入了一些简单而强大的基线,这些基线在某些情况下优于现有技术。