对抗样本

·

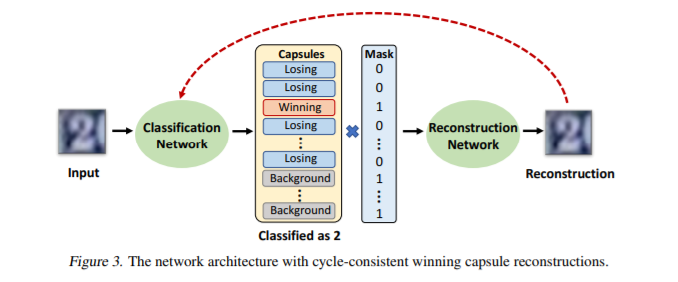

在一个持续的循环,在这个循环中,对对抗攻击更强的防御随后被更高级的防御感知攻击打破。我们提出了一种结束此循环的新方法,即通过使攻击者生成语义上类似于攻击目标类的输入来“转移”对抗攻击。为此,我们首先提出一种基于胶囊网络的更强大的防御,它结合了三种检测机制来实现对标准攻击和防御感知攻击的最新检测性能。然后,我们进行了一项人体研究,要求参与者对攻击产生的图像进行标记,结果表明,针对我们的防御系统的未检测到的攻击通常与对抗目标类相似。这些攻击图像不能再被称为“对抗性的”,因为我们的网络像人类一样对它们进行分类。

成为VIP会员查看完整内容

相关内容

专知会员服务

8+阅读 · 2020年5月4日

Arxiv

4+阅读 · 2019年5月24日