大型语言模型(Large Language Models, LLMs)具备强大的人工智能能力,但由于其高资源消耗与推理延迟,在实际部署中面临诸多挑战;相较之下,小型语言模型(Small Language Models, SLMs)虽然在性能上有所妥协,却具有高效、易部署等优势。因此,LLM 与 SLM 的协同合作正逐渐成为一种关键范式,用以在性能与资源之间实现协同优化,尤其适用于资源受限的边缘设备中的先进 AI 应用。 本文综述了 LLM–SLM 协作机制的最新研究进展,系统梳理了多种交互机制(如流水线式协同、路由机制、辅助性联动、知识蒸馏、模型融合)、关键支撑技术,以及由低延迟、隐私保护、个性化与离线运行等终端需求所驱动的多样化应用场景。通过总结当前研究成果,我们展示了该协同范式在构建更高效、可适配、易获取的人工智能系统方面的巨大潜力。

同时,本文也深入探讨了该领域所面临的若干持续性挑战,包括系统开销、模型间一致性、任务分配的鲁棒性、评估复杂性,以及安全与隐私问题等。

展望未来,研究将进一步朝着智能化自适应框架、深层次模型融合,以及多模态与具身智能的协同扩展方向发展,推动 LLM–SLM 协作成为下一代实用型与普及型人工智能的重要推动力。

1 引言

1.1 研究背景与动机

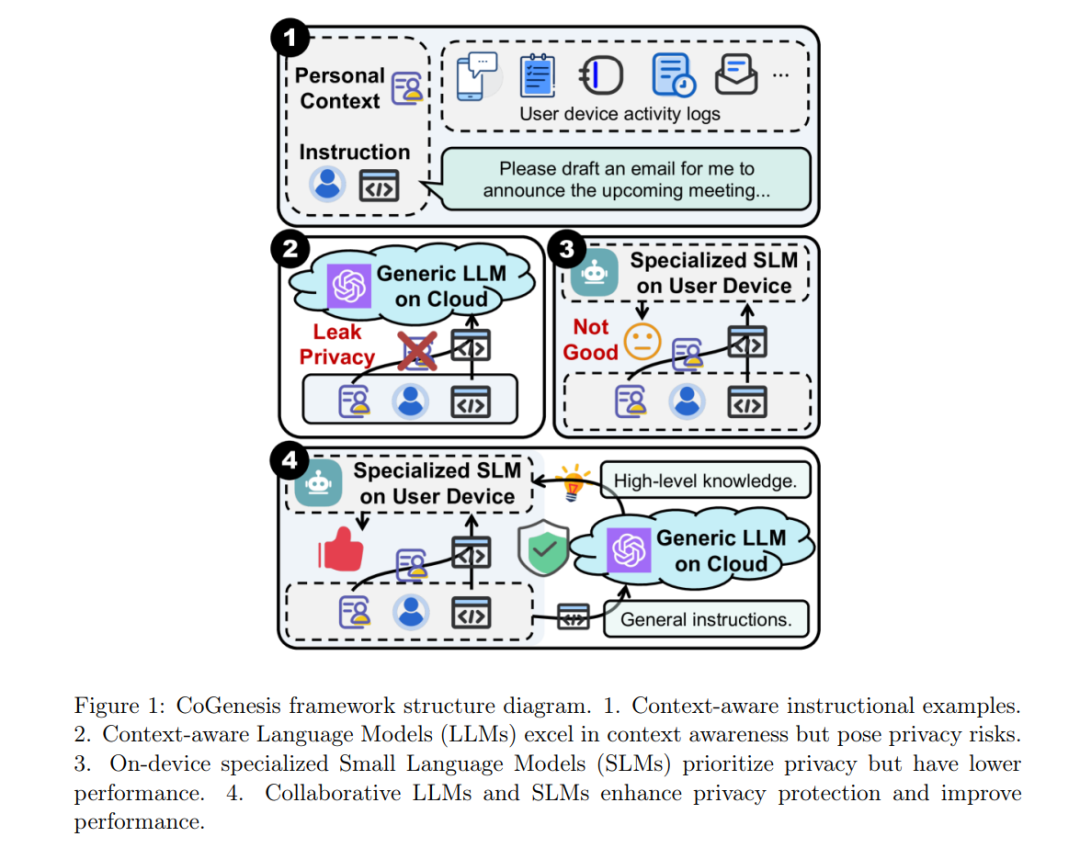

近年来,大型语言模型(Large Language Models, LLMs)在自然语言处理、代码生成、智能问答等多个领域取得了突破性进展(Brown et al., 2020;OpenAI, 2023)。然而,随着模型参数规模不断增长,其对计算资源的消耗、能耗成本以及部署开销也显著上升。尤其在需要低延迟和高隐私保障的边缘场景中,如智能手机、物联网设备和边缘服务器,传统基于云端的 LLM 推理模式面临严重的可行性挑战(Zhou, Lin, & Qian, 2024)。 与此同时,小型语言模型(Small Language Models, SLMs)因其结构轻量、推理速度快、部署便捷,广泛应用于资源受限的终端设备中(Gao, Zhu, & Liu, 2025)。在此背景下,大型与小型语言模型之间的协同机制逐渐成为学术界与工业界关注的重要研究方向。其核心目标在于,通过智能协作,融合 LLM 的强大能力与 SLM 的高效优势,构建出更智能、高效、可可靠部署的推理系统。

1.2 大小模型协同的定义与研究范围

广义上讲,大小模型协同是指在一个系统中,大型语言模型与小型语言模型协同工作、优势互补的机制。这一范式可细分为多个研究方向,包括:流水线协同、并行协同、条件触发推理、知识蒸馏等(Wang, Zhang, & Hu, 2024;Gao, Zhu, & Liu, 2025)。 例如,流水线协同是一种串行执行模式,其中一个模型的输出作为另一个模型的输入(Wang et al., 2024)。通常 SLM 负责前置处理或生成候选结果,再由 LLM 进行复杂推理或知识融合(Gao et al., 2025)。在级联预测框架(Cascade Speculative Decoding)中,SLM 生成草稿响应,LLM 并行进行验证与修正,从而提升响应速度(Chen, Liu, & He, 2023)。 在条件推理方面,有研究提出利用置信度分数来判断是否调用 LLM,以实现按需激活机制(Gupta, Rajbhandari, & Zhao, 2023)。此外,知识蒸馏通过训练过程将 LLM 的知识压缩并迁移至 SLM,从而提升后者对复杂任务的建模能力,同时保持其计算效率(Gu, Ren, & Lin, 2024)。上述研究构成了大小模型协同的核心范畴,并为构建节能高效的 AI 系统提供了理论与实践基础。

1.3 端侧大模型的兴起与协同机制研究的推动

近年来,随着芯片性能的提升与模型压缩技术的成熟,端侧大型语言模型的兴起推动了协同机制研究进入新阶段。诸多科技公司已开始在终端设备部署自研大模型。例如,Apple 于 2024 年在其“Apple Intelligence”系统中集成了一款参数规模约为 30 亿的端侧语言模型,用于本地处理部分自然语言任务,并将复杂请求交由云端模型处理(Apple Inc., 2024)。华为则在其 HarmonyOS 智能助手中引入了轻量化的盘古大模型版本,实现了边缘-云混合推理(Huawei Technologies, 2024)。 该类架构引发了诸多新研究问题:如何更高效地划分 LLM 与 SLM 之间的任务边界?如何管理边缘与云端间的计算卸载与动态路由?协同机制如何在保障响应质量的同时优化整体能耗效率?相关挑战还包括模型选择策略、边云通信开销、隐私保护机制以及多模型融合的精度问题(Zhang, Sun, & Liu, 2025)。 因此,大小模型协同机制不仅是当前理论研究的热点问题,更是智能终端迈向本地化、高性能、低功耗 AI 推理的重要技术路径。

1.4 本文结构与贡献

本文首先引入研究背景与动机,并界定了大小语言模型协同机制的定义及研究范围。接着,第二章将详细阐述相关基础概念,包括 LLM 与 SLM 的特点、优势与局限性,以及协同的理论依据与现实必要性。 第三章深入探讨大小模型协同的机制与架构,系统归类并介绍常见模式,如流水线式、混合/路由式、辅助增强式、知识蒸馏驱动型以及模型融合等,并分析实现协同所需的关键支撑技术。 第四章则结合终端侧需求,探讨协同机制在实际场景中的应用,包括低延迟实时推理、隐私敏感任务、个性化定制、离线/弱网环境以及能耗受限场景下的解决方案。 最后,第五章总结当前该领域面临的挑战与开放问题,展望未来的发展趋势,并归纳本文的研究价值与理论贡献。