【ICML2020-西电】用于语言生成的递归层次主题引导RNN

《Recurrent Hierarchical Topic-Guided RNN for Language Generation》,也被今年ICML录用。该论文属于自然语言处理领域。语言模型是各种自然语言处理任务的关键组成部分,其主要目的是捕获单词序列的分布,但它们通常忽略了文档中句子的顺序和文档上下文。在语言建模中,如何寻找更好的方法,既能捕捉单词之间的顺序,又能捕捉全局语义信息是比较有挑战的问题。不同于语言模型,主题模型是用来在一系列文档中发现抽象主题的一种统计模型。主题模型可以提取具有全局语义的隐表示,但是它们通常将每个文档视为一袋单词(BoW),忽略了单词之间的顺序。

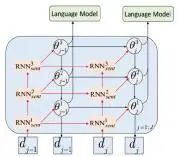

因此针对上述讨论的语言模型的问题,以及主题模型和语言模型各自的优势,本次研究提出使用深层时序主题模型来指导语言模型进行建模(rGBN-RNN)。如图1(a)所示,所提模型由两个关键部分组成:(1)一个层次递归主题模型(rGBN);(2)一个基于多层RNN的语言模型(RNN)。主题模型用于捕获跨文档的全局语义和文档中句子间的长期依赖关系,而语言模型用于学习句子中单词之间的局部语法关系。

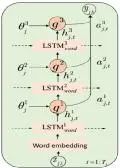

图1(a)rGBN-RNN生成模型 (b)RNN语言模型

(c)rGBN-RNN模型的总体结构,由解码器(rGB和语言模型)和编码器(变分时序推理)两部分构成,红色箭头表示主题权向量的推理,黑色箭头表示数据生成。

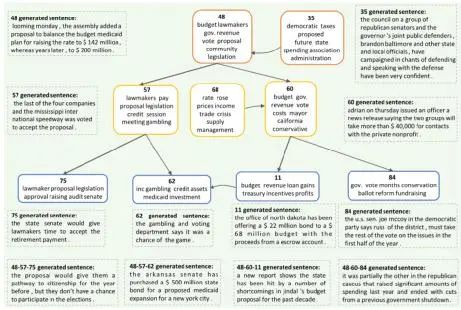

图1(三层rGBN-RNN基于APNEWS(新闻)数据集推断出的主题,以及在主题指导下生成的句子。由上至下,第3层、第2层、第1层主题分别用橙色、黄色和蓝色实线框表示,生成的句子用虚线框表示,虚线框中标注了生成句子所用的主题索引号。图的底部是由不同层次的主题组合生成的句子。

来源链接:

https://mp.weixin.qq.com/s/_KlJzuBdbaGotoCRpj82ag

https://arxiv.org/abs/1912.10337

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“RGBN” 可以获取《ICML2020用于语言生成的递归层次主题引导RNN》专知下载链接索引