数据可视化以图表形式在数据分析中发挥着关键作用,提供关键洞察并辅助做出知情决策。随着近年来大型基础模型的兴起,自动图表理解取得了显著进展。基础模型,如生成预训练变换器(Generative Pre-trained Transformers, GPT),已经革新了多种自然语言处理(NLP)任务,并越来越多地应用于图表理解任务中。这篇综述文章提供了这些基础模型背景下图表理解最近发展、挑战和未来方向的全面概览。文章从背景部分开始,定义图表理解,概述问题表述,并讨论研究图表理解任务至关重要的基本构建块,包括视觉编码器、图表到表格的翻译、OCR模块、文本编码器和文本解码器。在任务和数据集部分,我们探讨了图表理解内的各种任务,包括图表问答、图表字幕制作、图表到表格转换、图表事实核查和图表字幕事实错误校正。我们讨论了评价指标和图表及文本输入的来源。然后检视了建模策略,包括分类基础和生成基础的方法,以及增强图表理解性能的工具增强技术。此外,我们讨论了每项任务的最新性能并探讨如何提升性能。在一个专门的部分中,我们讨论了挑战和未来方向,强调了诸如特定领域图表、以及关于真实性、覆盖范围、相关性、稳健性、公平性和数据偏见的评价标准等问题。我们还深入探讨了这些多模态基础模型的组成部分,包括调整LM主干的必要性、多阶段训练过程的有效性,以及合成数据的潜在充分性。探索了与用户或其他系统交互的代理导向设置。最后,我们讨论了如自然图像理解、表格理解和文档理解等相关任务,提供了对视觉和文本数据理解更广阔景观的洞察。这篇综述文章为自然语言处理、计算机视觉和数据分析领域的研究人员和实践者提供了一个全面的资源,为利用大型基础模型进行图表理解的未来研究提供了宝贵的见解和方向。本文提及的研究以及新兴的研究将持续更新于: https://github.com/khuangaf/Awesome-Chart-Understanding。

在信息交流中图表理解的重要性:在我们当代的多媒体信息世界里,数据的体量和复杂性持续膨胀,图表在促进事实信息的连贯且富有洞察力的交流、传达见解和做出决策中的角色至关重要。跨越学术界、科学研究、数字媒体和商业领域,图表作为将原始数据转换成可理解的视觉叙事的不可或缺的工具。它们能够以简洁直观的格式封装复杂的数据集,使决策者能够迅速把握关键见解,辅助知情推理和战略规划。认识到图表在现代信息传播中的关键作用,计算社区持续对自动图表理解表现出兴趣,如自动图表理解的大量研究所证明。特别是,关于图表问答、图表字幕制作、图表到表格转换、图表事实核查和图表字幕事实错误校正的工作奠定了探索图表理解技术中图表语义复杂性的基础框架。

在大型基础模型时代的图表理解挑战与机遇:传统的图表理解工作聚焦于微调方法,通常在领域可移植性和推理鲁棒性方面遇到限制。令人兴奋的是,大视觉-语言基础模型(例如,GPT-4V、LLaVA)的出现引发了在自动推理能力上的范式转变,催化了包括通过基于文本的提示实现强零/少次推理能力在内的各种多媒体认知任务的前所未有的进步。但在这一变革性创新的景观中,图表理解领域仍旧深陷固有的复杂性和巨大挑战。图表因其多面向的视觉表现和细腻的语义呈现出一系列独特的障碍。从条形图、折线图到饼图和散点图,每种图表类型都采用独特的视觉语法来传达数据关系,需要超越简单的像素级模式识别的复杂解释机制。图表作为揭示如新兴趋势、挑战假设的异常值和变量间可能不会从仅仅是表格形式的原始数据立即显现的关系的深刻见解的渠道。它们使得可以进行跨数据点的比较分析,为简洁地并置不同实体或时间段提供一个视觉平台。此外,从简单的数字关系到复杂的多维实体,底层数据集的内在多样性为图表理解任务增加了另一层复杂性。尽管面临这些挑战,自动图表理解位于机遇与影响的交汇处,提供了一扇解锁埋藏在视觉叙事像素中的可行动见解的大门。通过利用大型基础模型的能力,图表理解展示了在弥合原始视觉数据与有意义见解之间的差距方面的提升潜力,从而使技术可扩展地用于易于访问的应用和增强人类认知。

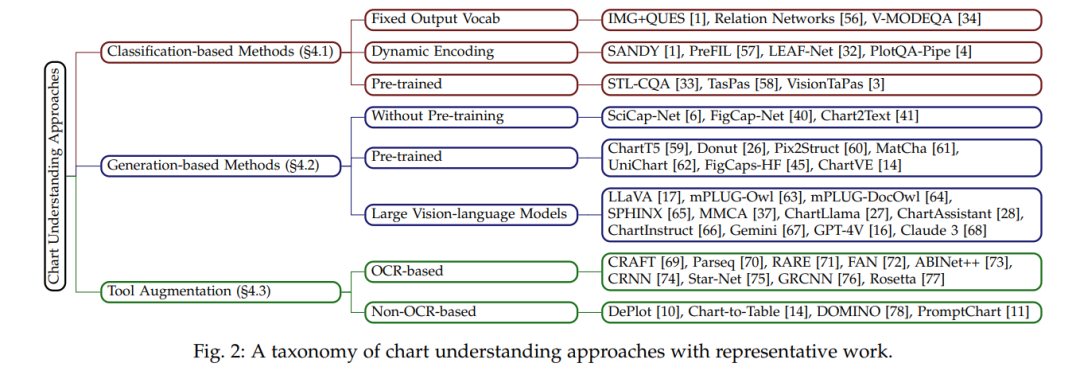

尽管已有数项研究综述了图表理解研究的领域,但这些综述往往在全面性或特定性上表现出一定的缺口。一些综述没有涵盖在图表理解研究中使用的现代数据集,以及最新的建模方法,如涉及预训练的视觉-语言模型和大型基础模型。相反,其他综述主要集中在可视化方面(即数据转换为图表的过程),因此忽视了图表解释的细腻任务。本综述旨在弥合这些缺口。我们首先在第2节定义自动图表理解和问题表述的基本构建块。我们讨论了图表理解的多面性,包括从解释图表视觉到分析底层数据的任务,以及概述了图表理解的结构性建模组件,如视觉编码器、OCR模块、文本解码器及其在将原始图表图像和文本查询转换为有意义见解中的角色。然后,在第3节,我们检查了推动图表理解研究的数据集和模型评估指标。本节分析了这些数据集的来源、多样性和局限性,提供了对当前图表理解数据景观的见解。它还回顾了各种评估指标,强调了鲁棒且细腻的评估方法的必要性。有了这些特征的见解,我们进一步提供了自动图表理解的流行建模策略。第4节深入探讨了图表理解中的多样化建模策略,包括从自然图像理解、视觉-语言预训练和基础模型,如大型语言模型(LLMs)和大型视觉-语言模型(LVLMs)的调整。特别是,我们强调了视觉编码器和文本解码器在模型有效性上的选择影响,并讨论了工具增强在图表理解中的作用。我们通过展示不同图表理解任务上的最新性能以及我们如何改进它们来结束这一部分。最后,第5节讨论了图表理解中的挑战和未来方向。我们强调了特定领域图表的重要性、对全面评估指标的需求,以及对增强模型鲁棒性和多功能性的敌对设置的潜力。我们还在第6节讨论了图表理解如何位于与自然图像理解、表格理解和文档理解相关工作的交汇处。本综述文章通过确定未来研究的关键领域结束,如为复杂图表开发模型、完善评估指标和多样化数据集。我们不仅提供了对图表理解当前状态的深入概览,而且为这一激动人心的数据可视化与机器学习交叉领域的未来进展奠定了基础。