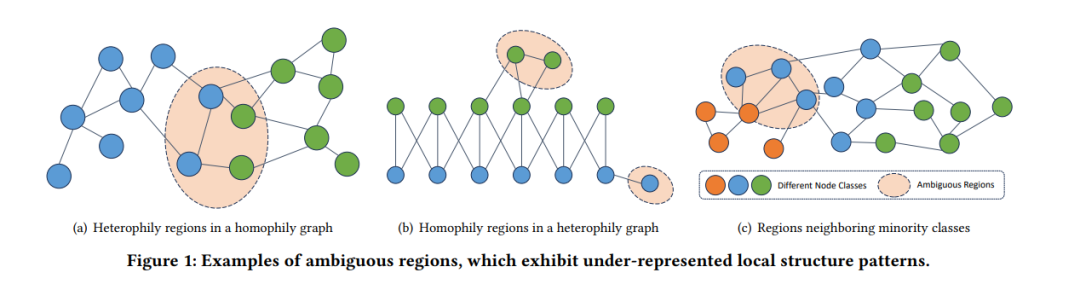

图神经网络(GNNs)在各个领域的图结构数据学习中展示了显著的成功。尽管取得了巨大成功,现有工作经常忽视一个关键挑战,即消息传播的学习能否有效地泛化到代表性不足的图区域。这些少数区域经常展示不规则的同质性/异质性模式和多样化的邻域类分布,导致模糊性。在这项工作中,我们研究了GNNs内的模糊性问题,其对表示学习的影响,以及为对抗这一问题而开发的更丰富的监督信号。我们对GNN进行了细致的评估,分析了不同图区域中模糊性的存在及其与节点位置的关系。为了消除节点嵌入的模糊性,我们提出了一种新颖的方法,DisamGCL,它利用额外的优化指导来增强表示学习,特别是对于模糊区域中的节点。DisamGCL基于预测的时间不一致性识别模糊节点,并通过以拓扑感知的方式采用对比学习引入消歧规则化。DisamGCL促进节点表示的区分性,并且可以减轻消息传播引起的语义混合,有效地解决了模糊性问题。经验结果验证了DisamGCL的效率,并突出了其在代表性不足的图区域改善GNN性能的潜力。

成为VIP会员查看完整内容

相关内容

Arxiv

30+阅读 · 2023年4月19日

Arxiv

135+阅读 · 2023年4月7日