AAAI 2021 | 用于旋转目标检测的动态锚框学习策略

作者 | 明奇

作者 | 明奇

编辑 | 陈大鑫

Motivation

-

进一步加剧的正负样本不平衡。 对于旋转目标检测而言,预设旋转anchor要额外引入角度先验,使得预设的anchor数目成倍增加。 此外,旋转anchor角度稍微偏离gt会导致IoU急剧下降,所以预设的角度参数很多。(例如旋转文本检测RRD设置13个角度,RRPN每个位置54个anchor)。 -

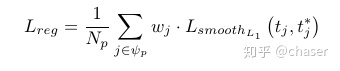

分类回归的不一致。 当前很多工作讨论这个问题,即预测结果的分类得分和定位精度不一致,导致通过NMS阶段以及根据分类conf选检测结果的时候有可能选出定位不准的,而遗漏抑制了定位好的anchor。 目前工作的解决方法大致可以分为两类:网络结构入手和label assignment优化,参见related work这里不再赘述。

讨论

-

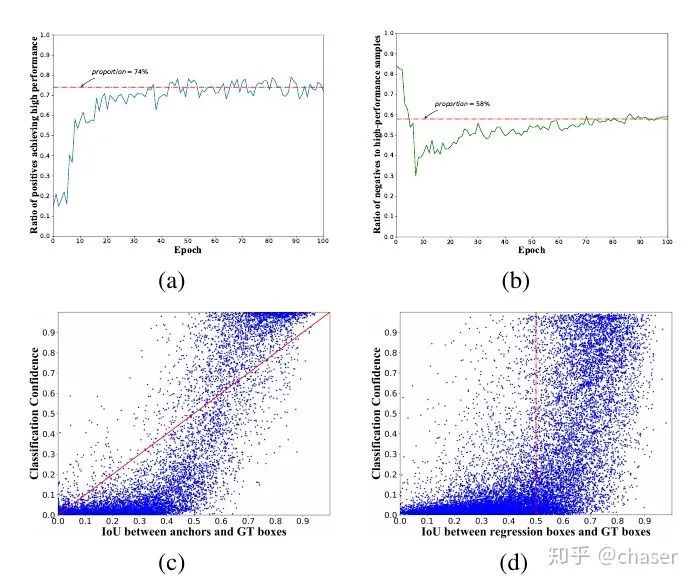

74%左右的正样本anchor回归的pred box后依然是高质量样本(IoU>0.5);近一半的高质量样本回归自负样本,这说明负样本还有很大的利用空间,当前基于输入IoU的label assignment选正样本的效率并不高,有待优化。 -

图c说明,当前的基于输入IoU的标签分配会诱导分类分数和anchor初始定位能力成正相关。而我们期望的结果是pred box的分类回归能力成正相关。从这里可以认为基于输入IoU的标签分配是导致分类回归不一致的原因之一。 这个很好理解,划分样本的时候指定的初始对齐很好的为正样本,其回归后就算产生了不好的预测结果,分类置信还是很高,因为分类回归任务是解耦的;反之很多初始对齐不好的anchor被分成负样本,即使能预测好,由于分数很低,无法在inference被输出。 -

进一步统计了预测结果的分布如d,可以看到在低IoU区间分类器表现还行,能有效区分负样本,但是高IoU区间如0.7以上,分类器对样本质量的区分能力有限。 【问:表面上右半区密密麻麻好像分类器完全gg的样子,但是我们正常检测器并没有出现分类回归的异常,高分box的定位一般也不赖,为什么? 一是由于很多的IoU 0.5以上的点都是负样本的,即使定位准根本不会被关注到;二是预测的结果中,只要有高质量的能被输出就行了,其他都会被NMS掉,体现在图中就是右上角可以密密麻麻无所谓,只要右下角没有太多点可视化的检测结果就不会太差。】

方法

3.1、分析

-

输入IoU大,但是输出IoU小的anchor并不应该被划分为负样本,其更大概率还是正样本的,这部分容易学习的样本丢失严重影响收敛。 -

任何样本都可能在训练过程中随机匹配到一个目标,但不应该因此直接确信为正样本,这在训练早期尤为严重。

3.2 动态 Anchor 选择

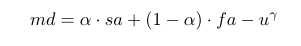

和

和

两项(即

两项(即

)实际上就能实现超越输入IoU的labelassignment了,但是输出IoU很不稳定,参数比较难调,而加入空间先验后稳定了很多,效果也能保持很好的水平。

)实际上就能实现超越输入IoU的labelassignment了,但是输出IoU很不稳定,参数比较难调,而加入空间先验后稳定了很多,效果也能保持很好的水平。

有很多表征形式,之前试过各种复杂花哨的表征和加权变换,虽然相对现有形式有所提升但是提升空间不大。没必要搞得故弄玄虚的,所以最后还是保留了这种最简单的方式。

有很多表征形式,之前试过各种复杂花哨的表征和加权变换,虽然相对现有形式有所提升但是提升空间不大。没必要搞得故弄玄虚的,所以最后还是保留了这种最简单的方式。

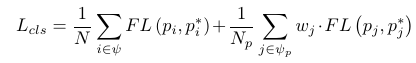

3.3 Matching-Sensitive Loss

-

避免分类器对匹配度划定的负样本进行不合理的关注。比如在md补偿的策略下,一个低质量正样本可能导致很大的补偿值从而带来一堆低质量正样本; -

由于匹配度是介于[0,1],直接加权将导致正样本被进一步稀释; -

确保分类和回归任务对补偿的anchor的足够关注,每个样本至少有一个anchor能学好。例如对于某个gt最大md为0.2,直接加权将导致其loss贡献很小,本来就难匹配的目标更难学了。

实验

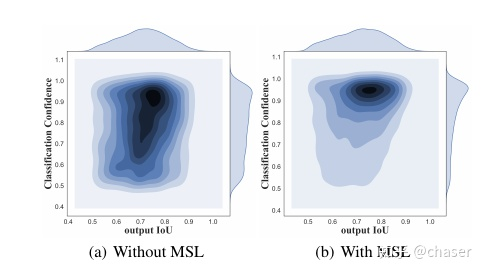

4.1 Ablation

4.1.1 Component-wise evaluation

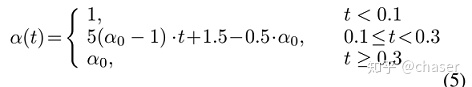

设置为0.1,因为输出IoU实际上非常不稳定,比例一旦增大就会导致训练不收敛。

设置为0.1,因为输出IoU实际上非常不稳定,比例一旦增大就会导致训练不收敛。

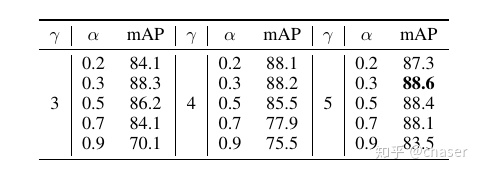

4.1.2 Hyper-parameters

合理减小会使特征对齐的影响增大,同时mAP增大,说明能够输出IoU能够有效指导样本划分过程。如果

合理减小会使特征对齐的影响增大,同时mAP增大,说明能够输出IoU能够有效指导样本划分过程。如果

过大将使得空间对齐能力占主导地位,输出IoU带来的不稳定减小,此时不应施加很强的扰动惩罚,即减小

过大将使得空间对齐能力占主导地位,输出IoU带来的不稳定减小,此时不应施加很强的扰动惩罚,即减小

的值,如

的值,如

时,

时,

从3减小到5,mAP从70.1提升到83.5。

从3减小到5,mAP从70.1提升到83.5。

也就是正常的IoU完全可以不要,仅靠

也就是正常的IoU完全可以不要,仅靠

和

和

就能取得更好的结果,但是很敏感anchor设置和

就能取得更好的结果,但是很敏感anchor设置和

取值以及

取值以及

的形式,比较难调。

的形式,比较难调。

和

和

应该同时增大或减小。此外观察不难发现,

应该同时增大或减小。此外观察不难发现,

在0.3-0.5的效果是最好的,

在0.3-0.5的效果是最好的,

也大致可以确定。这个结论在其他数据集和其他anchor设置上也验证过,依然成立,论文篇幅有限这里没有予以展示。但是说实话,取值而言会有偏移,虽然不会太多但是还是要调一调,这个有点不快乐。

也大致可以确定。这个结论在其他数据集和其他anchor设置上也验证过,依然成立,论文篇幅有限这里没有予以展示。但是说实话,取值而言会有偏移,虽然不会太多但是还是要调一调,这个有点不快乐。

4.2 实验结果

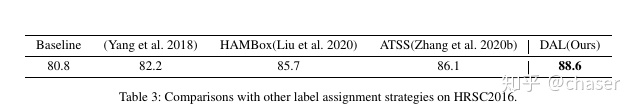

4.2.1和其它sampling 方法比较

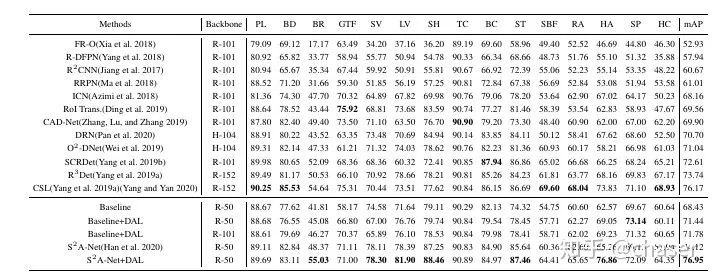

4.2.2 Results on DOTA

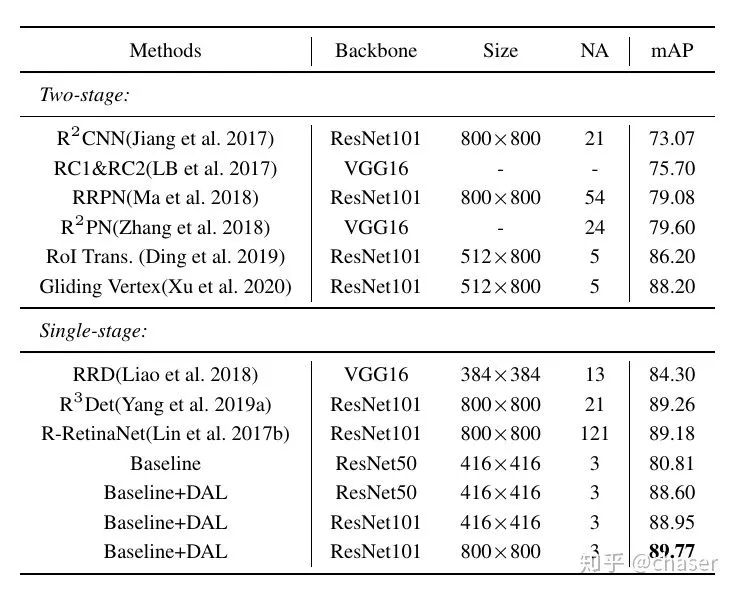

4.2.3 Results on HRSC2016

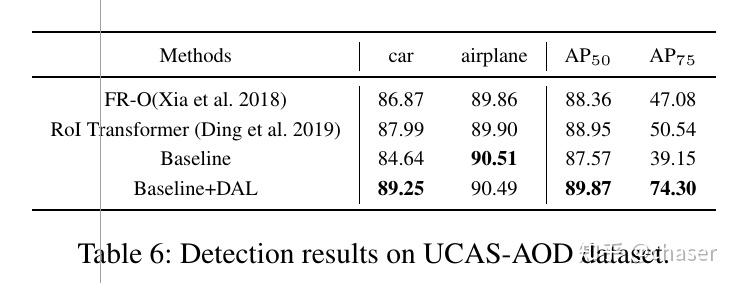

4.2.4 Results on UCAS-AOD

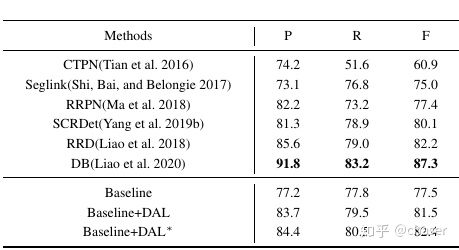

4.2.5 Results on ICDAR2015

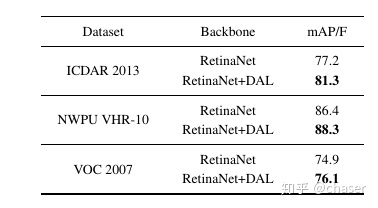

4.3 Experiments on HBB dataset

点击阅读原文,直达AAAI小组!

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为星标账号,以及常点文末右下角的“在看”。

登录查看更多

相关内容

专知会员服务

46+阅读 · 2019年11月15日

Arxiv

4+阅读 · 2018年9月23日