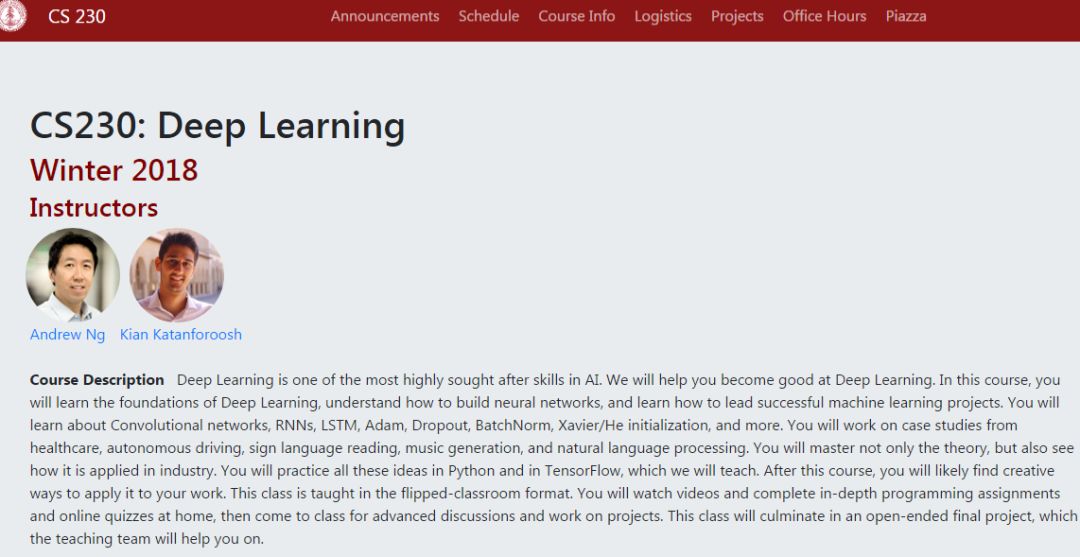

吴恩达最新深度学习课程: 斯坦福2018—Andrew Ng、Kian Katanforoosh主讲(附PPT)

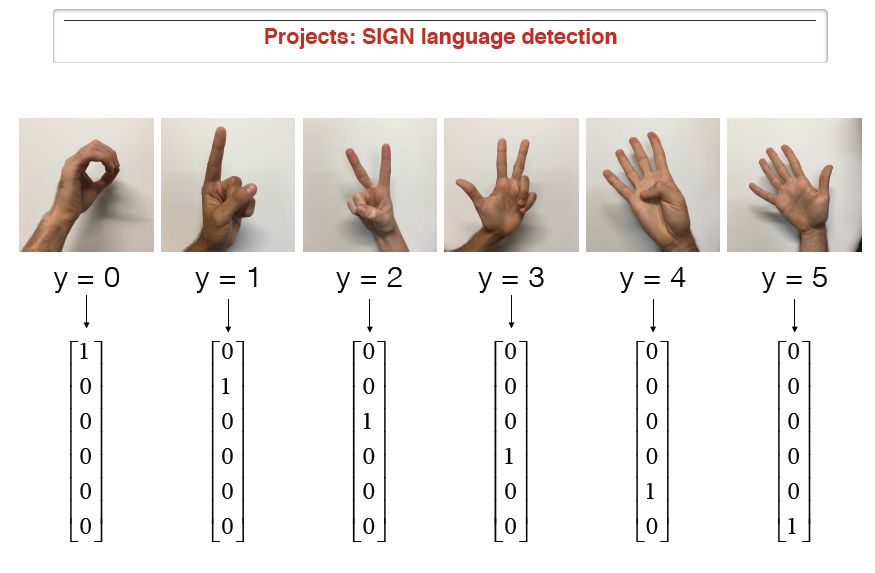

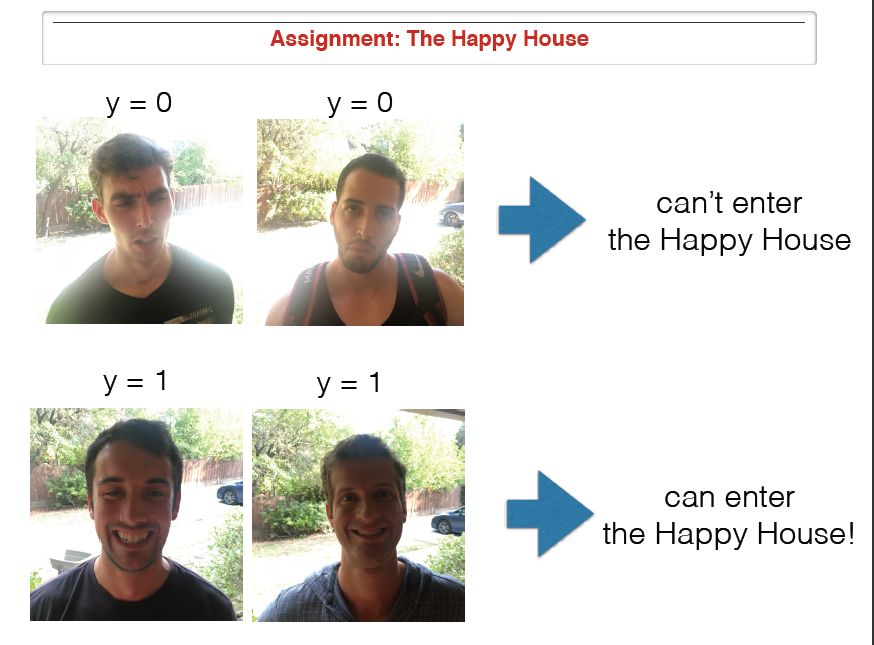

【导读】近期,斯坦福大学深度学习课程有开课了,主讲老师是人工智能领域知名学者Andrew Ng和Kian Katanforoosh。我们在早些时候也编辑发布了卡耐基梅隆大学的深度学习课程,斯坦福大学和卡耐基梅隆大学一样,都是当今走在AI领域前沿的机构。今天整理的斯坦福大学深度学习课程的主要内容同样涵盖了深度学习的基础知识和常见的模型,包括:反向传播、梯度下降、CNNs、RNNs、LSTM、强化学习等等。与其他课程有所不同,本课程还关注深度学习的应用,包括医疗、自动驾驶、手语阅读、自然语言处理等,从项目实践的角度帮助学生掌握深度学习。

专知内容组附上上一次CMU2018和CMU2017年课程:深度学习的内容:

1. CMU2018年春季课程: 深度学习——Bhiksha Raj主讲(附PPT和video)

2. CMU2017年秋季课程:深度学习——Ruslan Salakhutdinov主讲(附PPT下载)

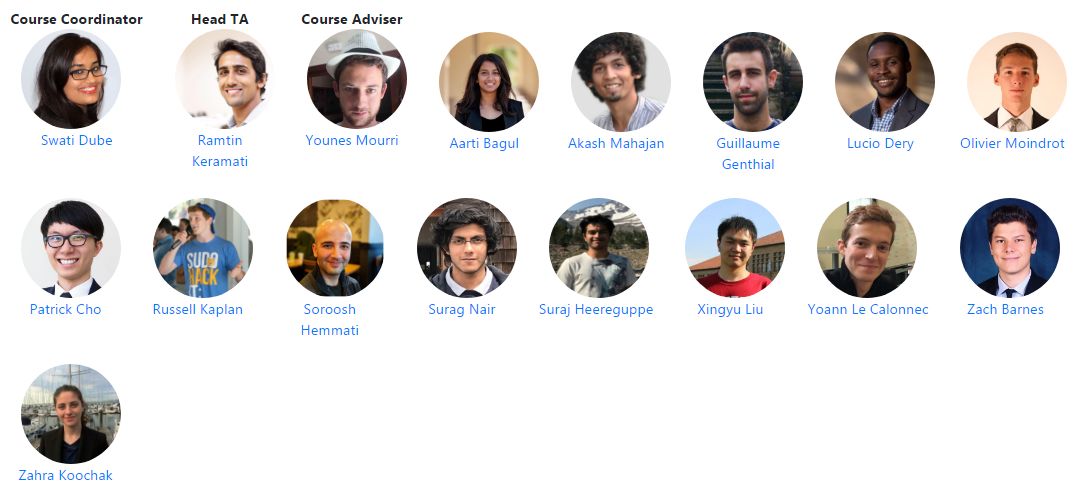

▌主讲老师

▌课程简介

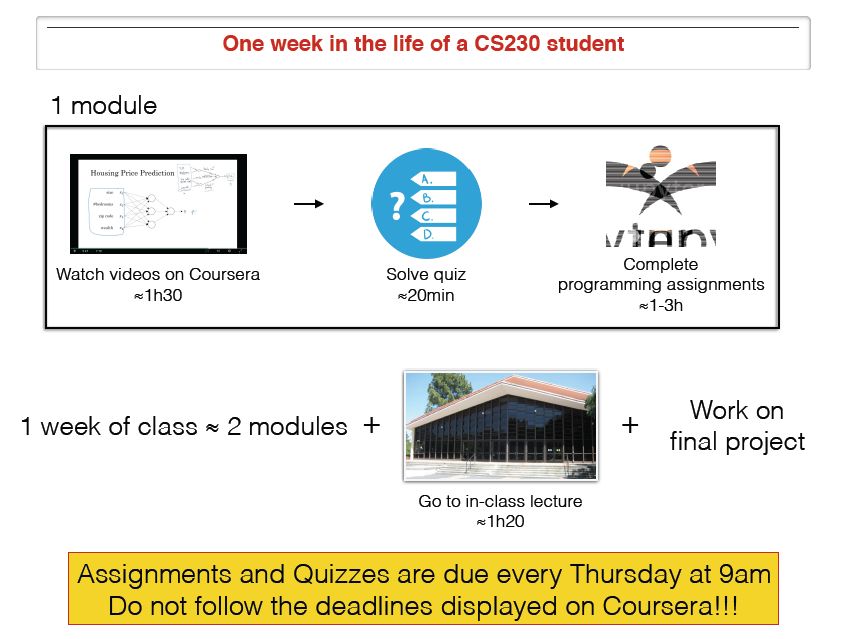

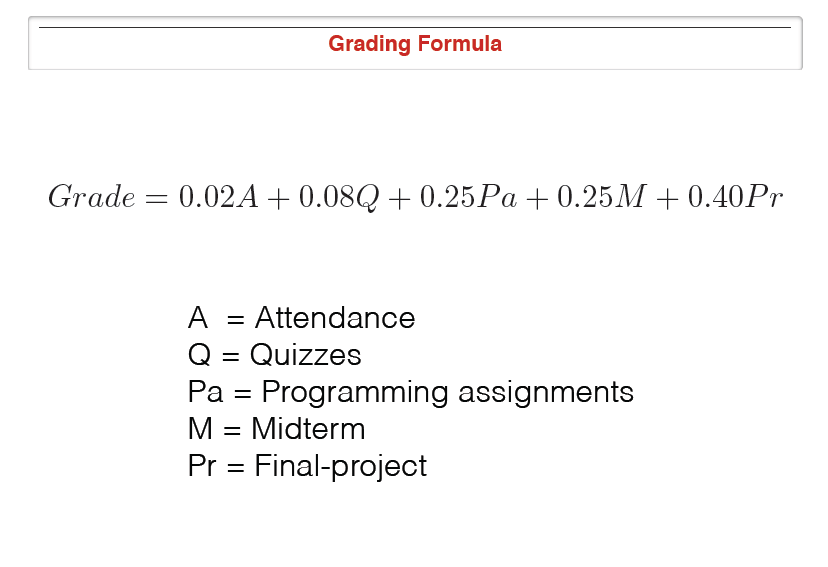

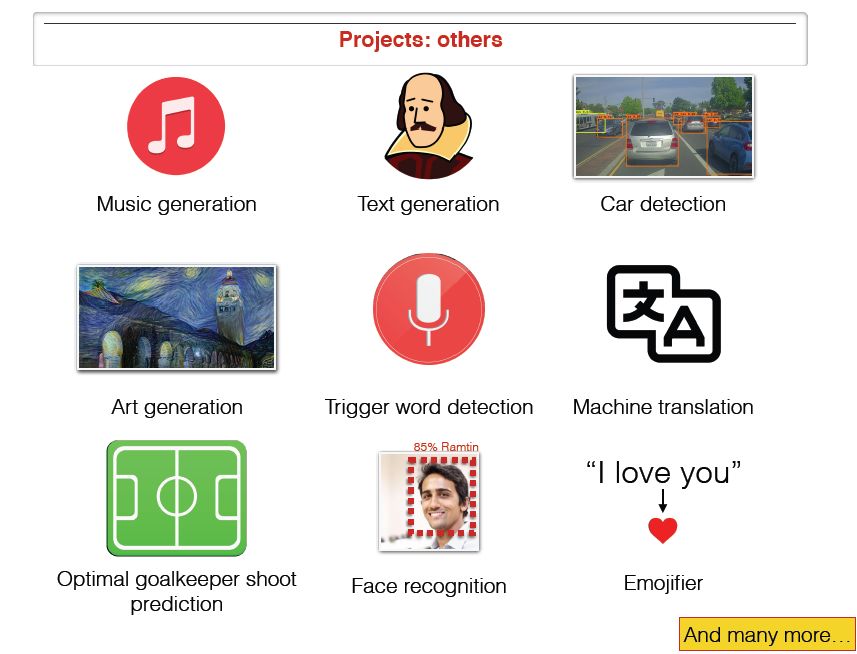

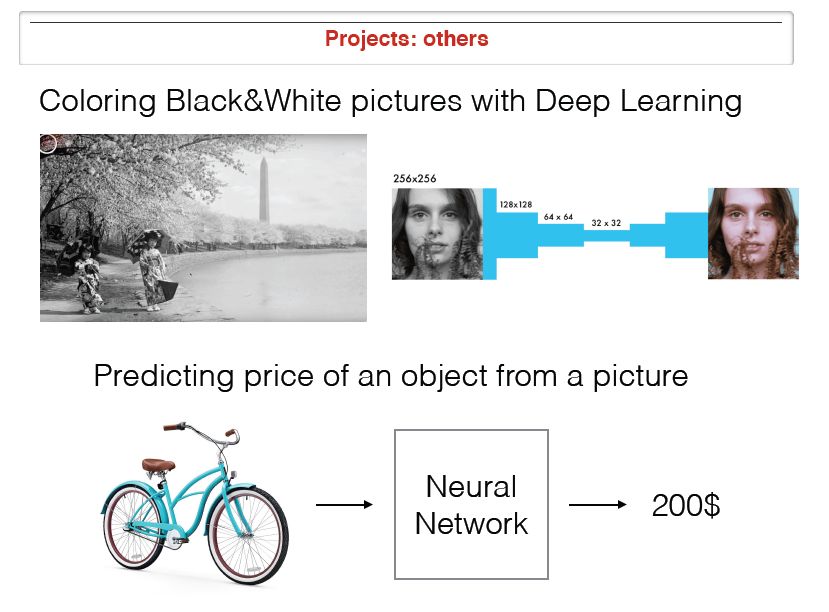

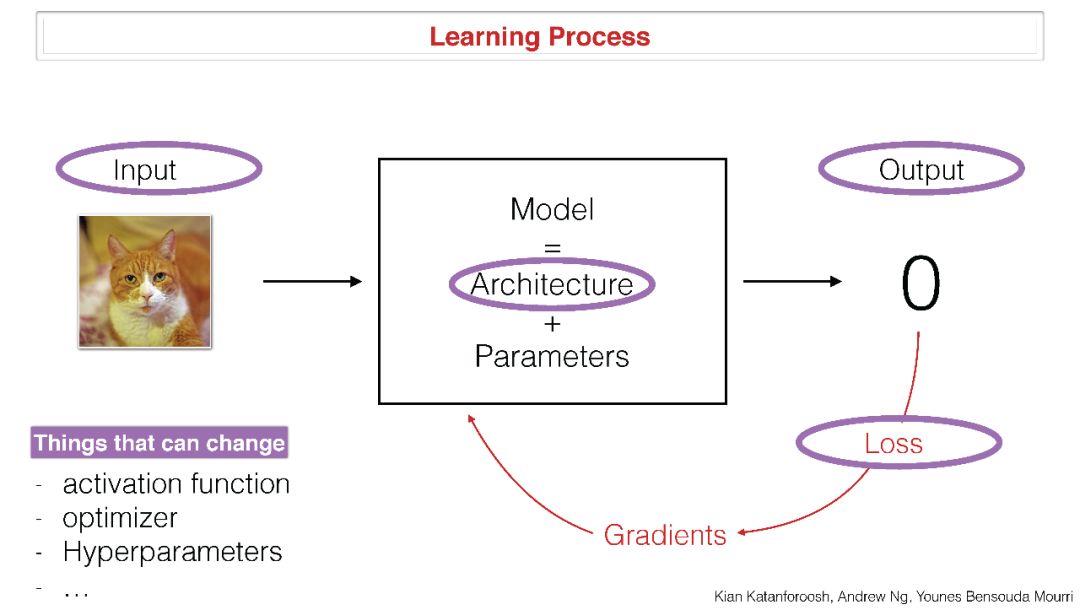

深度学习是人工智能中最受追捧的技能之一。我们将帮助您学习深度学习。在本课程中,您将学习深度学习的基础知识,了解如何构建神经网络,以及如何完成一个成功的机器学习项目。具体地,您将学习卷积网络,RNNs,LSTM,Adam,Dropout,BatchNorm,Xavier / He初始化等等。还可以将该技术应用到医疗,自动驾驶,手语阅读,音乐创作和自然语言处理的案例研究中。您不但要去掌握理论,还要去看看它在工业中的应用。我们将教会您在Python和TensorFlow中实践所有的这些想法。完成本课程后,您可能会找到创造性的方法并将其应用于您的工作。您将可以在家观看视频并完成编程任务和测验,然后来课上进行深入讨论和项目实践。

▌课程信息

时间和地点

星期四上午10:30 - 上午11:50,丁克尔斯比尔礼堂(Dinkelspiel Auditorium)

联系信息

如果您有任何问题,为了尽快获得教学人员的回复,我们强烈建议您将其发布到班级论坛上。 为了获得更好的帮助,我们强烈建议您在办公时间前往交流。您也可以通过电子邮件cs230-qa@cs.stanford.edu

▌助教列表

▌预备知识

要求学生具备以下背景知识:

1. 掌握基本的计算机科学原理和技能,能自己动手写计算机程序。

2. 熟悉概率论(CS 109或STATS 116)

3. 熟悉线性代数(Math 104,Math 113或CS 205中的任何一个)

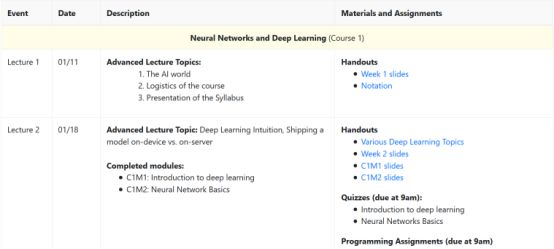

▌课程内容安排

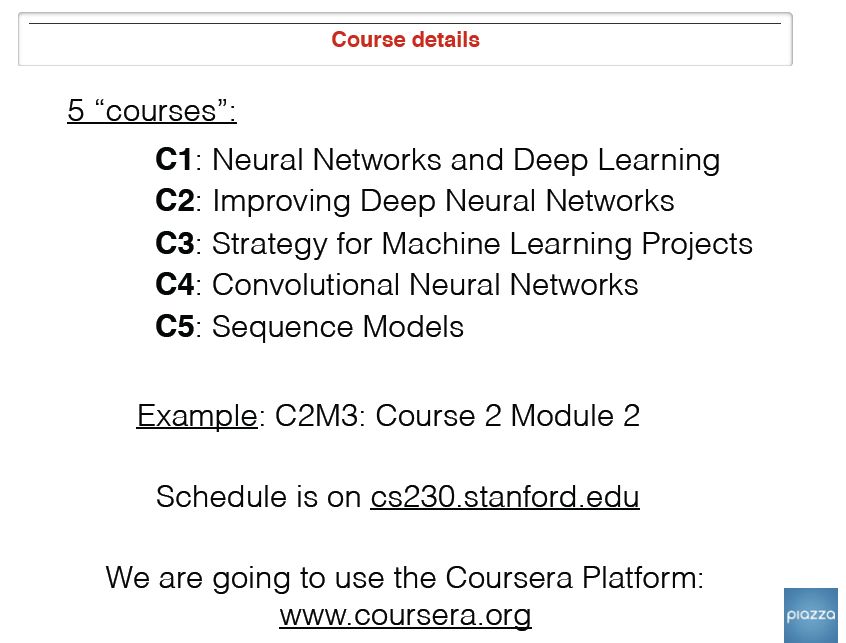

课程一:神经网络和深度学习

第1讲

走进AI世界

课程安排

教学大纲

Slides: https://web.stanford.edu/class/cs230/files/Week1_slides.pdf

第2讲

深度学习介绍

神经网络基础

Slides:

https://web.stanford.edu/class/cs230/files/Week2_slides.pdf

https://web.stanford.edu/class/cs230/files/C1M1.pdf

https://web.stanford.edu/class/cs230/files/C1M2.pdf

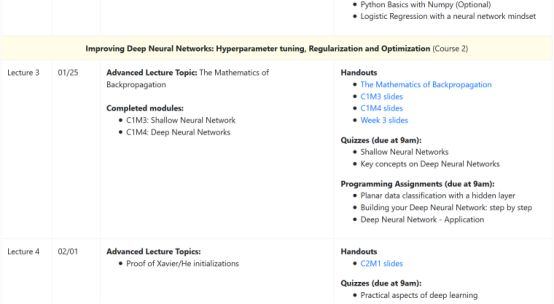

课程二:改进深层神经网络 超参数优化、正则化和优化。

第3讲

反向传播的数学基础

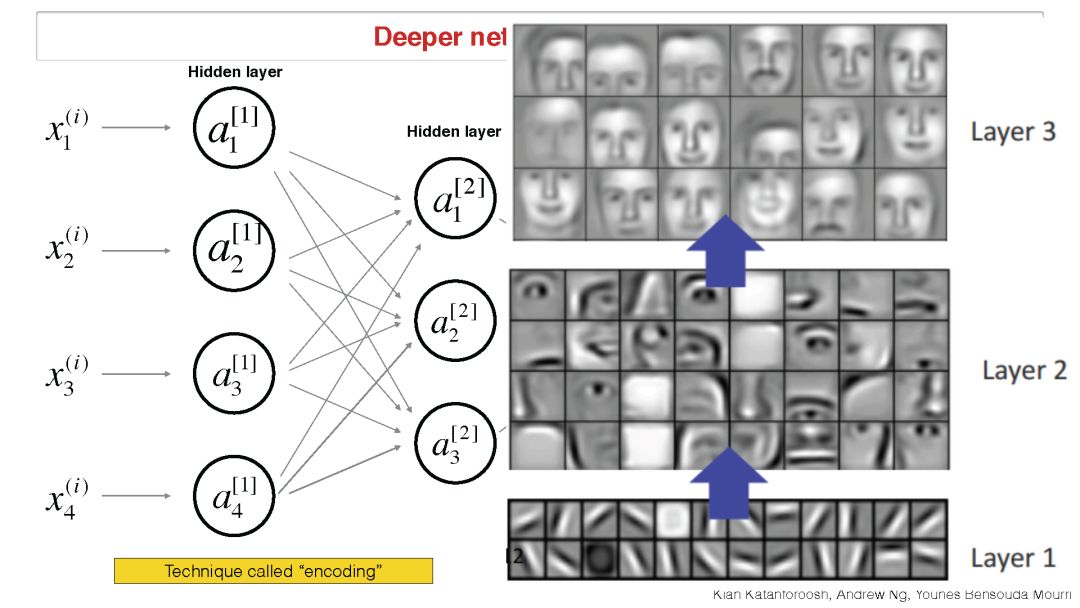

浅层神经网络

深层神经网络

The Mathematics of Backpropagation:

https://web.stanford.edu/class/cs230/files_fall2017/CS230_Handout3.pdf

slides:

https://web.stanford.edu/class/cs230/files/C1M3.pdf

https://web.stanford.edu/class/cs230/files/C1M4.pdf

https://web.stanford.edu/class/cs230/files/lecture-notes-3.pdf

第4讲

深度学习的实践方面

Slides: https://web.stanford.edu/class/cs230/files/C2M1.pdf

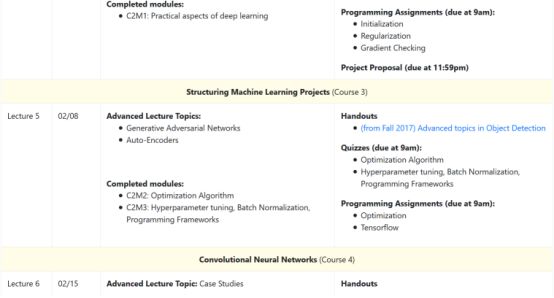

课程三:构建机器学习项目

第5讲

生成对抗网络

自编码器

优化算法

超参数调优,Batch标准化,编程框架。

https://web.stanford.edu/class/cs230/files_fall2017/CS230_Handout6.pdf

课程四:卷积神经网络

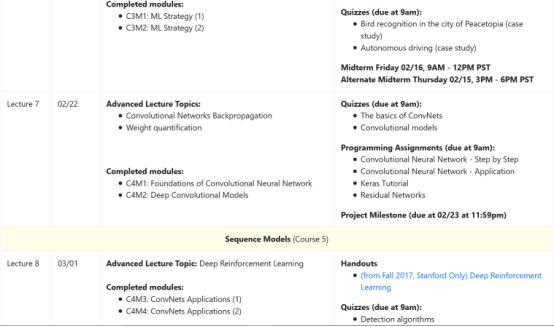

第6讲

案例学习(机器学习策略)

第7讲

卷积网络反向传播

加权量化

卷积神经网络的基础

深度卷积模块

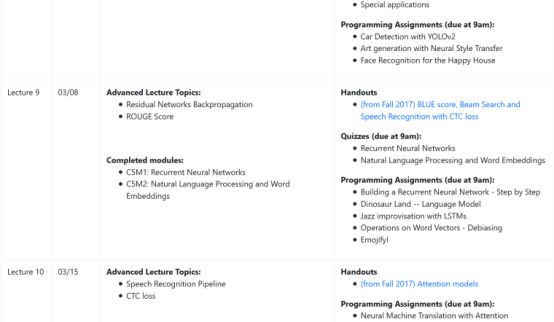

课程五:序列模型

第8讲

深度强化学习

https://docs.google.com/a/stanford.edu/presentation/d/10l5OBS0dWTgkgAWHNQqDziyVk5yRCeX9SPAagMIyc0A/edit?usp=sharing

第9讲

残差网络反向传播

循环神经网络

NLP和词嵌入

https://web.stanford.edu/class/cs230/files_fall2017/CS230_HandOut10.pdf

第10讲

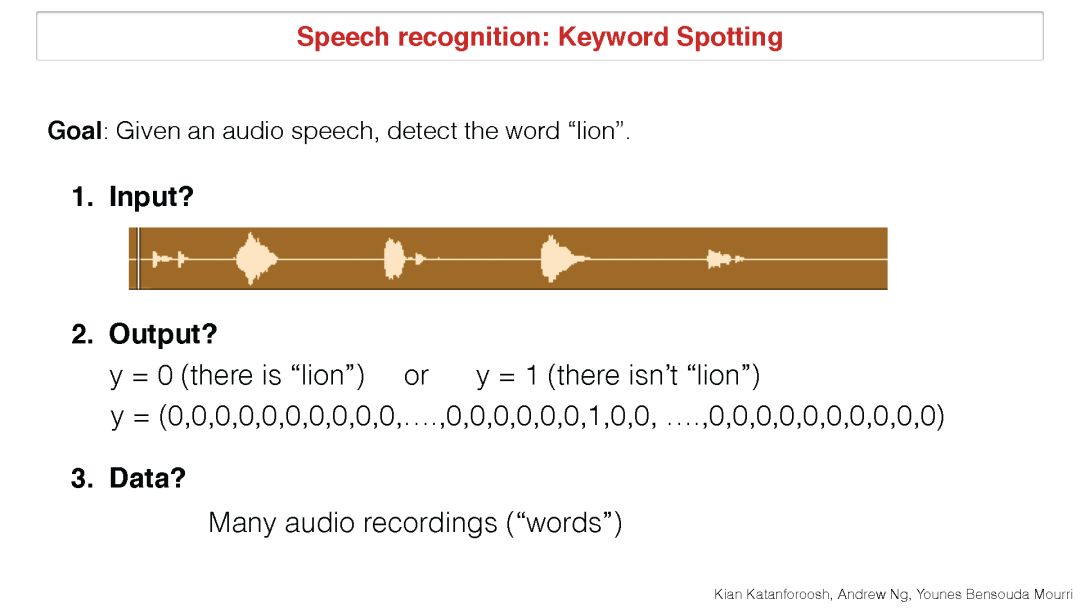

语音识别

CTC损失

注意力机制

https://web.stanford.edu/class/cs230/files_fall2017/CS230_Handout8.pdf

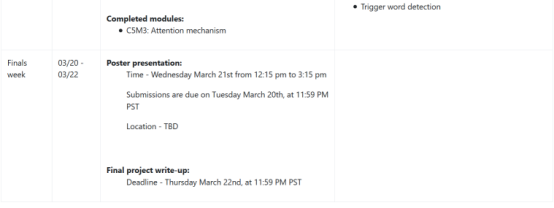

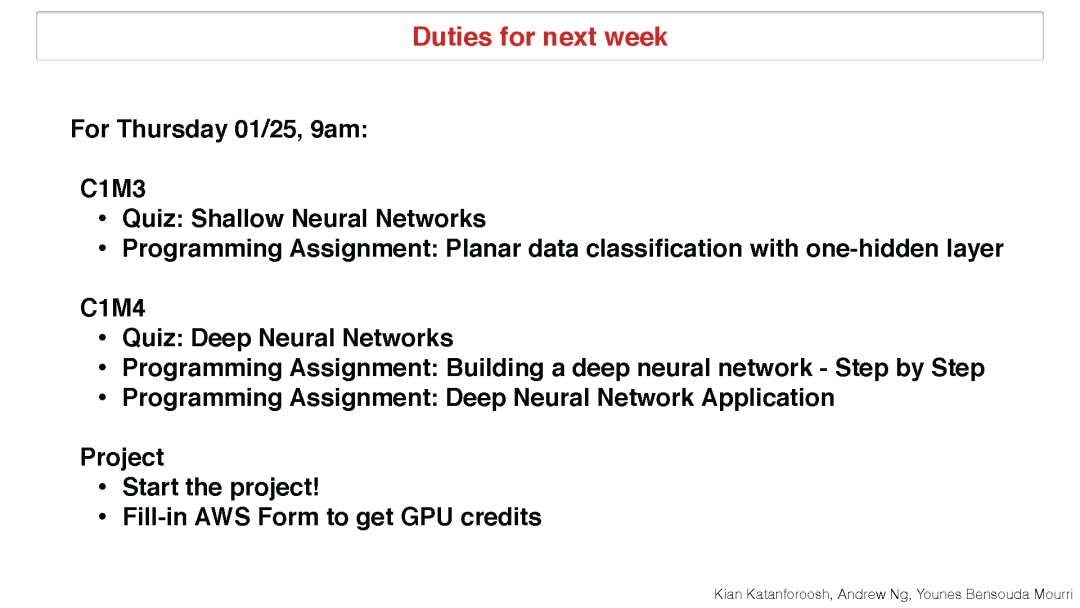

具体课程表截图:

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“CS2302018” 就可以获取 课程已有PPT下载链接~

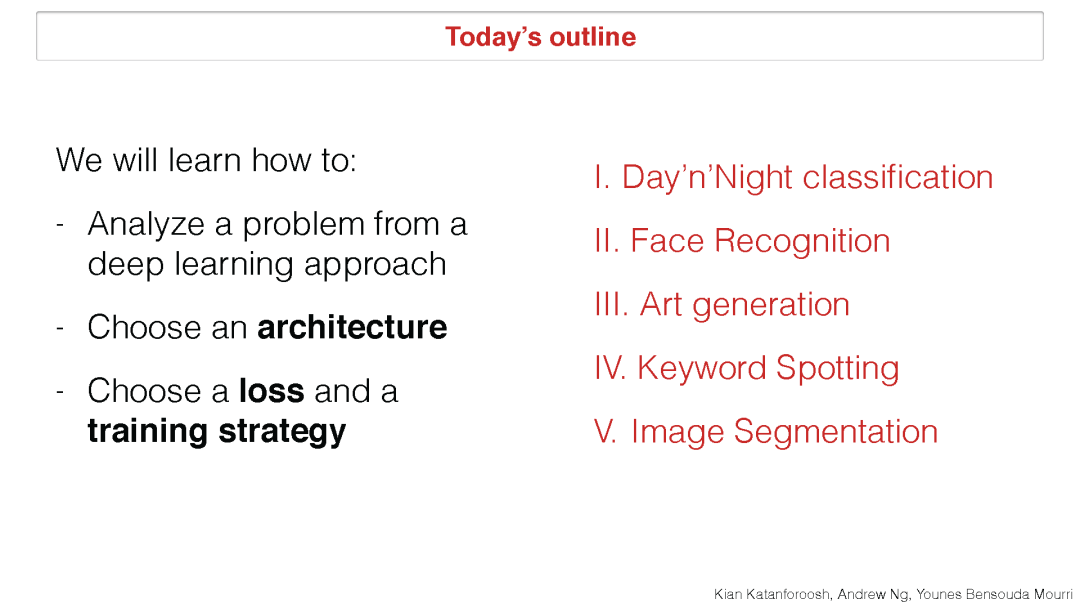

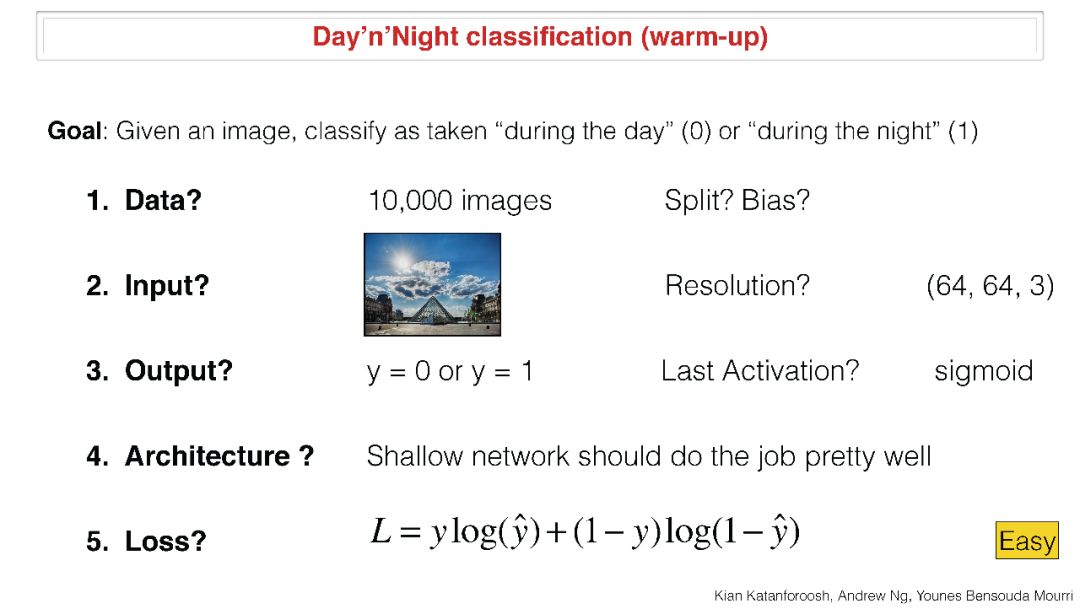

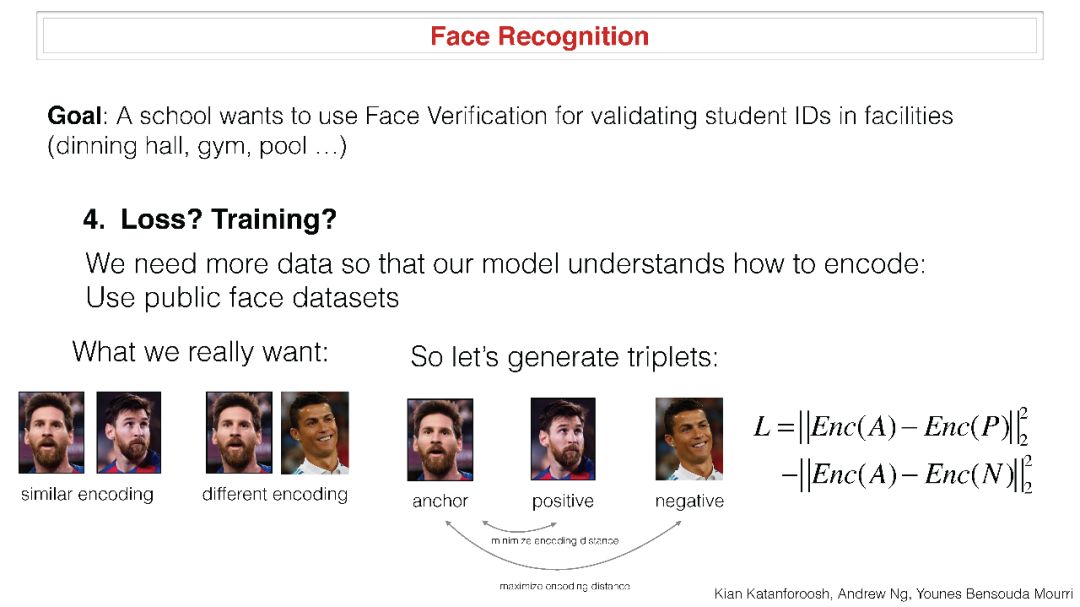

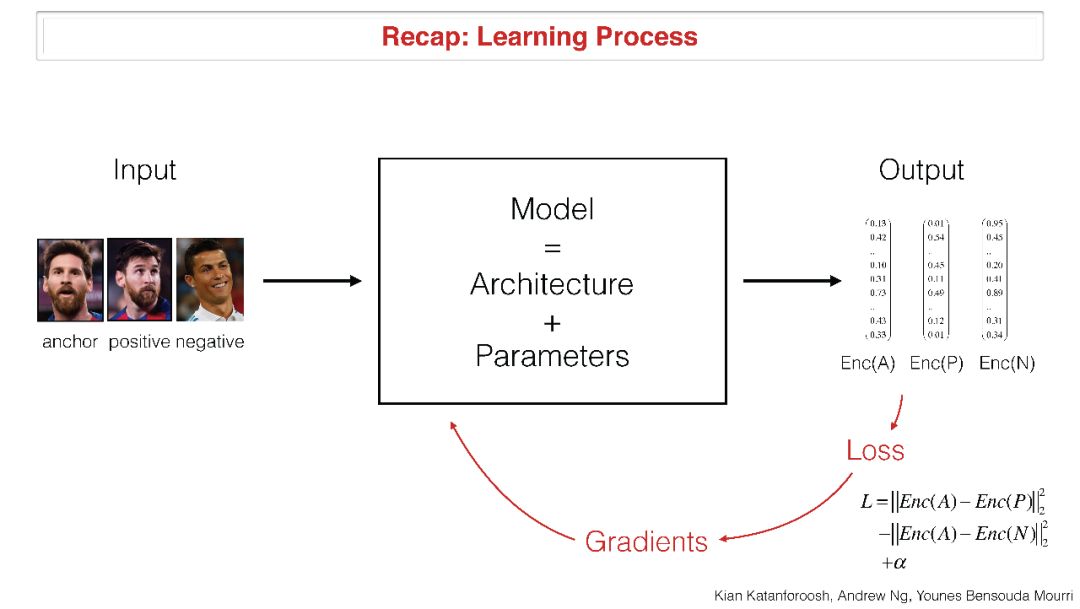

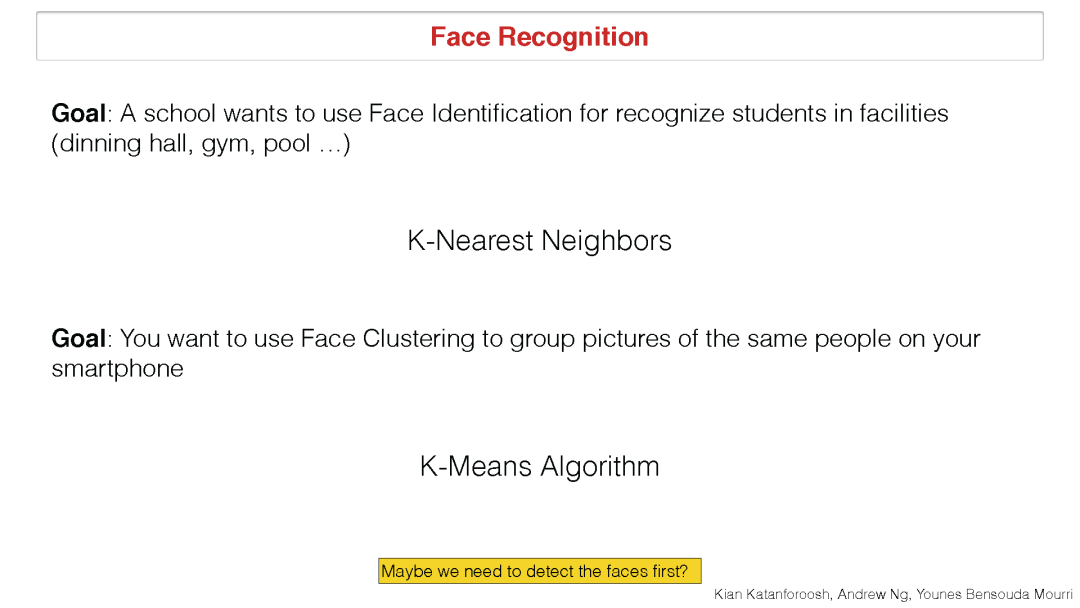

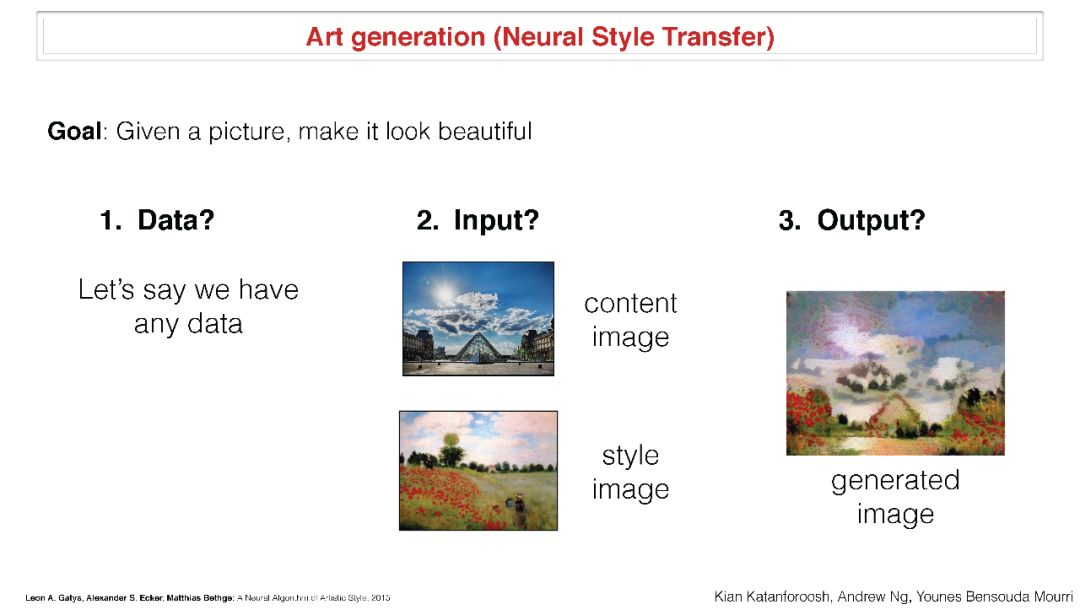

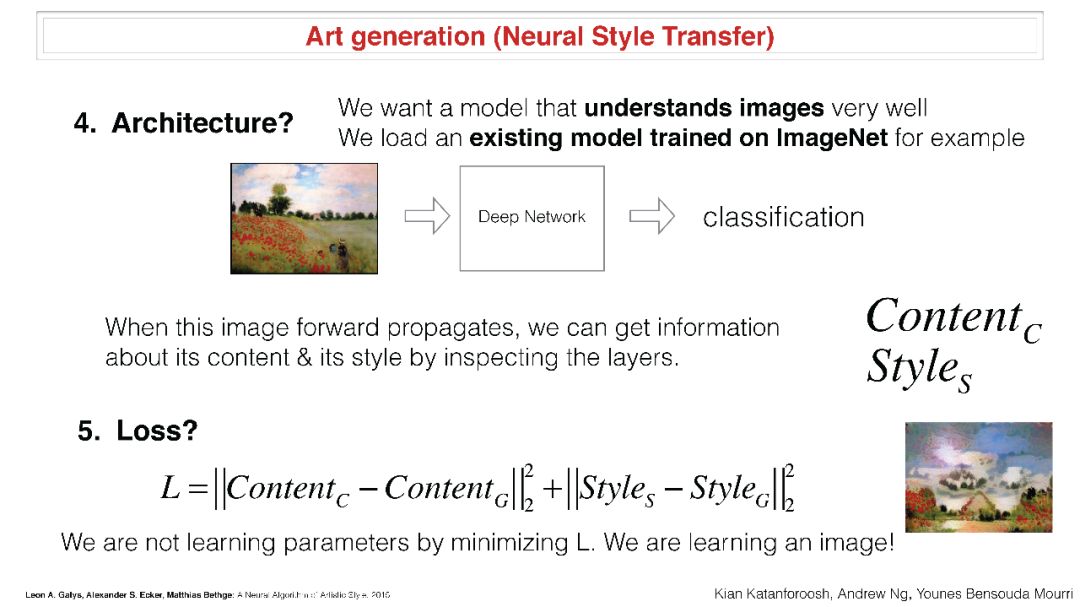

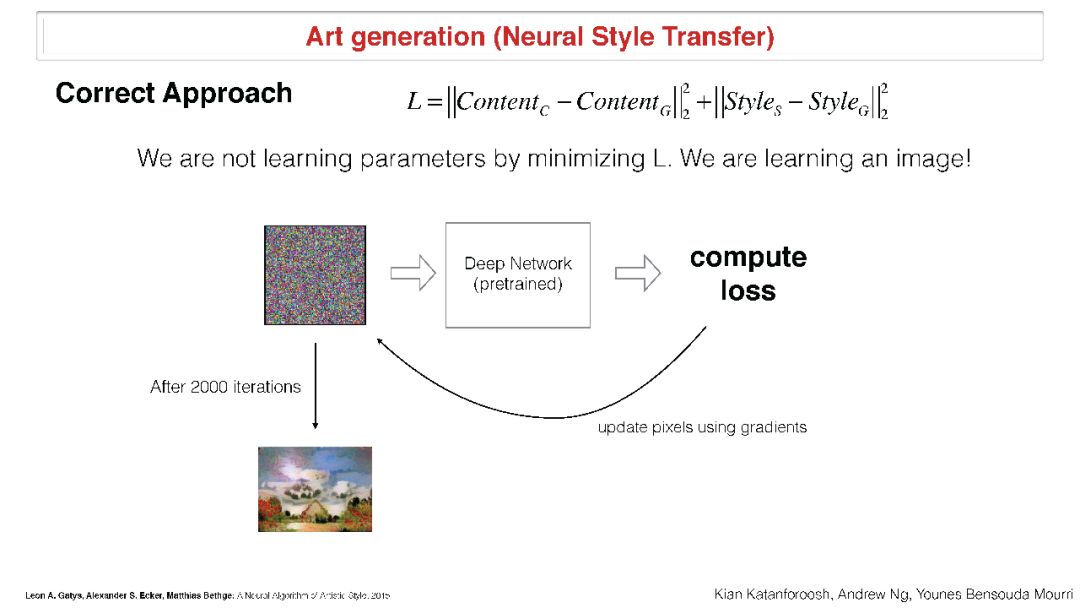

▌前两次课PPT详细内容

原文链接:

https://web.stanford.edu/class/cs230/index.html

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“CS2302018” 就可以获取 课程已有PPT下载链接~

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域26个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!

点击“阅读原文”,使用专知