斯坦福CS224n《基于深度学习的NLP》课程更新,C.Manning主讲

新智元报道

来源:Stanford

编辑:大明

新智元报道

来源:Stanford

编辑:大明

【新智元导读】斯坦福大学官方公布cs224n课程《基于深度学习的自然语言处理》详细安排,主讲人为斯坦福大学人工智能实验室主任,著名计算机科学家Christopher Manning教授,1月份课程阅读材料已公布。本课程自2017 年起开设,2017年该课程视频已公开放出。

近日,斯坦福大学官网公布了2019年度冬季cs224n课程:基于深度学习的自然语言处理的课程安排。本课程主讲人为斯坦福大学人工智能实验室主任,著名计算机科学家Christopher Manning教授。

授课时间和地点:太平洋标准时间每周二/周四,下午4:30-5:50,NVIDIA Auditorium。

本课程从第二周开始,设定数小时的每周辅导时间,包括远程网络辅导,具体时间和地点待定。注册学生的讲座视频届时将在网上公开放出。

公开讲座视频:课程完成后,计划在YouTube上公开发布视频。请耐心等待,因为准备视频以供发布需要一些时间。与此同时,2017年冬季课程视频已在YouTube上公开发布。

cs224n官网链接:

http://web.stanford.edu/class/cs224n/index.html

2017年本课程视频观看地址(油管):

https://www.youtube.com/playlist?list=PL3FW7Lu3i5Jsnh1rnUwq_TcylNr7EkRe6

资格审核:一般来说,如果是斯坦福社区(本校注册学生、教职员工/教师)的成员,我们很高兴您可以参加讲座。如果课程太满,位置不足,会要求本校注册学生参加。由于申请人数众多,我们无法评估任何未正式报名参加课程的学生的作业或项目。

课程内容

这门课程是讲什么的?

自然语言处理(NLP)是信息时代最重要的技术之一,也是人工智能技术的关键部分。 NLP的应用无处不在,因为人们的交流都要使用语言:在网络搜索、广告、电子邮件、客户服务,语言翻译、医学报告等应用都离不开语言。

近年来,深度学习方法在许多不同的NLP任务中已经具备了极高的性能,这些方法使用单个端到端神经模型,不需要传统的、针对特定的功能的项目。

在本课程中,学生将深入了解NLP深度学习的前沿研究现状。通过讲座、作业和期末项目,学习设计、实施和理解构建神经网络模型所需的技能。今年,CS224n将首次使用PyTorch而不是TensorFlow。

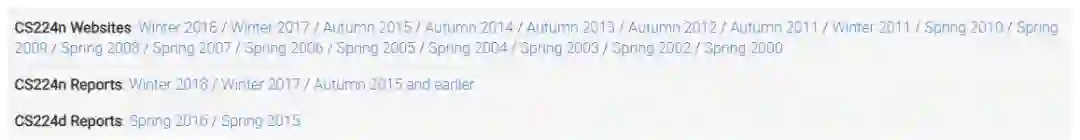

往年课程资源

本课程于2017开始开设,是之前CS224n(自然语言处理)和CS224d(自然语言处理与深度学习)课程的合并,官网上有过去几年相关课程的官网链接和学生项目报告,可供参考。

先修课程/知识要求

精通Python

所有类分配都将使用Python(NumPy和PyTorch)。

本教程可能对那些不熟悉Python和/或NumPy的人有用。如果你有很多编程经验,但使用的不同的语言(例如C / C ++ / Matlab / Java / Javascript)也是没问题的。

大学微积分、线性代数(例如MATH 51,CME 100)

学生应该习惯于使用多变量导数,并理解矩阵/向量符号和运算。

基本概率和统计(例如CS 109或同等课程)

学生应了解概率基础知识、高斯分布、均值、标准差等。

具备一定机器学习的基础(例如CS 221或CS 229)

我们将制定成本函数,采用衍生工具并通过梯度下降进行优化。如果学生已经掌握基本的机器学习/深度学习知识,那么理解本课程将会更容易,但这一点不做强制要求,不掌握这些知识也可以上CS224n这门课。

这里给出了一些参考资源。

Dan Jurafsky and James H. Martin. Speech and Language Processing (3rd ed. draft)

Jacob Eisenstein. Natural Language Processing

Yoav Goldberg. A Primer on Neural Network Models for Natural Language Processing

Ian Goodfellow, Yoshua Bengio, and Aaron Courville. Deep Learning

课程表与授课内容已公布,附1月课程阅读材料

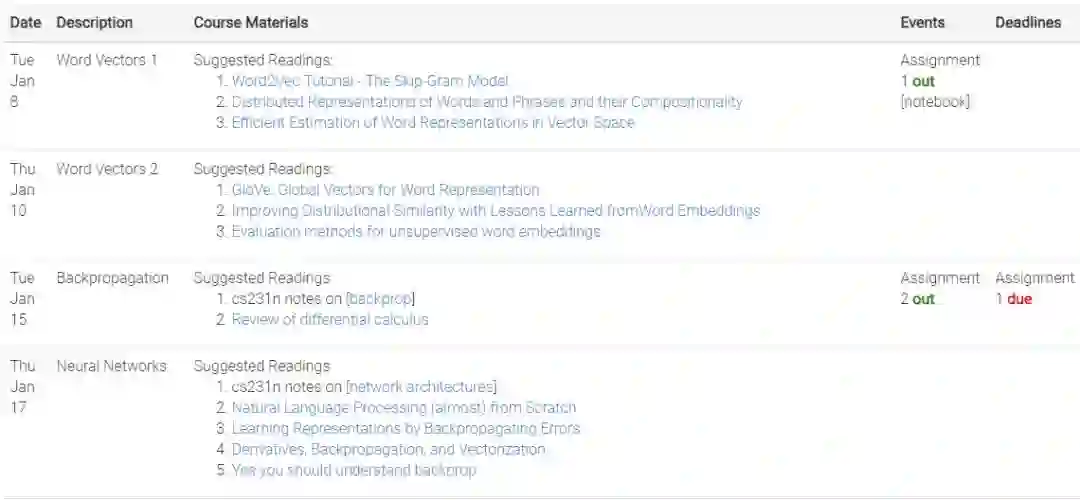

目前CS224n的2019年度课程表已经公布,授课时间从1月8日至3月14日,每周二和周四授课。其中1月份课程的建议阅读材料已经给出。

按照时间顺序,1月份授课主题分别为:

词向量、反向传播、神经网络、依存句法分析、递归神经网络和语言模型、梯度消失和RNN、机器翻译、Seq2Seq和注意力。

更多信息和资源,可访问斯坦福cs224n官网链接:

http://web.stanford.edu/class/cs224n/index.html

【加入社群】

新智元 AI 技术 + 产业社群招募中,欢迎对 AI 技术 + 产业落地感兴趣的同学,加小助手微信号:aiera2015_2 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名 - 公司 - 职位;专业群审核较严,敬请谅解)。