NIPS 2018论文评审出炉:大型车祸现场

昨天,NIPS 2018的论文评审结果已经陆续出炉了,成绩公布后总是有喜有忧,分数高自然意味着自己的作品被评委们肯定,但是分数低的同学们内心难免失落,若是再看到令人费解的评语,可就真的扎心了。

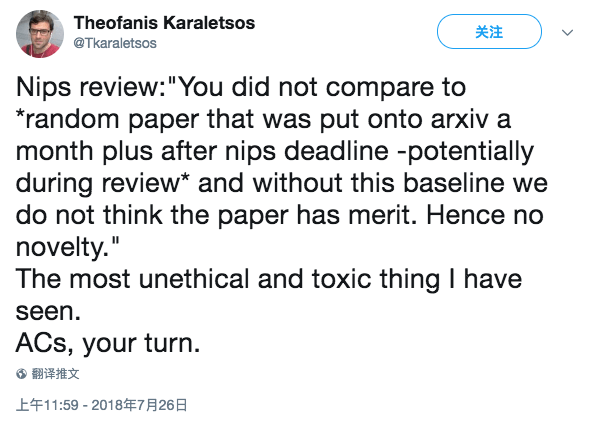

昨天开始,就有网友陆续在社交媒体上吐槽自己得到的NIPS论文的评审意见,首先是这位名叫Theofanis Karaletsos的网友,他是Uber AI实验室的一名研究者。

我收到的NIPS评语:“截稿后一个多月,arXiv上发布了一篇随机论文,你没有跟它作对比啊,那个时候还处于评审阶段呢,要是没这个基准对比的话,我们认为这篇论文没有价值。综上,没有创新性。”

这是我见过最不道德且恶毒的评论。

请AC出来走两步。

评论区也是一片心疼的声音。

@Jeff Clune:“我们在ICML的深度神经演化论文也是这样的结果。”

@Zi Wang:“我之前的NIPS评语更搞笑,他们问我proof最后的小方块是啥。”

@Jakob Macke:“这个表述太蠢了吧……AC肯定得介入下。万一评审员就是那篇arXiv的作者之一可就真尴尬了……”

@Jasper:“这绝对是评审员的错。任何没经过同行评议的论文都不能算作是前人研究。”

伤心之余,Karaletsos还是告诉大家,他收到的评审意见其实很长,大部分内容都还是很正常的,只是这些批评真的很让人生气。

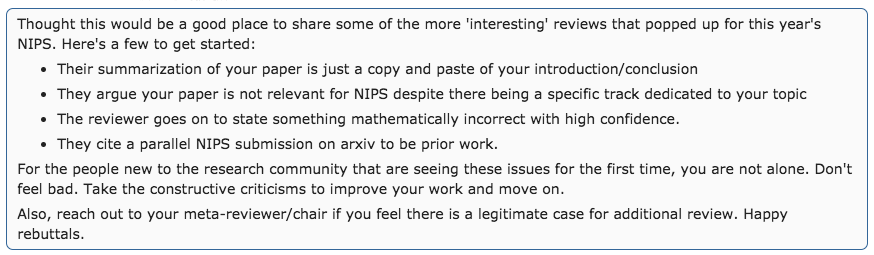

这位小哥的遭遇也并不是唯一一例,在reddit上也有很多网友说出了自己的故事,比如评审员说他们的论文根本没有新颖的算法,或者认为他们的论文和NIPS不相关,有的甚至直接复制粘贴论文的简介或结论作为评审意见。总之,就很气。

真的质量差还是“灌水”的副作用

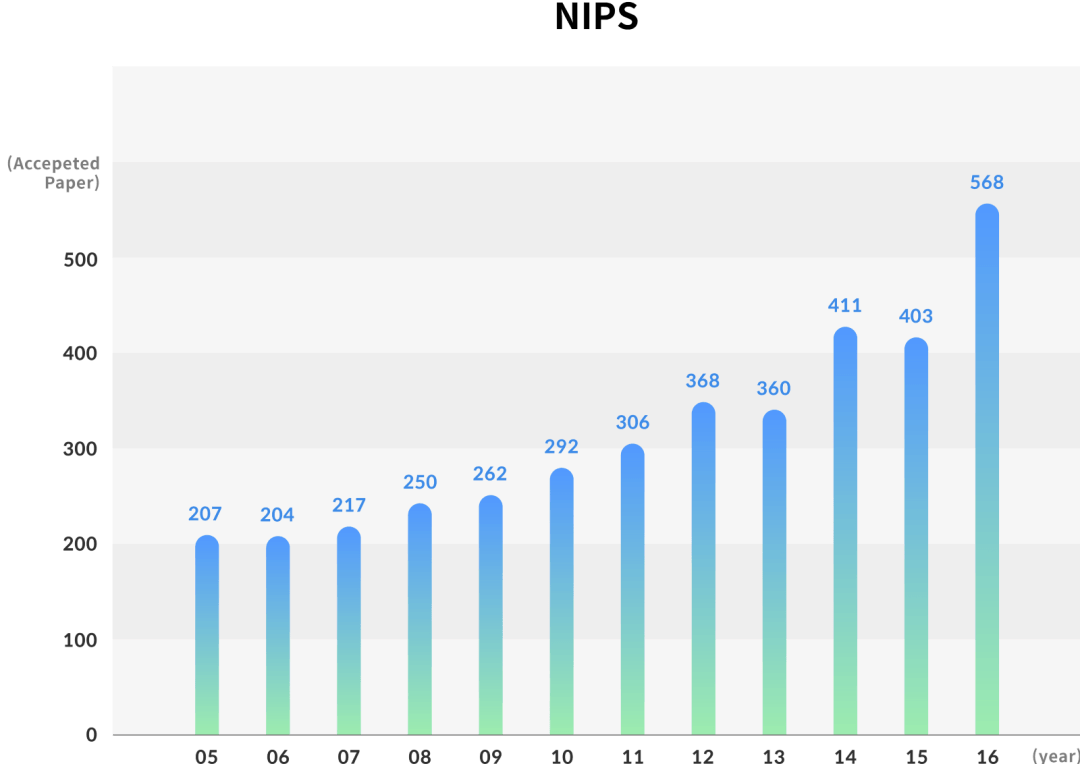

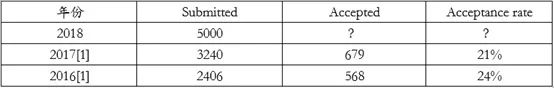

随着机器学习、神经网络等话题热度不断攀升,专业领域内涌入的人才也越来越多。去年11月,韩国Kakao AI Report就统计了2005年至2016年在NIPS上发布的论文,总体看来接收论文的数量在稳步上升,而今年(2018年)提交到NIPS的论文更是达到了近5000篇。

来源:Kakao AI Report

来源:知乎@mileistone

NIPS 2018的论文提交截止日为5月18日,距今也只有两个多月的时间,如此大量的论文必然需要足够的审稿人,审稿质量自然很难保证,甚至还有本科生作为审稿人的情况出现。所以说,收到一些不专业、毫无道理的评审意见似乎已经是各大会议的家常便饭了。

但是NIPS作为机器学习和计算机神经科学的顶级会议,评审过程真的这么随意吗?

官方评审细则

在NIPS 2018的官网,有关Reviewing的部分如下:

不论是审稿人还是区域主席(AC),审稿过程都是双盲评审,即审稿人和区域主席不知道论文作者是谁,但是在高级区域主席和项目主席评审阶段不采用双盲形式。在评审过程中,论文作者有一周的时间对最初的审稿意见作出回应。当论文决定是否接收后,评审意见以及最初的意见,还有作者的回应都会公布出来,但不会公布审稿人、区域主席和高级区域主席。被拒绝的论文作者仍可以公开评审意见及回应,如果本人同意的话。

在这一段评审细则中,重点就是“双盲评审”,这也是目前很多大会通用的审稿规则,最初的目的就是为了保证公平。可是这个双盲评审也只限于区域主席及以下审稿过程,到了更高的阶段,审稿人仍能知道作者的姓名和所在机构。

除此之外,在我们此前报道过的一篇论文中(即使匿名也能知道论文作者?双盲评审的效力究竟如何?)讲到,经验丰富的审稿人可能会通过论文话题、前人研究、数据集或代码的引用等细节发现蛛丝马迹,从而推测出论文作者。虽然这种猜测的命中率并非百分之百,但是绝对做不到完全的匿名。

另一方面,“双盲”能否完全贯彻也是一个值得讨论的问题,它不仅仅涉及评审过程中的完全“双盲”(即从头到尾保护作者信息),甚至在没有投稿前就要保密。这里可参考计算机语言学协会(ACL)最新的投稿规则。近日ACL修订了投稿、评审和引用规则,要求ACL下属会议的匿名投搞论文在会议投稿截止日期前的一个月内不允许上传到非匿名预印本平台(比如arXiv),并且直到论文评审结果公布后才可以公开上传。

此前,微软研究院首席研究员、CVPR 2019的程序主席华刚博士在接受采访时也表示,arXiv让双盲评审形同虚设。原因就在于,arXiv上的论文很多都没有经过同行评议,质量参差不齐,其中有些论文的观点不一定正确,或者带有偏见。如果提前上传到arXiv,双盲评审就失去了意义。这也反应了文章开头Karaletsos遇到的问题,NIPS的评审人将新上传的、没经过同行审议的论文作为标准并否定了Karaletsos的创新性,看起来确实不严谨。

写封反驳信也许还有机会

虽然分数似乎凉凉,如果你对自己的论文还抱有一丝信心,还可以抓紧时间写一封rebuttal为自己辩护一下。小编搜了一下,网上有很多反驳信的模板,我们以IJCAI官方给出的建议为例,给大家展示反驳信应该写些什么。

反驳信的目的是解答审稿人提出的问题并且指出他们的错误或误解之处。写得过长或包含不相关信息只会给你的论文减分,因为审稿人不会看一篇很无聊的反驳信,而且还会漏掉重要信息。所以一定要控制在2000个字符以内(字符!字符!字符!NIPS不一定是2000,但是字数不能太多就是了)。

除此之外,更重要的是直面审稿人的问题,如果真的是自己遗漏了某个要点,就要承认并作出具体改进计划。如果是审稿人的理解有问题,那就需要详细解释。

下面是反面教材一:

“Dear reviewer, you write that programming an intelligent frying pan is not in the scope of IJCAI. We strongly disagree. Moreover, a paper about an intelligent bread toaster has been published at IJCAI a few years ago.”

不要说你不同意评审员认为你的项目不属于该领域,要知道在审议时还会有别的审稿人,如果他犯了错误,其他审稿人会指出的。

反面教材二:

“Dear reviewer, you write that the performance if our algorithm is only a small improvement over the state of the art. We think it is a huge improvement.”

个人认为自己的工作有较大提升,这种辩解毫无意义。

反面教材三:

“Dear reviewer, you write that our contribution should have be positioned with respect to a paper by Moet and Chandon. You are right, this is an important omission. In the final version we will include a detailed comparison between their work and ours.”

不要承诺很模糊的事情,要说具体怎么做。

以下是一些句子示范,重点把握思路,一定要做到有理有据,符合逻辑:

“Dear reviewer, you write that our work on an intelligent saucer should have be positioned with respect to a paper by Spielberg et al. However, the latter considers intelligent flying saucers, while our work is about cooking.”

“Dear reviewer, you write that our contribution should have be positioned with respect to a paper by Moet and Chandon. You are right, this is an important omission. We were unaware of their work. We read it and found out that their paper identifies the computational complexity of deciding whether two XXXX databases are superweakly equivalent, which subsumes our Proposition 17. However, all our other results remain unconcerned.”

以上只是一些粗略的建议,毕竟每个人的论文情况都不一样。有了反驳的机会就要去试嘛,毕竟不会有什么损失,万一成功了呢?不过话说回来,如果真的是reviewer想挂这篇论文那还真是没办法了……

欢迎各位在评论区讨论自己那些年发过paper的心路历程!

参考资料:www.ijcai-18.org/faq/#q5

twitter.com/Tkaraletsos/status/1022360838408040448

www.zhihu.com/question/32055996

www.msra.cn/zh-cn/news/features/gang-hua-20170516