【泡泡一分钟】DeNet:带有定向稀疏采样的可扩展实时目标检测(ICCV2017-43)

每天一分钟,带你读遍机器人顶级会议文章

标题:DeNet: Scalable Real-time Object Detection with Directed Sparse Sampling

作者:Lachlan Tychsen-Smith, Lars Petersson

来源:ICCV 2017 ( IEEE International Conference on Computer Vision)

播音员:糯米

编译:张建 周平(45)

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

我们从图像问题中去定义目标检测,如同去估计一个非常大却极其稀疏的边界框的依赖概率分布。随后,我们确定了一个稀疏分布估计方案,定向稀疏采样,并在一个基于单一端到端CNN的检测模型上使用它。

这种方法扩展并形式化了以前最先进的检测模型,额外地强调了高的评价率与简化的人工工程。

我们引入了两个创新点,一个基于角点的兴趣区域估计器和一个基于反卷积的CNN模型。

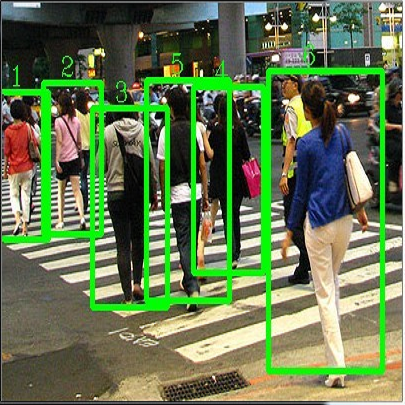

由此产生的模型是场景自适应的,不需要手动定义的参考边界框,并且可以在MSCOCO,Pascal VOC 2007和Pascal VOC 2012上产生具有高度竞争力并带有实时评价率的结果。

进一步的分析表明,在渴望细粒度的目标定位时,我们的模型表现的特别的好。我们认为,这种优势源于相对于其他方法的非常大的可用兴趣区域集合。

源代码地址:https://github.com/lachlants/denet

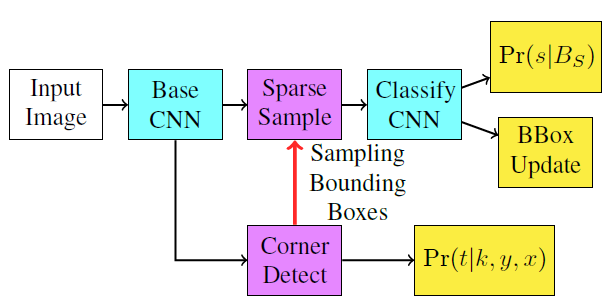

图1。一个高层的流程图描绘了DeNet的方法。

其中CNN被标记位蓝色,新组件为紫色,输出为黄色。采样边界框依赖性(用红色标注)在反向传播期间保持恒定,从而产生一个端到端的训练模型。角点分布与最终的分类分布采用交叉熵损失来联合优化。

Abstract

We define the object detection from imagery problem as estimating a very large but extremely sparse bounding box dependent probability distribution. Subsequently we identify a sparse distribution estimation scheme, Directed Sparse Sampling, and employ it in a single end-to-end CNN based detection model. This methodology extends and formalizes previous state-of-the-art detection models with an additional emphasis on high evaluation rates and reduced manual engineering. We introduce two novelties, a corner based region-of-interest estimator and a deconvolution based CNN model. The resulting model is scene adaptive, does not require manually defined reference bounding boxes and produces highly competitive results on MSCOCO, Pascal VOC 2007 and Pascal VOC 2012 with real-time evaluation rates. Further analysis suggests our model performs particularly well when finegrained object localization is desirable. We argue that this advantage stems from the significantly larger set of available regions-of-interest relative to other methods. Source-code is available from: https://github.com/lachlants/denet

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com