328页ppt! Allen等ACL2022《少样本自然语言处理》教程,阐述最新前沿技术

ACL 是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。一直以来,ACL 在 NLP 领域的学术影响力都位列第一,它也是 CCF-A 类推荐会议。今年的 ACL 大会已是第 60 届,于 5 月 22-5 月 27 在爱尔兰都柏林举办。

ACL 2022论文奖项公布,伯克利摘得最佳论文,陈丹琦、杨笛一等华人团队获杰出论文

来自微软等最新ACL2022教程《知识增强自然语言处理》教程,值得关注!

https://github.com/allenai/acl2022-zerofewshot-tutorial

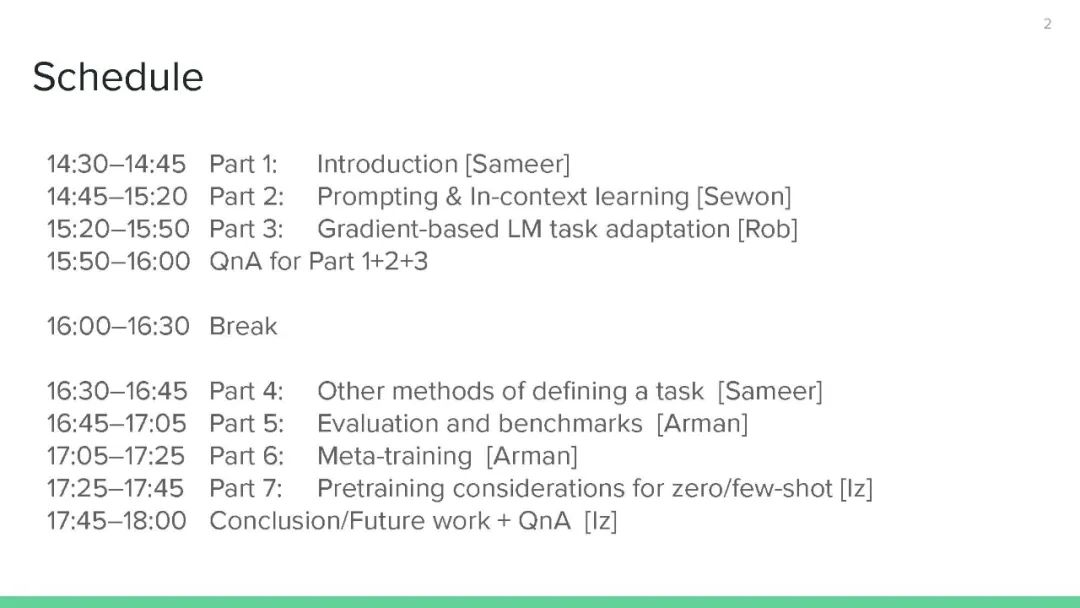

目录内容:

参考文献:

Language Models are Few-Shot Learners (Brown et al., 2020)

It’s Not Just Size That Matters: Small Language Models Are Also Few-Shot Learners (Schick and Schütze, 2021)

Multitask Prompted Training Enables Zero-Shot Task Generalization (Sanh et al., 2021)

FLEX: Unifying Evaluation for Few-Shot NLP (Bragg et al., 2021)

讲者:

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“FSNLP” 就可以获取《少样本NLP?Allen等ACL2022《少样本自然语言处理》教程,阐述最新前沿技术,附328页ppt》专知下载链接

登录查看更多