ACL 是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。一直以来,ACL 在 NLP 领域的学术影响力都位列第一,它也是 CCF-A 类推荐会议。今年的 ACL 大会已是第 60 届,将于 5 月 22-5 月 27 在爱尔兰都柏林举办。

ACL 2022论文奖项公布,伯克利摘得最佳论文,陈丹琦、杨笛一等华人团队获杰出论文

来自DeepMind等学者Aishwarya Agrawal, Damien Teney, Aida Nematzadeh做了关于《视觉语言预训练:当前趋势与未来》教程,值得关注!

本教程的目标是概述多模态预训练问题的处理所需的要素,特别是视觉和语言。我们还将讨论这一领域的一些开放性问题和有希望的未来方向。

在过去的几年里,人们对建立多模态(视觉语言)模型越来越感兴趣,这些模型是在较大但噪声较大的数据集上进行预训练的,其中两种模态(如图像和文本)松散地相互对应(如ViLBERT和CLIP)。给定一个任务(比如可视的问题回答),这些模型通常会针对特定于任务的监督数据集进行微调。除了更大的预训练数据集,Transformer体系结构,特别是应用于两种模态的自注意力,最近的预训练模型在下游任务上的令人印象深刻的性能。

这种方法之所以有吸引力,有几个原因: 首先,预训练数据集通常是自动从Web上整理出来的,以微不足道的收集成本提供了巨大的数据集。第二,我们可以训练大型模型一次,并在各种任务中重用它们。最后,这些预训练方法的表现更好或与以前的特定任务模型持平。一个有趣的问题是,除了良好的任务表现,这些预训练的模型是否学习了更好地捕捉两种模态之间的一致性的表征。在本教程中,我们关注最近的视觉语言预训练范例。我们的目标是首先提供图像-语言数据集、基准和建模创新。接下来,我们讨论用于视觉语言预训练的不同模型家族,强调它们的优点和缺点。最后,我们讨论了通过统计学习进行视觉语言预训练的局限性,以及因果建模等替代方法的必要性。

https://vlp-tutorial-acl2022.github.io/

目录内容:

**1. 引言 Introduction: the goal of the tutorial (5 minutes) **

2. 视觉语言概览 Vision-language landscape before the pretraining era (55 minutes)

**Motivation for vision-language research from both application and research point of views. **

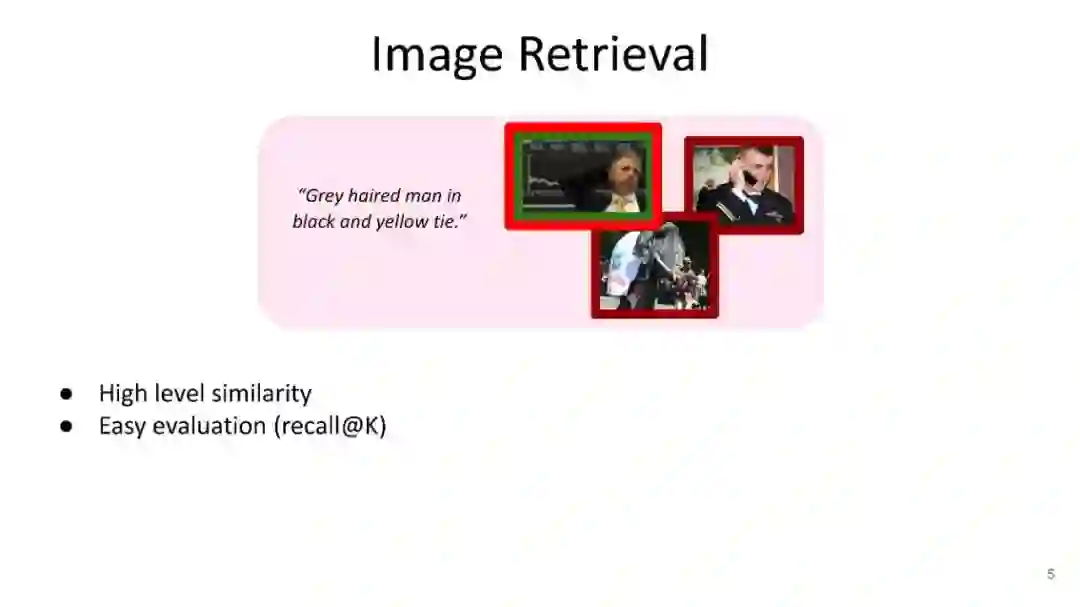

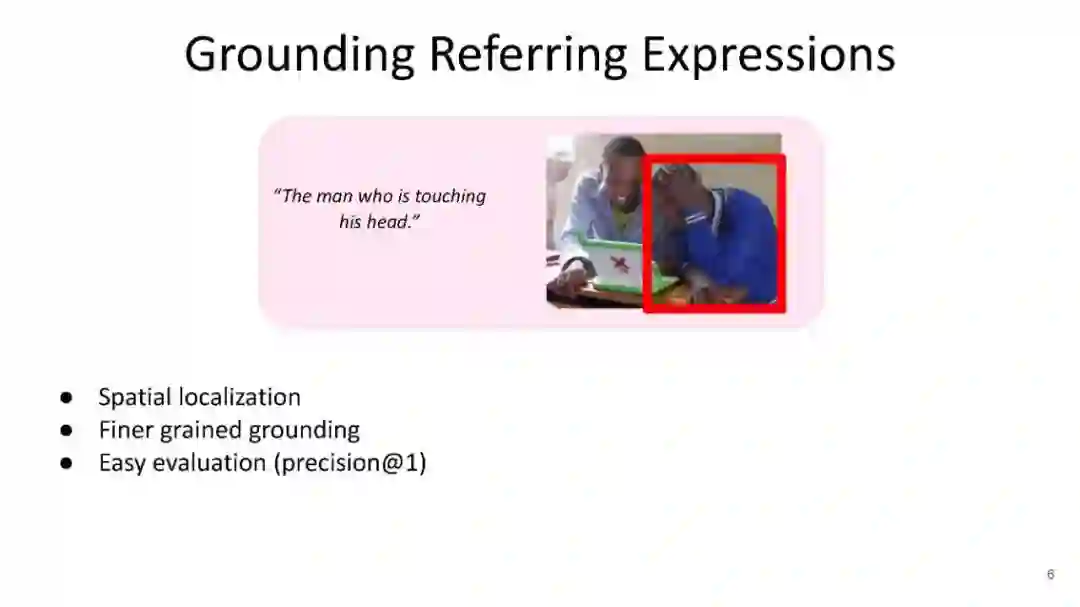

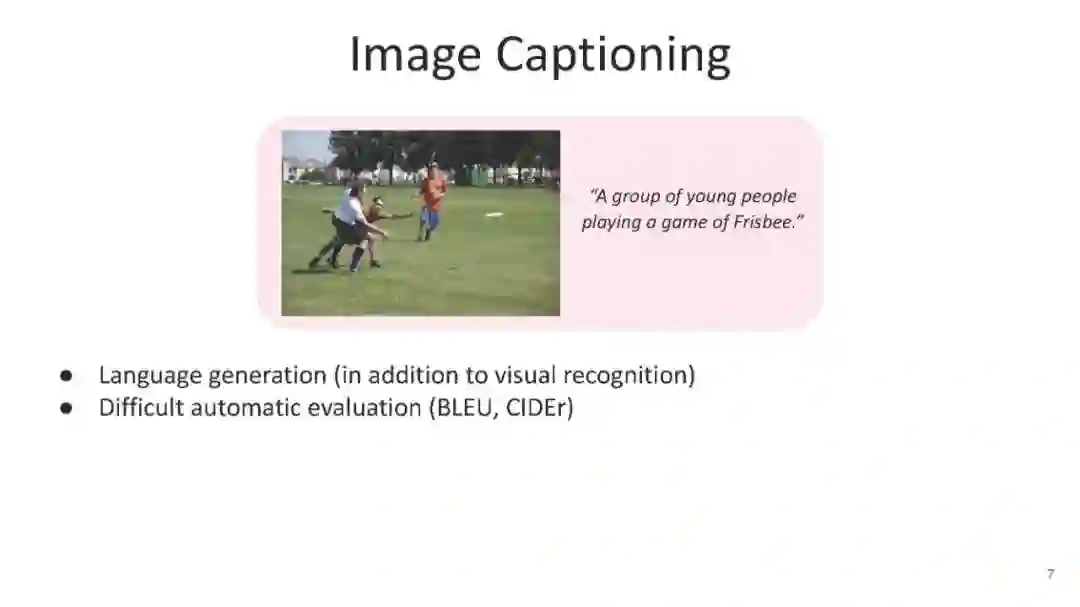

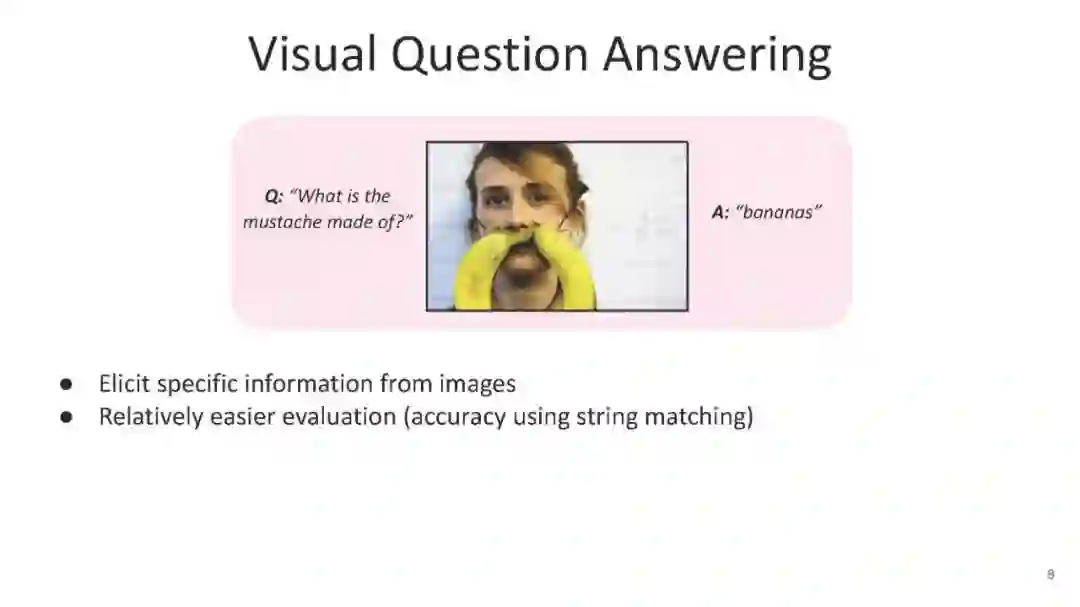

**Popular vision-language tasks, datasets and benchmarks (e.g., image-retrieval, referring expressions, image captioning, visual question answering). **

Task specific modelling approaches and fundamental innovations before the pretraining era (e.g., CNN + LSTM based approaches, language guided image attention, multimodal pooling, compositional networks).

**3. 视觉语言预训练 Vision-language pretraining (VLP) (60 minutes) **

**– Inspiration from pretraining successes in NLP (transformers, BERT, GPT). **

**– Different families of VLP models (all are transformer based models): * Models using task-specific heads for each downstream task (e.g., ViLBERT, LXMERT, UNITER, OSCAR, VinVL). **

*** Models treating all downstream tasks as language generation tasks, i.e. no task-specific head (e.g., VL-T5, VLBART, SimVLM). **

*** Models using VLP data for improving performance on vision tasks (e.g., CLIP, ALIGN). **

*** Models using VLP data for improving performance on language tasks, including multilingual data (e.g., Vokenization, M3P, VL-T5, SimVLM). **

– Different VLP datasets and how they affect the downstream task performance w.r.t their size, degree of noise, and similarity with downstream datasets.

4. Beyond statistical learning in vision-language

讲者:

Aishwarya Agrawal (DeepMind, University of Montreal, Mila), Damien Teney (Idiap Research Institute), and Aida Nematzadeh (DeepMind)