【干货书-斯坦福】最优化算法,521页pdf,《Algorithms for Optimization》MIT出版社

这本书全面介绍优化工程系统设计的实用算法。这本书从工程的角度进行优化,其目标是设计一个系统来优化受约束的一组指标。读者将学习一系列挑战的计算方法,包括高维搜索空间,处理有多个竞争目标的问题,以及适应指标中的不确定性。图表、例子和练习传达了数学方法背后的直觉。文本提供了Julia编程语言的具体实现。

https://mitpress.mit.edu/books/algorithms-optimization

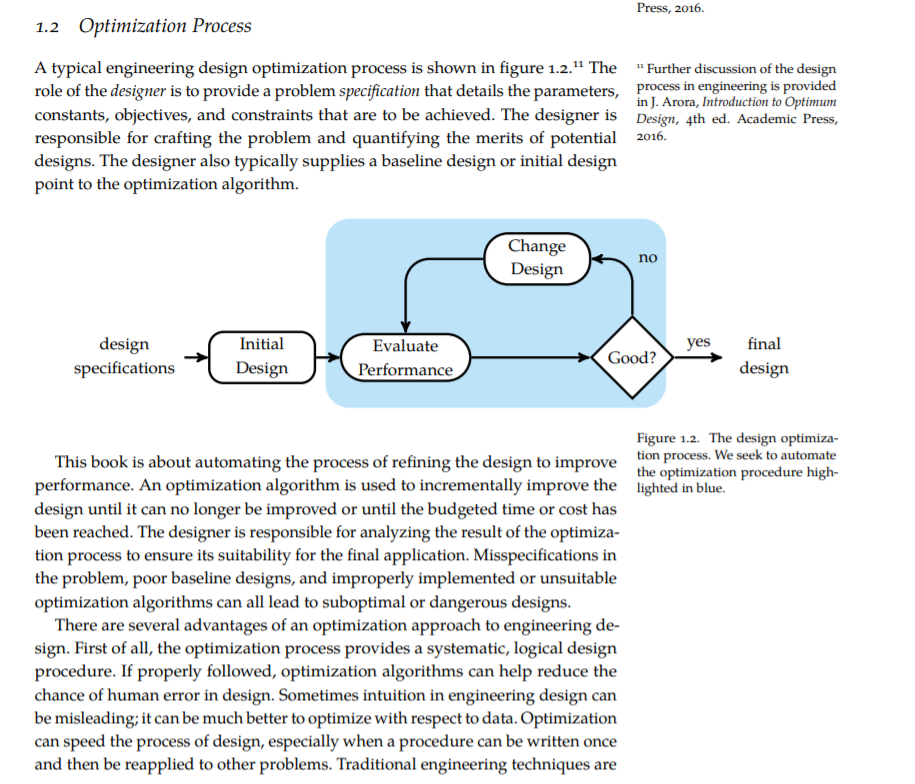

许多学科的核心都涉及到优化。在物理学中,系统被驱动到他们的最低能量状态服从物理定律。在商业上,公司的目标是股东价值最大化。在生物学中,越健康的生物体越有可能生存下来。这本书将从工程的角度关注优化,目标是设计一个系统来优化受约束的一组指标。这个系统可以是一个复杂的物理系统,比如飞机,也可以是一个简单的结构,比如自行车车架。这个系统甚至可能不是物理的;例如,我们可能会有兴趣为自动化车辆设计一个控制系统,或设计一个计算机视觉系统来检测肿瘤活检的图像是否为癌。我们希望这些系统能运行得尽可能好。根据应用程序的不同,相关的度量可能包括效率、安全性和准确性。对设计的限制可能包括成本、重量和结构坚固性。

这本书是关于优化的算法,或计算过程。给定系统设计的一些表示,如编码机翼几何的一组数字,这些算法将告诉我们如何搜索空间的可能设计,以找到最好的一个。根据应用程序的不同,这种搜索可能涉及运行物理实验,比如风洞测试,也可能涉及计算解析表达式或运行计算机模拟。我们将讨论解决各种挑战的计算方法,例如如何搜索高维空间,处理有多个竞争目标的问题,以及适应指标中的不确定性。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“A521” 可以获取《最优化算法,521页pdf,《Algorithms for Optimization》MIT出版社》专知下载链接索引