近期必读的5篇顶会CVPR 2021【行为识别】相关论文和代码

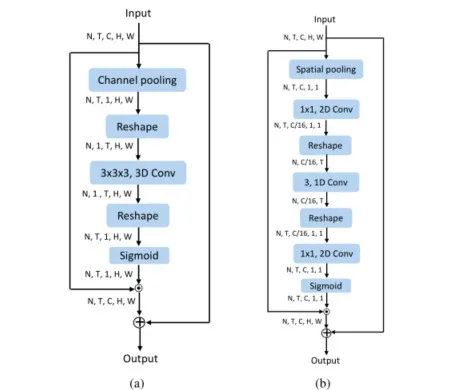

1. ACTION-Net: Multipath Excitation for Action Recognition

作者:Zhengwei Wang, Qi She, Aljosa Smolic

摘要:时空,channel-wise和运动模式是视频动作识别的三种互补且至关重要的信息类型。传统的2D CNN在计算上简单,但无法捕捉时间关系。3D CNN可以实现良好的性能,但计算量很大。在这项工作中,我们通过设计可以嵌入到2D CNN中的通用有效模块来解决这一难题。为此,我们提出了一个时空,通道和运动激发(ACTION)模块,该模块由三个路径组成:时空激发(STE)路径,通道激发(CE)路径和运动激发(ME)路径。STE路径采用一个通道3D卷积来表征时空表示。CE路径通过在时间方面明确地建模通道之间的相互依赖性,来自适应地重新校准通道方式的特征响应。ME路径计算特征级别的时间差异,然后将其用于激发运动敏感通道。我们为2D CNN集成了ACTION模块,以形成一个简单而有效的ACTION-Net,这样可以减少额外的计算成本。通过使用三个数据集(即Something-Something V2,Jester和EgoGesture)在三个主干网(即ResNet-50,MobileNet V2和BNInception)上始终优于2D CNN,证明了ACTION-Net的有效性。

代码:

https://github.com/V-Sense/ACTION-Net

网址:

https://www.zhuanzhi.ai/paper/eafc9c05a986dd332aed968b0320dbad

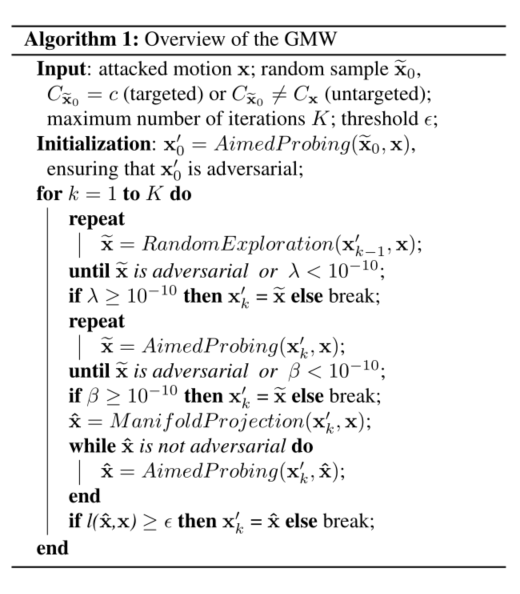

2. BASAR:Black-box Attack on Skeletal Action Recognition

作者:Yunfeng Diao, Tianjia Shao, Yong-Liang Yang, Kun Zhou, He Wang

摘要:骨骼运动作为独立的数据源或补充,在人类动作识别中起着至关重要的作用。最近,基于骨骼的动作识别器的鲁棒性受到了质疑,当攻击者可以全面了解识别器时,它们很容易受到对抗性攻击。但是,在大多数情况下,此白盒要求过于严格,并且攻击并未真正造成威胁。在本文中,我们证明了这种威胁在黑盒设置下也确实存在。为此,我们提出了第一种黑盒对抗攻击方法BASAR。通过BASAR,我们证明对抗攻击不仅是真正的威胁,而且可能是极具欺骗性的,因为流形上的对抗性样本在骨骼运动中相当普遍,这与通常认为对抗性样本仅在流形之外存在形成了鲜明的对比。通过详尽的评估和比较,表明BASAR可以成功跨越模型,数据和攻击模式进行攻击。通过严格的感知研究,我们表明它可以实现有效而又不易察觉的攻击。通过分析对不同动作识别器的攻击,BASAR可以帮助确定其脆弱性的潜在原因,并提供有关哪些分类器可能更强大地抵抗攻击的见解。

网址:

https://www.zhuanzhi.ai/paper/55eeedcd476ae95bba0edb9927c1954c

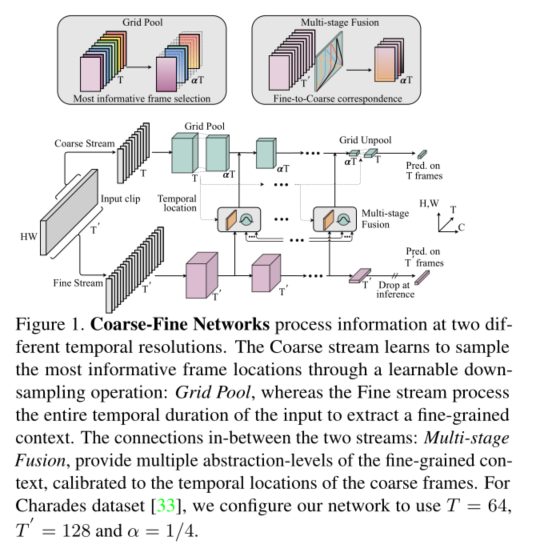

3. Coarse-Fine Networks for Temporal Activity Detection in Videos

作者:Kumara Kahatapitiya, Michael S. Ryoo

摘要:在本文中,我们介绍了Coarse-Fine网络,这是一种双流架构,该架构利用不同时间分辨率,来学习更好的长期运动视频表示。传统的视频模型以一种(或几种)固定的时间分辨率处理输入,而没有考虑任何动态帧选择。但是,我们认为,处理输入的多个时间分辨率并通过学习估计每个帧的重要性来动态地执行此操作可以极大地改善视频表示,特别是在时序动作定位领域。为此,我们提出(1)“Grid Pool”,一个时间下采样层,用于提取粗略特征;以及,(2)“多阶段融合”,一种时空注意力机制,用于融合细粒度的上下文与粗略的特征。我们证明了本文的方法可以在包括Charades在内的公共数据集中胜过最新的动作检测,并且显着减少了计算和内存占用。

网址:

https://www.zhuanzhi.ai/paper/3daae7f00567a3b397bc8968c402e379

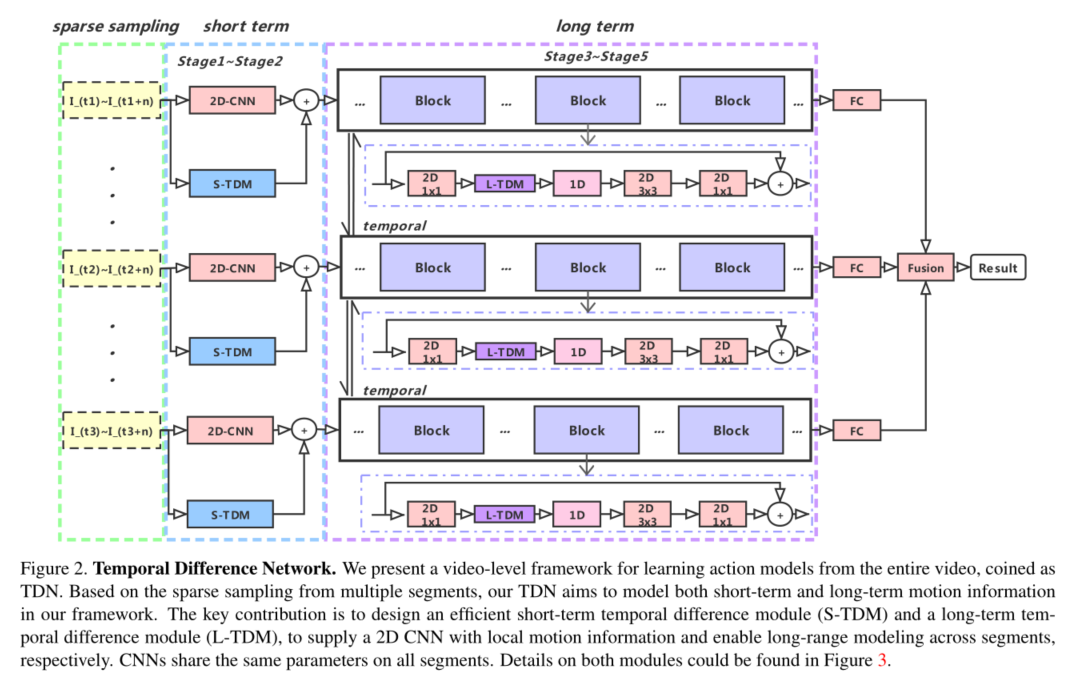

4. TDN: Temporal Difference Networks for Efficient Action Recognition

作者:Limin Wang, Zhan Tong, Bin Ji, Gangshan Wu

摘要:对于视频中的行动识别仍然具有挑战性。为缓解此问题,本文提出了一种新的视频架构,称为时间差分网络(Temporal Difference Network, TDN),重点是捕获多尺度时间信息以进行高效动作识别。我们TDN的核心是通过明确地利用时间差分操作设计有效的时间模块(TDM),并系统地评估其对短期和长期运动建模的影响。为了在整个视频中完全捕获时间信息,我们的TDN是采用两级差分建模范例建立的。具体而言,对于局部运动建模,连续帧上的时间差异用于为2D CNN提供更精细的运动模式,而对于全局运动建模,跨段的时间差异被并入以捕获用于运动特征激励的远程结构。TDN提供了简单而有原则的时间建模框架,可以用现有的CNN实例化,而所需的额外计算成本很小。我们的TDN在Something-Something V1和V2数据集上展示了最新的技术水平,可以与Kinetics-400数据集上的最佳性能相提并论。此外,我们进行了深入的消融研究并绘制了TDN的可视化结果,希望能对时差操作提供深入的分析。

代码:

https://github.com/MCG-NJU/TDN

网址:

https://www.zhuanzhi.ai/paper/e6c665dd90cc9e43e47ce9dd0aff87ff

5. Understanding the Robustness of Skeleton-based Action Recognition under Adversarial Attack

作者:He Wang, Feixiang He, Zhexi Peng, Yong-Liang Yang, Tianjia Shao, Kun Zhou, David Hogg

摘要:动作识别已在许多应用中被大量采用,例如自动驾驶,监控等,其中,鲁棒性是首要考虑的问题。在本文中,我们研究了最前沿的动作识别器对付对抗攻击的鲁棒性,到目前为止,这种鲁棒性很少被研究。为此,我们提出了一种新的攻击依赖3D骨骼运动的动作识别器的方法。我们的方法涉及创新的感知损失,可确保攻击的感知力。实证研究表明,我们的方法在白盒和黑盒方案中均有效。在各种动作识别器和数据集上都证明了其通用性。它的多功能性在不同的攻击策略中得到了体现。其欺骗性在广泛的感知研究中得到了证明。我们的方法表明,对3D骨骼运动(一种时间序列数据)的对抗攻击与传统的对抗攻击问题显着不同。它的成功引起了对动作识别器鲁棒性的严重关注,并为潜在的改进提供了见解。

网址:

https://www.zhuanzhi.ai/paper/e6c665dd90cc9e43e47ce9dd0aff87ff

请关注专知公众号(点击上方蓝色专知关注)

后台回复“CVPR2021AR” 就可以获取《5篇顶会CVPR 2021行为识别(Action Recognition)相关论文》的pdf下载链接~