数据分析师应该知道的16种回归方法:支持向量回归

支持向量回归(SVR)的工作原则类似与支持向量机(SVM),可以说SVR是SVM在因变量为数值变量或连续变量情况下的应用。SVM的主要思想是:给定训练样本,建立一个超平面作为决策曲面,使得正例和负例之间的间隔最大化。SVR的基本思想是:让所有样本点逼近超平面,使得样本点到超平面的总偏差达到最小。同简单线性回归(SLR)相比,SVR不要求变量间的高斯-马尔科夫假设,仅依赖于核函数。SVR的另一个优势是:它允许在不改变解释变量的情况下构建非线性模型,因而可以更好地解释生成的模型。下面开始介绍SVR及其在R中的实现。

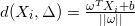

首先考虑简单二分类问题。设

其中

样本点

如果这个问题是线性可分的(即在当前空间存在一个超平面可以把正负例样本分开),就会存在无数解。为此我们考虑

下面开始寻找分割最大间隔(即使上图中的淡黄色区域达到最大),我们需要解决如下优化问题:

object:

subject to:

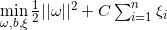

直接对上述目标函数优化一般不存在有效解。我们考虑形最小间隔为1的情形即

object:

subject to:

为了便于计算,将上述目标函数写为:

在实际问题中,训练集也可能会出现不可分的样本点(称为离群点),它们会影响分类超平面的形成。为处理不可分离的数据点,可引入松弛变量

object:

subject to:

对于上述线性可分和线性不可分的最优化问题,可以采用拉格朗日乘子法来求解。对于线性可分情况,添加拉格朗日乘子

考虑上式的对偶问题

object:

subject to:

其中

对于线性不可分情形,添加拉格朗日乘子

其对偶问题

object:

subject to:

其中

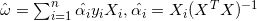

上述两个问题都转化为二次规划问题,因此存在全局最优解。这两个问题的最优解都为:

对比OLS,则SVR的预测值为:

对于非线性问题,超平面已经无法进行分类,可通过核函数

高斯核

- 多项式核

- 线性核

- Laplacian核

案例

本案例使用pressure数据集,该数据集描述摄氏温度和水银蒸汽压之间的关系如下图所示

SVR使用e1071包,KSVR使用kernlab,下图绘制了四种KSVR与原始SVR的拟合曲线,出线性KSVR外,其余KSVR通过调谐参数都可以很好对数据进行拟合,而且优于SVR。

cols=RColorBrewer::brewer.pal(8,'Dark2')

plot(pressure$temperature,pressure$pressure,pch=16,cex=2,col='gray70',

xlab='temperature',ylab='pressure')

library(e1071)

modelsvm = svm(pressure~temperature,pressure)

predsvm = predict(modelsvm, pressure)

lines(pressure$temperature, predsvm, col = cols[1], lty=1,lwd=2)

library(kernlab)

test1 <- ksvm(pressure~temperature,data=pressure,kernel="rbfdot",

kpar=list(sigma=0.5),C=50,cross=3)

predksvm1 = predict(test1, pressure)

lines(pressure$temperature, predksvm1, col = cols[2], lty=1,lwd=2)

test2 <- ksvm(pressure~temperature,data=pressure,kernel="polydot",

kpar=list(degree=3, scale=1, offset=1 ),C=5,cross=3)

predksvm2 = predict(test2, pressure)

lines(pressure$temperature, predksvm2, col = cols[3], lty=1,lwd=2)

test3 <- ksvm(pressure~temperature,data=pressure,kernel="laplacedot",

kpar=list(sigma = 2),C=5,cross=3)

predksvm3 = predict(test3, pressure)

lines(pressure$temperature, predksvm3, col = cols[4], lty=1,lwd=2)

linepot <- function(x,y) {sqrt(sum((x-y)^2))}

class(linepot) <- "kernel"

test4 <- ksvm(pressure~temperature,data=pressure,kernel=linepot

,C=5,cross=3)

predksvm4 = predict(test4, pressure)

lines(pressure$temperature, predksvm4, col = cols[5], lty=1,lwd=2)

legend('topleft',c('SVR','kSVR(gauss)','kSVR(poly)','kSVR(laplace)',

'kSVR(line)'),col= cols[1:5],lty=1,lwd=2,bty='n')

推荐阅读

reticulate: R interface to Python

使用jupyter notebook搭建数据科学最佳交互式环境

长按二维码关注“数萃大数据”