AAAI 2023 | CF-ViT:由粗到细的两阶段动态推理架构

©作者 | 陈锰钊

单位 | 厦门大学

研究方向 | 模型压缩与加速

此文章介绍刚被 AAAI 2023 会议接收的动态 ViT 论文 CF-ViT: A General Coarse-to-Fine Method for Vision Transformer。代码、训练日志、预训练模型皆已在 GitHub 上开源。

论文题目:

论文链接:

代码链接:

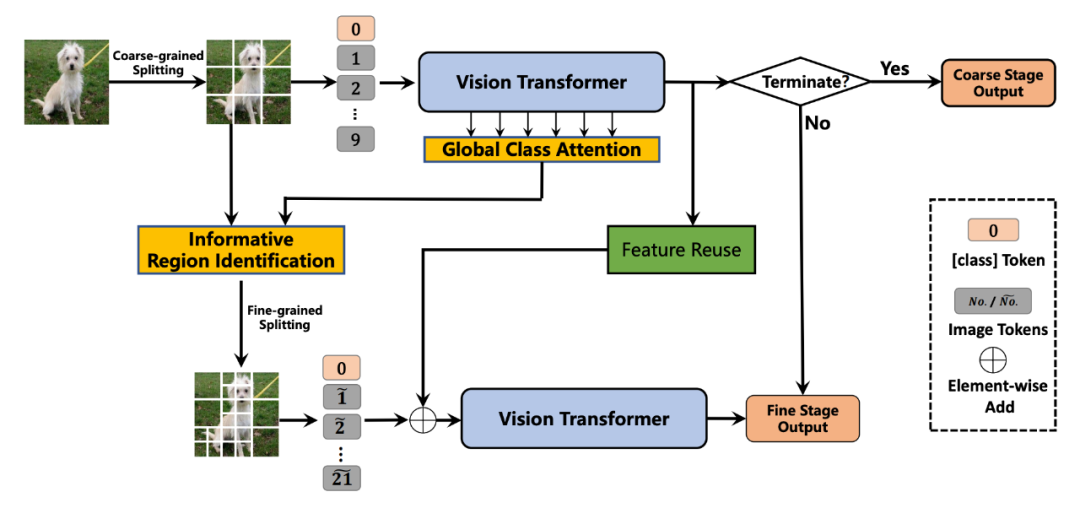

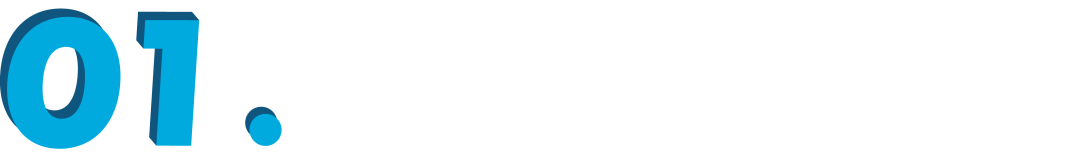

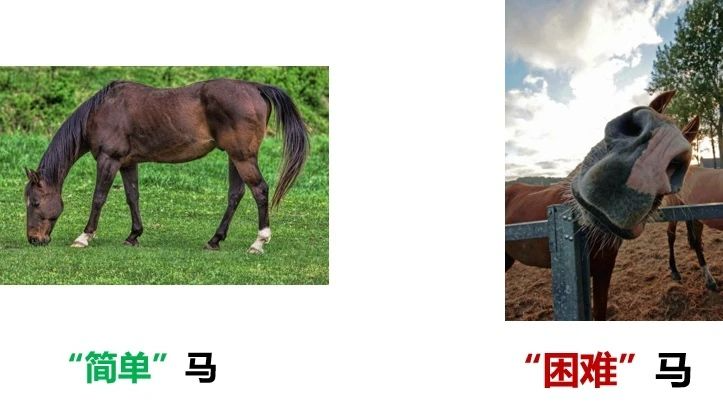

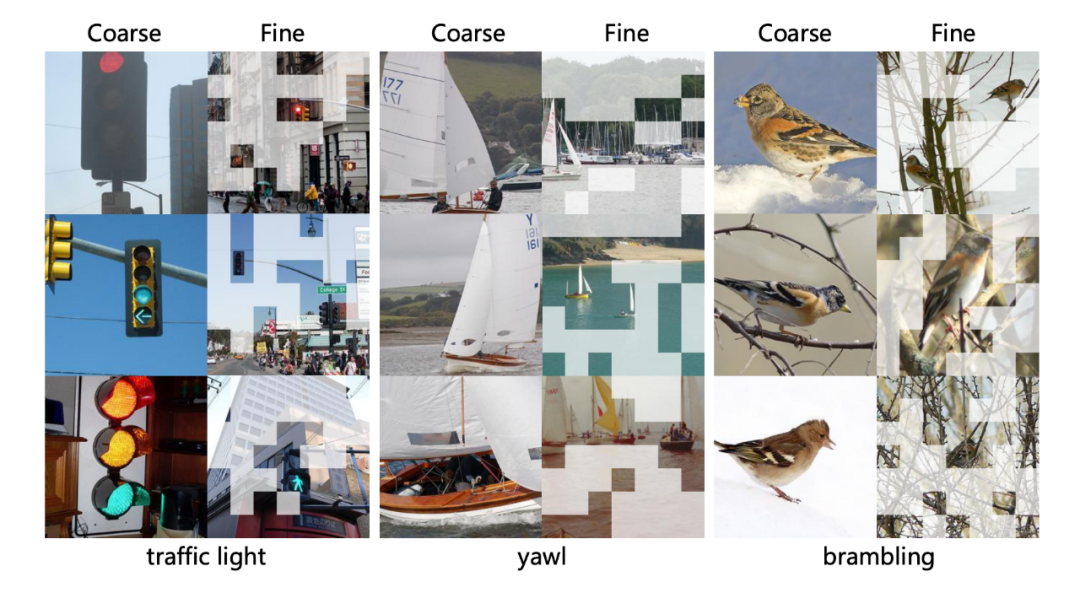

▲ 图1. CF-ViT两阶段推理示例

研究动机及简介

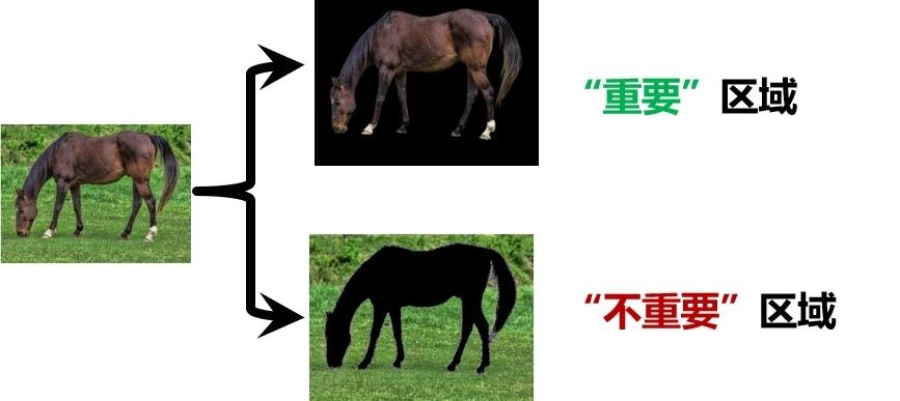

▲ 图2. 图像之间的空间冗余性

▲ 图3. 图像内部的空间冗余性

方法详述

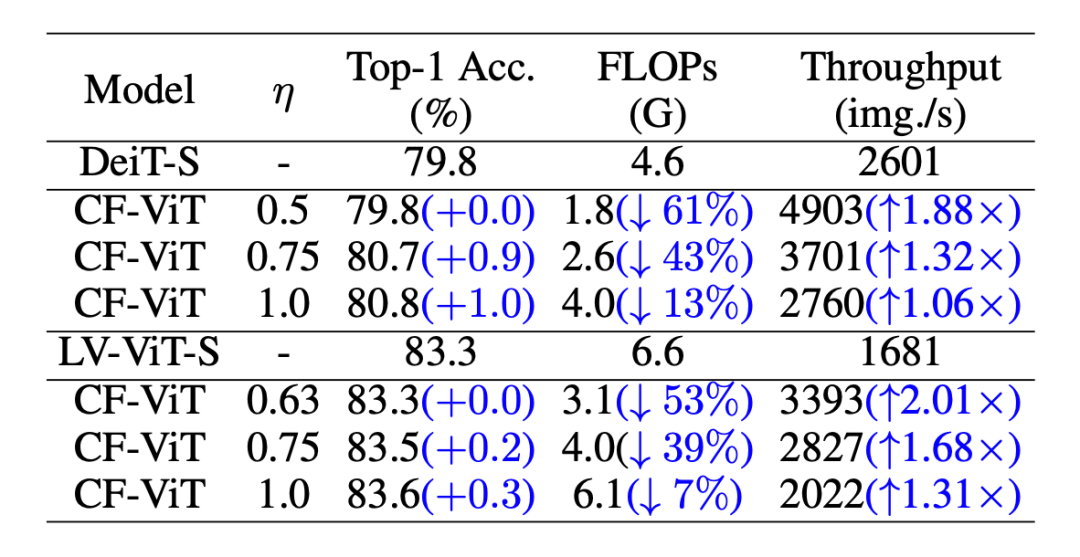

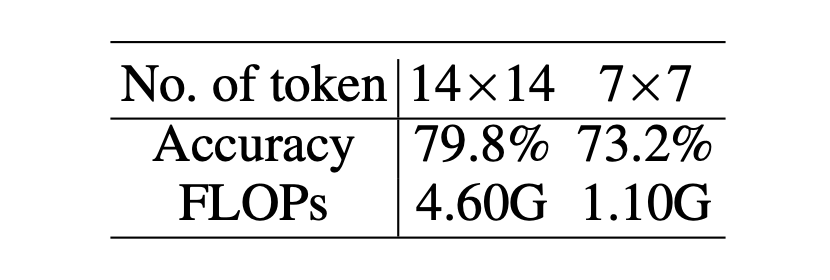

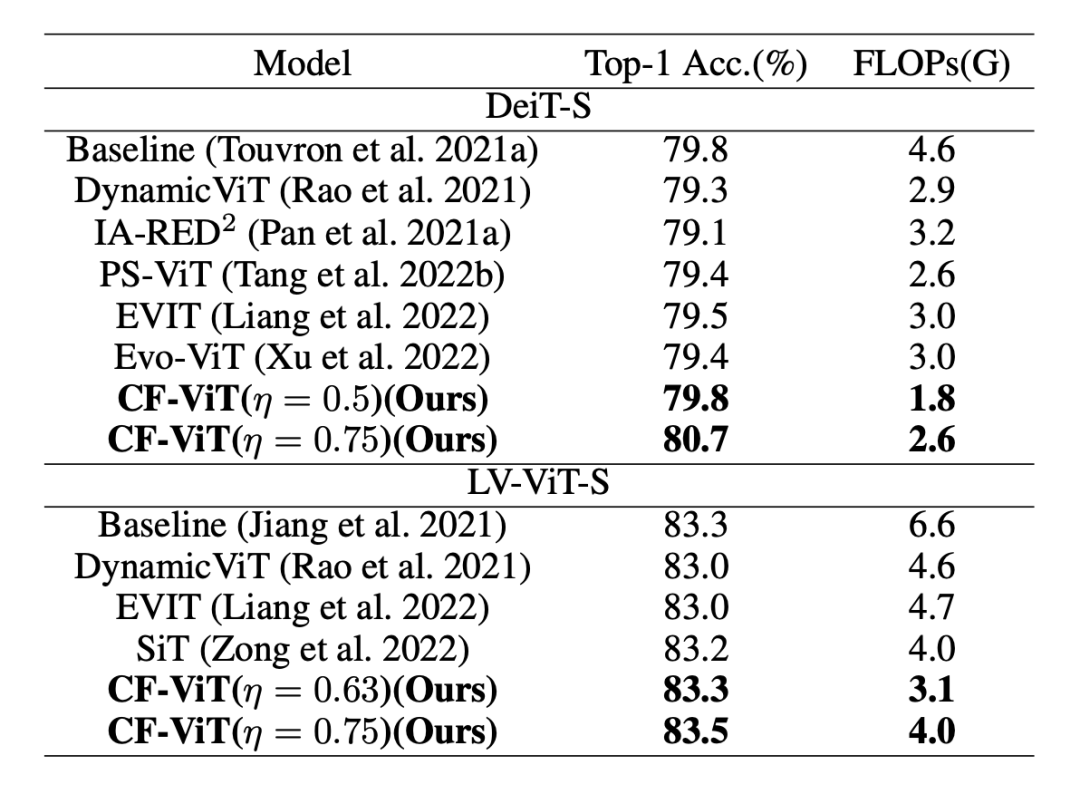

▲ 表3. 和现有的token剪枝方法对比

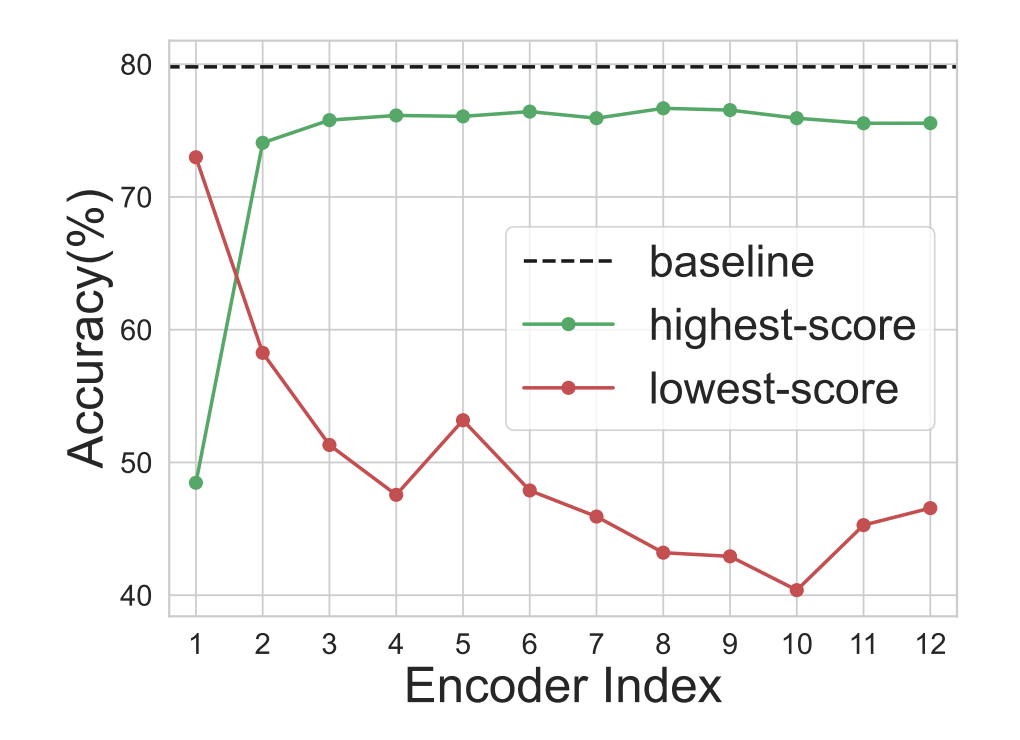

▲ 图6. 分别在两个推理阶段被正确分类的图像

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编