加入极市专业CV交流群,与10000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

作者:卢策吾

知乎链接:https://zhuanlan.zhihu.com/p/109139026

本文已由作者授权转载,未经允许,不得二次转载。

我们组近两年一直希望从知识驱动角度解决行为理解,希望构造一个action上类似bert 一样的强大工具。这次CVPR 2020,我们组的博士生李永露同学一次中了三篇论文,全是围绕

知识驱动的行为理解(Human Activity Understanding)方面的工作。

他也是HAKE的第一作者。

HAKE是一个全新的人类行为知识引擎,

主页:

hake-mvig.cn/home/

上面代码和数据都有。另外提一下,李永露同学属于踏实科研的典范。他其实已经完全掌握灌水顶会的技能,手头也很多东西,在同龄人疯狂发论文的大背景下,沉住气做solid的工作,不急着发论文,这次中三篇CVPR完全是顺其自然。

1. PaStaNet: Toward Human Activity Knowledge Engine

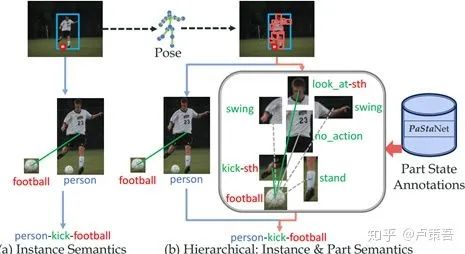

之前的方法大多基于实例级别的特征或知识(human,object)出发去学习action,但是对于human-object interaction这种复杂的行为,仅靠这种粗粒度的知识是不够的(目前大家的性能都卡在了一个台阶上),且训练出来的模型常因不同数据集的action种类设定不同而很难泛化(domain gap)。

这次我们提出了一个全新的思路,除了实例知识这条路径,开辟了一条人体部位语义知识的学习路径。如上图,一个“踢球”的动作可以被分解(parsing)为一系列part级别的知识。最大的好处,是我们发现part级别的动作状态(part states)种类,要远远少于整体动作的种类,举个栗子,就好像26个字母和成千上万单词的关系。

有了学习part states的能力,我们就能模型“组合”推理出整体的动作,且这种知识是*可学习*可迁移*的。

我们为此花费一年半时间准备了超过10万张动作图像的part知识库HAKE,并提出了Activity2Vec模型。同ImageNet训练backbone一样,利用PaStaNet训练的Activity2Vec,可以很好地把大量part知识迁移到新任务上,例如,在大型的行为数据上,我们取得了非常好的效果提升:HICO(+6.4mAP),HICO-DET(+5.0mAP);甚至跨模态在视频数据集AVA也有3.6mAP的提升。

同时,我们还证明了,在模型能够完美估计part states时,我们的方法可以直接爆炸式提升性能,HICO(65mAP, 目前传统方法40mAP左右),HICO-DET(34mAP,传统方法20mAP左右),AVA(49mAP,sota的video模型如slowfast在28mAP左右)。我们相信,HAKE可能成为行为理解领域非常重要的知识库和引擎,驱动后续的研究把行为理解的性能再提升一个台阶。

目前我们正积极把HAKE扩展到视频行为理解领域,争取在大型视频数据集如AVA上构建更加强劲的知识引擎,并引入更强的推理方法。

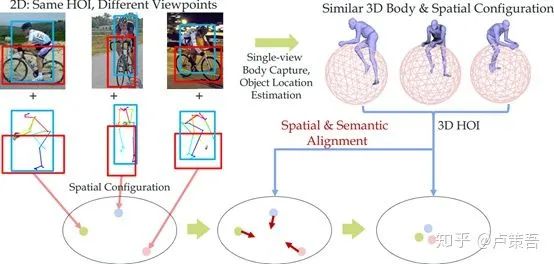

2. Detailed 2D-3D Joint Representation for Human-Object Interaction

基于2D视觉的行为理解一直受到视角、遮挡问题的干扰,例如“吃饭”这个动作,在不同角度拍摄的图像在2D上差异巨大,这就给学习带来了很多困难,因此我们提出了基于single-view 3D recover的多模态学习方案,进一步拓展HOI方向的范式。

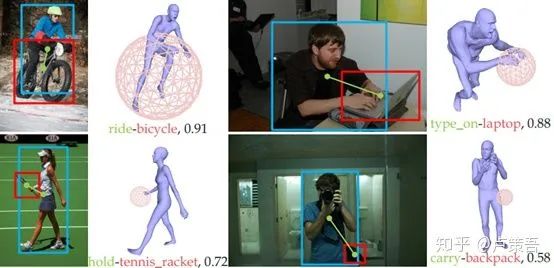

通过单目恢复细粒度的人体结构和物体空间位置信息,可以在3D space“重建”整个human-object interaction我们可以很好地校正多视角带来的歧义,有效提升HOI的学习。下面是一些有趣的结果。

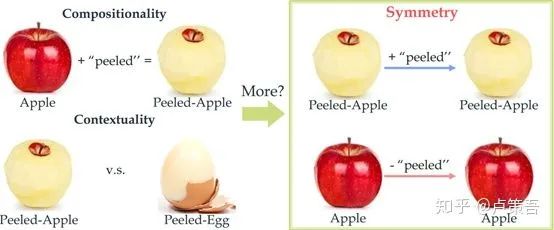

3. Symmetry and Group in Attribute-Object Compositions

最后介绍另一个和HOI(human-object interaction)类似的组合式学习问题:attribute-object compositional learning, 如让模型去学习red-apple这个概念,不仅要识别出apple,还需要知道它的属性,这是比物体识别更难的高阶语义学习问题。我们这次提出了一种全新的视角,在群论的启发下,提出了一种基于对称性的学习方法:

如上图,除了已知的组合性(compositionality)和上下文相关性(contextuality)外, 我们发现了一种新的属性:对称性(symmetry)。基于这种新的属性,我们引入了群论中对于构成群需要的四大公理作为学习目标函数和约束,并在对称性的启发性提出了一种全新的属性分类方法RMD(relative moving distance),有效改进了attribute-object的学习性能,尤其在attribute分类效果上有了非常好的结果。

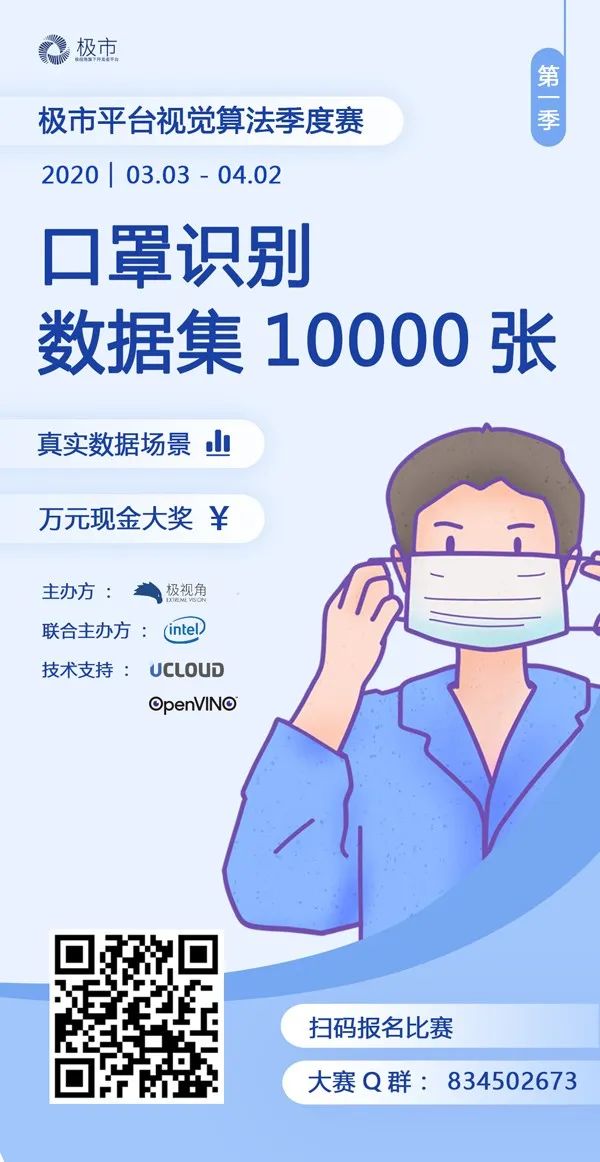

极市平台视觉算法季度赛,提供真实应用场景数据和免费算力,特殊时期,一起在家打比赛吧!

![]()

添加极市小助手微信

(ID : cv-mart)

,备注:

研究方向-姓名-学校/公司-城市

(如:目标检测-小极-北大-深圳),即可申请加入

目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群

,更有

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、

干货资讯汇总、行业技术交流

,

一起来让思想之光照的更远吧~

![]()

△长按添加极市小助手

![]()

△长按关注极市平台,获取最新CV干货

觉得有用麻烦给个在看啦~ ![]()