【微软Alekh等开放新书】强化学习理论与算法,83页pdf,了解最新进展

【导读】强化学习是近几年研究的热点,特别是伴随DeepMind AlphaGo的出现名声大噪。微软首席研究经理Alekh Agarwal、UIUC助理教授姜楠、华盛顿研究基金会数据科学主席Sham M. Kakade合编的新书《强化学习:理论与算法》,83页pdf,讲述了强化学习最新进展,包括MDP、样本复杂度、策略探索、PG、值函数等关键议题,是了解强化学习的材料。

新书地址:

https://rltheorybook.github.io/

作者介绍:

Alekh Agarwal目前是微软人工智能研究中心的研究员,领导强化学习研究小组。之前,在加州大学伯克利分校获得计算机科学博士学位后,与彼得·巴特利特(Peter Bartlett)和马丁·温赖特(Martin Wainwright)一起在纽约微软研究院(Microsoft Research)度过了六年美好的时光。

http://alekhagarwal.net/

姜楠,UIUC助理教授

https://nanjiang.cs.illinois.edu/

华盛顿研究基金会数据科学主席Sham M. Kakade

强化学习(RL)是一种机器学习范式,在这种范式中,agent从经验中学习完成顺序决策任务。RL在机器人、控制、对话系统、医疗等领域有广泛的应用。

第一章 马尔科夫决策过程MDP 预介绍

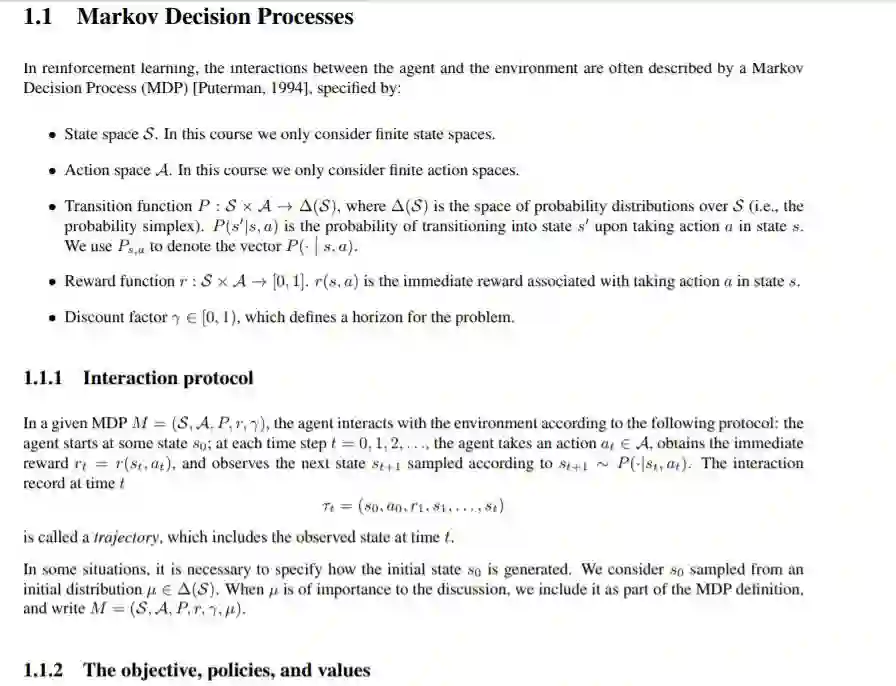

在强化学习中,agent与环境之间的相互作用通常用马尔可夫描述,决策过程(MDP) [Puterman, 1994],

1.1 马尔科夫决策过程

1.1.1 交互协议

1.1.2 目标、策略和价值观

1.1.3 平稳策略的Bellman一致性方程

1.1.4 Bellman最优性方程

1.2 MDP规划

1.2.1 Q值迭代

1.2.2 策略迭代

第二章 生成模型的样本复杂度

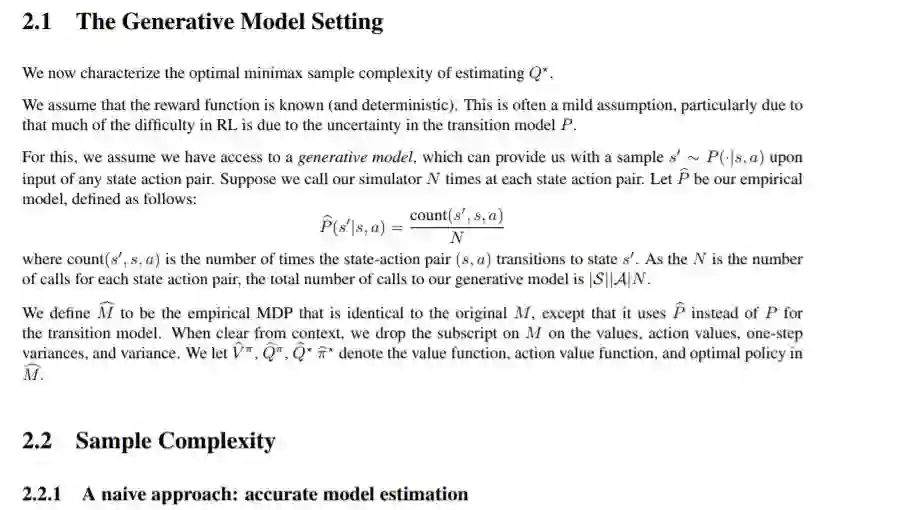

2.1 生成模型设置

2.2 样本的复杂性

2.2.1一种朴素方法:精确的模型估计

2.2.2 更细化的方法:使用稀疏模型

2.2.3下界

2.2.4 关于πb策略的价值

2.3 分析

2.3.1 完成证明

2.4 文献评论

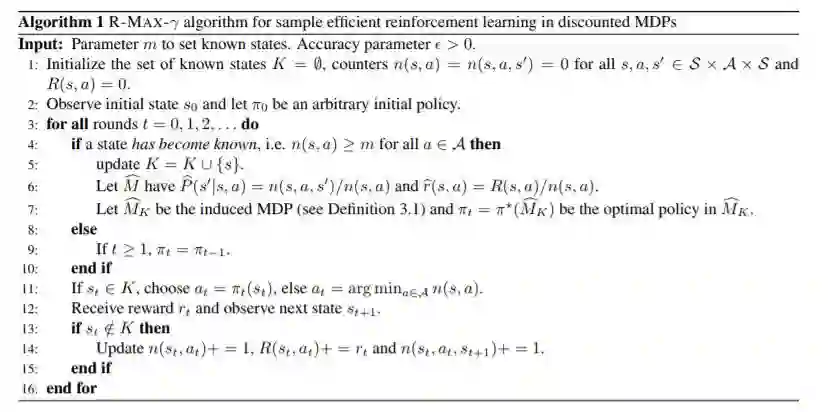

第三章 强化学习的策略探索

在这一讲中,我们将看到一个代理如何在MDP中工作,随着时间的推移,它可以学习接近最优的行为策略。与前一讲关于生成模型的设置相比,我们不再能够方便地访问每个状态的转换,而只能在MDP中执行轨迹。这给学习过程增加的主要复杂性是,代理必须参与探索,也就是说,计划到达尚未看到足够多的样本的新状态,以便能够学习这些状态中的最佳行为。

第四章 策略梯度方法

4.1策略梯度法

4.4.1优化

4.2 软最大策略和相对熵正则化

4.3 自然策略梯度

4.3.1 全局收敛和Softmax策略类

4.3.2 函数逼近与迁移学习的联系

4.4 相关算法

4.4.1 信任区域策略优化(TRPO)

4.4.2 近策略优化(PPO)

4.4.3 保守政策迭代(CPI)

4.5 文献评论

第五章 值函数近似

5.1 近似策略策评价

5.2 大致的策略改进

5.2.1 基于“∞逼近”的贪婪策略改进

5.2.2 保守策略迭代

第六章 RL的战略探索和丰富的观测资料

6.1 问题设置

6.2 值函数逼近

6.3 传达员排名

6.4 Bellman秩较小的CDPs的样本效率学习

第七章 行为克隆和学徒学习

7.1 线性规划公式

7.1.1 原始LP

7.1.2 双LP

7.2 行为克隆

7.2.1 通过监督学习进行行为克隆

7.2.2 分布匹配的行为克隆

7.2.3 样本效率:比较方法

7.3 观察学习

7.3.1 通过分布匹配从观测中学习

7.4 反向强化学习

完整详细请官网下载或者便捷下载:请关注专知公众号(点击上方蓝色专知关注)

后台回复“RLTA” 咨询获取强化学习《Reinforcement Learning: Theory and Algorithms》电子书pdf下载链接

更多关于“强化学习”的论文知识资料,请登录专知网站www.zhuanzhi.ai查看,或者点击“阅读原文”查看:

https://www.zhuanzhi.ai/topic/2001320766352755/awesome