在第二届北京智源大会上,2007年图灵奖得主Joseph Sifakis为我们带来了题为“Can We Trust Autonomous Systems? Boundaries and Risks”的主题演讲。

![]()

Joseph Sifakis,欧洲科学院和法国科学院院士,美国文理科学院和美国国家工程院院士,中国科学院外籍院士。Joseph是著名嵌入式系统专家,1981年独立提出模型检测方法,这一方法被广泛应用于芯片检测、通讯协议、嵌入式系统以及安全算法等领域。1993年开创Verimag实验室。2007年,Sifakis因在模型检查理论和应用上的卓越贡献而被授予图灵奖,2012年,获得利奥纳多·达芬奇勋章。Sifakis现作为欧洲卓越网络嵌入式系统设计联盟技术协调人,负责对35个欧洲研究小组的研究进行协调,来推进欧洲在嵌入式系统设计理论和应用上的发展。

Sifakis在演讲中认为,在物联网的自动化控制中存在两大问题:对于工业物联网,规则可以被直接更改;对于人机物联网,人类或明确或武断的行为,也可能戏剧性地导致触发控制序列和规则的更改。因此,Sifakis在本次演讲中从传统的安全检测手段出发,为我们逐步引入下一代安全系统的概念。他在分享中提到,下一代的安全系统更强调自主性,即系统的自我调控能力。在自动驾驶、大脑手术、工业报警等这些熟悉的物联网行业,我们不难看出,在产品的整个寿命中,系统所处的环境都是瞬息万变的,因此,系统强大的自我调控能力必不可少。那么我们能否相信“自主”系统,系统的边界与风险又在哪里呢?我们不妨从Sifakis的精彩讲座中寻找答案。

整理:智源社区 钱小鹅

1. 下一代自主系统的特征和概念

Sifakis首先指出,下一代自主系统的产生是为了满足用自治代理逐步取代人工操作来进一步自动化现有机构的需求。因此,自主系统需要足够严谨并在处理知识时表现出“Broad Intelligence”,具体来说需要满足如下几个要求:

-

能处理一系列动态改变且可能有潜在冲突的目标,

这反应了自主系统从狭隘人工智能/弱人工智能到强人工智能/广义人工智能的转变趋势;

-

-

但面对这些关键性的要求,目前的自主系统还有诸多的缺陷。比如:系统中的自我学习部分没有可信赖的保障技术进行支持;处理地理分布和移动性所需的网络基础架构可信赖性差,如网络安全问题、反馈时间无法得到保证等;处于高动态中的行为带来了巨大的复杂性,如网络物理媒介和不可预测性。

Sifakis认为自动驾驶就是自主系统中的一个标志性案例,它提出了严峻的技术挑战,并涉及巨大的经济利益和深远的社会影响。从中我们也可以一窥下一代自主系统的新趋势。与航空航天和铁路行业相比,自动驾驶技术有如下特征:

1. 自动驾驶的研发人员并不遵循“通过设计来保障安全”的理念,他们通过端到端的黑箱机器学习来进行技术设计。

2. 自动驾驶技术的研发人员认为统计学的可信度依据已经足够保障安全,这表示如果一辆车开了上百万公里没有出事故,那么他们就认为这辆车足够可靠。

4. 与飞机这种软件和硬件在出厂后均无法修改的产品不同,自动驾驶汽车的关键软件可以通过更新进行定制,如特斯拉汽车以月为单元进行软件升级。

接下来,Sifakis评价了Elon Musk 2015年在英伟达技术大会上的一个观点,Musk宣称自己几乎把自动驾驶汽车当作一个已经实现的问题,他只是需要若干年来按部就班地实现而已。然而,是否真如Musk所言,自动驾驶技术可以当作一个已经实现的问题呢?Sifakis 给出的答案是否定的。他认为,自动驾驶缺乏足够严谨的设计方式,人们对它的普遍态度可以概括为接受其风险、贪婪其利益的直率现实主义;认为传统的严谨设计方式本质上具有局限性,复杂问题只能通过经验方法来解决,对经验方法带有盲目的信念;以及坚信自己已经掌握了正确手段,技术实现只是时间问题的无限乐观。

Sifakis指出,我们的安全系统设计面临着巨大的挑战,我们正在从小型的、中心化的、自动的、在可预测环境下可规范的系统迈向复杂的、去中心化的、自主的、在非可预测环境下的不可规范的安全系统。我们需要建立一个新的科学和工程基础,而不是简单组合过去二十多年的现有成果并仅仅关注诸如自主计算、自适应系统、自主代理这类软件系统。我们需要解决以下这些问题:

1. 了解自动化和自治化之间的可能性范围。提升系统自主性的技术方案是什么?对于每一个提升,我们需要了解其中有哪些潜在的困难和风险。能有原则的确定一个能执行给定任务的系统是否足够可靠。

2. 将系统可信度与已开发系统的知识确实性关联起来。

3. 从传统的系统设计过渡到“混合”设计,以寻求在基于模型的可信赖性与基于数据的表现性之间的权衡.

接下来,Sifakis向我们解释了自主性(Autonomy)的概念。

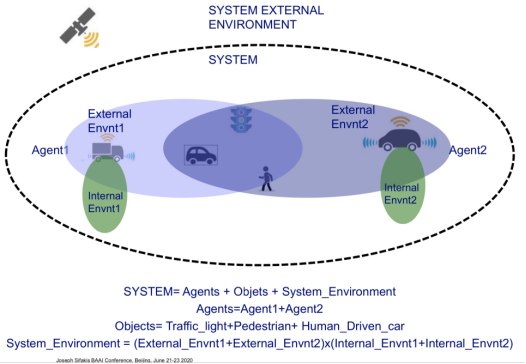

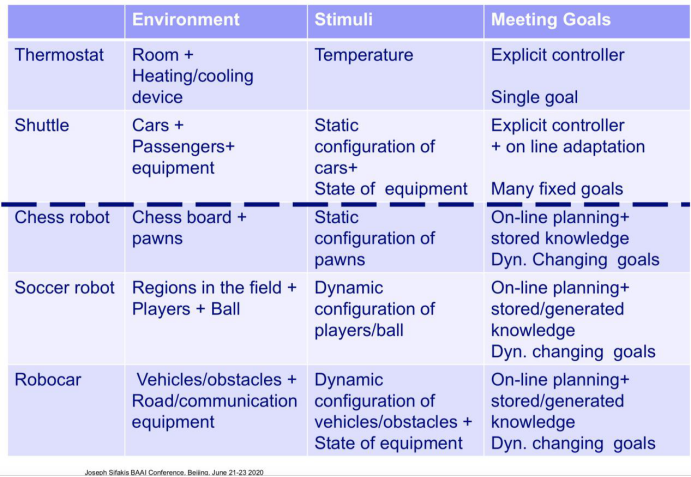

Sifakis认为对于自主系统,如恒温器、足球机器人、自动驾驶汽车等,它们都是在某种特定环境下,由若干携带传感器的终端组成,通过每个终端对各自的目标实现,其集体行为就会迈向系统整体目的的实现。如图1所示以自动驾驶为例,一个自主系统由终端、客体和系统环境组成。系统环境包括内部环境和外部环境。随着环境、感知客体的复杂化和动态化,目标的多变化,系统也逐渐由自动向自主迈进。

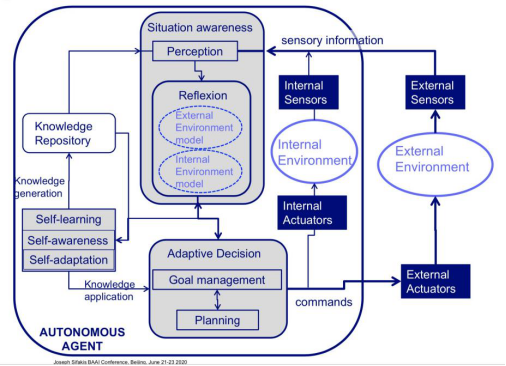

因此自主性是一个终端通过自己的方式(无需人工干预),在多变的环境下实现一系列目标的能力。如图3所示,它主要由五个互补的功能组成:

1. 感知,

对外部激励的翻译表达、从复杂的输入数据中去除模糊部分并提取相关信息;

2. 反馈,

能够建立/更新一个可靠的运行时环境模型以计算出可以实现目标的策略;

3. 目标管理,

从可能的目标中选择最接近当前给定环境模型的目标;

5. 自学习,

通过学习和推理创造新的情景知识和新目标的能力。

需要注意的是,上面提到的这些功能是实现无关的,我们未来可能通过机器学习、深度学习或者其他方式来实现。这五个功能也可以用来区分自动化和自主化。

2.系统的可信赖度问题(Trustworthiness)

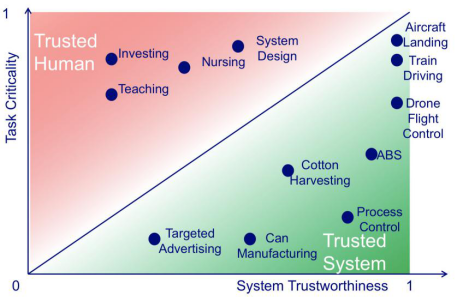

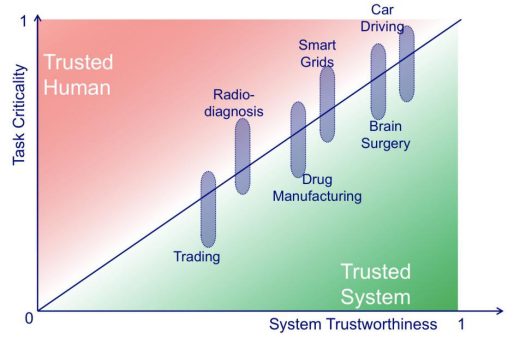

我们如何决定一个系统执行的任务是可以被信赖的呢?Sifakis认为有两点需要考虑,可信赖性(Trustworthiness)和严格性(Criticality)。系统的可信赖性是指不管外界发生何种意外,系统仍按照预定运行;系统的严格性则是错误的严重程度会在任务的实现中表现出严重的后果,比如驾驶一辆车、做手术、核电站作业。

从图4上可知,人类行为往往符合任务的严格性,而自动化的机器则满足系统的可信赖性,而两者的边界就是自动化的前沿领域。所谓自动化系统往往表现为静态的决策过程或者/以及失败的影响很小。而非自动化系统则需要好的情景认知以及多目标管理能力。而人和机器的共生自主系统则可以很好的在可信赖性和严格性之间取得平衡(如图4下所示)。我们可以制定一系列恰当的自主化标准来确保人和机器能和睦的一起工作,这些协议会帮助操作人员能够推翻机器的决定,机器也会主动征求人的介入。未来的很多应用会需要这种共生自主系统,比如汽车驾驶、大脑手术、药物制造等,这是自主系统实现的一个重要方式。

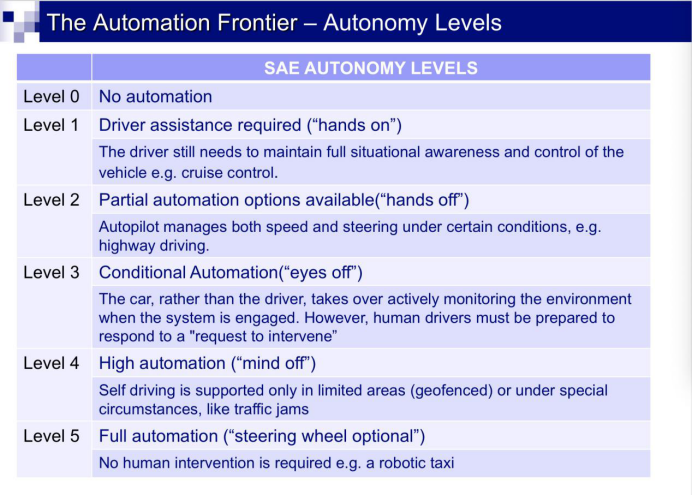

图5为SAE(美国汽车工程师协会)制定的自动驾驶自主级别标准。从level0到level5反映了人类与机器分工的不同方式。从最低级的非自动驾驶到最高级的没有人类介入的全自动驾驶依次定为六个级别。这表明了共生自主系统所面临的一个共同问题,我们如何划分人与机器之间明确的工作界限来最大确保他们的合作效率。

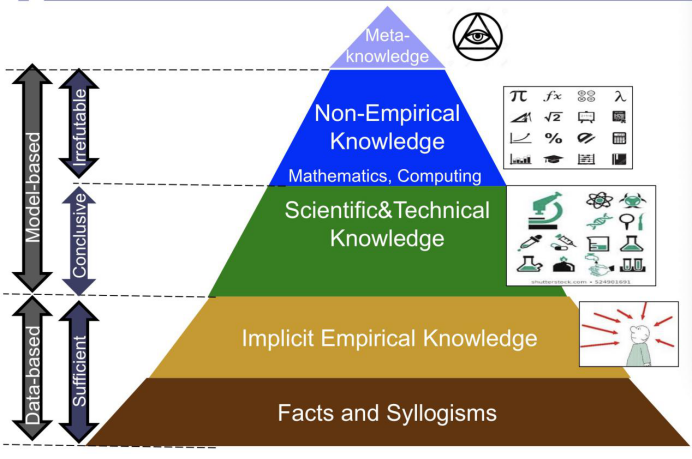

之后Sifakis提出了知识真实性(Knowledge Truthfulness)问题。他首先做了一个有趣的类比。人类的思考方式可以分为快思考(Fast Thinking)和慢思考(Slow Thinking)两种。快思考是无意识、自动化且毫不费力的,不需要自觉和控制,人们用它来处理所有

经验内隐知识(Empirical Implicit Knowledge)比如走路、说话、弹钢琴等。而与之对应的慢思考则是有意识、被控制且需要努力的,它有自我意识的参与和控制,它是所有推理知识如数学、科学、技术的源头。

我们可以分别把计算机技术的神经网络和传统计算与上面的快思考和慢思考作一个类比:神经网络对应快思考,它通过数据训练产生经验性的知识,是基于数据的知识,用神经网络去识别猫和狗正如人类的孩童认知一样,我们无法验证这种识别能力从何而来。传统计算机对应慢思考,它有明确的执行算法,是基于模型的知识,它能处理明确形式化的知识,是可以被验证的。

由这一类比进行引申,我们可以将知识分级建立知识金字塔,并将计算机技术放入其中。如图6所示,金字塔的最底层是事实及其推论,我们从中提取隐含的经验性知识建立第二层金字塔,第三层则是更加概括的科学和技术知识,第四层则是从中提取的高度抽象的非经验性知识,最顶层则被称为元知识。数学和计算被认为处于第四层,而机器学习和数据分析则处于第二层。也就是说科学与机器学习分别处在不同的知识层级,科学能够通过对实验的分析学习来进行合理的解释;而神经网络这类机器学习技术则无法解释他们的结论是如何得来的。

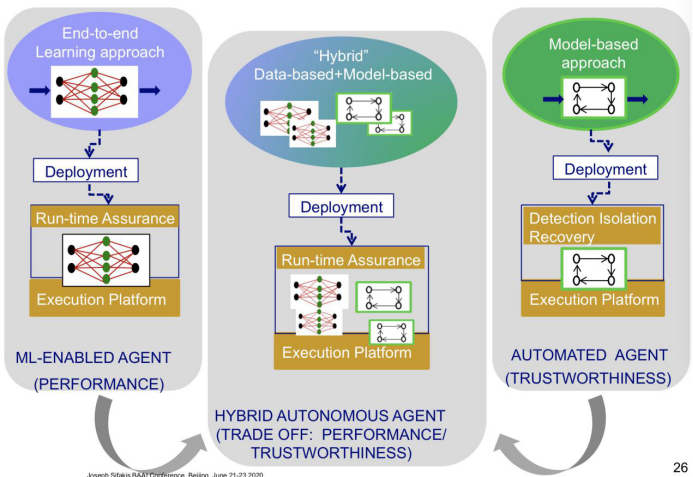

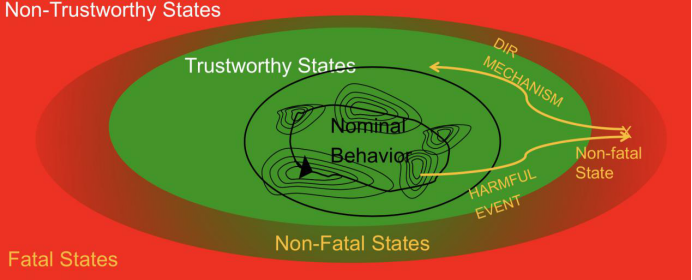

那么,如何涉及一个可信赖高性能的自主系统?Sifakis首先介绍说传统基于模型的系统设计方法足够信赖但性能较差,新兴的机器学习方案性能优秀但不可信赖,于是人们希望将两者综合利用,使得系统在可信赖性和高性能之间取得一个平衡。这就是混合设计流程(Hybrid Design Flows)。但对于这种混合设计自主系统,基于模型的设计方法面临着可信赖性的挑战。传统上,基于模型的设计方法在设计期间就试图保障系统的可信赖性,如图7所示,在系统设计时,他们会通过穷举有害事件来进行风险分析,找到有害事件后,先通过容错机制使这些有害事件是非致命的,最后通过DIR(Detection, Ioslation, Recovery)机制将系统从非致命状态还原至可信赖状态。但这种设计方法无法被直接应用于自主系统中。这主要是因为极度复杂和无法预测的环境以及系统的机器学习部分本身就是黑箱。这一问题在一份2017年关于撞车事故模型的分析报告中可见一斑,交通事故需要更加详细和复杂的分析才能保证系统被还原到可信赖状态,这包括对事故当时环境的分析。针对这一问题的关键方案是尝试用运行监测(Run-Time Monitoring)机制来取代DIR机制。

图7:混合设计流程(Hybrid Design Flow)

图8:传统的基于模型的设计方法是如何保证可信赖性的

自动驾驶的混合设计目前有一些设计理论,如通过机器学习进行情景认知,再基于模型进行适应性决策。感知功能可以识别定义明确和完整的环境结构来作为驾驶模式选择上的参考,而每一种驾驶模式都需要详细的策略。

Level 3: 环境模型和分析,包括安全区域计算、轨迹计算、驾驶模式选择等;

之后Sifakis提到了系统设计关键的一环,系统如何被验证。仿真是系统验证中至关重要的一环,仿真模型的搭建覆盖了从技术到理论的方方面面。一个好的仿真系统应该有如下三个特性:

1. 真实性(Realism),

也就是让终端的行为和环境的表现尽可能贴合现实世界。

2. 语义意识(Semantic awareness),

仿真系统动力学应扎根于过渡系统语义(transition system semantic)中,它包括Notion of state来确保对实验的掌控性和可重复性;Scenarios来模拟/检测极端状态和高风险情形;Notion of coverage来衡量相关系统配置已经被实现到什么程度。

3. 多尺度多粒度的建模和仿真(Multiscale multigrain modeling and simulation),

包括在理论上,要加强对网络物理系统的建模、不同尺度之间的关联研究;实践中,对基础联合仿真引擎的开发如HLA、FMI等。

目前大多数工业仿真系统缺乏语义意识,他们大多依靠游戏引擎或者预建的软件。这是无法完全满足自主系统可靠性验证需求的。

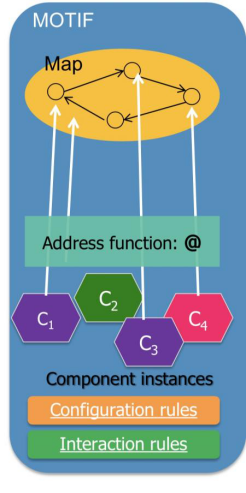

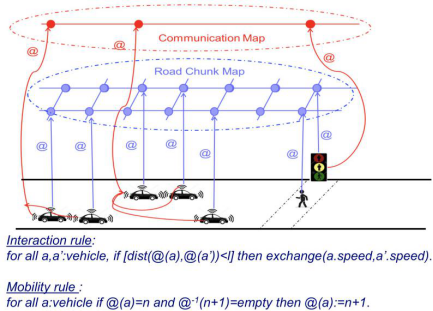

图9:DR-BIP的一些基本概念以及它们在自动驾驶中的实例

接下来Sifakis向我们介绍了他们实验室开发的一种针对自主系统的仿真语言,DR-BIP(Dynamic Reconfigurable BIP)。如图9左图所示,DR-BIP将系统看作由一系列主题(Motif)构成,每个主题都是一个协作模型,它包括:一系列元件(终端、客体);一个含有节点和边的地图,它用来表示元件之间的关系,这一关系可以是空间上的、也可以是组织上的。一个定位函数来将元件映射到地图上的各个节点。我们定义了交互规则来规定元件之间的交互(Atomic Multiparty Synchronization);同时我们还定义了配置规则使得我们可以添加/删除/移动元件并动态的变换地图。

我们以机器人车的仿真为例,如图9右图所示,这一复杂系统用到了两个主题,它们分别包含了路线地图和通讯地图。机器人车是终端,行人、路灯是客体,它们都属于主题中的元件。我们可以定义这样一个交互规则,当两辆车的距离小于一定阈值,则它们的速度交换;我们也可以定义一个配置规则,如当一辆车前面的一个节点为空的时候,我们可以将该车重新映射到前面的节点来表示机器人车的移动。

Sifakis认为目前的验证方式还远远达不到自主系统的要求,首先机器学习是无法被验证的,它的开发并不是基于一个形式化的目的,目前它对我们依然是个黑箱。而之前自动系统应用的形式化验证(Formal Verification)也有着诸多缺陷,它只在需求和目标可以被形式化的时候有效,难以应对高度动态且可以不断重构的自主系统。

讲座最后,Sifakis对于机器自主性的未来进行了一些展望:

1. 很多自动驾驶厂商会因为技术问题以及公众信任的崩塌而改变他们的野心——现实远远不像他们现在说的那样乐观。

2. 我们会摒弃基于数据还是基于模型的争论,将两者进行混合设计。

3. 自主性的级别会逐步平稳地向全自动或者共生自主迈进。

4. 自主系统的可信赖性依然是一个亟待解决的问题,我们没有决定性的证据表明这些系统是足够严格可靠的。虽然这些系统并不足够可靠,但好消息是它们也的确在向着更高层次的智能发展。我们将给予这些系统多大的决策自主权,我们何时能够相信它们,这些都是值得进一步思考的问题。

![]()

喜欢本篇内容,请

分享、点赞、

在看

![]()