深度学习为何泛化能力好? 探究《 深度学习中的隐式正则化》从矩阵和张量分解中得到的教训,141页ppt

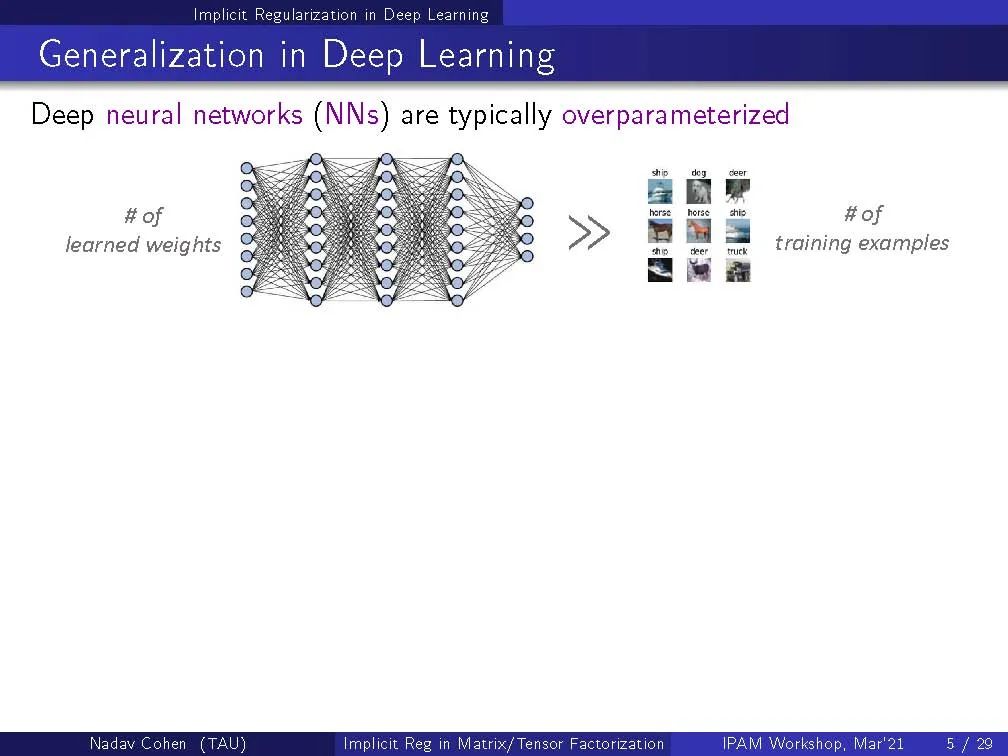

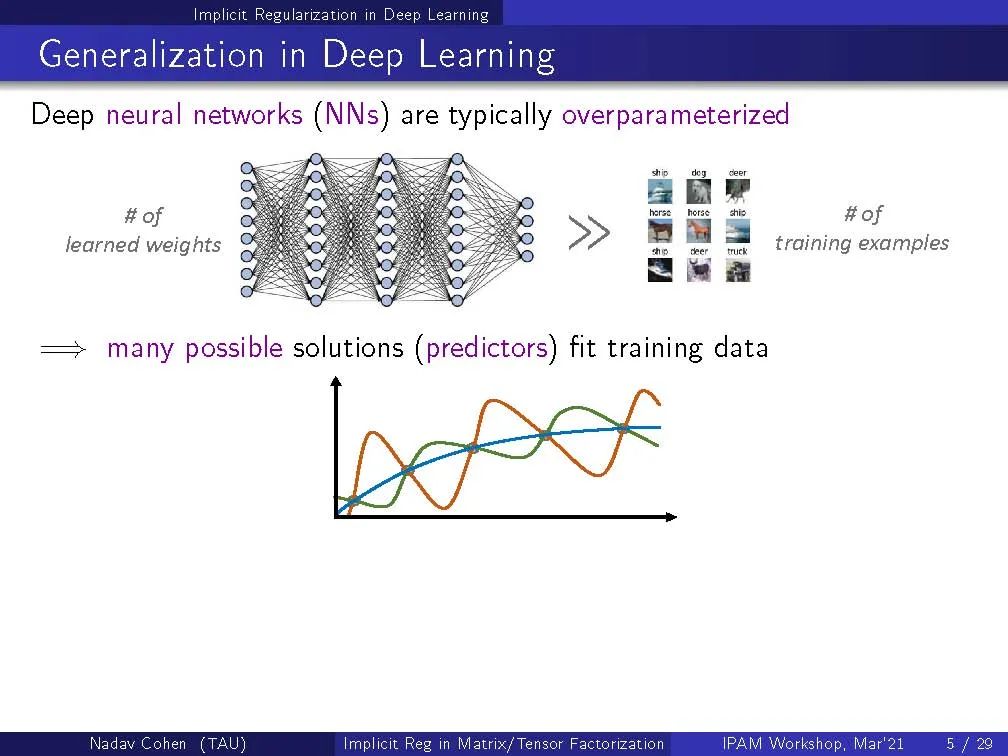

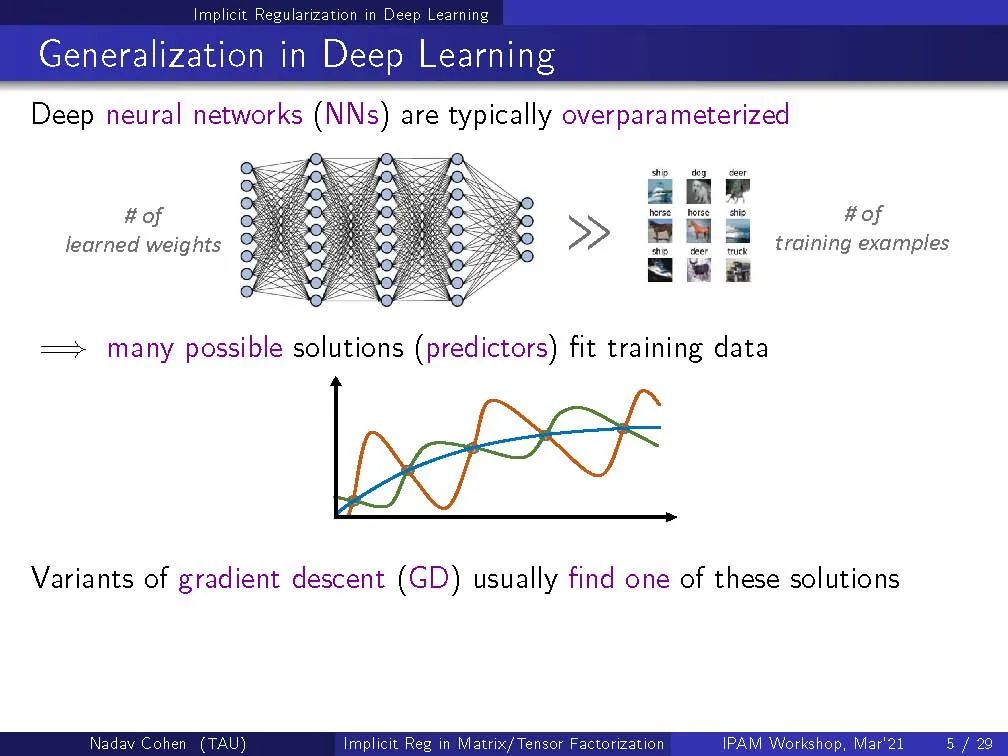

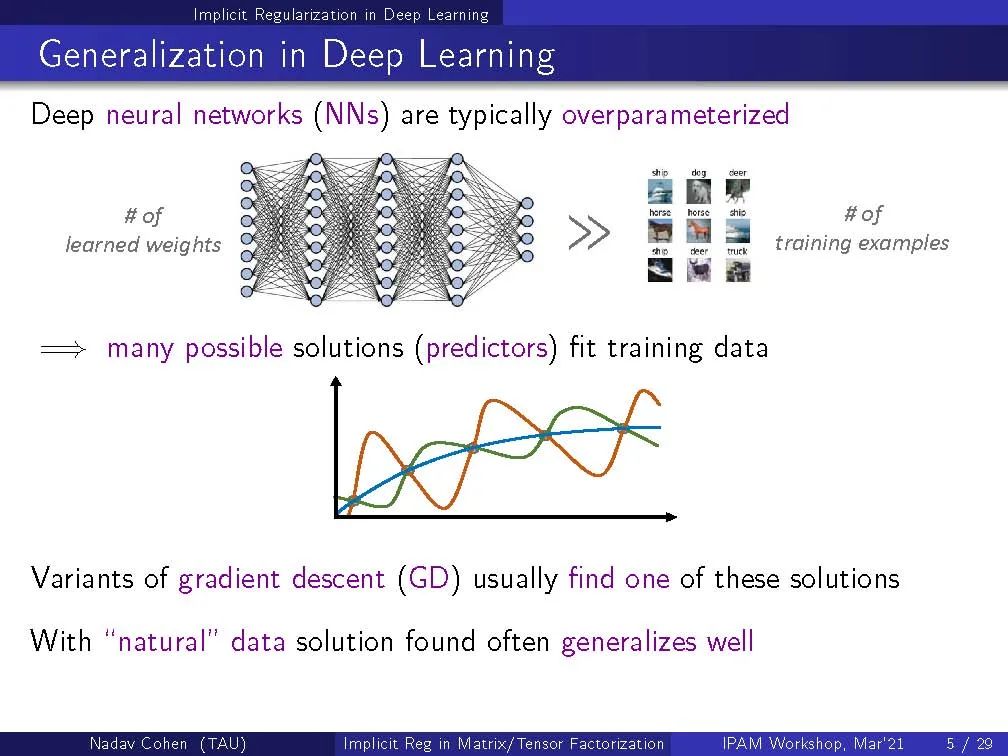

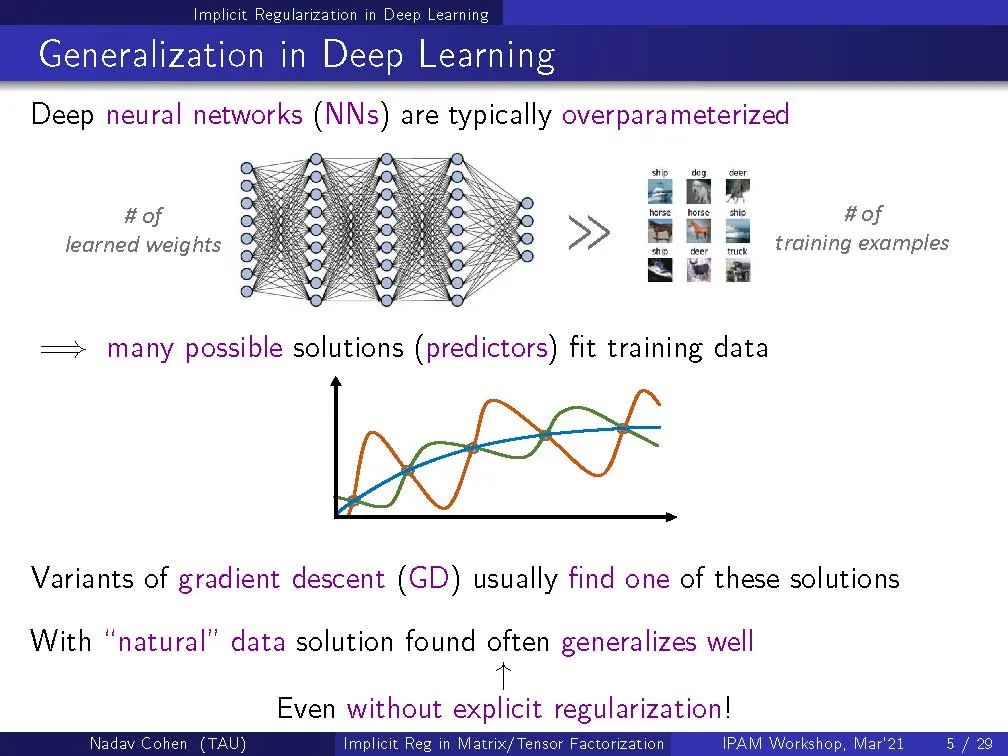

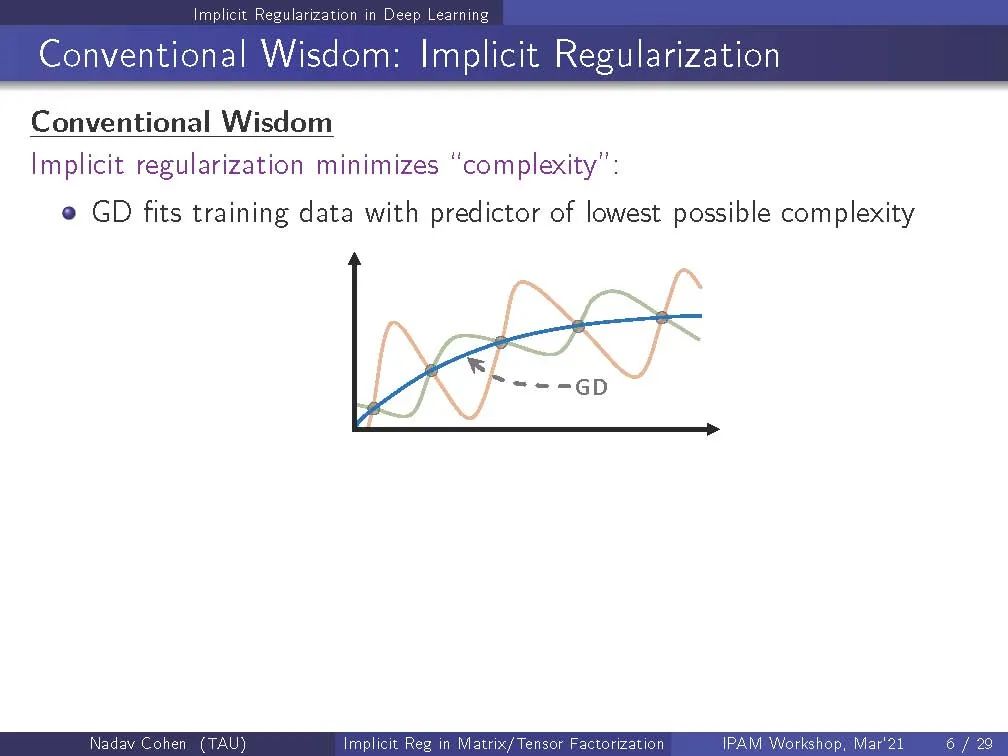

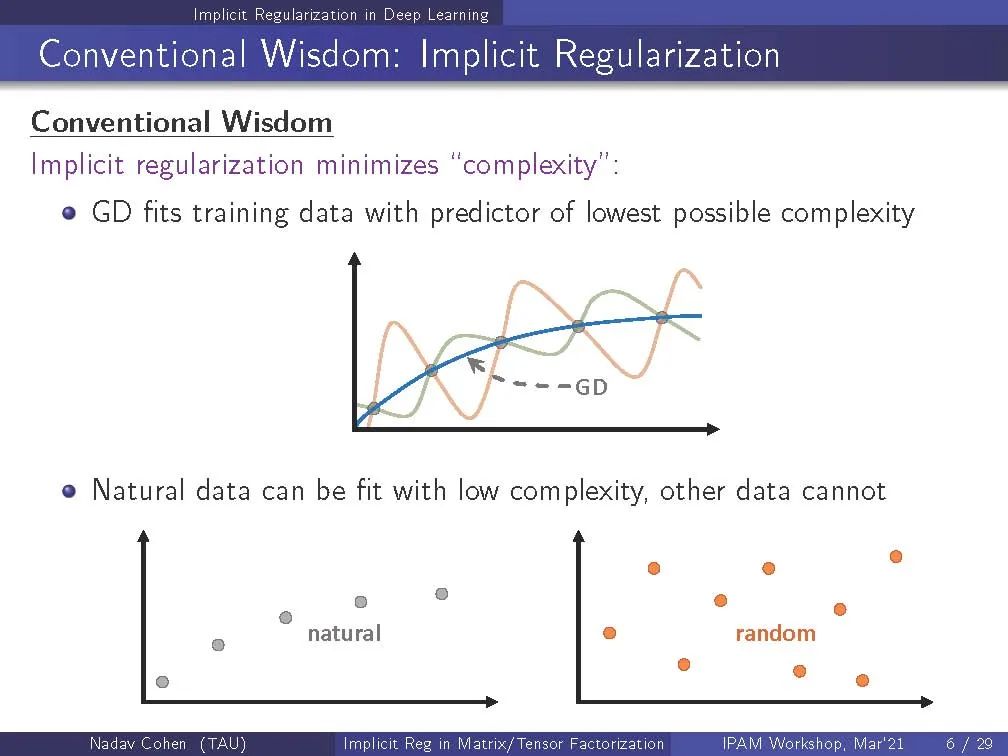

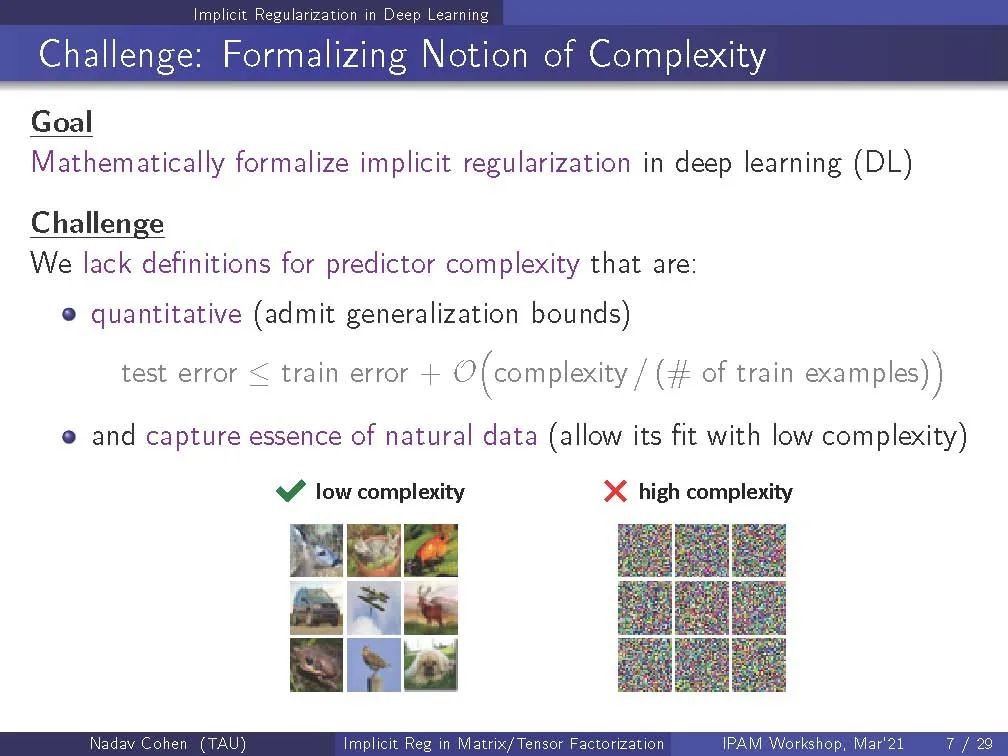

深度神经网络泛化的神秘能力被认为源于隐式正则化,一种基于梯度的优化的趋势,以拟合训练数据与低复杂度的预测器。“形式化这种直觉的一个主要挑战是,我们缺乏对复杂性的度量,既要量化,又要捕捉承认泛化的数据的本质(图像、音频、文本等)。考虑到这一挑战,我将介绍最近的隐式正则化在矩阵分解(等价于线性神经网络)和张量分解(等价于某种类型的非线性神经网络)中的分析。通过动态描述,我将建立隐式的低秩正则化,不同于任何类型的范数最小化,与先前的信念相反。然后,由于张量秩捕获非线性神经网络的隐式正则化,我将建议将其作为复杂度的度量,并表明在拟合标准数据集时它保持极低的水平。这就产生了张量秩解释神经网络的隐式正则化和将其转化为泛化的真实数据的特性的可能性。

http://www.ipam.ucla.edu/abstract/?tid=16593&pcode=TMWS1

目录:

1 深度学习隐式正则化 Implicit Regularization in Deep Learning

2 矩阵分解 Matrix Factorization

3 CP张量分解 CP Tensor Factorization

4 张量秩 Tensor Rank as Measure of Complexity

5 结论 Conclusion

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“IRDL” 就可以获取《深度学习为何泛化能力好?探究《 深度学习中的隐式正则化》从矩阵和张量分解中得到的教训,141页ppt》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年6月19日

Arxiv

0+阅读 · 2021年6月18日

Arxiv

17+阅读 · 2017年12月12日