【EMNLP2020-清华】基于常识知识图谱的多跳推理语言生成

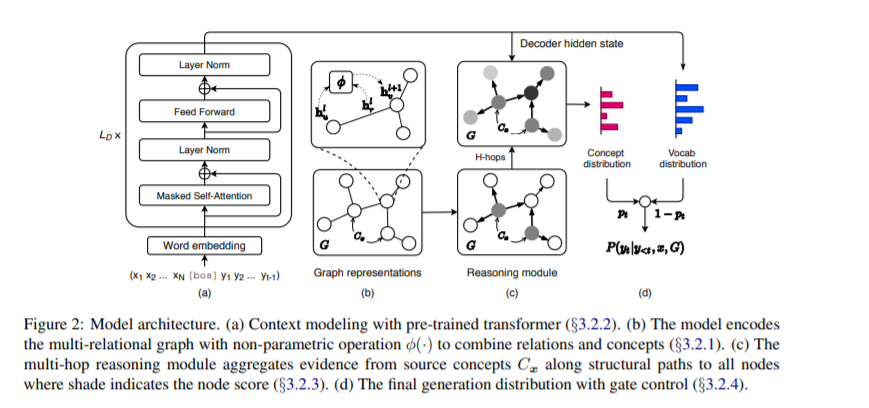

尽管生成式预训练语言模型在一系列文本生成任务上取得了成功,但在生成过程中需要对基本常识进行推理的情况下,它们仍然会受到影响。现有的将常识知识整合到生成的预训练语言模型中的方法,只是简单地通过对单个知识三元组的后训练来迁移关系知识,而忽略了知识图谱中丰富的连接。我们认为,利用知识图谱的结构和语义信息有助于常识感知文本的生成。在本文中,我们提出用多跳推理流(GRF)进行生成,使预训练的模型能够在从外部常识知识图谱中提取的多关系路径上进行动态多跳推理。我们的经验表明,我们的模型在三个文本生成任务上优于现有的基线,这些任务需要推理而非常识知识。通过模型推导出的推理路径,证明了动态多跳推理模块的有效性,为生成过程提供了理论依据。

https://arxiv.org/abs/2009.11692

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GRF” 可以获取《【EMNLP2020-清华】基于常识知识图谱的多跳推理语言生成》专知下载链接索引

登录查看更多

相关内容

专知会员服务

95+阅读 · 2019年11月8日