![]() 作者 | 陈大鑫

作者 | 陈大鑫

昨日,墨尔本皇家理工大学的教授Mark Sanderson发推表示:

SIGIR拒绝了我们的论文,没有评审喜欢它。回头看,他们是对的,论文写得不好。我们重新写了之后并提交给CIKM 2020,(最后论文获得了CIKM 2020 最佳论文奖),有时候,拒绝恰是有好处的。

![]()

首先要指出的是上文Mark Sanderson他们这篇论文中的CIKM是CCF-B类会议,而之前被拒的是SIGIR是A类会议,但是这两个会的差距有这么大以至于CIKM的最佳论文都不配在SIGIR上接收?当然作者的前后两次论文写作也是因素之一。

一般来讲,同行评审被认为是高质量、有影响力工作的过滤器,但是事实上却并非如此:

1、同行评审不能保证质量控制:

无论是小错误还是严重的方法学缺陷——如果是在生物医学文献中,发表有缺陷的结果甚至会产生致命的危害。

2、同行评审在发现有影响力的论文方面做的并不好:在引用方面,会议拒绝率与会议影响力之间的相关性不强,而且一篇论文在一个会议上被拒绝却有可能会在另一个会议上被录取并获奖,如上面例子即是。

问题在于,这两种期望一开始就不太现实。同行评审人员实际上并不能真正地执行质量把控,因为只用几个小时甚至更短的时间来评审论文是无法确保论文的可复现性的。

从同行评审中我们可以实际期待的是拒绝那些有明显方法缺陷的论文,并聚焦那些有利于该领域发展的idea。

然而,目前的评审流程并不是为了实现这两个目的而设立的,而是通过把所有论文进行评分排名,以筛选出大概TOP 25%的论文。

在去年的时候,南京大学周志华教授曾曝出:ICLR 2020竟然有47%的审稿人从来没有在本领域发表过论文。

除此之外,Science在今年三月份的时候也曾报道:经过同行评审后的研究仅比预印本研究质量提高4% 。(https://www.sciencemag.org/news/2020/03/do-preprints-improve-peer-review-little-one-study-suggest)

这个问题似乎让人蠢蠢欲动但不太好回答,近日,来自哥本哈根大学的研究者们在一篇论文中以NLP顶会为例子,指出同行评审是研究人员判断会议提交论文质量的最佳方式,但是它正在变得越来越虚假。

![]()

论文链接:https://arxiv.org/pdf/2010.03863v1.pdf

哥本哈根大学的研究者认为,问题的一部分是出于评审人员和领域主席面临的是一项定义不清的任务,这迫使他们往往都是在进行“苹果与橘子”的比较一般的任务。

研究者并在之后从多个角度分

析了评审制度的优缺点,并提出了相应改进建议。

在具体在这篇论之前,我们首先以ICLR2021为例了解一些AI顶会的评审流程:

![]()

|

|

5、程序主席分配论文给审稿人

|

9、审稿人作出终审 |

|

|

6、审稿人完成初审 |

10、区域主席作出论文Oral/poster等接收建议 |

|

|

7、区域主席审阅评审质量 |

11、程序主席作出论文最终的接收决定 |

|

|

8、“互怼”(Rebuttal)阶段 |

|

为什么同行评审如此之难?

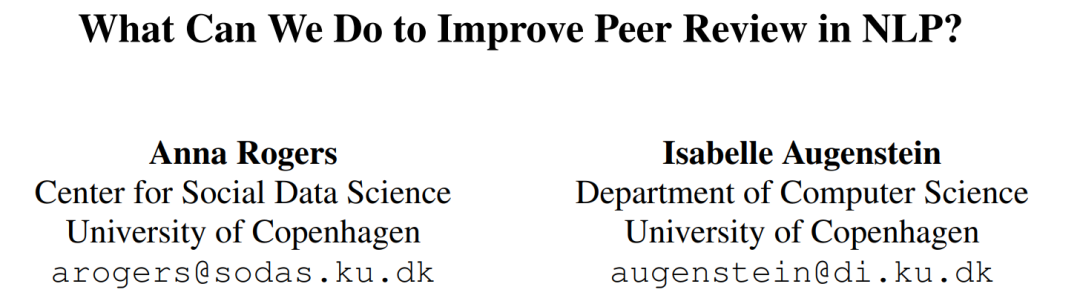

如果论文的评分等级分布(比如Oral、Spotlight等)在优秀论文和糟糕论文之间有一个明确的界限(理想情况下,这一界限将与会议接受率相匹配),同行评审将会很容易。

然而,情况显然并非如此。基于论文引用数,Anderson在2009年假设论文价值是Zipf分布的,如下图所示。

![]() 图一 论文价值分配

这意味着,即使是最客观的评审者,最差的被接受论文和最好的被拒论文之间的差异也不到1%。

更糟糕的是,事实是并没有一个明确的标准来帮助划定边界。

Anderson(2009)在SIG-COMM 2006上讨论了一个实验,他们首先对低评分方差的论文做出简单的接受/拒绝决定,然后再为高方差的论文指派额外的9名审稿人。

据报道,那些不得不讨论困难案例的评论员们被“apples-tooranges”的比较“逼疯了”,比如一篇边缘论文评价不完整,另一篇论文适用性狭隘。

不管我们为这些决定苦恼多久,决策结果看起来都是随机的。

一个很好的例子是在2014年的NIPS上,10%的提交论文被两个不同的PC评审,结果却是他们对57%的论文做出的接收决定不一致。

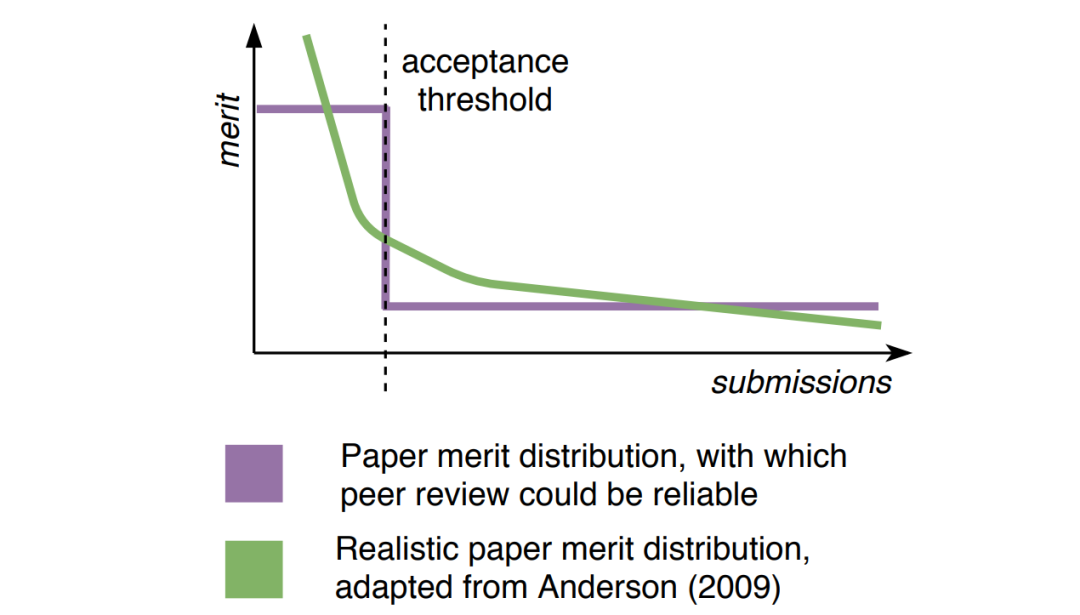

对于大型的ACL会议来说,情况更糟:我们经常互相权衡不同类型的论文,它们具有不同的优势和劣势(下图),哪一篇更具科学价值呢,这很难有一个“正确”的答案。

图一 论文价值分配

这意味着,即使是最客观的评审者,最差的被接受论文和最好的被拒论文之间的差异也不到1%。

更糟糕的是,事实是并没有一个明确的标准来帮助划定边界。

Anderson(2009)在SIG-COMM 2006上讨论了一个实验,他们首先对低评分方差的论文做出简单的接受/拒绝决定,然后再为高方差的论文指派额外的9名审稿人。

据报道,那些不得不讨论困难案例的评论员们被“apples-tooranges”的比较“逼疯了”,比如一篇边缘论文评价不完整,另一篇论文适用性狭隘。

不管我们为这些决定苦恼多久,决策结果看起来都是随机的。

一个很好的例子是在2014年的NIPS上,10%的提交论文被两个不同的PC评审,结果却是他们对57%的论文做出的接收决定不一致。

对于大型的ACL会议来说,情况更糟:我们经常互相权衡不同类型的论文,它们具有不同的优势和劣势(下图),哪一篇更具科学价值呢,这很难有一个“正确”的答案。

启发式评审

本节列出了NLP中最有问题的启发式方法,以供评审人员和论文作者参考。

语言错误、不规范的文体或修辞结构容易被发现并被认为态度非常草率,这使得几乎所有人都在与北美作者的对比中处于劣势。

英语组织差的论文给人感觉比内容差还要更糟糕。

一个简单的启发是检查论文是否超过了SOTA。虽然一项工程贡献应证明与SOTA相比有显著改进,但并不一定是预测性能的改进:计算或数据效率、可解释性、认知合理性等方面的进步也很有价值。

对预测性能的过多关注鼓励了对训练前数据和计算的“军备竞赛”,并加剧了方法论问题。与最新的SOTA模型进行比较的要求也让我们陷入了

仓鼠轮

的困境,使得实验在论文提交时已经过时。

在过去的两年里,Transformer几乎占据了话题霸主,仅BERT就成为150多个提出分析和各种修改的研究的目标。“热门趋势”形成了推荐接受的论文类型的原型。像历史文本规范化这样的小众主题则被否决了(除非BERT可以用在这方面)。

由于典型的NLP实验使用英语作为目标语言,使用其他语言,论文将被认为狭隘。这种启发是站不住脚的,因为只测试爱沙尼亚语的方法和只测试英语的方法一样具有普遍性吗,但它也加强了英语的“默认”霸主地位。

如果审稿人认为一篇论文已经被研究界接受,他们就不需要再做过多评审了。例如,BERT没有办法通过完全匿名的同行评审。另外知名实验室往往有大量的在线关注订阅者,甚至是PR部门,“

马太效应

”越来越明显。

由于一篇典型的“可接收”论文以复杂的DL模型为特征,简单的解决方案看起来好像作者没有做足够的工作。这种观点显然是不对的的,因为目标是解决问题,而不是以复杂的方式解决问题。

由于一篇“主流”的ACL论文目前使用基于深度学习的方法,所以其他任何东西看起来都不属于主流——即使ACL代表“计算语言学协会”。这使得跨学科的努力处于劣势,并继续出现NLP的智力隔离趋势。理论论文和语言资源不应该仅仅因为不包含深度学习实验就处于劣势。

令人惊讶的是,在一个如此依赖于有监督的机器学习的领域里,资源论文通常仅仅因为是提供资源的论文而被拒绝。

这听起来几乎荒谬,但科学同行评审系统地偏向于无异议(而非新颖)的作品。

一个评审员在没有现有技术的情况下评估一个全新的idea,要比一篇有明确的已有工作和排行榜的论文更困难,这会促进“安全的”、渐进的、可能枯燥的工作,并将非主流工作置于不利地位。

很难回答,因为科学价值的标准很模糊。人类在回答一个难题时通常会不自觉地用一个更简单的问题来代替它。

“使用这种启发式方法的评审人员实际上并不是对他们分配给他们的真实论文作出回应,而是对更符合他们兴趣和方法的虚构论文作出回应,而真实的论文相比之下则是不利的。

EMNLP 2020在其官网博客中明确提出了上述大多数启发式方法,但启发式是人类在不确定情况下不得以妄自推理评审的方式,因此解决这个问题的唯一方法就是澄清评审人员期望执行的任务。

我们可以废除同行评审吗?

想法很大胆![]() ,现实很无奈。

如果这项任务从根本上说是不可能的,我们是否应该放弃它,进而寻找替代同行评审的方法?每一轮的会议录取通知都会促使社交媒体呼吁废除整个系统、提高录取率、让论文引用成为衡量论文质量的标准。

不幸的是,这是不现实的,即使论文引用数和科学声誉或努力的宣传之间没有共同的依赖性。

从根本上讲,低录取率是非专家论文质量的一个代表指标,几乎每个招聘和资金委员会都期望这一指标。我们还不能提出关于如何改变这种状况的严肃建议,任何实验都需要一代非常勇敢的学生,他们愿意在没有很“体面”论文发表记录的情况下毕业。

EMNLP 2020提出的Findings是一个好例子,它使EMNLP能够在除了22.4%的主会接受率之外增加15.5%的额外接受率。

不幸的是,这种方法并没有解决根本问题,并引入了新的问题:

•Findings的存在很可能加剧审稿人的偏见:

他们可能会对“non-trendy”工作给出较低的分数,以促使其论文进入Findings

。

•无论Findings在社区中取得什么样的地位,在学术排名中,它将始终是第二梯队:这也许将改变从事“non-trendy”工作的人的职业轨迹和所受到的资助;

•Findings隐含地迎合了“快科学”:作者不必改进论文,而是可以原封不动地发表论文的情况下继续别的研究之路。

从短期来看,Findings帮到了作者(尤其是那些SOTA结果可能“过时”的作者),

但是从长远来看,这将意味着更多的论文被处理的结果不好。

最后,“Findings”还降低了一个新的顶会出现的可能性、使“untrendy”主题成为trendy,并可能改变该领域的方向。

具有讽刺意味的是,EMNLP本身就是被保守的ACL评审员拒绝的论文的发源地。

如果ACL在1996年创立 Findings ,那么今天可能就没有EMNLP了,而且整个领域的经验也可能更少。

,现实很无奈。

如果这项任务从根本上说是不可能的,我们是否应该放弃它,进而寻找替代同行评审的方法?每一轮的会议录取通知都会促使社交媒体呼吁废除整个系统、提高录取率、让论文引用成为衡量论文质量的标准。

不幸的是,这是不现实的,即使论文引用数和科学声誉或努力的宣传之间没有共同的依赖性。

从根本上讲,低录取率是非专家论文质量的一个代表指标,几乎每个招聘和资金委员会都期望这一指标。我们还不能提出关于如何改变这种状况的严肃建议,任何实验都需要一代非常勇敢的学生,他们愿意在没有很“体面”论文发表记录的情况下毕业。

EMNLP 2020提出的Findings是一个好例子,它使EMNLP能够在除了22.4%的主会接受率之外增加15.5%的额外接受率。

不幸的是,这种方法并没有解决根本问题,并引入了新的问题:

•Findings的存在很可能加剧审稿人的偏见:

他们可能会对“non-trendy”工作给出较低的分数,以促使其论文进入Findings

。

•无论Findings在社区中取得什么样的地位,在学术排名中,它将始终是第二梯队:这也许将改变从事“non-trendy”工作的人的职业轨迹和所受到的资助;

•Findings隐含地迎合了“快科学”:作者不必改进论文,而是可以原封不动地发表论文的情况下继续别的研究之路。

从短期来看,Findings帮到了作者(尤其是那些SOTA结果可能“过时”的作者),

但是从长远来看,这将意味着更多的论文被处理的结果不好。

最后,“Findings”还降低了一个新的顶会出现的可能性、使“untrendy”主题成为trendy,并可能改变该领域的方向。

具有讽刺意味的是,EMNLP本身就是被保守的ACL评审员拒绝的论文的发源地。

如果ACL在1996年创立 Findings ,那么今天可能就没有EMNLP了,而且整个领域的经验也可能更少。

我们能做什么?

在评估研究人员的方式发生系统性变化之前,同行评审仍然是“

可用的最差系统

”,不过显然还有改进的余地。

首先,同行评审必须成为学术简历的重要组成部分,也是雇主预算时间的一部分。过度劳累的研究人员在空闲时间做的评审其质量不会太高的。

其次,我们需要减少评审人员和AC在高度不确定性下进行推理评审的需求。

当审稿人不是他们所评审论文的专家时,他们估计要用不太靠谱的启发式方法来审稿。匹配应该同时考虑任务和方法,但是由于不可能总能找到完美的匹配,因此具有互补部分专业知识的审稿人(例如,如果论文不是关于英语的,需要一名会说这种语言的人,再加上一名领域专家)可能是一种保守策略。

AC 不应该对不同类型的论文做出决策。如果 survey,opinion,资源和分析论文等都是受社区欢迎的,那么它们应该有各自对应的接受率和最佳论文奖。

用新颖性去评判可复现性报告或用 SOTA 结果评判资源论文都是不合理的。COLING 2018 曾提出考虑论文贡献类型的评审形式。

某个会议的主要关注点是什么:是SOTA工程、方法的多样性、还是新idea?哪些因素对论文接收与否影响比较大?清楚地说明这一点将有助于作者为他们的研究工作找到一个合适的会议,也有助于评审和AC意见更加一致。

这就是为什么相似的论文会从不同的评审那里得到看似随机排名的原因,因为他们在原创性等问题上存在着分歧,即使有明确的政策也是无济于事。显而易见的解决办法是只要求审稿人给出具体的分数(原创性、技术可靠性等),而这恰恰成为决定论文接收与否的基础。

还有另一种根本不同的方法是提高评审员的责任感,例如通过公开评审。

不幸的是,类似ICLR这样的公开评审并没有解决核心问题,而且会引入其他相关问题。

是什么阻碍了进步?

现在在这一点上,读者可能会和这篇论文的匿名评审一样的失望,觉得:咳,多新鲜!

这也正是问题如此困难所在的原因:

我们不缺乏概念创新而是缺乏实际行动。

在组织方面,每一届 ACL会议都由一组新的人员来组织,他们会设立自己的政策。这样的多样性本身将是个美事,但往往很多事情都会随同改变,没有系统的对比,显著成功的创新可能不会持续。

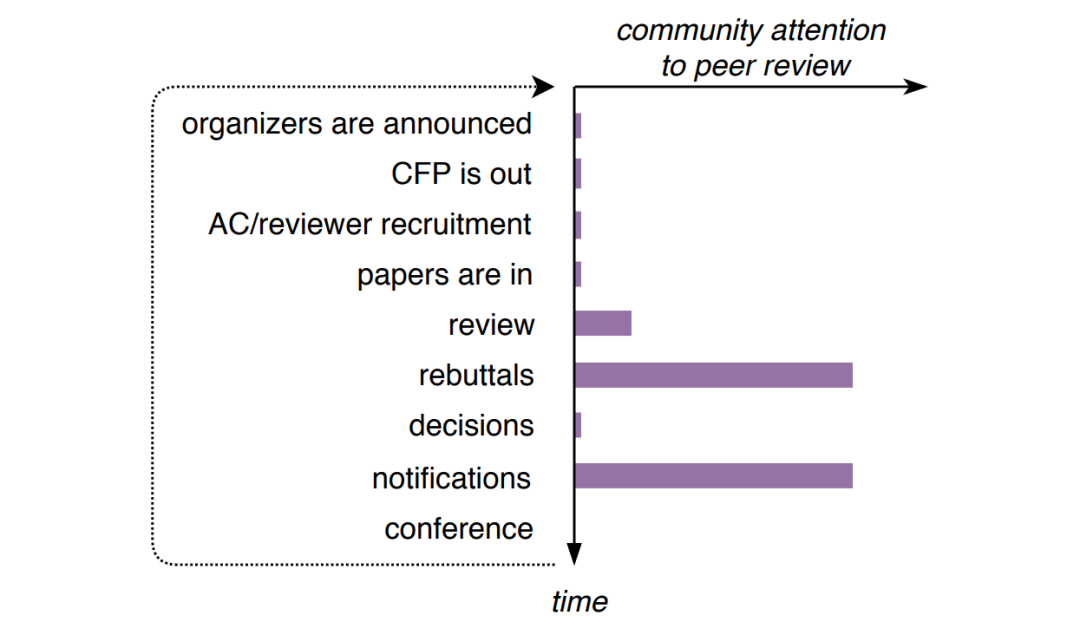

在社区方面,我们还不知道社交媒体上如何讨论同行评审的量化研究,但作为Twitter#NLProc社区的活跃成员,我们的印象是,这一主题主要是在作者反驳期间以及在主要会议上收到接受通知后出现的,如下图所示:

当时,有很多抱怨和改革建议,但实际行动却很少(这确保了在下次会议上重复这种循环)。

从根本上说,同行评审是一个注释问题,我们可以尝试解决它,因为我们对实验方法论、迭代指导原则开发、注释者间的一致性和偏差有足够的了解。

•组织者

:缺乏机制来检验一项政策是否优于另一项政策,并确保成功的政策得到遵守。

•作者:

缺乏积极监测政策变化的意愿,缺乏要求报告和获取评审数据进行独立分析的能力。

•评审员:

缺乏对元研究作为研究有效部分的认可,这一点,正如我们在本文中所了解到的,很难在其上发表。

在某种程度上,同行评审似乎阻止了其对同行评审本身的研究,这似乎是作茧自缚?

结论

社区让人们执行定义不清的任务是行不通的,然而,这正是我们作为评审员对自己的期望,

我们可以努力做得更好。

降低论文评价不确定性的方法很多,例如改进评审机制和评审人员论文匹配问题。问题是,除了ACL已经在做的事情之外,实现其中任何一个都需要大量的工作,有时这与ACL当前的实践背道而驰。

在任何一个大型组织中进行大的变革都是困难的(尤其是在志愿者驱动的组织中),但这是唯一的方法。

1、承认这类工作是值得尊敬的、有价值的元研究(这样就有了做这项工作的动机)。

2、为系统开发、测试和对比评审政策以及社区反馈循环创建新的、ACL投票通过的角色供作者和评审员使用。

其实ACL的一个特别委员会正在进行滚动评审改革,

以应对日益增长的论文评审量,但是提高评审质量则是另外一个不同的、需要长期为之努力的工程。

![]()

点击“阅读原文”,进入直播间预约,避免错过精彩分享!

作者 | 陈大鑫

作者 | 陈大鑫

图一 论文价值分配

图一 论文价值分配

,现实很无奈。

,现实很无奈。