人类善于利用手指触觉来感知物体的物理特性(包括质量、重心、转动惯量、表面摩擦等),从而完成高难度的控制任务。在不远的将来,机器人也会拥有触觉分析能力。在刚刚结束的机器人顶会 IROS 2020 上,上海交大 & MIT 联合项目 SwingBot 为我们展示了如何让机器人通过触觉传感器来学习感知物体复杂的物理特性(tactile exploration),从而完成一个高难度的甩笔任务(in-hand object swing-up)。该工作也摘得此次大会的最佳论文奖项。

![]()

IROS2020 最佳论文奖项。来源 iros2020.org (http://iros2020.org/)

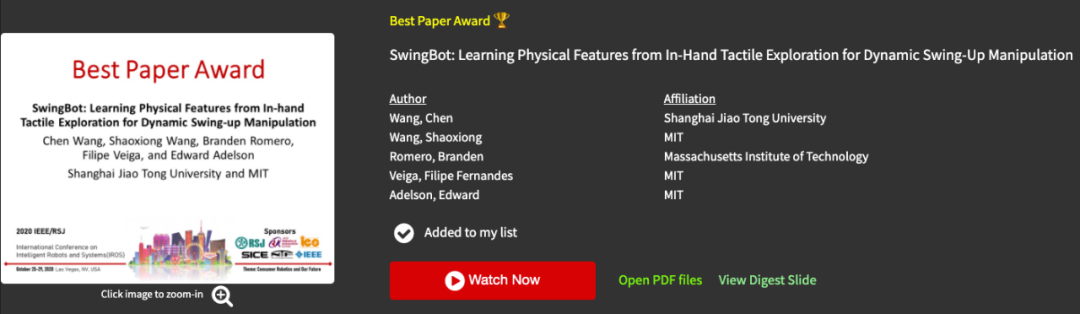

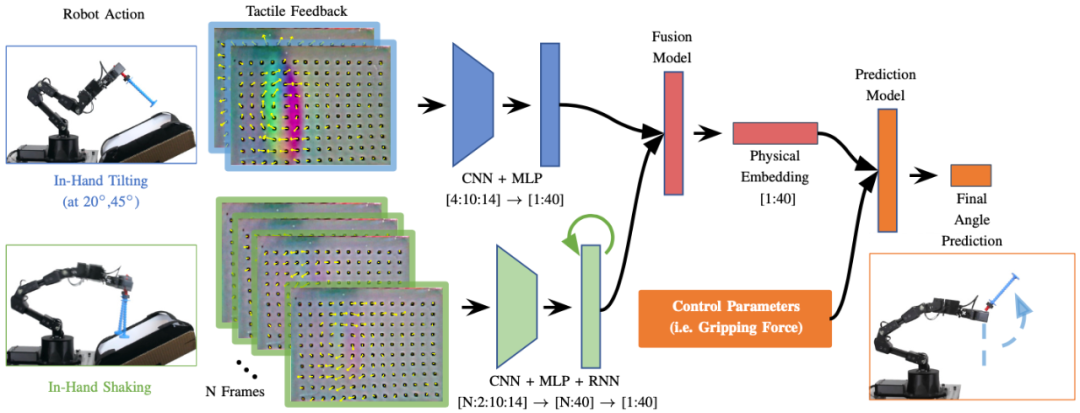

下图为机器人触觉分析的流程通过握着物体旋转一定角度和抖动物体来感知物理特性,从而推断出最佳的控制策略实现甩笔。

![]()

该项目通过对多种触觉探索动作的信息融合,让机器人端到端的去学习概括手中物体的物理特性,并依靠这个物理特征来实现高难度的手上控制任务(in-hand swing-up)。更多的详细内容可以访问论文原文和项目主页:

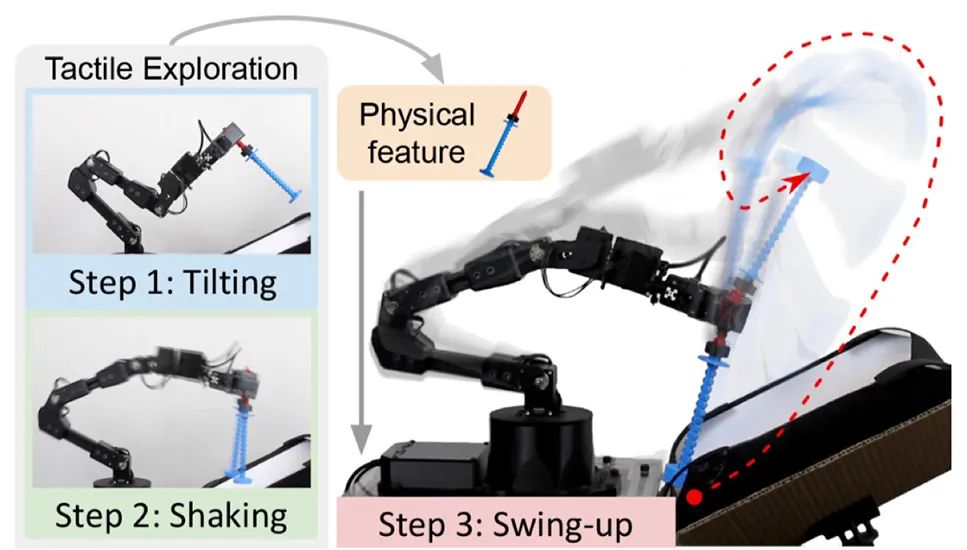

研究人员使用的是一款名为 GelSight 的机器人触觉传感器,该传感器也发明于此 MIT 项目组(指导教授:Edward Adelson)。区别于传统触觉传感器依赖于稀疏的电极阵列(基于电阻 / 电容 ),GelSight 是一个

基于光学的触觉传感器,通过一个微型相机来拍摄接触面的三维几何形变,可以返回高精度的触觉信息

(见下图是 GelSight 重建的奥利奥饼干表面)。

更值得一提的是,因为只需要一个低成本的微型摄像头和一个树莓派控制器,GelSight 的制作总成本只有 100 美金(700 元),远低于市面上的其他触觉传感器。

![]()

在本篇工作中,研究人员将 GelSight 安装在了机器人二爪夹具的一侧,通过在传感器上

标定靶点和重建三维信息

,高密度的力学反馈可以以每秒

60

帧的速度实时传输出来。

![]()

人类可以通过多种触觉探索动作(触摸、甩、掂量)来概括手上物体的物理特性(重量、光滑程度、重心位置等)[1],而且人类并不需要测量这些物理参数的精确数值,而是用自己的经验结合触觉手感来实现对手中物体高难度的控制。

受这个观察的启发,该项目的研究人员首先提出了一个多触觉探索的信息融合模型(Information fusion model for multiple tactile exploration actions),该模型的目的是整合不同的机器人触觉探索动作信息到一个共同的物理特性特征空间(Physical embedding)中,从而实现对物体多种物理特性(质量、重心位置、转动惯量和摩擦力)的概括能力。

![]()

研究人员为机器人设计了两种基础的探索动作:(1)紧握物体并旋转一定角度(in-hand tilting)和(2)放松紧握状态并抖动物体(in-hand shaking)。动作(1)的触觉反馈信息会通过一个卷积神经网络(CNN)来输出一个一维的特征向量;动作(2)的抖动因为是时序信息,会用一个循环神经网络(RNN)来处理获得相应的特征。这两个特征信息通过拼接和一个由若干多层感知器(MLP)组成的融合模型进行整合,得到一个低维的物理特征概括(physical feature embedding)。

区别于逐个测量每种不同的物理特性,这种信息整合模型的一大优势是可以根据任务来自主调节对不同物理信息的关注程度,因为很多任务是无法明确分析出是哪一种物理特性起到了主导作用,而使用该方法可以让

机器人自主地学习并选择需要的物理信息

。此外,这两个触觉探索动作加起来只需要 7 秒的时间,相比于用精密的仪器来逐个测量物体的质量和摩擦力等,该方法的效率也有很大的提升,并且不需要额外的测量仪器的辅助,

更接近人类的触觉感知能力

。

此外,为了让机器人自主学习选择最需要的物理信息,研究人员接着提出了一个控制预测模型,该模型通过输入先前获得的物理特征向量和机器人控制参数,来预测最终物体会被甩到的角度。在训练过程中,整个流程是用一个端到端(end-to-end)的训练算法来实现的。研究人员设计了一个

机器人自动采集数据的系统,并且 3D 打印了可以随意调节物理特性的模型来采集数据

,具体如下两个动图所示:

![]()

![]()

研究人员让机器人自主采集了

1350

次甩笔的数据,其中包含了

27

个不同物理特性的物体。在测试的时候,研究人员额外选择了

6

个训练数据中不包含(unseen)的新物体,机器人需要通过触觉探索模型来确定未知物体的物理特性,并根据任务要求的最终甩到的角度,来选择一套成功率最高的控制参数。

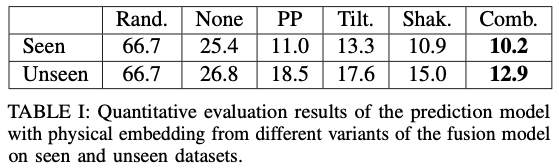

研究人员首先对比了使用和不使用多触觉探索融合算法对预测控制模型准确率的影响(数值越低,准确度越高),其中融合算法(Comb.)在已知和未知物体上的预测误差率都远低于不使用触觉信息(None)。此外融合算法(Comb.)的表现也比单一使用一种触觉探索动作(Tilt.: tilting-only, Shak.:shaking-only)的算法效果好。

![]()

以下是机器人在测试过程中,通过使用多触觉探索融合算法来实现对未知物体(unseen objects)的物理特性探索和上甩效果(swing-up)。第一个任务要求将物体上甩至相对于传感器 90 度的角度位置:

![]()

第二个任务要求将物体上甩至相对于传感器 180 度的位置:

![]()

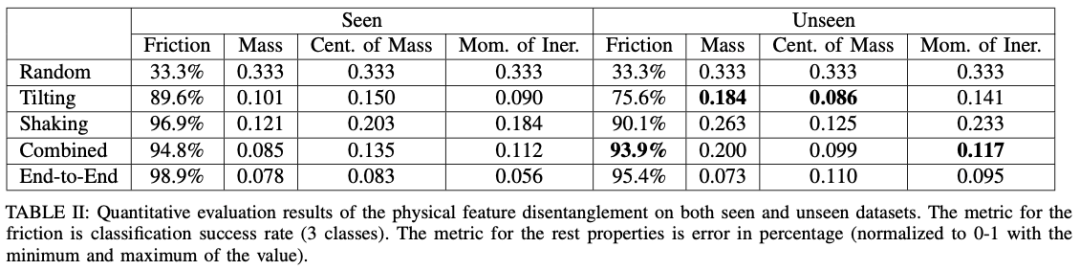

研究人员紧接着探索融合算法学习到的物理特征空间到底包含哪些信息。他们用一组额外的多层感知器来回归(regression)每一个物理特性的具体参数,并计算误差百分比(数值越低,准确度越高)。

如下表所示,可以发现第一个旋转动作(Tilting)对物体的质量(Mass)、重心(Center of mass)和转动惯量(Moment of inertia)的信息捕捉更准确。而第二个摇晃动作(Shaking)对物体接触部分的摩擦力(Friction)的把握更准。将两种探索动作融合的算法(Combined)取得了最好的回归准确率。

![]()

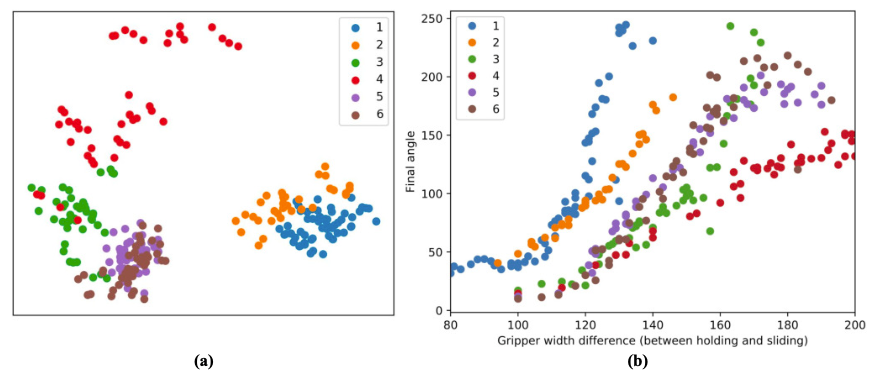

最后研究人员进一步探索所学习到的物理特征空间是如何能够做到对未知物体依然适用的。他们可视化了

6

个未知物体的数据分布并展示在了下图 (b) 中,其中 x 轴表示控制参数,y 轴表示最终上甩的角度。在图 (a) 中,研究人员用 PCA 提取了每个采样中网络输出的物理特征向量的主成分(2 维)并可视化在这个二维点图中。观察可以发现,如果两个物体的控制策略相近(例如物体 5 和物体 6),他们的物理特征间距也会越近,而两个物体的控制策略相差较大(例如物体 1 和物体 4),则在特征空间上的间距也会更大。

![]()

![]()

王辰(Chen Wang): 本科毕业于上海交通大学,师从卢策吾教授。他即将前往 Stanford 攻读计算机博士学位,该项目是其在 MIT 暑研期间完成的。个人主页:http://www.chenwangjeremy.net

王少雄(Shaoxiong Wang):MIT CSAIL 博士生四年级,师从 Prof. Edward Adelson(此项目指导教授),本科毕业于清华大学。个人主页:http://shaoxiongwang.com/

[1] Lederman, Susan J., and Roberta L. Klatzky. "Hand movements: A window into haptic object recognition." Cognitive psychology 19.3 (1987): 342-368.

[2] M. K. Johnson and E. H. Adelson, "Retrographic sensing for the measurement of surface texture and shape," 2009 IEEE Conference on Computer Vision and Pattern Recognition, Miami, FL, 2009, pp. 1070-1077, doi: 10.1109/CVPR.2009.5206534.

本周日,在北京有一场属于开发者的冬日狂欢。

12月20日,798大罐等你。

点击

阅读原文

,立即报名。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com