【动态】“人工智能安全与隐私”系列论坛第16期圆满落幕

会议上午十点开始,首先由吴保元教授开场主持。吴教授简要介绍了AISP论坛的基本情况,并介绍了本次论坛的主办、承办及协办单位,以及论坛的专家委员会。其次,吴教授介绍了香港中文大学(深圳)数据科学学院所在实验室的情况。然后,吴教授对本期主讲嘉宾韩亚洪教授进行了简介。

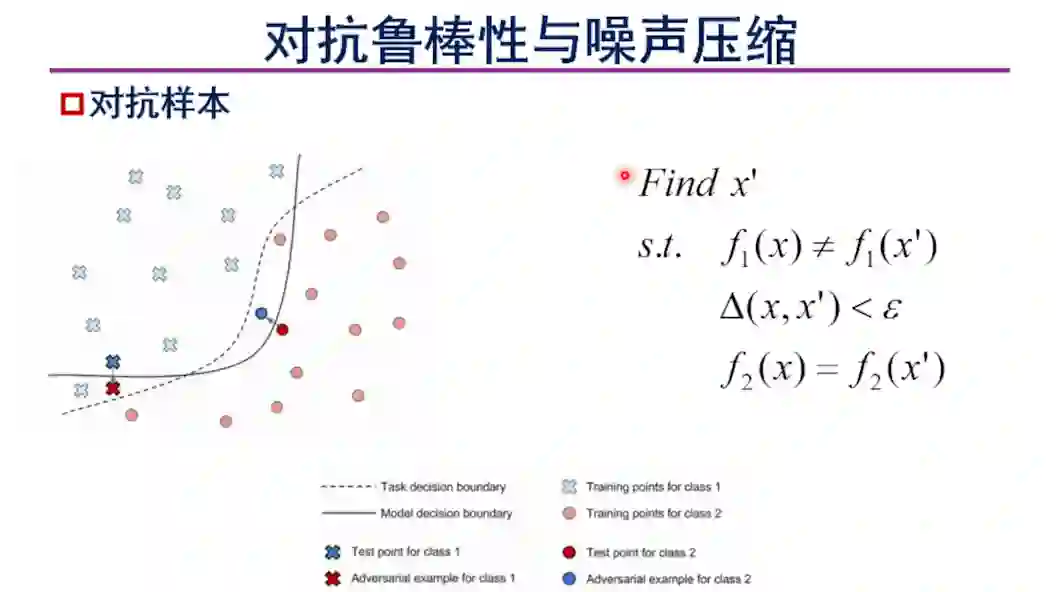

接下来,由天津大学智能与计算学部韩亚洪教授进行题目为《深度视觉模型的对抗鲁棒性与黑盒攻击》的报告。韩教授的报告分为五个方面。首先讨论对抗鲁棒性和噪声压缩。这部分内容是后面工作开展的基础。韩教授首先提到,对抗样本是计算机视觉和机器学习领域的一个重要概念,并给出了对抗样本的定义。根据攻击方对目标模型了解程度的高低,对抗攻击可分为白盒攻击和黑盒攻击两类。

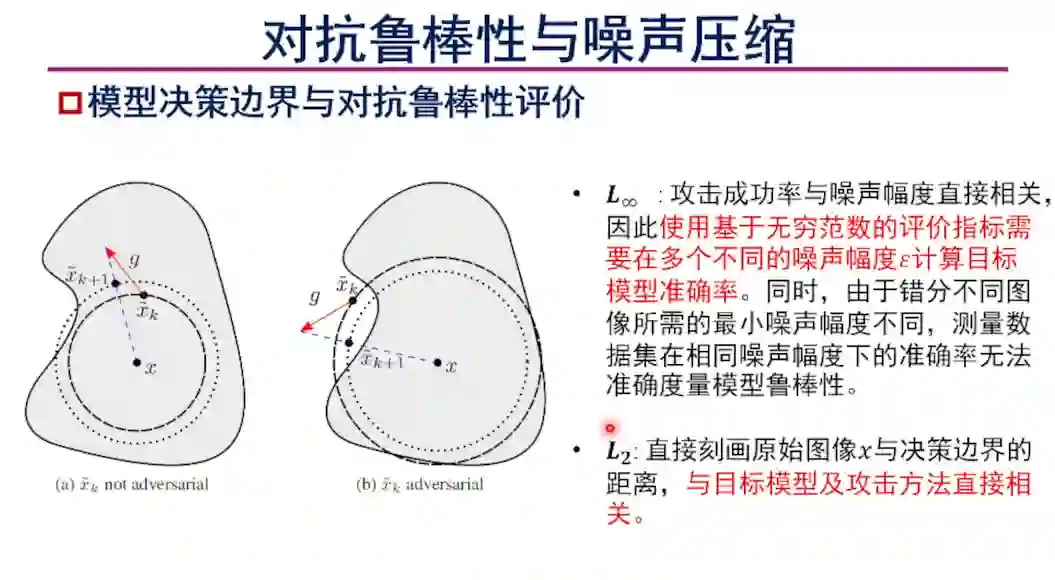

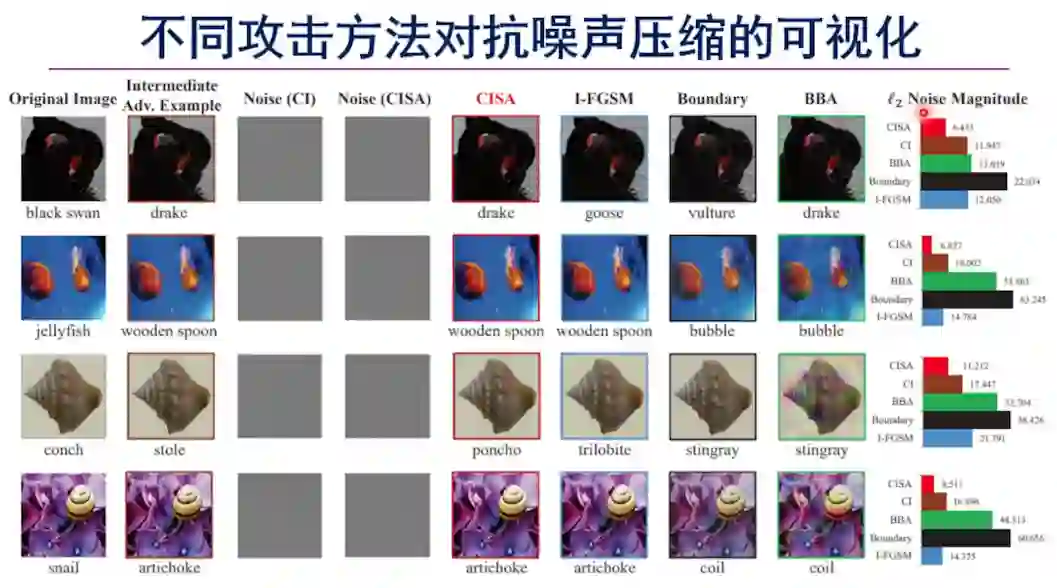

韩教授比较了对抗攻击中两种评价策略。其中基于无穷范数的评价策略在定量噪声幅度下计算攻击方法的攻击成功率。二范数则计算攻击成功所需的最小噪声幅度。通过从对抗空间和集合论两方面的分析可得出结论,基于无穷范数的评价策略能找到的对抗样本是二范数评价策略能找到的对抗样本的真子集,因此在不引入额外限制情况下对噪声幅度的压缩,相对于在人为限定的噪声幅度下判断是否错分,是更优的判断准则。

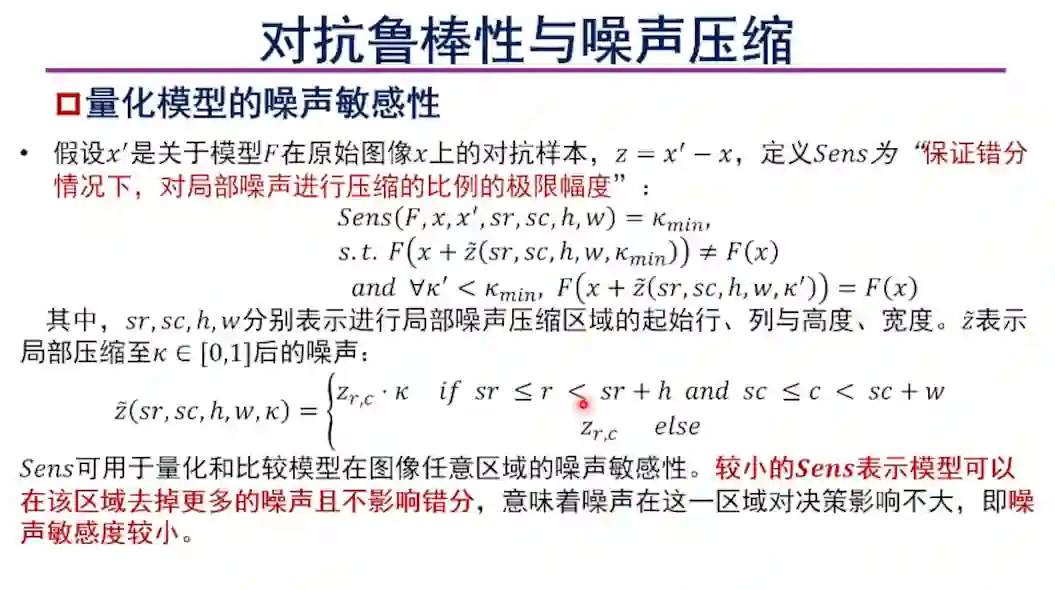

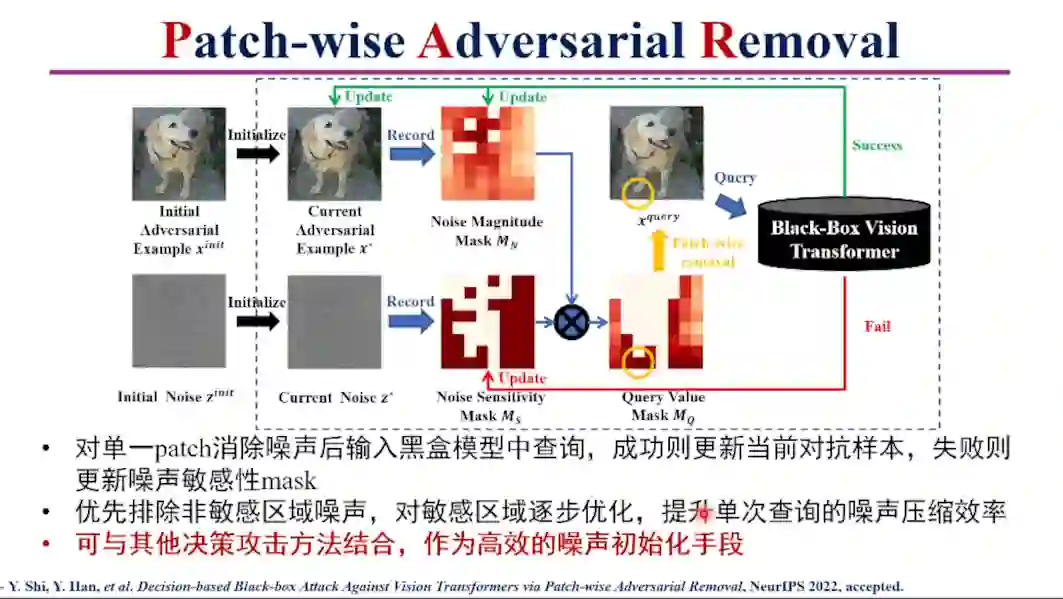

韩教授进一步对模型的噪声敏感性进行了定义,使用“保证错分情况下,对局部噪声进行压缩的比例的极限幅度”对模型的噪声敏感性进行了量化,并比较了CNN和ViT两类模型的噪声敏感性。韩教授介绍了在噪声敏感性定义的基础上关于噪声敏感性与决策攻击成功率的定理,结论为噪声压缩的失败更有可能是图像的高敏感区域导致的。

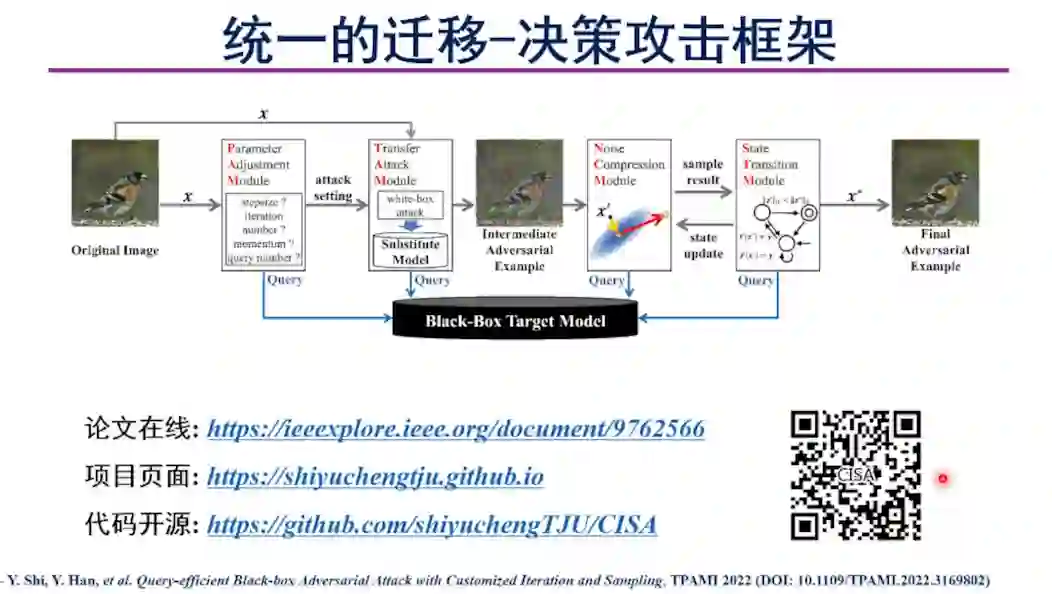

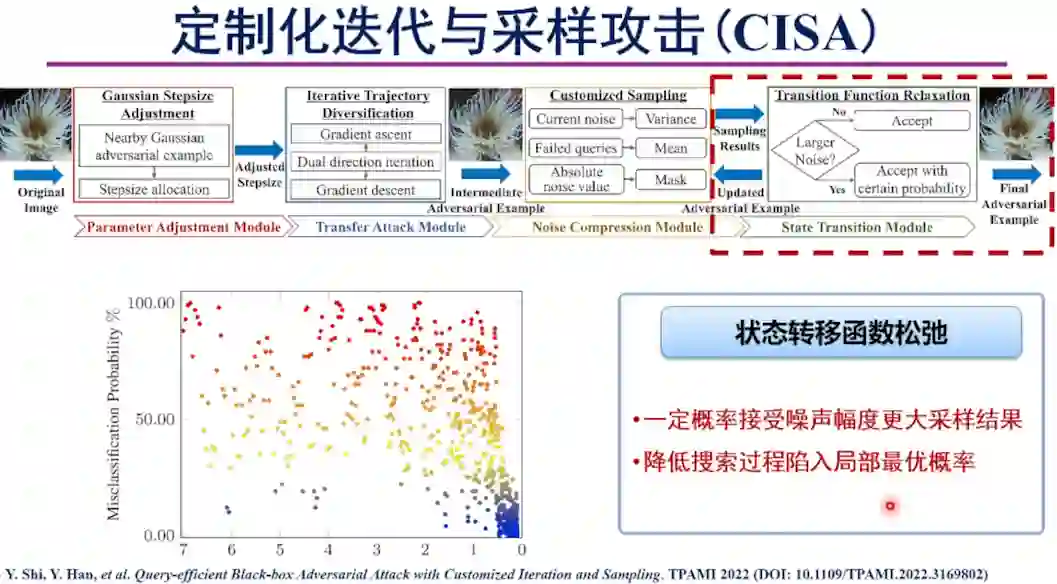

在此基础上,韩教授介绍了两个相互关联的工作。第一个工作是统一迁移-决策黑盒攻击。韩教授首先介绍了现有基于迁移和基于决策的黑盒攻击在模型过拟合、冗余噪声压缩、查询效率低下等方面的问题。针对现有方法的问题,韩教授提出了由四个模组构成的黑盒攻击框架,其中四个模组分别进行参数调整、迁移攻击、噪声压缩和状态转移。

在新的黑盒攻击框架的基础上,韩教授介绍了定制化迭代与采样攻击。该方法中包含高斯步长调整、迭代轨迹多样化、定制化采样和状态转移函数松弛四个步骤。该工作发表在TPAMI 2022上。

韩教授在新的黑盒攻击方法基础上,对决策攻击噪声压缩单调性进行了进一步的理论分析,包括决策攻击噪声压缩单调性分析以及边界攻击的马尔科夫性质,并展示了CISA攻击方法的实验结果。

第二个工作是针对ViT的决策黑盒攻击。韩教授介绍了ViT和CNN结构差异导致的对ViT进行黑盒攻击的困难。针对现有黑盒攻击方法的问题,韩教授介绍了首个针对ViT模型的黑盒决策攻击方法PAR。PAR使用高斯噪声生成初始对抗样本,使用两个掩模分别记录当前对抗样本的噪声幅度和噪声敏感性,寻找噪声消除价值最高的patch进行压缩。

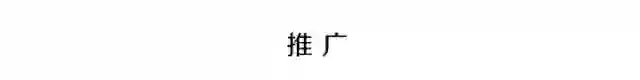

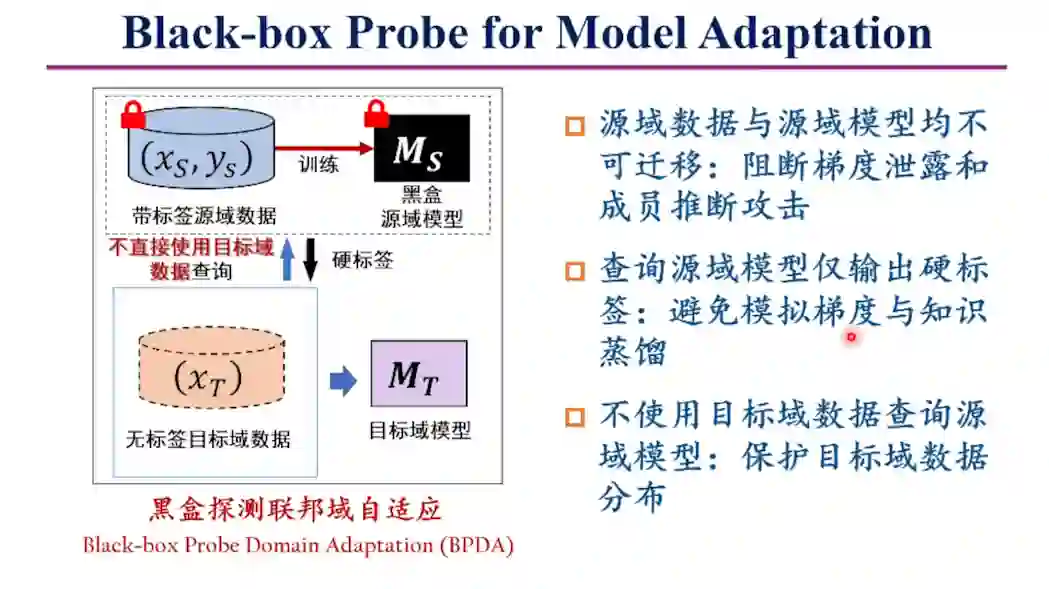

接下来,韩教授介绍了在更加开放的环境下对黑盒去中心化模型部署的方法。现有的域自适应方法至多在Source-free的无监督域自适应设定下进行方法设计,由于依靠梯度传递和模型交换方法,可能面临模型窃取或成员推断攻击等威胁。因此,韩教授介绍了黑盒域自适应设定用于在复杂开放环境下阻断梯度泄露和成员推断攻击。

针对该框架,韩教授提出了BPDA域自适应方法,通过分布对抗训练提升黑盒探测效率,可在不传递模型的情况下实现安全的域自适应。

接下来是吴保元教授为我们带来的《Our recent advances on black-box attacks and a comprehensive benchmark》报告分享

首先,吴教授介绍了一个基于查询和迁移的黑盒对抗攻击工作。

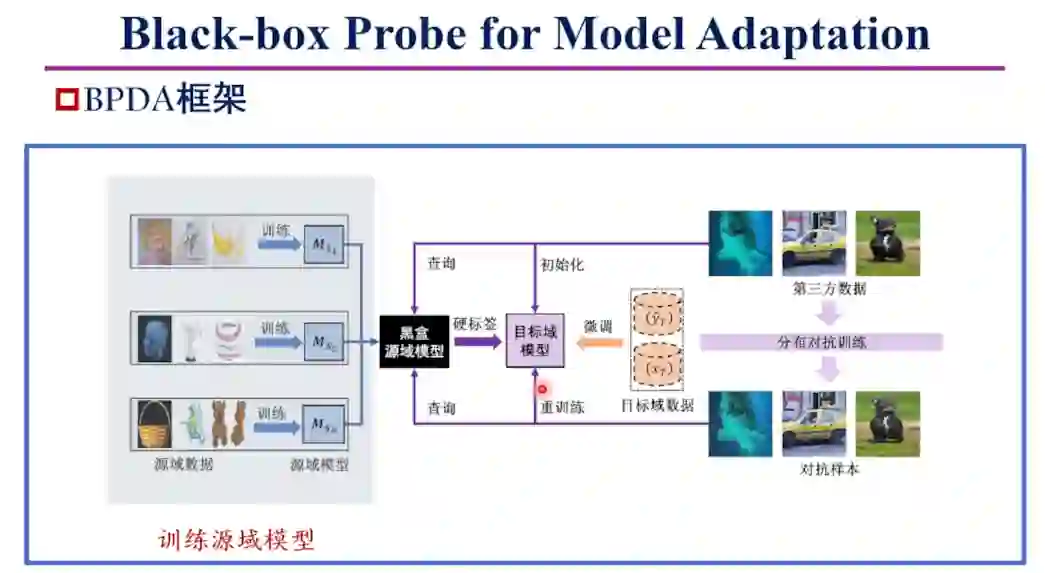

在基于查询的黑盒对抗攻击方法中,除了韩教授重点介绍的基于决策的攻击方法外,还有一类基于置信度的攻击方法称作Score-based attack,这种方法从分类正确的数据出发,逐步添加噪声直到错分

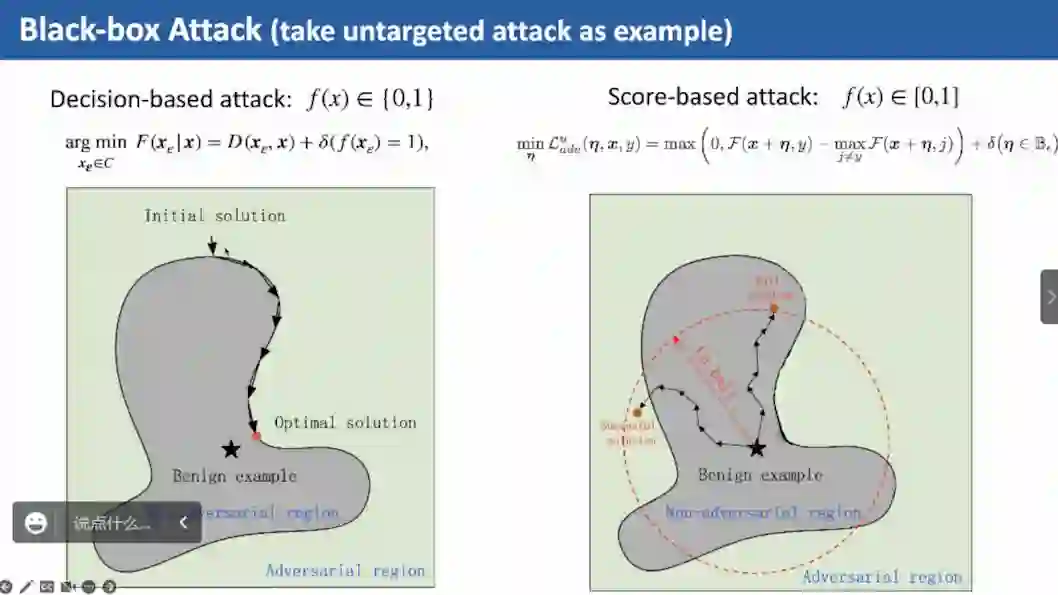

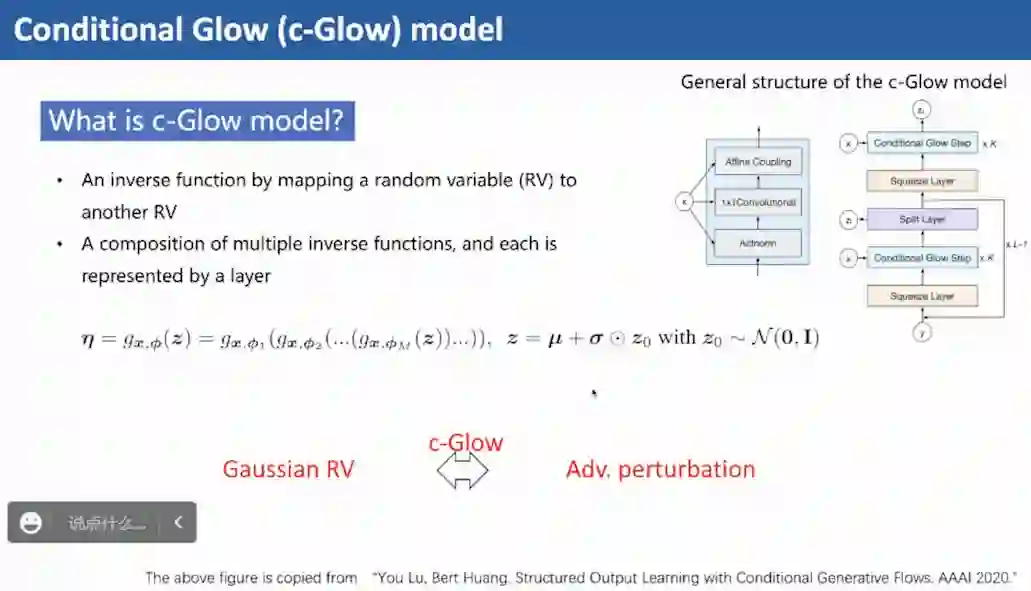

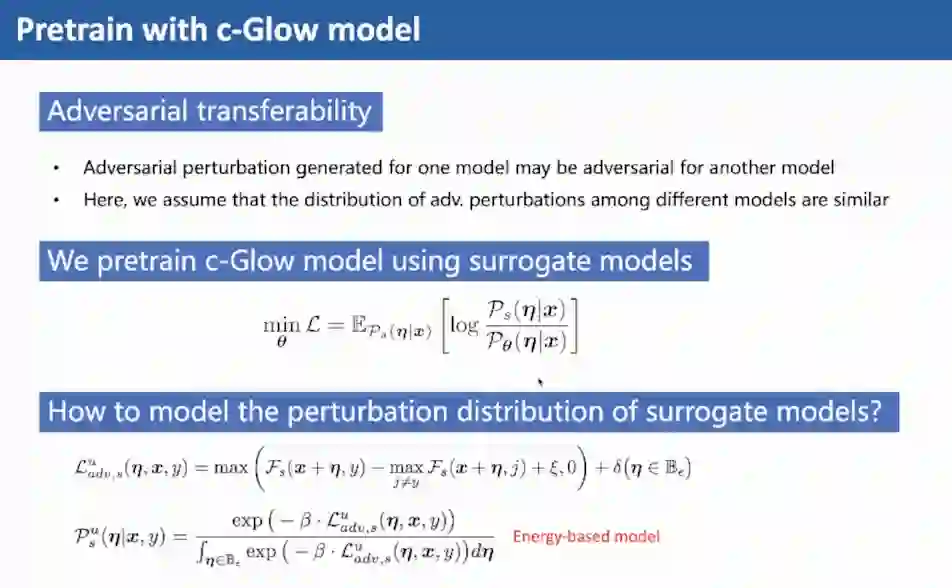

在基于置信度的攻击方法中,重要的问题在于如何建模对抗样本的分布,以及如何对替代模型的噪声分布进行建模

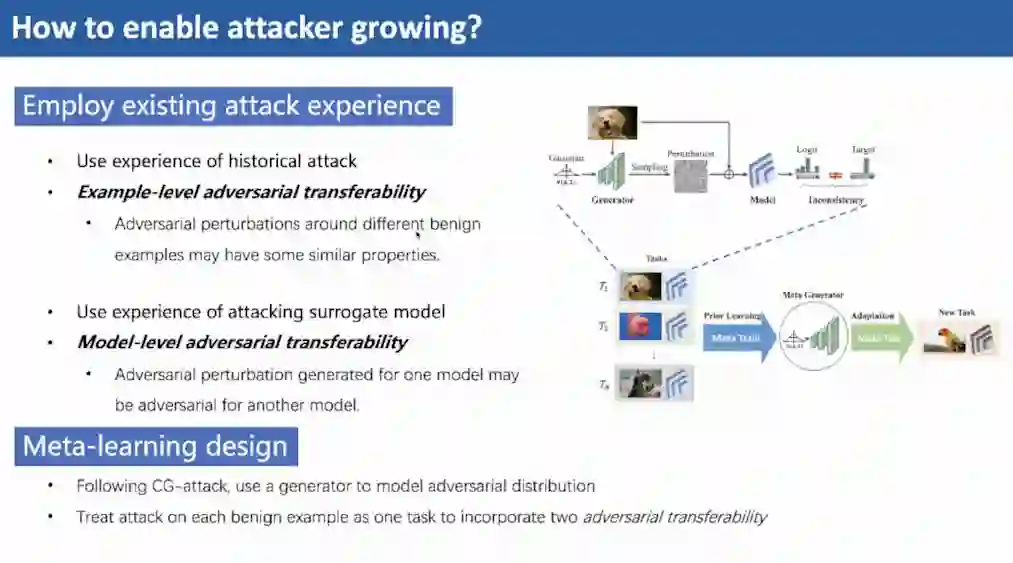

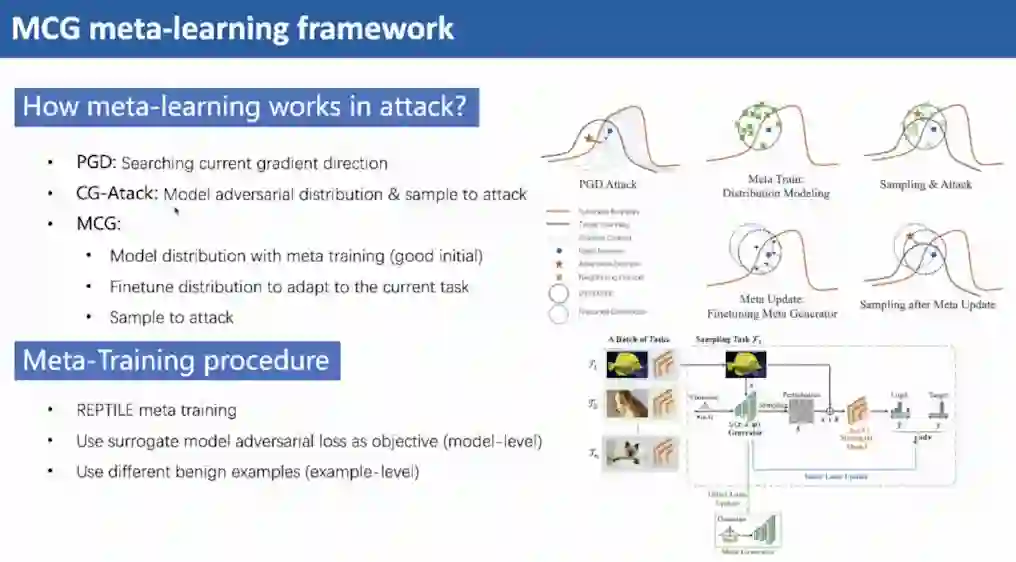

接下来,吴教授介绍了一种基于元学习的框架,可以有效提升模型的迁移能力。基本思想是利用元学习的方法,通过历史攻击结果提升攻击方的攻击能力

吴教授提出一种基于元学习的MCG方法,使用meta training对对抗样本的分布建模,并且将每次攻击当作一个新的任务,将当前分布对新的任务微调以提升攻击效果该工作发表在TPAMI 2022上。

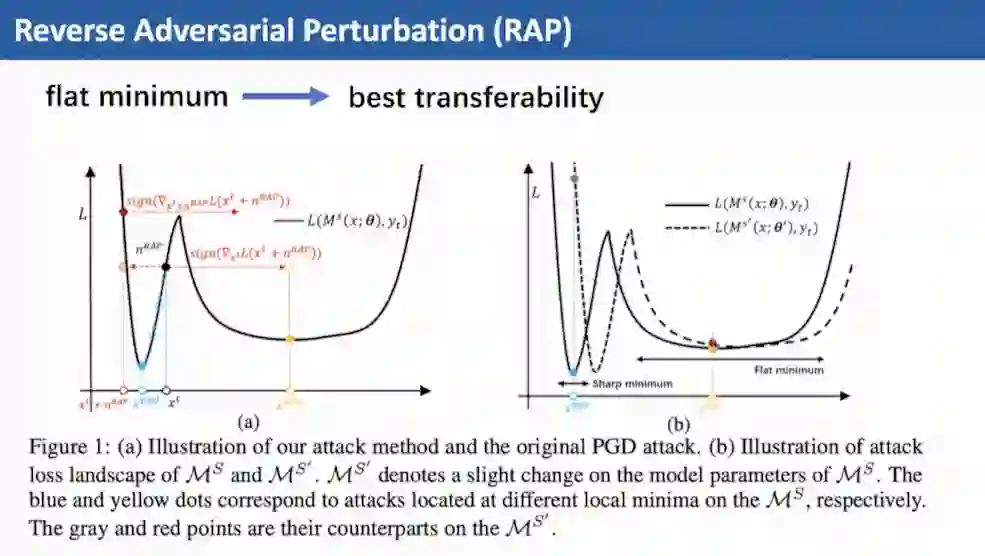

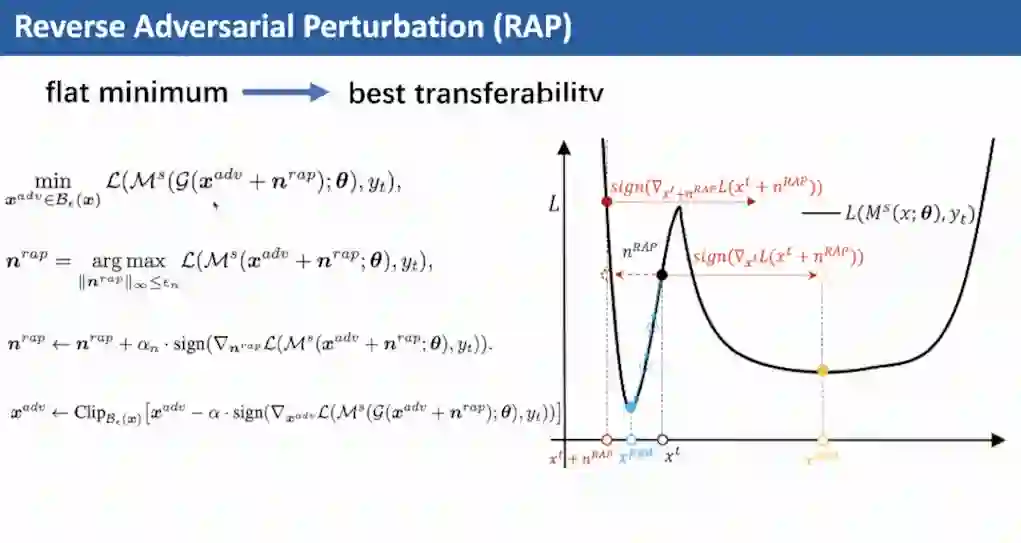

然后,吴教授介绍了一种可有效提升对抗迁移性的通用方法。不同的对抗样本迁移能力差别很大,在flat minimum区域迁移能力较高。

基于这一思路,吴教授提出改变迁移攻击的目标函数,在一个小的邻域内最大化包含对抗噪声的目标函数,更容易找到flat的区域,该方法可与现有的其他迭代攻击方法结合,实现更高的迁移攻击成功率。该工作发表在NeurIPS 2022上。

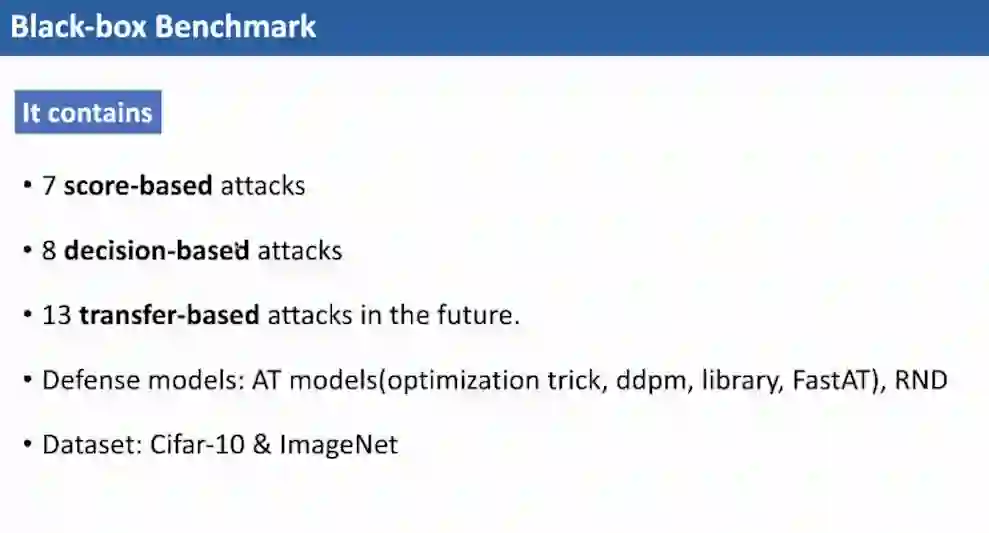

最后,吴教授介绍了一种可用于度量黑盒攻击方法性能的benchmark。这是一个整合了多种攻击方法的工具库,可以帮助人工智能安全领域的学习者快速入门。

这个工具库中包含了多种基于置信度和基于决策的攻击,未来将加入更多基于迁移的攻击。同时该工具库还整合了多种对抗防御方法,以及两个图像分类数据集。

问答环节

Q1

弹幕问题(针对韩教授介绍的决策攻击方法):为什么调整决策攻击的策略有这么显著的效果?

韩教授回答:原始的Boundary Attack忽略了决策攻击过程中根据攻击的进程对攻击策略进行调整。另外,决策攻击本身是一个迭代的过程,如果每次都从高斯噪声开始则忽略了上一轮采样的历史信息,但我们在实验中发现这对攻击效果影响很大,因为上一轮的攻击已经有了一个采样方向,对这种信息的忽略是一种浪费。

Q2

吴教授讨论:怎么看待目前基于查询的黑盒攻击方法分为Score-based 和 Decision-based 两类攻击方法的现状,这两种方法可以互相借鉴吗?

韩教授回答:这二者之间的结合确实是一个值得考虑的方向。这和transfer-based 与 decision-based 攻击相结合的思路不同,这二者结合的点在于transfer-based攻击的结果可以作为decision-based 攻击噪声压缩的起点。但是Score-based 和 Decision-based 两类攻击方法结合的点还不清楚,是很值得探索的一个方向。

Q3

吴教授讨论:攻击ViT相对于攻击CNN而言有什么独特的挑战?

韩教授回答:一开始投稿的时候审稿人也问过类似的问题,在黑盒设定下设计针对ViT的决策攻击本身就包含了一定的先验知识。从技术方面来说,挑战主要来自于ViT和CNN模型结构的差异,尤其是ViT将图像拆分成多个互不叠加的patch的操作,直接导致不同区域的噪声敏感度差异巨大。站在噪声压缩的角度,必须对不同的区域区别对待。另外,ViT使用的self-attention机制也阻碍了在少数像素上添加的噪声对最终决策结果的影响,这一点在CNN中是不存在的。

Q4

问题:有没有一种比较好的方式度量对抗样本到决策边界的距离?

韩教授回答:一开始讨论的安全半径就是一种度量对抗样本到决策边界的思路。因为这个问题可以转换为对模型能够容忍多少对抗噪声的度量。但是,直接使用对抗样本来度量这一距离是比较困难的,因为对抗噪声对于单个样本是特定的,而不同的对抗攻击方法在添加噪声的时候也都是特定的,沿着某个特定的方向,即使是决策攻击沿着特定方向采样的方法也都相对特定,很难找到一个均匀或一致的半径。所以在一开始讨论安全半径的时候我们也借鉴了高斯均匀的对抗半径作为桥梁,使用这个容易计算的半径及其与对抗的鲁棒半径之间的关系简介度量对抗样本与决策边界距离。这只是一种方式,一定有更好的度量的方式,还需要进一步的探索。