鱼与熊掌可以兼得:何恺明等人一统语义分割与实例分割

选自arXiv

作者:Alexander Kirillov、Ross Girshick、Kaiming He、Piotr Dollár

机器之心编译

参与:张倩、王淑婷

全景分割是很吸引人的主题,它结合语义和实例分割的优势构建更强大的方案。但目前大多数顶尖方法都分别用两个模型建模语义和实例分割两种任务,并最后将预测结果组合在一起。这种方法并不能利用两者间的交互信息提供更准确的预测,这样也就没什么意义了。在何恺明等研究者的这篇论文中,他们结合 Mask R-CNN 与 FCN 构建出一种新型的全景分割模型,这个统一的模型在两种任务间共享计算,并实现非常好的性能。

近年来,语义分割快速发展,这项任务是为每个像素分配一个类别标签。在最近的实例分割中,机器的任务是检测和分割每个目标实例。用于语义分割的全卷积网络(FCN)[39] 和实例分割的 Mask R-CNN[23] 等简单而强大的基线方法也促成了这些进展。这些方法概念上非常简单、快速、灵活,可以作为该领域许多后续进展的基础。本文作者的目标是提出一种类似的简单、单网络基线方法,用于全景分割 [29] 联合任务,该任务包含语义分割和实例分割。

尽管概念上非常直观,但设计一个针对两种任务准确率都很高的单个网络非常困难,因为在两种任务上表现最好的方法都存在着许多差异。语义分割任务中占领榜单 [17, 14] 的网络是 FCN,它拥有由空洞卷积增强的特殊主干 [55, 10]。在实例分割任务中,带有特征金字塔网络(FPN)[34] 主干的基于区域的 Mask R-CNN [23] 成为解决几个棘手识别难题 [35, 58, 41] 的基础。尽管已经有研究者尝试统一语义分割和实例分割 [44, 1, 9],但鉴于它们同时训练但基准测试各自独立的特性,目前为实现各自最佳性能所必需的专门化可能是不可避免的。

由于这些顶尖方法存在架构上的差异,有人可能认为在设计用于两个任务的单个网络时牺牲其中一个的准确率是必须的。但是,本文作者提出了一种简单、灵活的高效架构,在两种任务中都能利用单个网络取得很高的准确率,这个网络可以同时生成基于区域的输出(实例分割)和像素密集的输出(语义分割)。

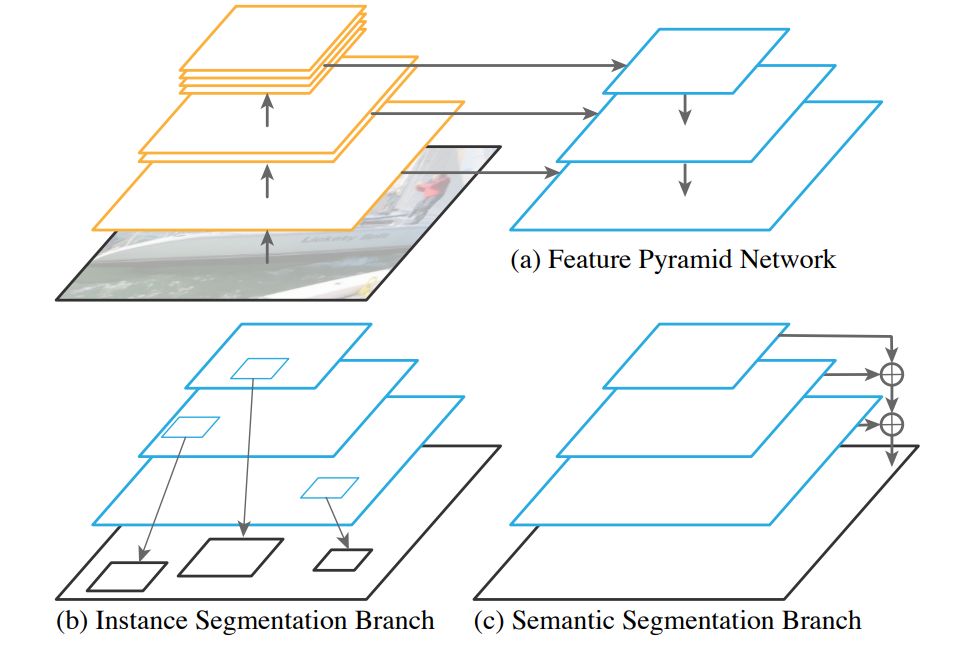

该方法从实例级识别 [23] 中流行的 FPN[34] 主干入手,并添加了一个分支,用于并行执行语义分割和现有的基于区域的实例分割分支(见图 1)。作者在添加密集预测分支时没有改变 FPN 的主干,使其能够兼容现有的实例分割方法。本文提出的方法名为全景 FPN,因为它可以通过 FPN 同时进行实例分割和语义分割,在给定 Mask R-CNN 框架的情况下非常容易实现。

图 1:全景 FPN:(a)作者从目标检测中广泛用于抽取丰富的具有多尺度特征的 FPN 主干入手。(b)在 Mask R-CNN 中,作者在 FPN 上利用基于区域的分支进行实例分割。(c)同时,作者在同样的 FPN 特征上添加了轻量级密集预测分支用于语义分割。利用 FPN 进行的 Mask RCNN 简单扩展使其对两个任务来说都是快速、准确的基线。

虽然全景 FPN 是 Mask RCNN 利用 FPN 进行的简单扩展,但适当训练两个分支来同时进行基于区域和密集像素的预测对于结果的优劣至关重要。作者在合二为一的网络中进行了细致的研究,以平衡两个分支的损失、高效构建小批量、调整学习率计划及实现数据增强。作者还探索了用于语义分割分支的多种设计(其它网络组成部分都按照 Mask R-CNN 设计)。总体来看,尽管该方法对于准确的设计选择是鲁棒的,但用适当的方法解决这些问题才是取得良好结果的关键。

单独为每个任务训练时,本文方法在两个数据集(COCO 和 Cityscapes)的实例分割和语义分割方面都取得了极好的结果。在实例分割中的结果不出所料,因为该方法在此案例中等效于 Mask R-CNN。而在语义分割中,附加在 FPN 上的这一简单密集预测分支产生的准确率却足以匹敌基于空洞卷积的最新方法(如精心设计的 DeepLabV3+)。

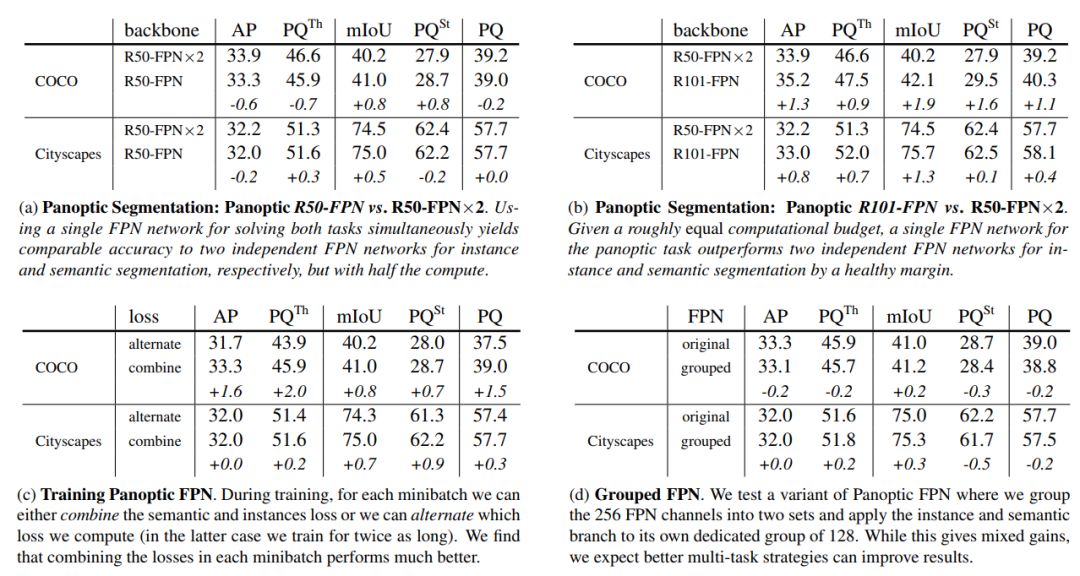

对于全景分割,作者证明了通过适当的训练,可以使用单个 FPN 来同时解决两个任务(语义分割和实例分割),且产生的准确率相当于训练两个单独的 FPN,而所需的计算量仅为一半。计算量相同的情况下,用于两个任务的联合网络远远优于两个单独的网络。全景分割结果示例如图 2 所示。

图 2:使用单个 ResNet-101-FPN 网络在 COCO 数据集(上)和 Cityscapes 数据集(下)上的全景 FPN 结果。

全景 FPN 具有高效的存储和计算能力,在 Mask R-CNN 上所需花费甚少。通过避免使用开销很高的空洞卷积,该方法可以使用任何标准的顶级主干(如大型 ResNeXt)。作者认为,该方法的灵活性、快速训练能力和推断速度将有利于未来的全景分割研究。

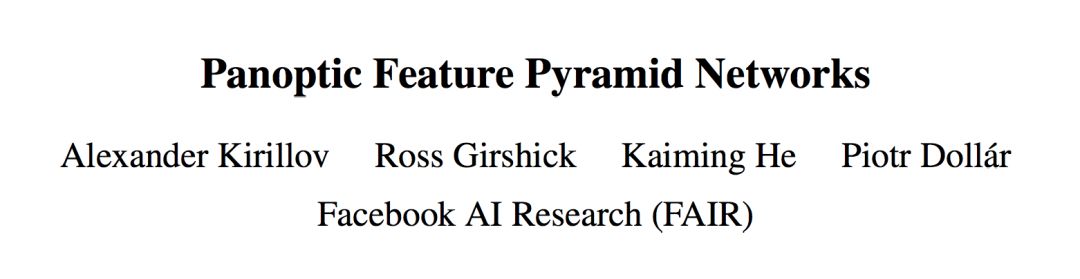

在 2017 年的 COCO Stuff Segmentation 挑战赛中,作者获得第一名时使用的是其模型的初始版本(仅语义分割分支)。然后该单分支模型被采用和泛化至 2018 COCO & Mapillary 挑战赛的几个项目中,充分展示了其灵活性和有效性。作者希望本文提出的联合全景分割基线将同样有效。

论文:Panoptic Feature Pyramid Networks

论文地址:https://arxiv.org/abs/1901.02446v1

摘要:最近引入的全景分割任务再次激发了社区统一实例分割和语义分割任务的兴趣。然而,当前针对这一联合任务的最佳方法使用的是各自独立的不同网络,这些网络进行实例分割和语义分割,但并不执行任何共享计算。在本文中,作者的目标是在架构层面统一这些方法,设计单个网络来解决两个任务。本文提出的方法通过使用共享的特征金字塔网络 (FPN) 主干,给 Mask R-CNN(流行的实例分割方法)添加了语义分割分支。令人惊讶的是,这个简单的基线不仅对实例分割有效,而且还产生了一种轻量级的、性能最佳的语义分割方法。在本文中,作者对这种带有 FPN 的 Mask R-CNN(称之为全景 FPN)最小扩展版本进行了详细研究,发现对两项任务来说,它都是鲁棒又准确的基线。由于这种方法概念简单且有效,作者希望该方法可以作为强大的基线,助力未来的全景分割。

3.1 模型架构

特征金字塔网络:FPN 采用具有多种空间分辨率特征的标准网络(如 ResNet [24]),并增加了一条具有横向连接的自上而下的轻型路径。

实例分割分支:FPN 的设计,尤其是所有金字塔级别使用相同的通道尺寸,使连接基于区域的目标检测器(如 Faster R-CNN)变得更加简单。

全景 FPN:如上所述,本文的方法是用 FPN 修改 Mask R-CNN,以实现像素级语义分割预测。

语义分割分支:为了根据 FPN 特征生成语义分割输出,作者提出了一个简单的设计——将来自 FPN 金字塔所有级别的信息合并至单个输出中。

图 3:语义分割分支。每个 FPN 级别(左)通过卷积和双线性上采样进行上采样,直到大小变为 1/4(右),然后将这些输出相加,最后转换成像素输出。

4. 实验

表 1:使用 FPN 的语义分割。

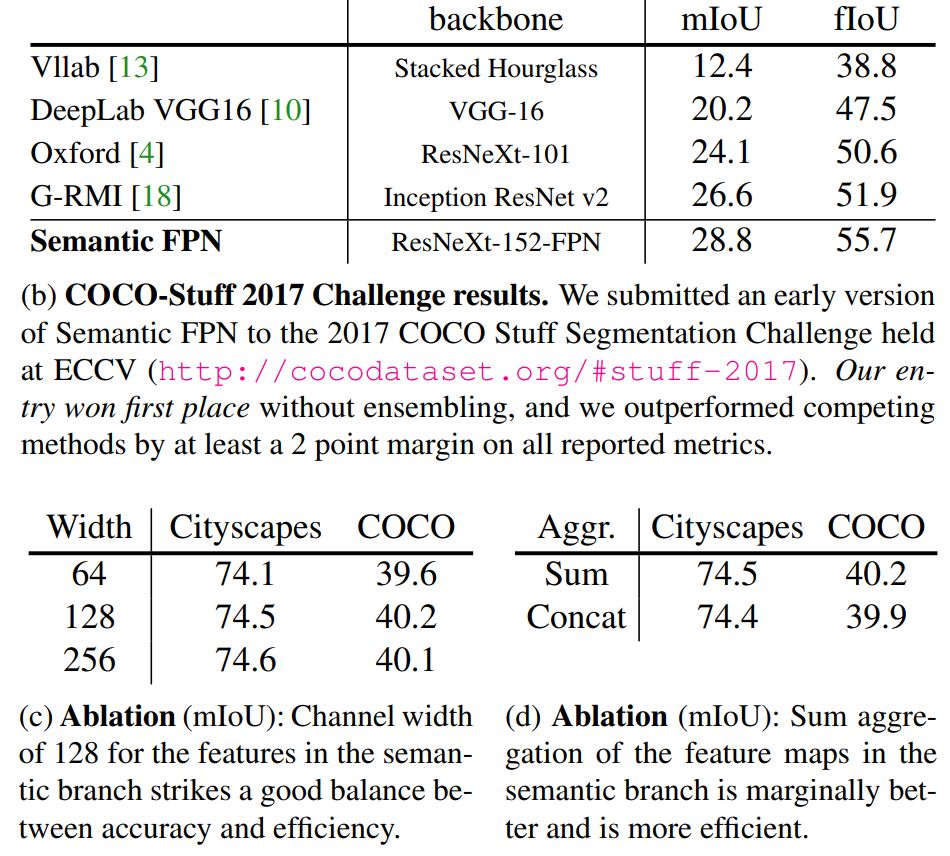

表 2:多任务训练:(a,b) 在单任务基线上增加一个语义分割分支并适当调整λs(加粗部分),能够略微改善实例分割的结果。注意,λs 是指分配给语义分割损失的权重,λs=0.0 作为单任务基线。(c,d) 在单任务基线上增加一个实例分割分支并适当调整λi(加粗部分),能够给语义分割带来更大改善。和之前一样,λi 是指分配给实例分割损失的权重,λi = 0.0 被用作单任务基线。

表 3:全景 FPN 结果。

图 6:使用单个 ResNet-101-FPN 网络在 COCO 数据集(上)和 Cityscapes 数据集(下)上的更多全景 FPN 结果。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com