新书速递-《自动化机器学习:方法,系统和挑战》-免费下载

在过去十年中,机器学习研究和应用激增;特别是深度学习方法已经在许多应用领域取得了重要进展,例如计算机视觉、语音处理和游戏。然而,许多机器学习方法的性能对需要过多的设计的决策场景非常敏感,这对新用户构成了相当大的障碍。在蓬勃发展的深度学习领域尤其如此,人类工程师需要选择正确的神经网络、训练过程、正则化方法和所有这些组件的超参数,以使他们的网络以足够的性能完成他们应该做的事情。每个应用程序都必须重复这个过程。即使是专家也经常会遇到繁琐的反复试验,直到他们为特定的数据集找到一套好的选择。

自动机器学习领域旨在以数据驱动、客观和自动的方式做出这些决定:用户只需提供数据,自动机器学习系统自动确定最适合这一特定应用的方法。因此,AutoML使那些对应用机器学习感兴趣但没有资源来详细了解机器学习背后技术的领域科学家可以使用最先进的机器学习方法。这可以被看作是机器学习的民主化:有了AutoML,定制的最先进的机器学习触手可及。

正如我们在这本书里所展示的,自动学习方法已经足够成熟,可以与人类机器学习专家匹敌,有时甚至超越他们。简而言之,AutoML可以提高性能,同时节省大量的时间和金钱,因为机器学习专家既难找又昂贵。因此,近年来,人们对AutoML的商业兴趣急剧增长,一些主要的科技公司正在开发他们自己的AutoML系统。然而,我们注意到,开源自动学习系统比专有付费黑匣子服务更有利于机器学习民用化的目的。

这本书概述了AutoML领域的快速发展。由于社区当前对深度学习的关注,一些研究者现在错误地将自动学习等同于神经架构搜索的主题;但是当然,如果你正在读这本书,你会知道—虽然网络连接存储是自动存储的一个很好的例子—但是自动存储比网络连接存储有更多的优点。这本书旨在为有兴趣开发他们自己的自动化方法的研究人员提供一些背景和出发点,为那些想把自动化应用到他们的问题上的从业者强调可用的系统,并为已经在自动化领域工作的研究人员提供一个最新的视角。这本书分为三个部分,分别论述了AutoML的这些不同方面。

本书内容概述

第1部分:自动方法

这一部分包括关于所有AutoML系统背后共同基础的最新概述章节。

第1章:超参数优化

第2章:元学习

第3章:神经架构搜索

第2部分:自动化系统

本部分包括对各种可用的自动学习系统的深入描述,这些系统可用于开箱即用的有效机器学习。

第4章:Auto—WEKA。

第5章:Hyperopt-Sklearn

第6章:Auto-Sklearn:高效和健壮的自动机器学习

第7章:Auto-Net:面向自动调节的神经网络

第8章: TPOT :自动化机器学习的工具

第9章:自动统计学

第3部分:自动挑战

本部分深入分析了迄今为止面临的所有自动挑战。

第10章: 2015-2018 AutoML挑战赛系列分析

书籍pdf下载地址

公众号中回复关键字“auto19”获取

Duang,Duang,Duang!!!深度学习与NLP成立知识星球了。

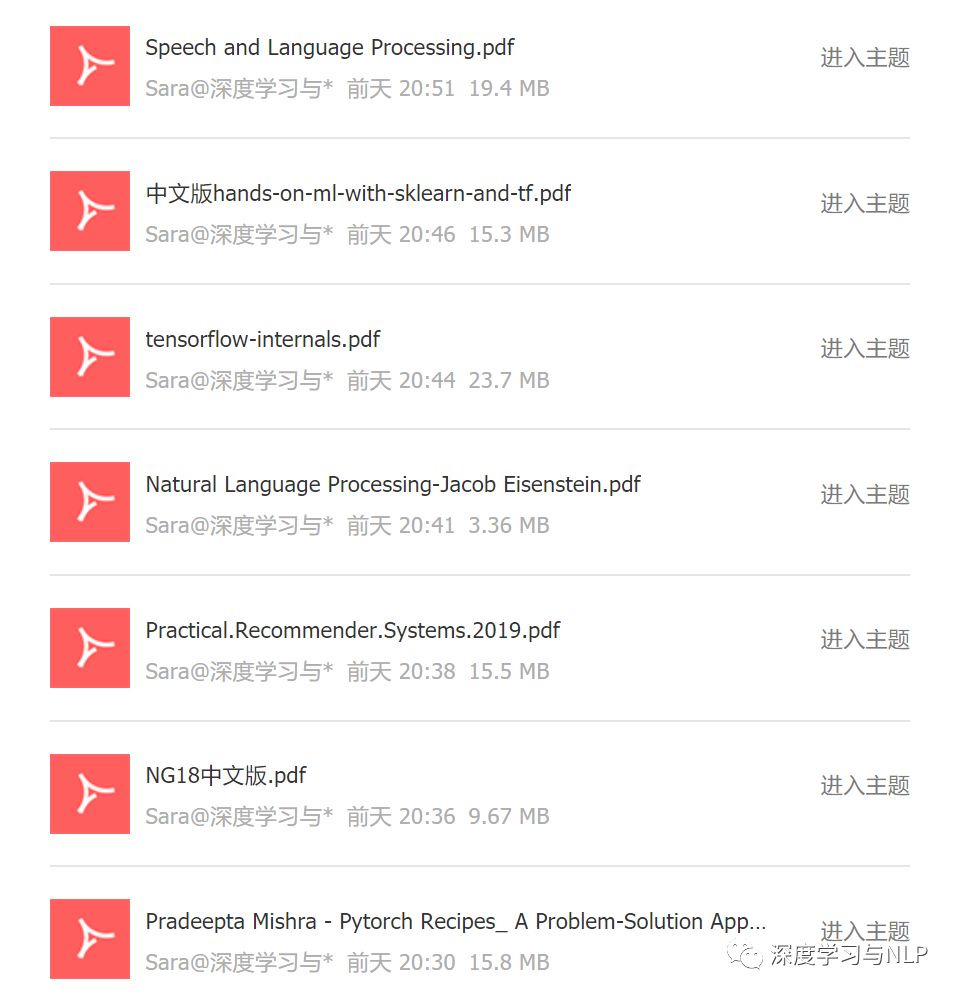

在这里不仅有行业内的大牛可以相互交流,学习。还会不定期分享深度学习、机器学习、自然语言处理等AI前沿技术相关的免费书籍,比如:

以及,国内外最新的前沿课程视频课程、重要的数据资源、前沿的论文等。

还在等什么,扫描下方二维码加入我们吧。

往期精品内容推荐

UC Berkeley《人工智能基础-2018》课程及视频教程(带中英文字幕)分享

DeepLearning_NLP

深度学习与NLP

商务合作请联系微信号:lqfarmerlq