ACL 2019开源论文 | 句对匹配任务中的样本选择偏差与去偏方法

作者丨张冠华

单位丨腾讯实习生 & 哈工大本科生

研究方向丨自然语言处理

导读

句对匹配 (Natural Language Sentence Matching,NLSM) 任务是指给定两个句子,判断它们的关系。常见的自然语言处理任务如 Paraphrase Identification 和 Natural Language Inference 都属于句对匹配的范畴。

在本文中,我们调研了六个 NLSM 数据集,发现这些数据集中广泛地存在一种样本选择偏差 (Selection Bias),以致于只使用三种和语义完全无关的特征,就可以在一些数据集上达到和 LSTM 差不多的准确率,这些特征被称为泄漏特征 (Leakage Feature)。

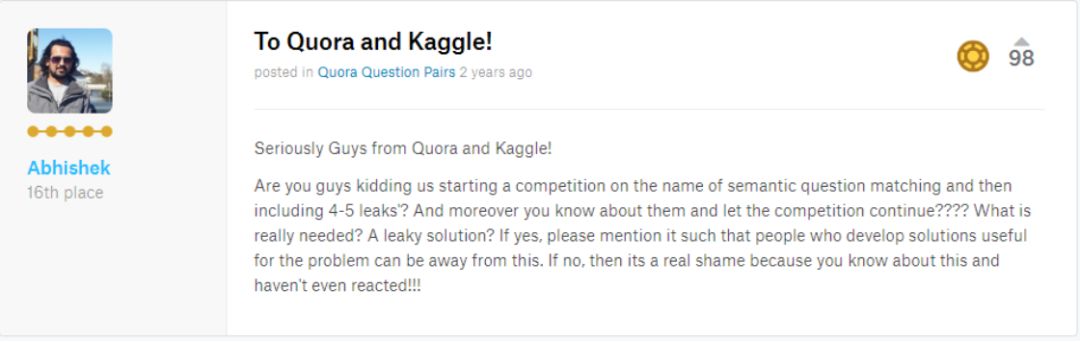

事实上, Leakage Feature 在 Kaggle 的各种比赛中早已受到了广泛的关注。在 Quora 官方在 Kaggle 上举行的比赛 Quora Question Pairs [1] 中,排名前列的模型中全部都用到了 Leakage Feature。而在 WSDM - Fake News Classification [2] 的数据集中,Leakage Features 也有很强的预测能力。

虽然 Leakage Feature 的预测能力很强,但是这些特征中的模式只是数据集构造过程中人工引入,在真实世界中不可推广。所以在比赛的讨论区中,Kaggle Grandmaster,boost.ai 的首席数据科学家 Abhishek 就曾质问比赛的严肃性。

本文探究了 Leakage Feature 的产生原因和其对深度模型的影响,并提出了一种不需要任何额外资源的去偏训练、评估方法,实验证明我们的方法能提升模型的真实泛化能力并提供更可靠的评估结果。

问题定义

句对匹配中的Leakage Features

在本文中我们定义的三个 Leakage Feature 分别是:

句子 1 在数据集中出现的次数 S1_freq

句子 2 在数据集中出现的次数 S2_freq

在数据集中与句子 1 和句子 2 都比较过的句子数量 S1S2_inter

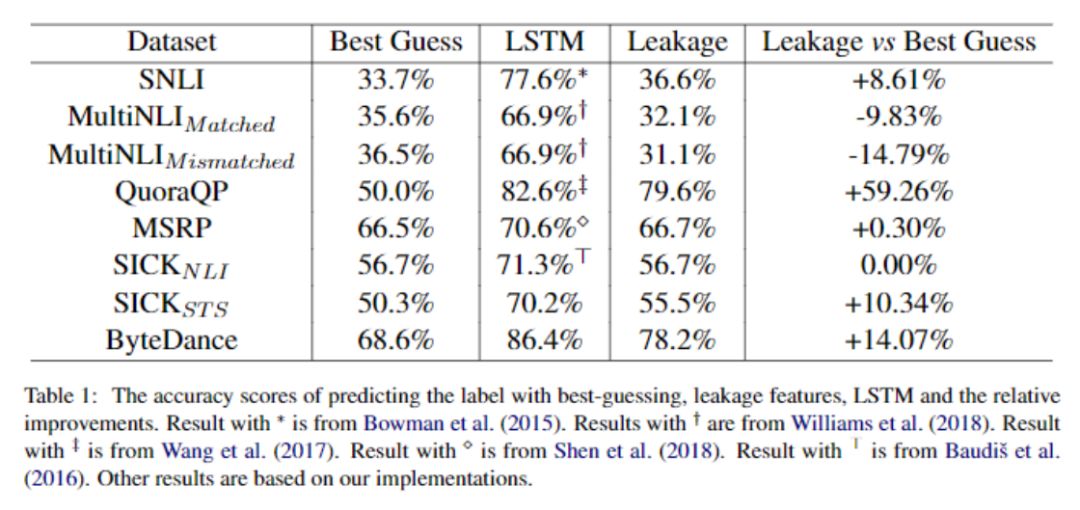

从表 1 可以看出,六个数据集中有四个都不同程度的受到 bias的影响。在 QuoraQP 上,只使用三个 Leakage Feature 甚至可以达到和 LSTM 差不多的结果。

这三个 Leakage Features 能有这么强的预测能力,本质上反映的是数据集中的 Selection Bias。

什么是 Selection Bias?

Selection Bias 指的是在数据采样过程中由于遵循了某种非随机的采样策略而导致的偏差,这导致采样出的数据相对于真实数据并不具有代表性。比如当我们想调查国民人均受教育程度的时候,如果只在大学里发调查问卷,那么得出的结论就是国民人均受教育程度都是本科以上。

而在句对匹配任务中,为什么会产生 Selection Bias 呢?我们结合 SNLI 和 QuoraQP 的数据集准备过程进行了合理的推断。

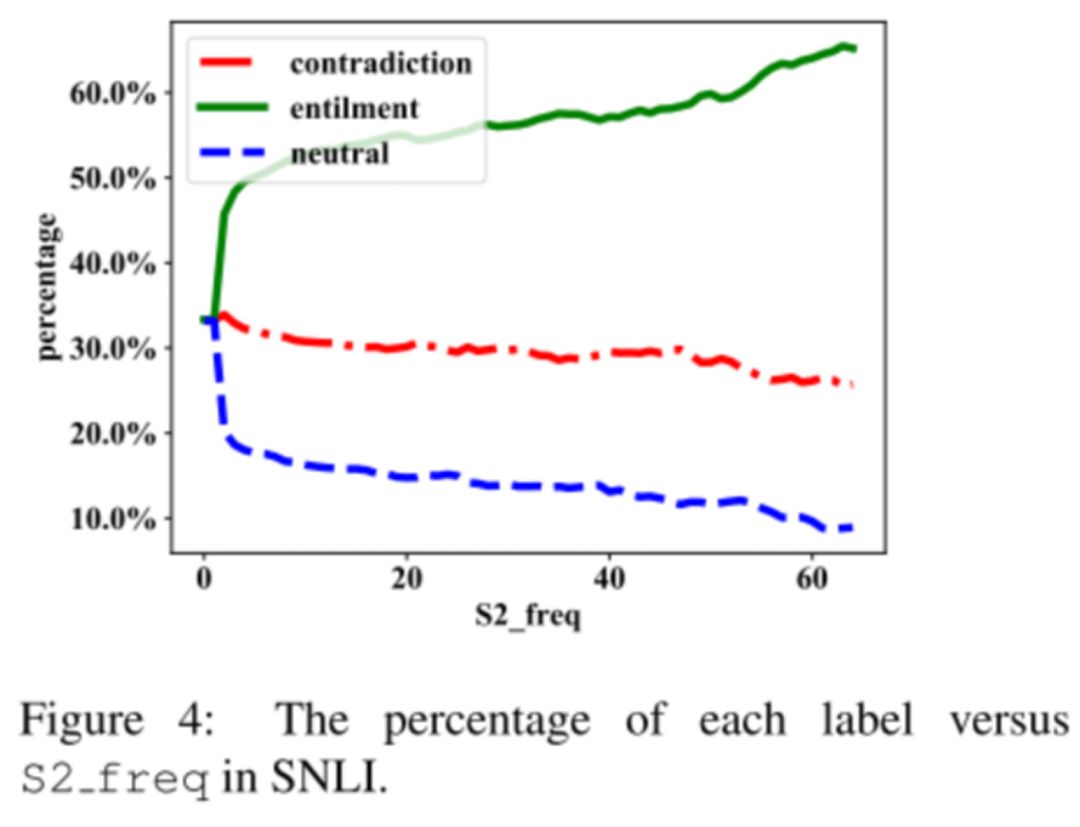

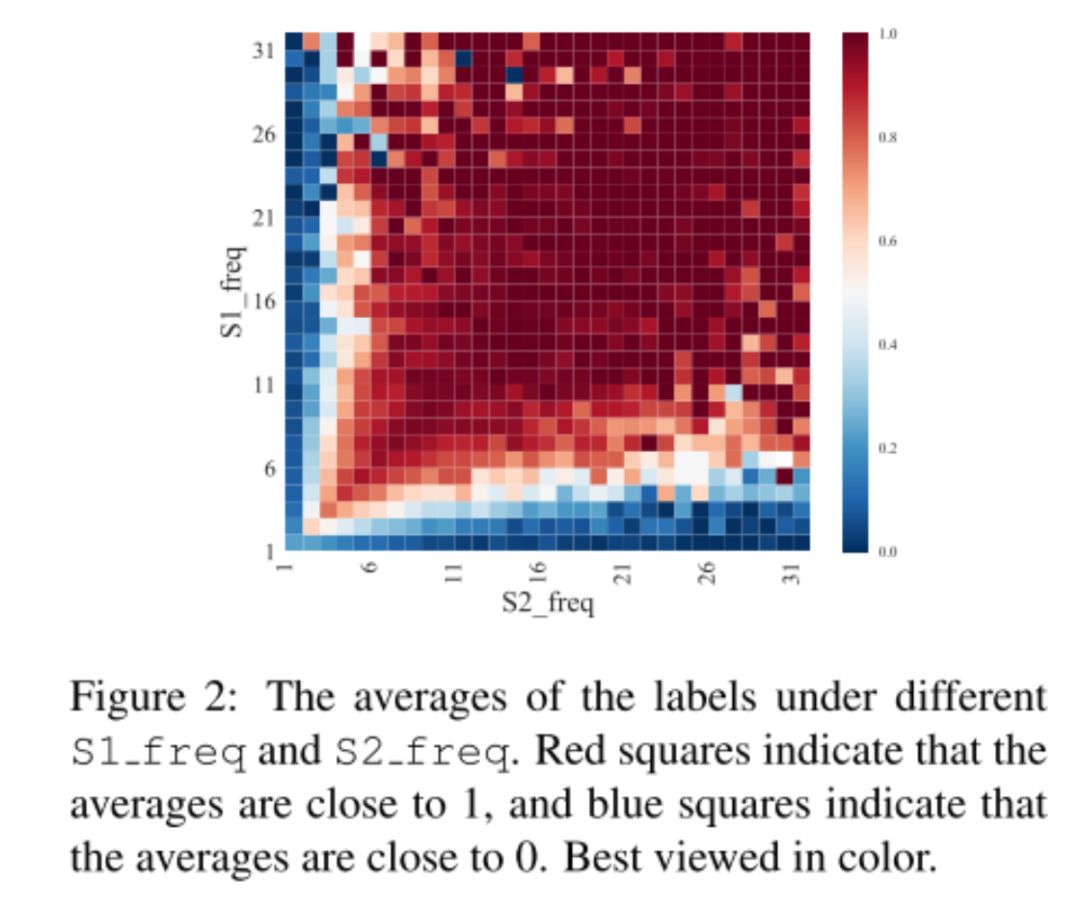

在 SNLI 的准备过程中,标注工人们需要根据给定的“句子 1” (premise scene descriptions) 为三种标签分别写一个“句子 2”。而在这个过程中发现,工人们会根据标签重复使用一些句子来做"句子 2",我们推测正是这种“复用”的操作导致了 SNLI 有偏。如下图,我们可以发现在 SNLI 中,随着 S2_freq 的增大,标签变得更倾向于是 Entailment。

在 QuoraQP 的准备过程中,数据集的准备者们提到:

我们最初的采样方法返回了一个很不均衡的数据集,其中正例多过负例。因此我们补充了一些负样本进去,其中负样本的一个来源是“相关问题”。

这种“补充负样本”的操作可能就是 QuoraQP 有偏的原因,我们推测这些后添加进去的句子可能只在数据集中出现了很少的次数,从下图我们可以看出,在 QuoraQP 中,当句子 1 和句子 2 出现次数都很多的时候,标签倾向于为 1;而当有一个句子出现次数很少的时候,标签则倾向为 0。

数据集有偏会带来什么影响?

我们的实验表明模型能捕捉到这种 bias,而这会导致以下两个结果:

模型的评估结果“虚高”,因为 Bias 在原始的测试集中有很强的预测能力。

模型的真实泛化能力下降,因为这种 bias 是不可推广的。

去偏方法

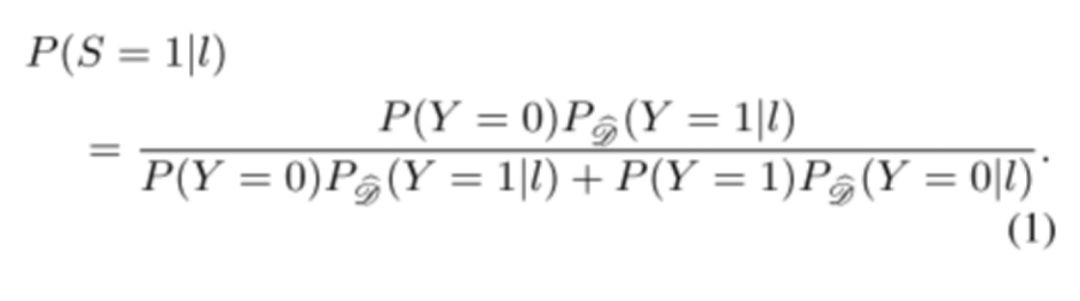

首先我们定义了一个 Leakage-Neutral 分布为 X×A×Y×S,其中 X 是语义特征空间,Y 是语义标签空间,L 是采样策略特征空间,S 是采样意图空间。S 表示数据集准备者在采样时想要选择的样本标签。比如 S=1,代表准备者想采一个正样本。

我们假设,在数据集准备过程中,对于每个样本 (x,y,s,l),如果 s=y,则该样本被采进数据集,否则该样本被丢掉。通过这种方式,产生了现有的有偏的数据集分布。

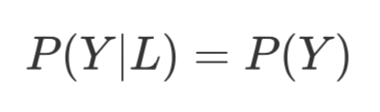

我们对 Leakage-Neutral 分布的定义有以下假设,第一个假设是 Leakage-Neutral 假设:

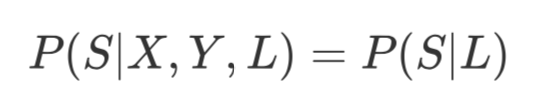

这个假设表明在 Leakage-Neutral 分布中,采样决策变量 L 和标签 Y 无关,这也使得 Leakage-Neutral 分布更贴近真实分布。第二个假设是:

这表明采样意图变量 S 由采样决策变量 L 完全决定。

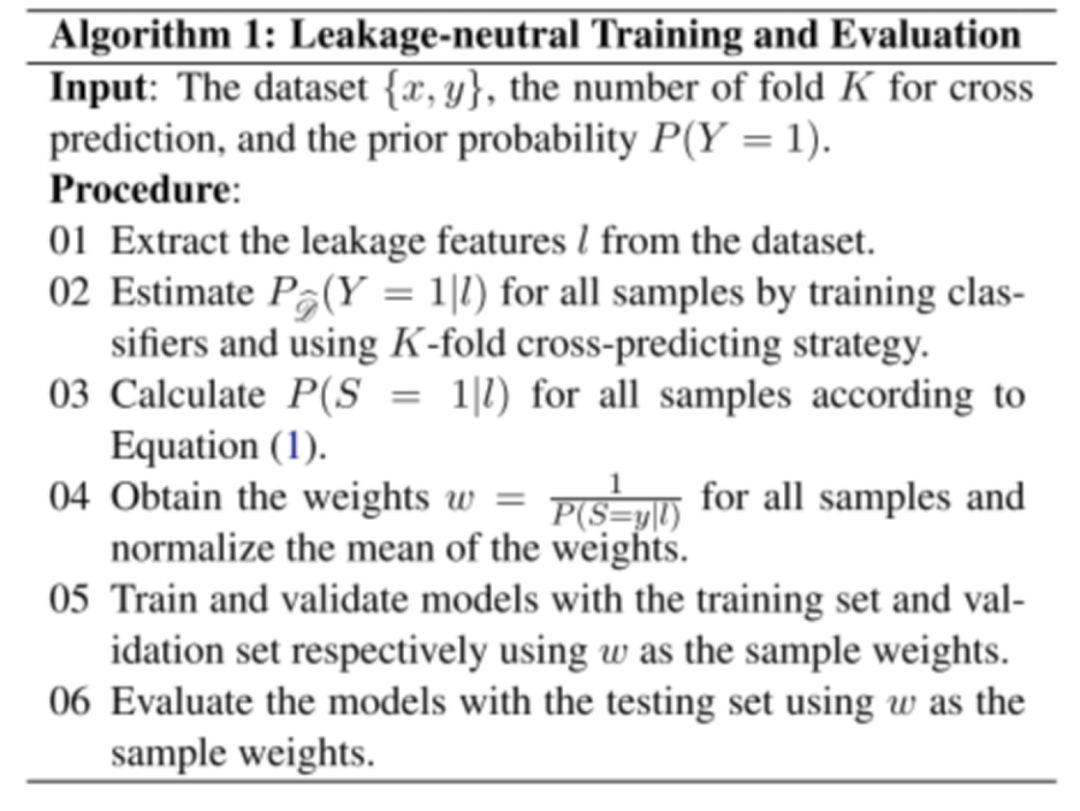

我们证明,通过对模型在训练和评估的时候添加适当的 sample weight,可以等价于在 Leakage-Neutral 分布中训练和评估。算法的流程图如下,指的是原本有偏数据集的分布,具体证明见论文。

在实践中,我们用随机森林 100 折交叉预测来估计

实验结果

不失一般性,在论文中,我们以 QuoraQP 为分析对象。QuoraQP 是一个二标签文本对匹配数据集,旨在判断给定的两句话语义上是否重复(重复为 1,不重复为 0)。

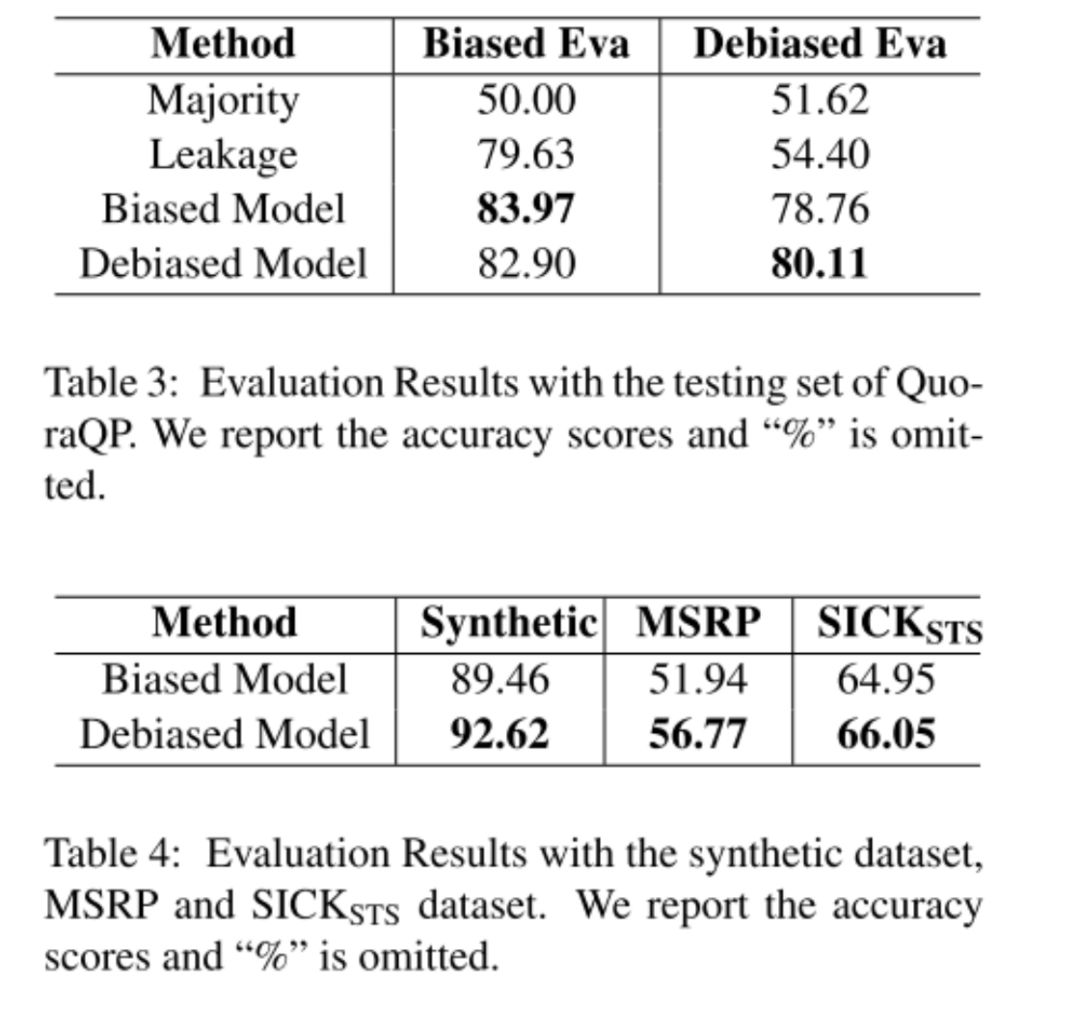

我们把在原有偏数据集中正常训练的模型叫 Biased Model,把加权训练的模型叫 Debiased Model。在有偏的测试集中正常测试的结果叫 Biased Eva,加权测试的结果叫 Debiased Eva。

如图三所示,Debiased Model 在有偏评估中低于 Biased Model,这是因为 bias 在原测试集中有预测能力。而在加权评估中 Debiased Model 高于 Biased Model,这是因为加权测试中 bias pattern 没有预测能力,当模型捕捉到 bias 并利用其进行预测,这实际上会起负作用。

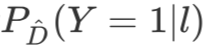

如图四所示,加权训练的模型在合成数据集、MSRP、SICK 中均有更好的预测能力,说明我们的方法能有效降低 bias 的影响,提升模型的真实泛化能力。

总结

在本文中,我们调研了六个 NLSM 数据集,发现这些数据集中广泛地存在一种样本选择偏差,以致于只使用三种和语义完全无关的特征,就可以在一些数据集上达到和 LSTM 差不多的准确率,针对这种偏差,我们提出了一种不需要任何额外资源的去偏训练、评估方法,实验证明我们的方法能提升模型的真实泛化能力并提供更可靠的评估结果。

相关链接

[1] https://www.kaggle.com/c/quora-question-pairs/overview

[2] https://www.kaggle.com/c/fake-news-pair-classification-challenge/overview

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文 & 源码