![]()

本届 ICML 会议已接近尾声,本届会议大家最关注的最佳论文、最佳论文提名、时间检验论文也已公布,而在未获奖的论文中有哪些被大家关注的好论文呢?

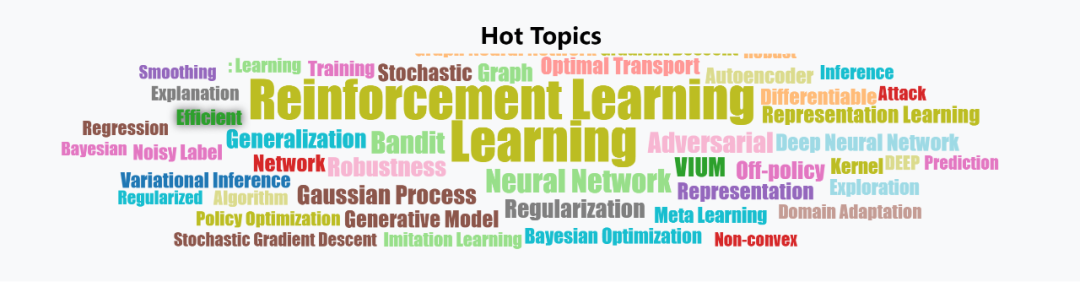

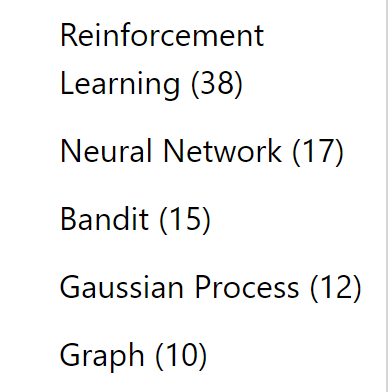

AMiner ICML 顶会系统统计了本次会议论文中出现频率较多的关键字,评估了本次会议中的热门方向,并可将不同类别的论文按引用量排序。依据 AMiner 系统,让我们来看看本次会议的热门话题与其中最受关注的论文吧。

热门主题

![]()

根据对入选论文标题的关键词分析,入选前10的热门话题为:强化学习,神经网络,Bandit,高斯过程,图,表示,最优输运,网络,随机性,表示学习。

![]()

![]()

利用 Aminer 按主题搜索论文及各个主题下论文按引用量排序的功能,我们可以轻松找到本次会议不同主题中那些受研究者关注的热点论文。让我们来看看不同主题的热点论文有哪些吧!

![]()

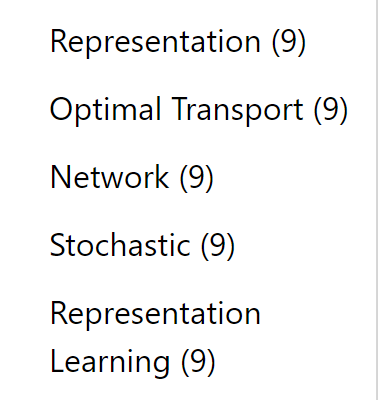

Skew-Fit: State-Covering Self-Supervised Reinforcement Learning

作者:

Vitchyr H. Pong

,

Murtaza Dalal

,

Steven Lin

,

Ashvin Nair

,

Shikhar Bahl

,

Sergey Levine

简介:在标准强化学习中,每一项新技能都需要一个手动设计的奖励函数,这需要大量的人工努力和工程设计。自我监督的目标设定有可能使这个过程自动化,使代理能够提出自己的目标并获得实现这些目标的技能。然而,这类方法通常依赖于手动设计的目标分布,或启发式,以迫使代理探索广泛的状态。作者提出了一个正式的探索目标,以达到目标的政策,最大限度的态覆盖。作者证明了这个目标等价于目标分布的熵最大化和目标达成性能的最大化,其中目标对应于整个状态。作者提出了一种学习这种最大熵目标分布的算法,并证明了在一定的正则性条件下,本文的方法在可能的状态集合上收敛到一个均匀分布,即使事先不知道这个集合。倾斜拟合使自监督代理能够自主选择和实践不同的目标。实验表明,它可以从图像中学习各种操作任务,包括用真正的机器人开门,完全从零开始,而且不需要任何人工设计的奖励功能。

![]()

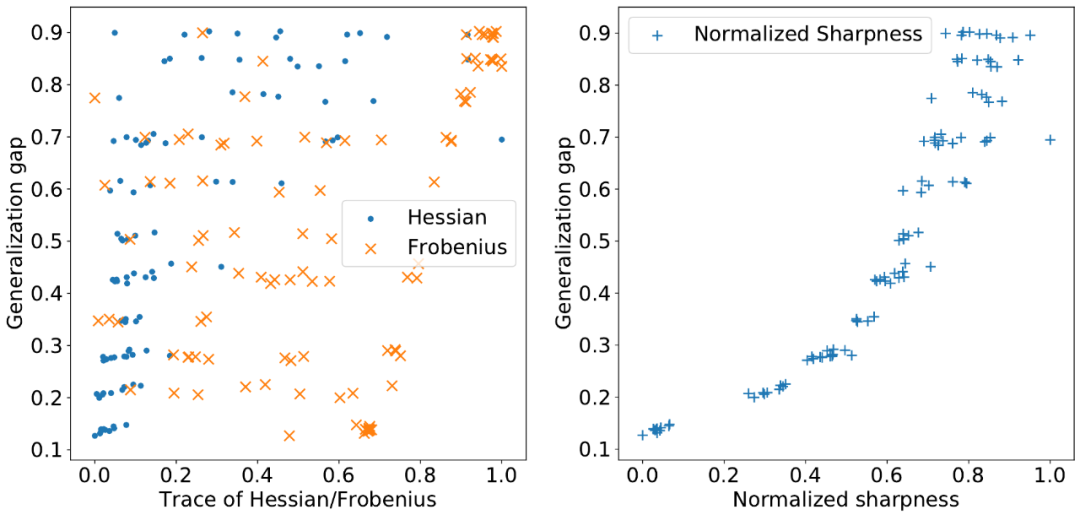

Normalized Flat Minima: Exploring Scale Invariant Definition of Flat Minima for Neural Networks using PAC-Bayesian Analysis

作者:Yusuke Tsuzuku,

Issei Sato

,

Masashi Sugiyama

简介:平面最小值的概念在深度学习模型的泛化研究中起着关键作用。然而,现有的平面度定义对参数的重定标敏感。这一问题表明,先前对平坦度的定义可能不是一个很好的泛化度量,因为泛化对于这种重定标是不变的。本文从 PAC-Bayesian 的观点出发,详细讨论了关于平坦极小的讨论,并引入了规范化平坦极小的概念,它不存在已知的尺度依赖性问题。此外,作者强调了现有的基于矩阵范数的泛化误差界的尺度依赖性,类似于现有的平面极小定义。本文修改过的平坦性概念也没有受到不足的影响,这表明它可能在假设类中提供更好的层次结构。

Reinforcement Leaning in Feature Space: Matrix Bandit, Kernels, and Regret Bound

作者:Lin F. Yang,

Mengdi Wang

简介:强化学习(RL)的探索在状态-行为空间较大时会遭受维数灾难。通常的做法是使用给定的特性参数化高维值和策略函数。然而,现有的方法要么没有理论上的保证,要么在规划期内遭受指数级的遗憾。在本文中,作者提出了一种在线 RL 算法,即 MatrixRL,它利用线性 bandit 的思想来学习概率转移模型的低维表示,同时谨慎地平衡开发-勘探的权衡。

![]()

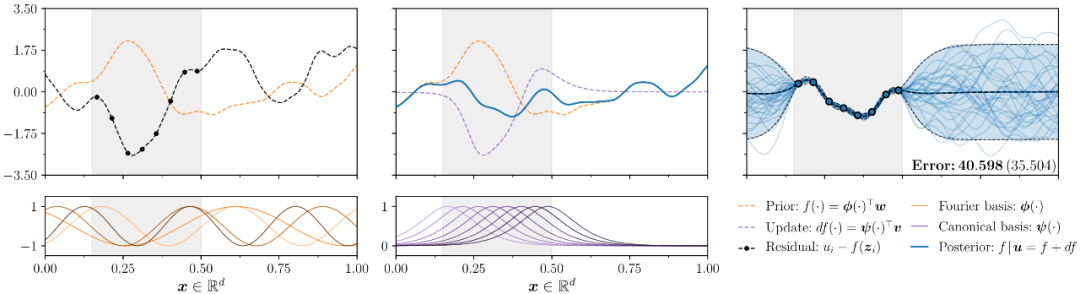

Efficiently Sampling Functions from Gaussian Process Posteriors

作者:Wilson James T,Borovitskiy Viacheslav,Terenin Alexander,Mostowsky Peter,

Deisenroth Marc Peter

机构: 伦敦帝国理工学院,圣彼得堡州立大学,伦敦大学学院

简介:高斯过程是许多真实世界建模问题的黄金标准,尤其是在模型的成功取决于它忠实地表示预测不确定性的能力的情况下。这些问题通常作为更大框架的一部分而存在,其中感兴趣的数量最终通过对后验分布的积分来定义。然而,这些算法的内部工作很少允许闭合形式的积分,因此需要蒙特卡罗方法。尽管在将高斯过程扩展到大型训练集方面取得了长足的进展,但是从其后验分布精确地生成绘图的方法仍然是在测试位置的数量上按立方体进行缩放的。作者确定了高斯过程的分解,通过使我们能够有效地生成精确表示其后验的函数,自然地有助于可伸缩采样。基于这种因式分解,作者提出了一种简单易用、通用的快速后验抽样方法——解耦抽样法。解耦采样是一种下降策略,它与高斯过程的稀疏近似无缝配对,以在训练和测试时提供可伸缩性。在一系列旨在测试竞争抽样方案的统计行为和实际结果的实验中,作者从经验上证明了用解耦抽样方法绘制的函数可以真实地表示高斯过程的后验,而代价只是通常情况下的一小部分。

![]()

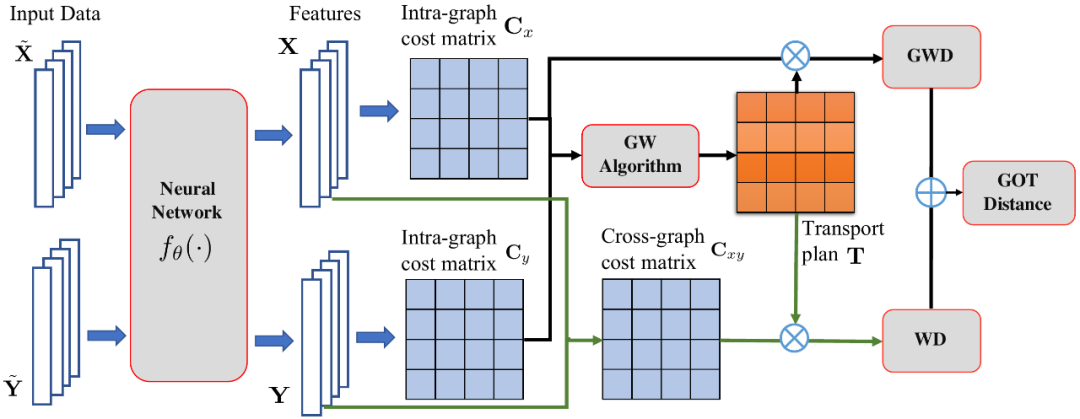

Graph Convolutional Network for Recommendation with Low-pass Collaborative Filters

简介:带低通协同滤波器的图卷积网络(GCN)广泛应用于推荐等图形数据学习任务中。然而,当面对一个大的图时,图的卷积计算量非常大,因而在现有的所有 GCN 中都被简化,但由于过于简化而严重受损。为了解决这一差距,作者利用 GCN 中的原始图卷积,提出了一种低通协作滤波器(LCF),使其适用于大图。LCF 的设计是为了消除观测数据中由于曝光和量化而产生的噪声,并且在无损的情况下降低了图形卷积的复杂度。实验表明,LCF 提高了图卷积的效率和效率,并且本文的 GCN 明显优于现有的GCN。

表示

![]()

![]()

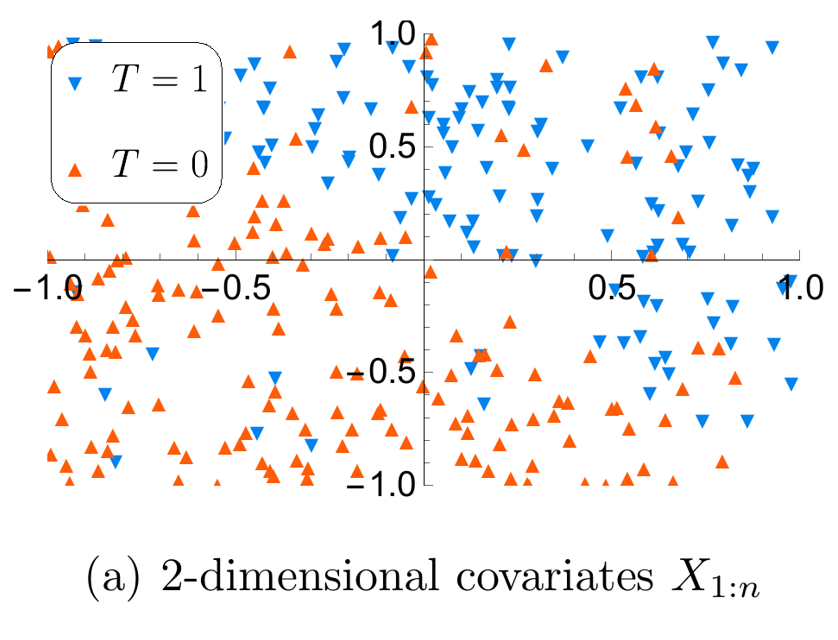

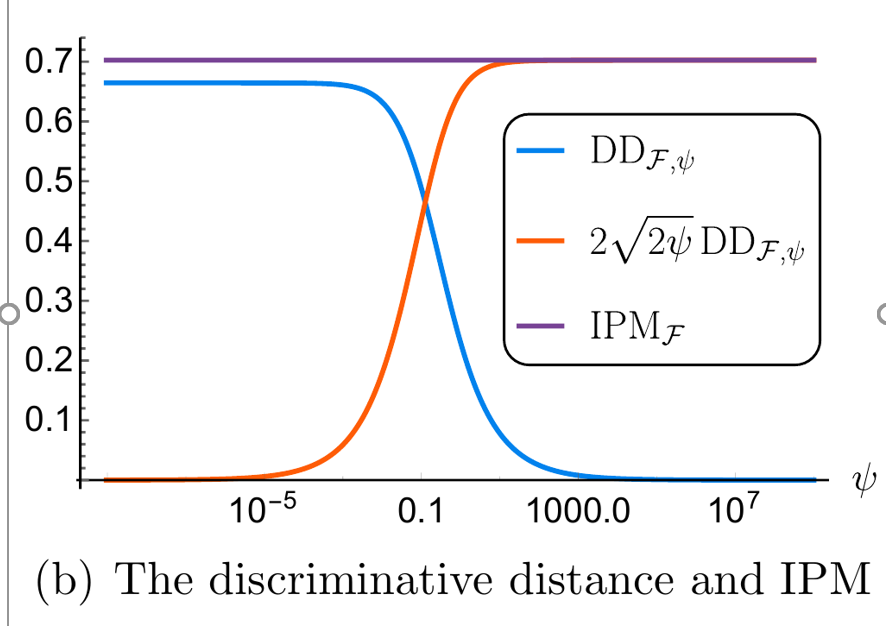

DeepMatch: Balancing Deep Covariate Representations for Causal Inference Using Adversarial Training

简介:当丰富的协变量和复杂的关系需要使用神经网络进行灵活的建模时,作者研究从观测数据进行因果推断的最优协变量平衡。标准方法,如倾向权重和匹配/平衡,在这种情况下失败是由于错误的倾向网络和不适当的协变量表示。作者提出了一种新的方法,基于一个加权和一个鉴别器网络的对抗性训练,有效地解决了这一方法上的差距。这一点通过该方法的新理论特征以及使用全连接结构学习复杂关系和卷积结构来处理图像混淆的实证结果来证明这一新方法如何能够在这些具有挑战性的环境中进行强有力的因果分析。

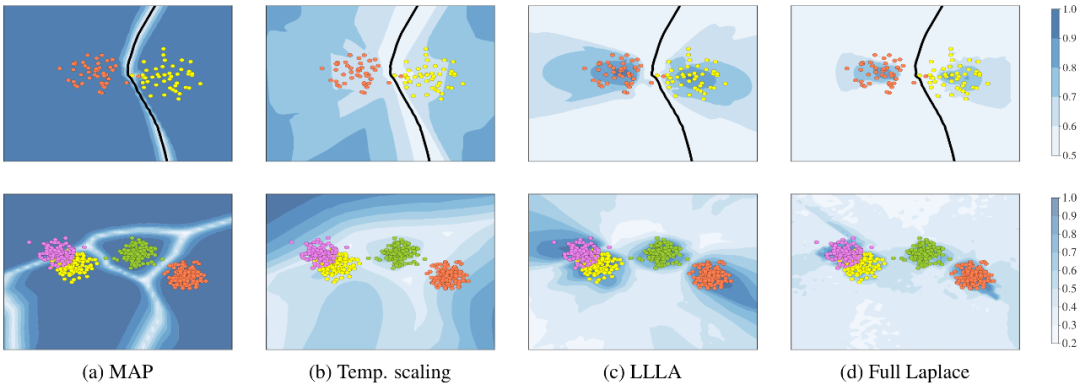

Being Bayesian, Even Just a Bit, Fixes Overconfidence in ReLU Networks

![]()

作者:Kristiadi Agustinus,Hein Matthias,Hennig Philipp

简介:ReLU 分类网络——可以说是应用最广泛的神经网络结构——的点估计已经被证明可以在远离训练数据的情况下产生任意高的置信度。这种结构与最大后验概率估计方案相结合,既不校准也不鲁棒。虽然贝叶斯近似的理论分析是有限的,但是经验证明近似贝叶斯推理可以改善神经网络的预测不确定性。作者从理论上分析了 ReLU 网络权值的近似高斯后验分布,并证明它们解决了过度自信问题。此外,作者还表明,即使是一个简单化的,因此便宜的贝叶斯近似,也可以解决这些问题。这表明,ReLU 网络中校准不确定度的一个充分条件是“有点贝叶斯”。这些理论结果验证了最后一层贝叶斯近似的使用,并激发了一系列保真度成本权衡。本文通过各种标准实验进一步验证了这些发现,这些实验使用普通的 deep ReLU 网络和 Laplace 近似。

![]()

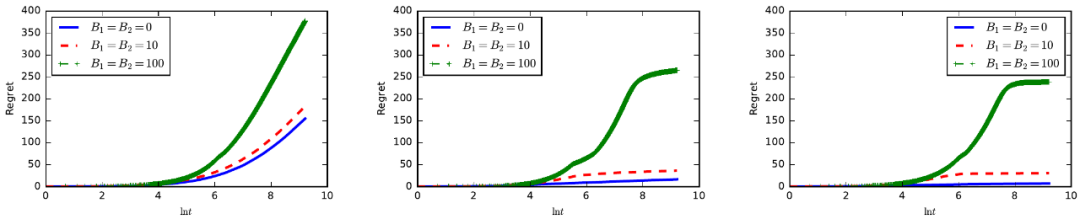

The Intrinsic Robustness of Stochastic Bandits to Strategic Manipulation

作者:

Zhe Feng

,

David C. Parkes

,

Haifeng Xu

简介:作者研究了随机bandits算法在理性参与者(即arms)的策略行为下的行为。每一只手臂都是一个策略玩家,它可以根据跨时期的预算约束来修改自己的奖励。每只手臂都有自己的兴趣,并寻求最大化自己被拉过一个决策线期望次数。策略操纵自然而然地出现在各种经济应用中,例如 Yelp 和 Amazon 等推荐系统。作者分析了三种流行的 banditor 算法:UCB、ε-贪心算法和Thompson抽样算法的鲁棒性。证明了在策略手臂的任何(可能适应性)策略下,这三种算法都能达到令人遗憾的上界O(max{B,lnT}),其中 B 为手臂的总预算。而且,作者证明本文的遗憾上限是正确的。本文的结果说明了只要 B=O(T),bandits 算法对策略操纵的内在鲁棒性。这与更悲观的对抗策略模型形成了鲜明的对比,在这种模型中,攻击预算O(lnT)可以欺骗 UCB 和 ε- 贪心者只拉动O(T)次最优的手臂。本文的结果适用于有界和无界的回报。

![]()

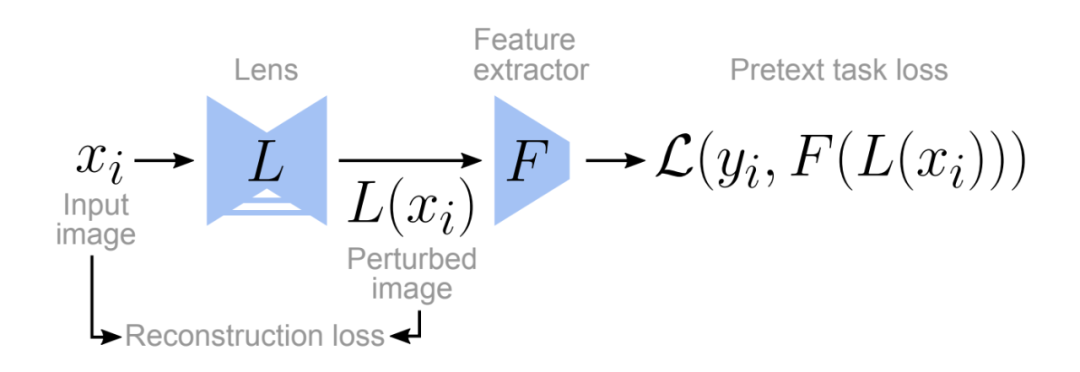

Automatic Shortcut Removal for Self-Supervised Representation Learning

作者:Minderer Matthias,Bachem Olivier,Houlsby Neil,Tschannen Michael

简介:在自监督视觉表征学习中,特征抽取器被训练在一个“pretext任务”上,该任务可以廉价地生成标签。这种方法的一个主要挑战是特征抽取器很快学会利用低级视觉特征,如色差或水印,然后无法学习有用的语义表示。许多工作已经投入到识别这些“快捷”功能和手工设计方案来减少它们的影响。在这里,作者提出了一个自动删除快捷方式功能的通用框架。关键假设是,那些首先被用来解决 pretext 任务的特征,也可能是最容易受到训练使任务变得更困难的对手的攻击。作者通过训练一个“镜头”网络来进行小的图像改变,从而最大限度地降低 pretext 任务的性能,从而证明了这一假设在常见的 pretext 任务和数据集中都是成立的。在所有测试案例中,使用修改后的图像学习的表现优于未经修改的图像。此外,镜头所做的修改揭示了 pretext 任务和数据集的选择如何影响自我监督学习的特征。

ICML 2020 已经接近尾声,想了解关于本次会议的更多信息可进入 AMiner

ICML 顶会系统

查看。AMiner 系统提供论文收录下载,热点统计,最佳论文解读,论文概要,论文精读,会议论文 ppt 讲解视频,华人作者、华人一作学生统计,按主题搜论文,按作者搜论文等一系列方便功能,是参会者与研究人员及对会议感兴趣的AI从业者及学生的便利工具。

![]()

![]()

喜欢本篇内容,请

分享、点赞、

在看

![]()