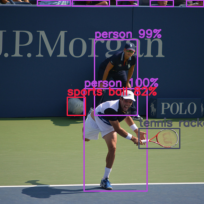

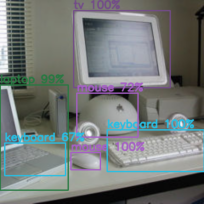

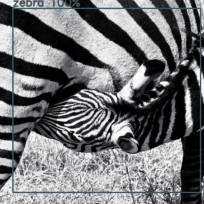

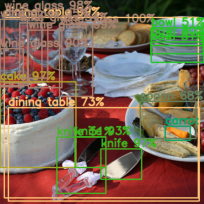

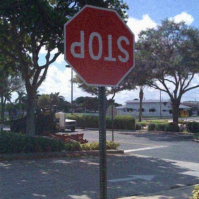

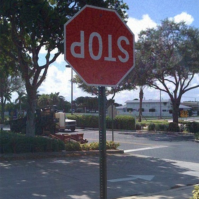

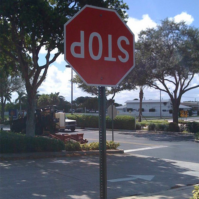

Recent advances in machine learning show that neural models are vulnerable to minimally perturbed inputs, or adversarial examples. Adversarial algorithms are optimization problems that minimize the accuracy of ML models by perturbing inputs, often using a model's loss function to craft such perturbations. State-of-the-art object detection models are characterized by very large output manifolds due to the number of possible locations and sizes of objects in an image. This leads to their outputs being sparse and optimization problems that use them incur a lot of unnecessary computation. We propose to use a very limited subset of a model's learned manifold to compute adversarial examples. Our \textit{Focused Adversarial Attacks} (FA) algorithm identifies a small subset of sensitive regions to perform gradient-based adversarial attacks. FA is significantly faster than other gradient-based attacks when a model's manifold is sparsely activated. Also, its perturbations are more efficient than other methods under the same perturbation constraints. We evaluate FA on the COCO 2017 and Pascal VOC 2007 detection datasets.

翻译:机器学习的最新进展表明,神经模型很容易受到最小扰动投入或对抗性实例的影响。反向算法是优化问题,通过扰动输入使ML模型的准确性最小化,常常使用模型损失功能来制造这种扰动。由于图像中可能存在的位置和物体大小,因此最先进的天体探测模型具有非常大的产出方块的特征。这导致其产出稀少,优化问题导致大量不必要的计算。我们提议使用一个非常有限的模型所学多元子组来计算对抗性实例。我们的 \ textit{Focused Aversarial attack}(FA)算法确定了一小部分敏感区域来进行基于梯度的对抗性攻击。当模型的元件被分散激活时,FA比其他梯度攻击要快得多。此外,在相同的扰动限制下,其扰动率比其他方法更有效。我们用CO 2017 和 Pascal VOC 2007 探测数据集评估FA 。