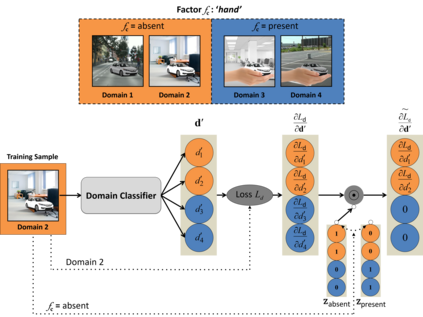

Domain Adaptation (DA) is a highly relevant research topic when it comes to image classification with deep neural networks. Combining multiple source domains in a sophisticated way to optimize a classification model can improve the generalization to a target domain. Here, the difference in data distributions of source and target image datasets plays a major role. In this paper, we describe based on a theory of visual factors how real-world scenes appear in images in general and how recent DA datasets are composed of such. We show that different domains can be described by a set of so called domain factors, whose values are consistent within a domain, but can change across domains. Many DA approaches try to remove all domain factors from the feature representation to be domain invariant. In this paper we show that this can lead to negative transfer since task-informative factors can get lost as well. To address this, we propose Factor-Preserving DA (FP-DA), a method to train a deep adversarial unsupervised DA model, which is able to preserve specific task relevant factors in a multi-domain scenario. We demonstrate on CORe50, a dataset with many domains, how such factors can be identified by standard one-to-one transfer experiments between single domains combined with PCA. By applying FP-DA, we show that the highest average and minimum performance can be achieved.

翻译:在与深神经网络进行图像分类时,域适应(DA)是一个高度相关的研究主题。将多种源域以精密的方式组合成优化分类模型,可以改进对目标域的概括性。这里,源数据和目标图像数据集的数据分布差异起着主要作用。在本文中,我们根据视觉因素理论描述图像中真实世界场景的一般表现方式,以及最近DA数据集的构成方式。我们显示,不同领域可以通过一系列所谓的域因子来描述,这些域因子的数值在域内是一致的,但可在各域间发生变化。许多DA方法试图将所有域因子表示方式从功能表示中去除所有域因地处变化而成为域域。在本文中,我们表明,由于任务强化因素也会丢失,这可能导致负面的转移。为了解决这个问题,我们建议采用保理-保有DA(FP-DA)这一方法来培养一种深层次的对抗性、不受监督的DA模型,该模型能够在多个域内保存具体的任务相关因素,但可在多个域间变化。我们用CORe50进行演示,一个与许多域的数据集组合,通过许多域的组合,可以把这种因素与最起码的域用来显示一个标准的MAPAA。