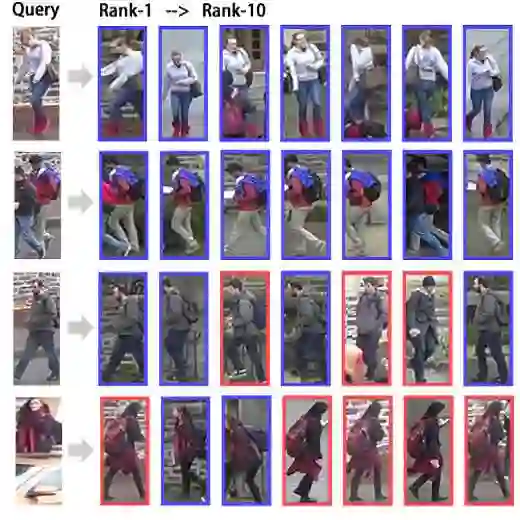

Attention mechanisms have been widely used in deep learning, and recent efforts have been devoted to incorporating attention modules into deep neural networks (DNNs) for person Re-Identification (Re-ID) to enhance their discriminative feature learning capabilities. Existing attention modules, including self-attention and channel attention, learn attention weights that quantify the importance of feature tokens or feature channels. However, existing attention methods do not explicitly ensure that the attention weights are informative for predicting the identity of the person in the input image, and may consequently introduce noisy information from the input image. To address this issue, we propose a novel method termed Reduction of Information Bottleneck loss (RIB), motivated by the principle of the Information Bottleneck (IB). A novel distribution-free and efficient variational upper bound for the IB loss (IBB), which can be optimized by standard SGD, is derived and incorporated into the training loss of the RIB models. RIB is applied to DNNs with self-attention modules through a novel Differentiable Channel Selection Attention module, or DCS-Attention, that selects the most informative channels for computing attention weights, leading to competitive models termed RIB-DCS. RIB is also incorporated into DNNs with existing channel attention modules to promote the learning of informative channel attention weights, leading to models termed RIB-CA. Both RIB-DCS and RIB-CA are applied to fixed neural network backbones and learnable backbones with Differentiable Neural Architecture Search (DNAS). Extensive experiments on multiple person Re-ID benchmarks show that RIB significantly enhances the prediction accuracy of DNNs for person Re-ID, even for the occluded person Re-ID.

翻译:注意力机制已广泛应用于深度学习领域,近期研究致力于将注意力模块融入深度神经网络(DNN)以增强行人重识别(Re-ID)的判别性特征学习能力。现有注意力模块(包括自注意力与通道注意力)通过学习注意力权重来量化特征标记或特征通道的重要性。然而,现有注意力方法未能明确保证所学注意力权重对预测输入图像中行人身份具有信息性,因而可能引入输入图像中的噪声信息。为解决此问题,受信息瓶颈(IB)原理启发,我们提出一种称为信息瓶颈损失缩减(RIB)的新方法。本文推导出一种无需分布假设且高效的信息瓶颈损失变分上界(IBB),该上界可通过标准随机梯度下降(SGD)进行优化,并将其整合至RIB模型的训练损失中。通过新型可微分通道选择注意力模块(DCS-Attention)——该模块选择最具信息性的通道以计算注意力权重,RIB被应用于配备自注意力模块的DNN,由此构建出具有竞争力的RIB-DCS模型。同时,RIB也被整合至配备现有通道注意力模块的DNN中,以促进信息性通道注意力权重的学习,形成RIB-CA模型。RIB-DCS与RIB-CA均被应用于固定神经网络骨干架构及采用可微分神经架构搜索(DNAS)的可学习骨干架构。在多个行人重识别基准数据集上的大量实验表明,RIB能显著提升DNN在行人重识别任务中的预测准确率,即使在遮挡行人重识别场景下亦表现优异。