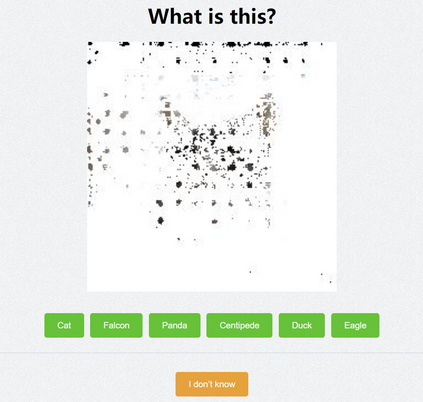

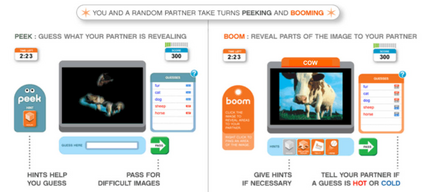

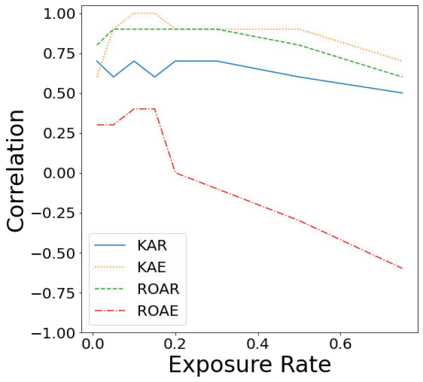

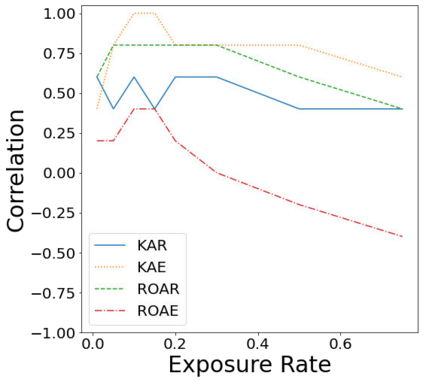

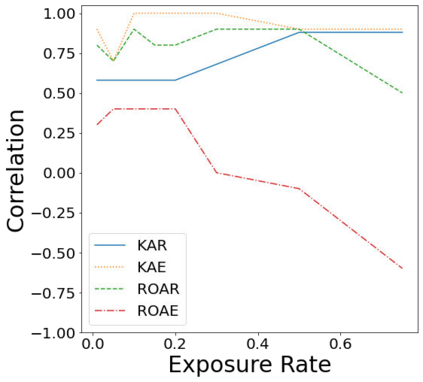

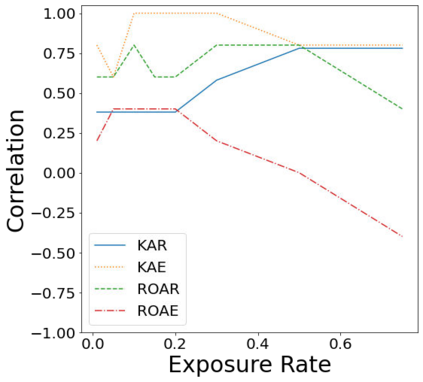

Understanding the reasons behind the predictions made by deep neural networks is critical for gaining human trust in many important applications, which is reflected in the increasing demand for explainability in AI (XAI) in recent years. Saliency-based feature attribution methods, which highlight important parts of images that contribute to decisions by classifiers, are often used as XAI methods, especially in the field of computer vision. In order to compare various saliency-based XAI methods quantitatively, several approaches for automated evaluation schemes have been proposed; however, there is no guarantee that such automated evaluation metrics correctly evaluate explainability, and a high rating by an automated evaluation scheme does not necessarily mean a high explainability for humans. In this study, instead of the automated evaluation, we propose a new human-based evaluation scheme using crowdsourcing to evaluate XAI methods. Our method is inspired by a human computation game, "Peek-a-boom", and can efficiently compare different XAI methods by exploiting the power of crowds. We evaluate the saliency maps of various XAI methods on two datasets with automated and crowd-based evaluation schemes. Our experiments show that the result of our crowd-based evaluation scheme is different from those of automated evaluation schemes. In addition, we regard the crowd-based evaluation results as ground truths and provide a quantitative performance measure to compare different automated evaluation schemes. We also discuss the impact of crowd workers on the results and show that the varying ability of crowd workers does not significantly impact the results.

翻译:深入神经网络的预测背后的原因对于获得人类对许多重要应用的信任至关重要,这反映在近年来AI(XAI)对解释性的需求日益增加。基于光度特征归属方法,强调有助于分类者决策的图像的重要部分,往往被用作XAI方法,特别是在计算机视觉领域。为了从数量上比较各种基于显著的XAI方法,提出了几种自动评价计划的方法;然而,不能保证这种自动评价指标正确评价解释性,自动化评价计划评级高并不一定意味着对人类产生高度影响。在本研究中,我们提议采用新的基于人的评价计划,利用众包评估XAI方法,以评价人造数据。我们的方法受到人类计算游戏“Peek-a-boom”的启发,通过利用人群的力量可以有效地比较不同的XAI方法。我们用自动化和以人群为基础的评价计划评价方法评估各种不同方法的显著差异图。我们进行的实验表明,我们基于人群的评估结果是不同的地面评估计划。我们对于基于众组评估计划的结果的自动化评估的结果,我们用不甚易懂。我们之间的比较表明,对基于众组评估计划的结果是不同的实地评估计划的结果。我们用不同的评估方法来进行不同的评估。