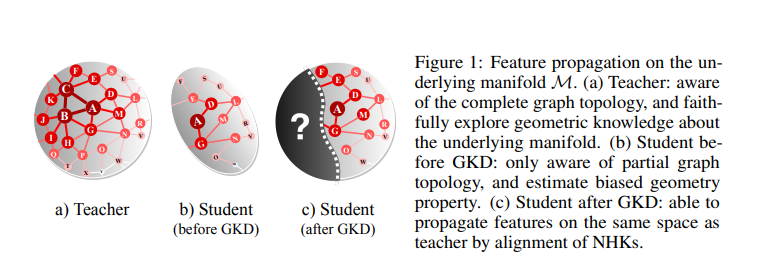

本文研究了一种知识迁移的新范式,旨在通过将知识从在完全图上训练的教师GNN模型提取到在更小或更稀疏的图上操作的学生GNN模型,将图拓扑信息编码到图神经网络(GNN)中。为此,我们回顾了热力学和GNN行为之间的联系,在此基础上,我们提出了神经热核(NHK)来封装与GNN体系结构有关的底层流形的几何特性。一个基本的和原则性的解决方案是通过对齐教师和学生模型的NHKs,称为几何知识蒸馏。我们开发了非参数实例化和参数化实例化,并在不同的实验设置中演示了它们的有效性,用于不同类型的特权拓扑信息和师生方案的知识蒸馏。

https://arxiv.org/pdf/2210.13014.pdf

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年12月31日

Arxiv

13+阅读 · 2018年9月7日