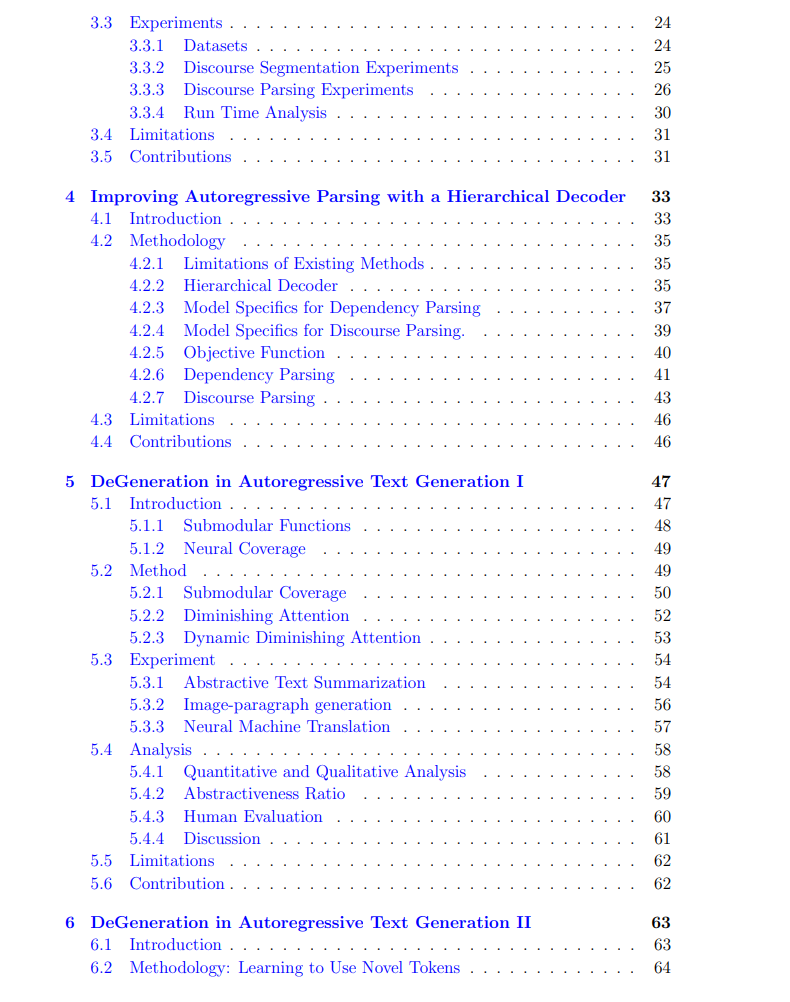

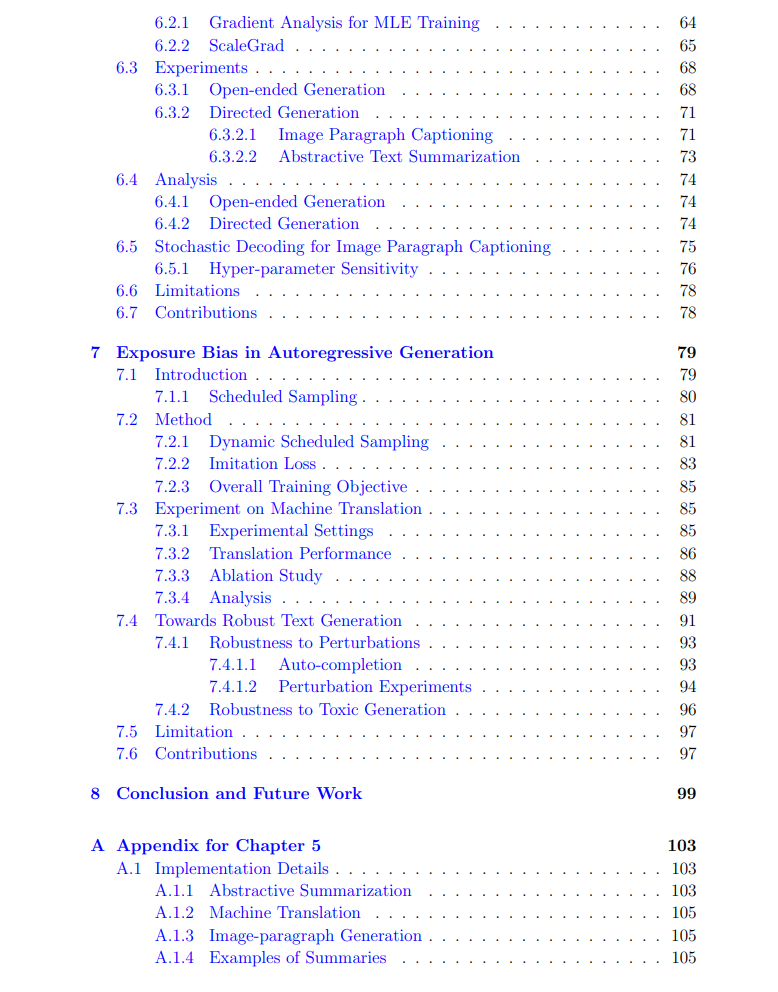

深度学习的进步在许多自然语言处理(NLP)任务中取得了巨大成就。考虑到语言的性质,即序列数据,大多数NLP任务可以框架化为序列学习框架,如文本生成。作为现代NLP技术最重要的基础之一,自回归生成模型在大量NLP任务中实现了卓越的表现。因此,本论文强调了针对不同NLP任务改进自回归生成模型的重要性。尽管许多任务可以自然地适应序列学习框架,但其中一些任务,例如构建话语解析树,需要复杂的设计才能适应神经模型。因此,本论文首先强调了一个新颖的统一框架用于话语解析,该框架以自顶向下的深度优先方式构建话语树,并将任务框架为一个自回归生成任务,其目标是预测给定文本片段的节点位置。所提出的方法通过广泛的实证实验证明是有效的。

此外,我通过提出一个层次解码器扩展了上述框架,该解码器利用了当前处理节点的父节点和兄弟节点的信息。所提出的解码器利用了树结构的性质,并进一步提高了话语解析和依存解析任务的实验性能。 另一方面,用于训练自回归生成模型的事实策略,即交叉熵损失和教师强制,在某些方面被证明是有问题的。例如,交叉熵损失,作为一种广泛使用的训练目标函数,常常导致文本生成中的文本退化,而教师强制则遭受曝光偏差问题,即训练和测试设置之间存在不匹配。针对文本退化,我引入了一类递减注意力机制,该机制强制序列到序列模型中通过交叉注意力计算的覆盖度的次模性。所提出的递减注意力在几个神经文本生成任务上取得了显著改进,包括文本摘要、机器翻译和图像段落生成。

进一步,我提出了一个新的训练目标ScaleGrad,以替代交叉熵,显著减少了不同文本生成任务中的退化问题。实际上,ScaleGrad可以扩展到文本退化之外的问题。它为通过直接修改输出层中的梯度信息将不同的归纳偏差注入文本生成模型提供了广泛的灵活性。

接下来,对于曝光偏差问题,本论文引入了一种基于训练准确性的新型计划采样,与现有的计划采样方法相比,只需要极少的超参数调整。此外,提出了一种新颖的模仿损失,以进一步强制模型的生成行为与教师强制行为相匹配。此外,本论文证明,减少曝光偏差可以提高语言模型对重复和有害错误的鲁棒性。