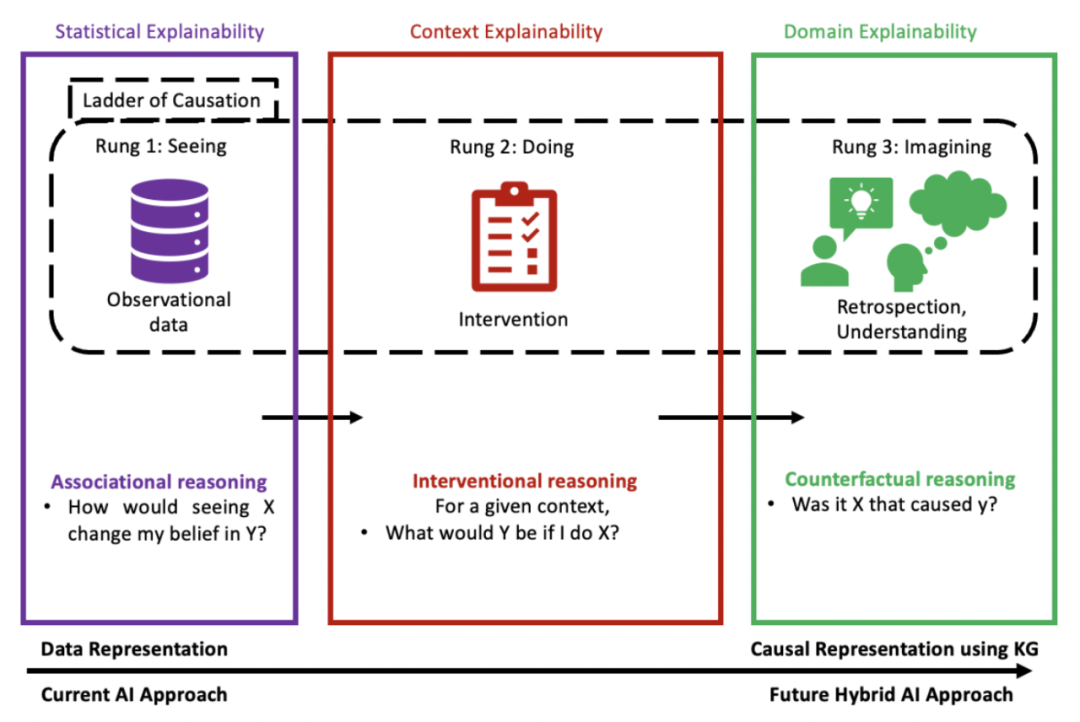

图1 网络和医疗保健中的因果AI:从基于数据表示和关联支持的统计解释性,到基于因果关系和干预支持的情境解释性,最后导向基于知识图谱中的因果表示的领域解释性,从而得到反事实支持。CCS概念:• 人工智能 → 因果AI; • 机器学习 → 解释性; • 自然语言理解; • 本体论 → 知识图谱;

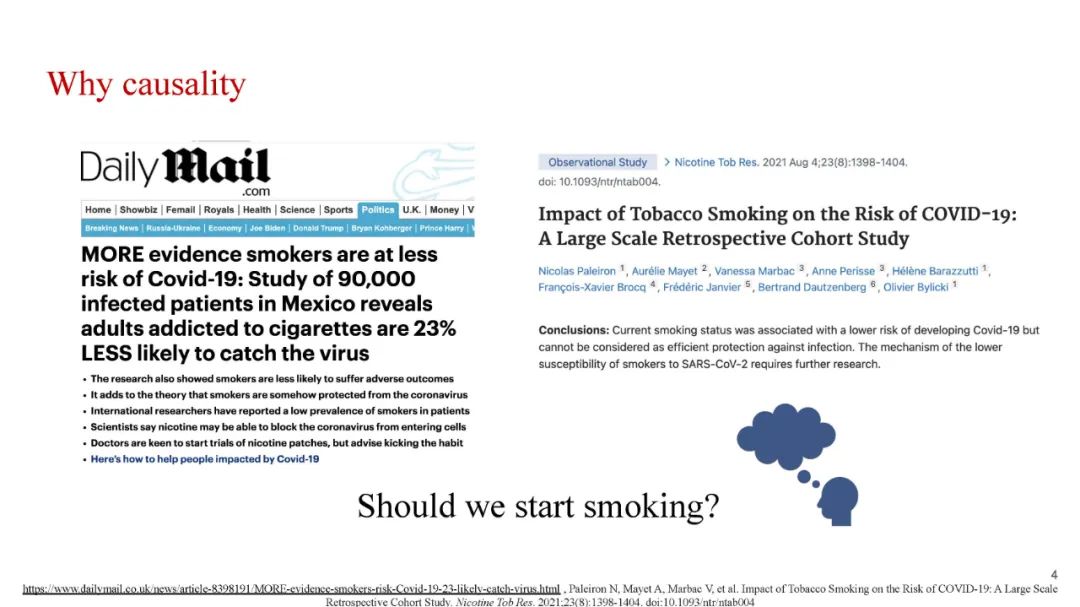

提高ML算法的性能和解释性是人类在现实世界中采用这些算法的首要任务。在像医疗保健这样的关键领域,这项技术有着显著的潜力,能够减轻人类的负担,并通过提供大规模的高质量辅助,大幅减少人工评估。在当今的数据驱动世界,人工智能(AI)系统仍然面临偏见、解释性、人类般的推理和解释能力等问题。因果AI是一种可以进行推理和做出类人选择的技术,使其有可能超越狭义的基于机器学习的技术,并可以整合到人类的决策制定中。它还提供了内在的解释性,新领域的适应性,无偏预测,并能处理所有大小的数据集。在这个讲座风格的教程中,我们详细介绍了如何在AI系统中使用知识图谱(KG)基础的方法来更丰富地表示因果性,这对干预和反事实推理(图1)是必要的,我们如何达到基于模型和领域的解释性,因果表示如何帮助网络和医疗保健。

1 教程时间表和活动 本教程主要包含以下四个模块:(10分钟)AI当前的状况:我们首先激发了在医疗保健和分析网络数据时,需要因果AI的动机。我们会给出实际网络例子,突显了现有的统计和数据驱动的AI系统的限制。开场环节将强调创建可理解的可解释AI系统需要因果AI。(25分钟)因果知识图谱开发:因果知识图谱(CausalKG)是迈向基于因果关系的知识灌输学习的符号人工智能的一步。我们证明使用CausalKG的系统不仅仅从相关性中学习,相反,它们对周围环境有着因果理解。除了因果性,CausalKG还使用知识图谱(KG),这也代表了空间,时间和交互。今天使用的AI算法依赖于均匀分布的、独立的数据,这些数据无法推导出假设性的、干预性的场景或超出分布的情况。我们展示了如何启用可能由观察数据和领域专家知识推导出来的干预和反事实推理,以及如何利用CausalKG将领域的因果知识融入当前的KG。我们讨论了构建一个因果知识图谱的过程,该图谱有助于将因果性纳入推理和预测过程,比如理解、规划和诊断医疗状况等。(25分钟)基于本体论和知识的因果解释推理:我们构建了一个推理系统,用于记录基于因果断言的解释,这些断言使用的是形式为关系和子类层次结构的本体论。我们首先构建本体论,使我们能够表达一个事实如何导致另一个事实,以及一个事实如何解释另一个事实。我们提供了一套正式的模式提取,这些因果关系从因果主张转向解释。这些模式展示了被认为是在解释性声明和算法预测上达成判断所必需的本体论原则。我们还介绍了药物滥用本体论,这是一个识别网络数据和精神卫生领域模式的本体论框架。