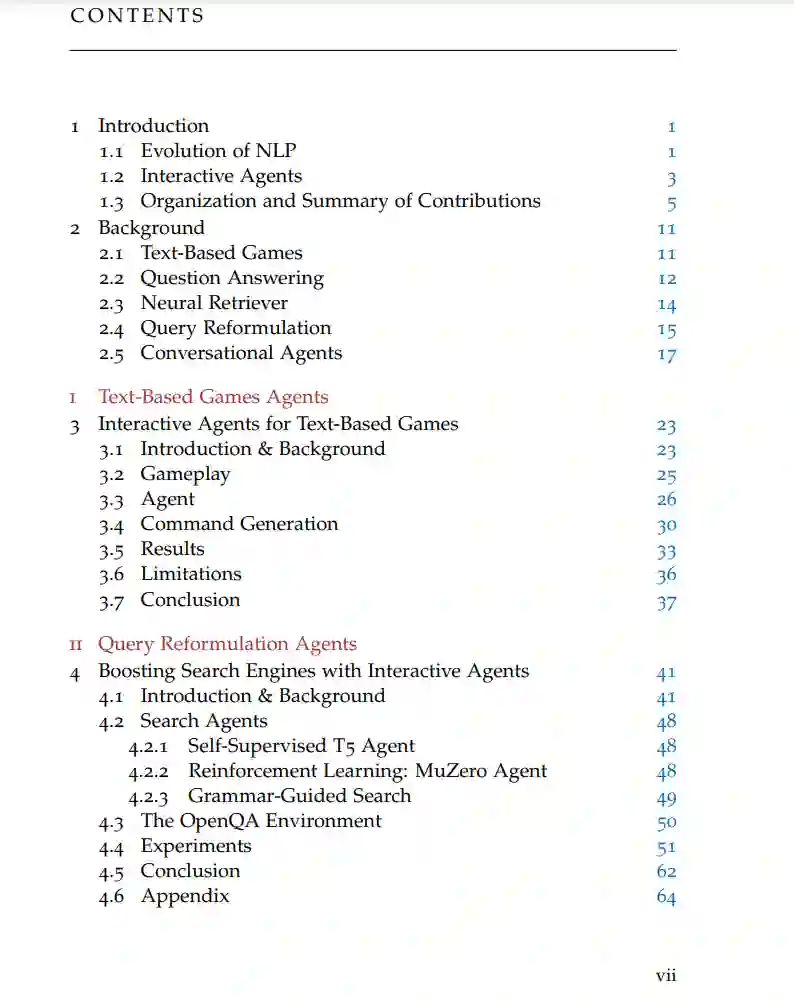

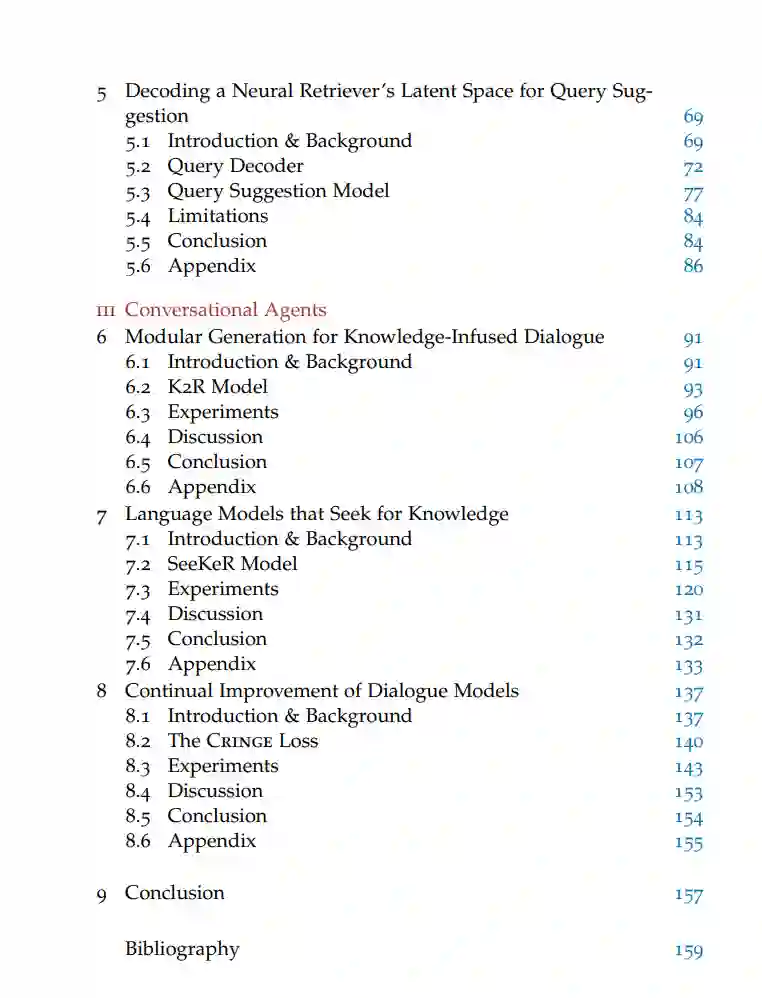

近年来,深度神经网络架构在自然语言处理(NLP)领域取得了显著成就。通过放大模型大小并在互联网上可用的大量文本数据上进行自监督预训练,即使在提供少量具体示例时,也解锁了泛化和复杂推理能力。然而,NLP的大部分进展都是基于静态学习范例进行的,其中模型在固定数据集上进行一次训练以学习特定技能,并在此后保持固定。在本论文中,我们将注意力转向NLP的交互式智能体,即与动态环境或用户互动的基于语言的模型。在三个不同的应用领域,(i)基于文本的游戏,(ii)查询重构,以及(iii)对话,我们调查并开发与不同形式的自适应环境互动的智能体。论文分为三部分,反映了三个应用领域。在第一部分,我们为基于文本的游戏开发了一个深度强化学习(RL)智能体,该智能体能够在结构相似但带有新对象和指令的游戏家族中进行泛化。第二部分重点关注查询重构,我们从两个角度进行研究。首先,我们考虑学习搜索问题,其中智能体被训练为使用自然语言与信息检索(IR)系统互动。观察IR组件的结果,它调整初始用户查询并收集一个改进的证据文档集。在此设置中,我们开发了两个学习成功的交互式搜索策略的智能体:一个通过纯强化学习训练的模型,另一个通过(自我)监督学习。在随后的章节中,我们将注意力转向神经检索模型,并为交互式查询建议开发智能体。为此,我们训练了一个查询解码器模型,该模型在共享段落-查询嵌入空间中的给定点生成相应的文本形式的查询。我们使用此解码器生成方向性查询细化的合成数据集,我们使用它来训练一个强大的重构模型。在论文的最后部分,我们提出了不同的方法来开发对话智能体。我们建议模块化对话模型的架构,以输出随后的模块所基于的中间文本序列。首先,我们表明,在对话响应之前生成知识输出作为中间步骤可以增加在开放域对话中的知识利用和事实正确性。接下来,我们开发了一个依次生成(i)搜索引擎查询,(ii)知识输出,以及(iii)最终响应的单一模型。我们表明,它在知识为基础的对话上超越了先前的最先进的对话模型,并在主题提示完成上超越了具有大量参数的模型。最后,我们探讨在部署后如何改进对话模型,并提出了一个目标,该目标允许在其生成的二进制标记示例上迭代训练语言模型。