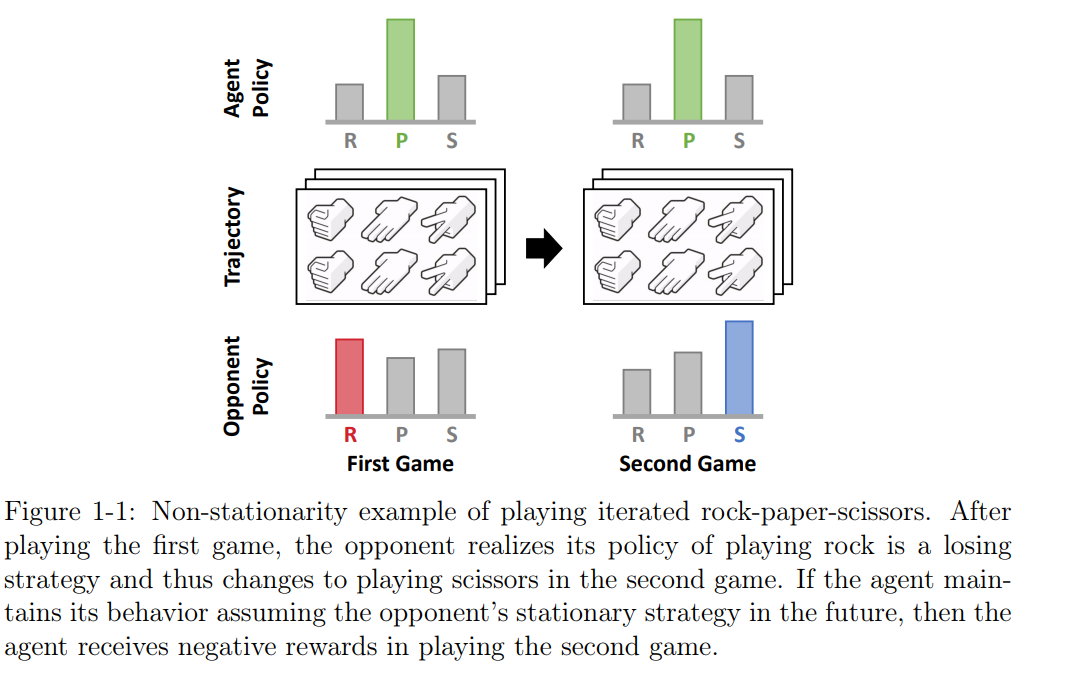

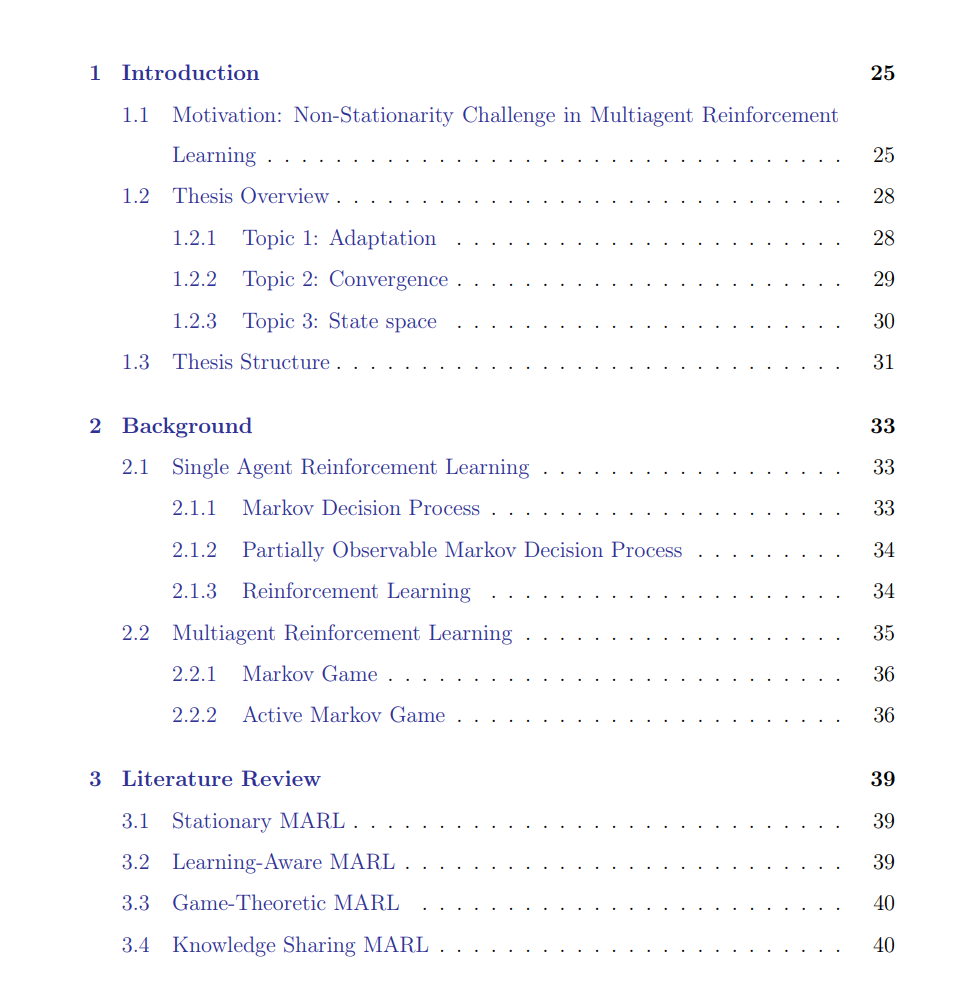

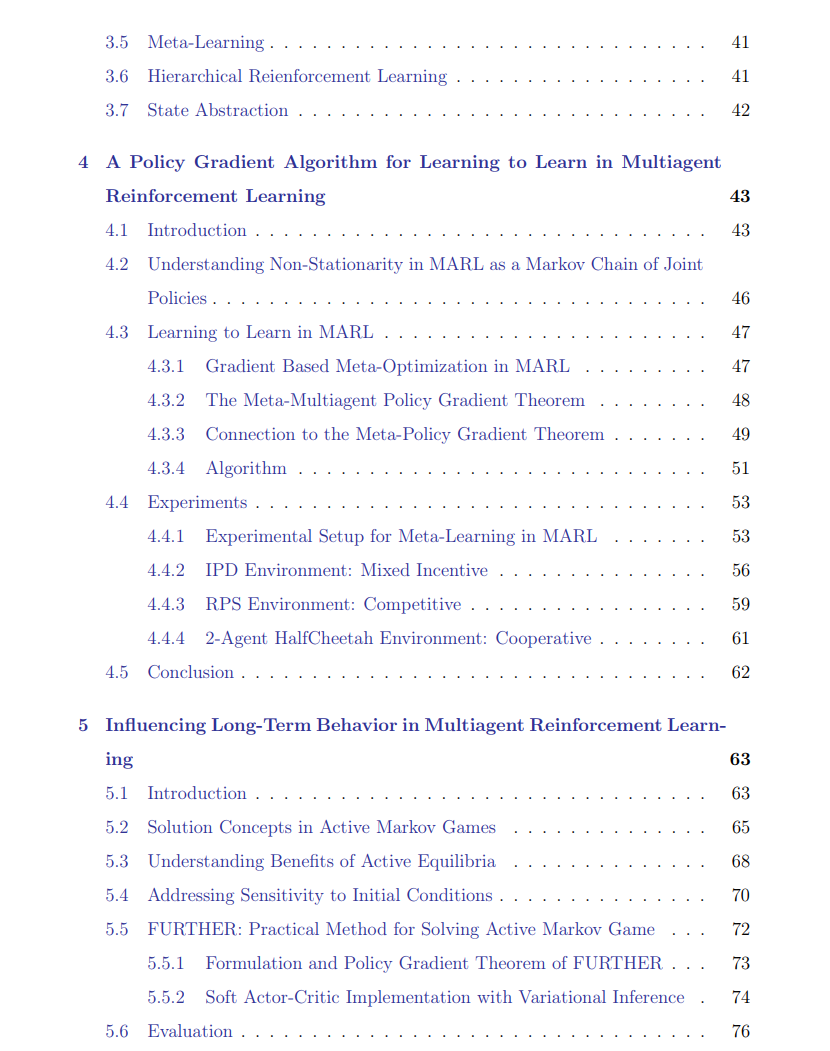

多智能体强化学习(MARL)为一组人工智能代理提供了一个有原则的框架,使它们能够在人类专家水平上学习协作和/或竞争行为。多智能体学习环境本质上比单智能体学习解决了更复杂的问题,因为代理既与环境互动,也与其他代理互动。特别是,在MARL中,多个代理同时学习,导致在遇到的经验中产生自然的非平稳性,因此要求每个代理在其他代理策略可能发生较大变化的情况下调整其行为。本论文旨在从三个重要主题来解决多智能体学习中的非平稳性挑战:1)适应性,2)收敛性,3)状态空间。第一个主题解答了代理如何通过开发新的元学习框架来学习有效的适应策略,以应对其他代理不断变化的策略。第二个主题解答了代理如何适应并影响联合学习过程,使得基于新的博弈论解决方案概念,策略在学习结束时收敛到更理想的极限行为。最后,最后一个主题解答了如何基于知识共享和上下文特定抽象来减小状态空间大小,从而使学习复杂性受到非平稳性的影响较小。总之,本论文发展了理论和算法贡献,为上述关于非平稳性的主题提供了有原则的解答。本论文中开发的算法在多智能体基准领域的多样化套件中展示了其有效性,包括混合激励、竞争和合作环境的全谱。

成为VIP会员查看完整内容

相关内容

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

Arxiv

16+阅读 · 2021年5月26日

Arxiv

20+阅读 · 2020年3月10日