题目: Convolutional Kernel Networks for Graph-Structured Data

摘要:

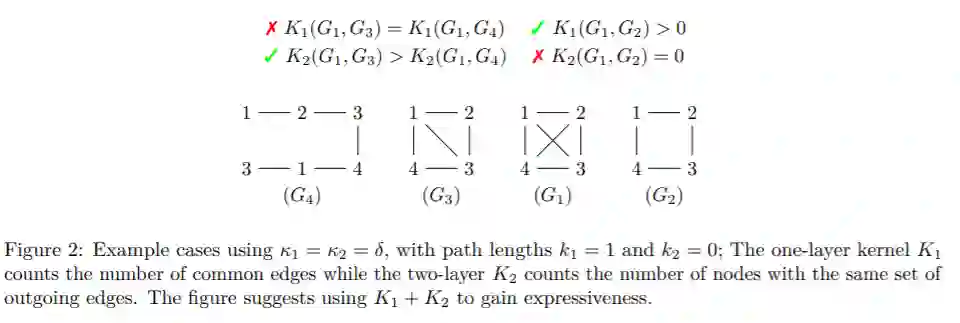

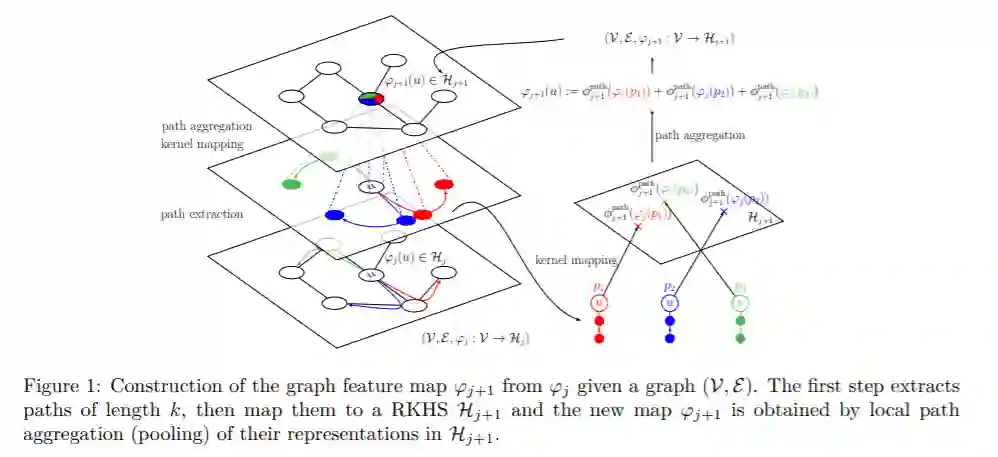

本文介绍了一系列多层图核,并在图卷积神经网络和核方法之间建立了新的联系。该方法通过将图表示为一系列内核特征图来概括卷积核网络以绘制结构化数据图,其中每个节点都承载有关局部图子结构的信息。一方面,内核的观点提供了一种无监督,表达性强且易于调整的数据表示形式,这在有限样本可用时非常有用。另一方面,我们的模型也可以在大规模数据上进行端到端训练,从而产生新类型的图卷积神经网络。并且证明了该方法在几种图形分类基准上均具有竞争优势,同时提供了简单的模型解释。

成为VIP会员查看完整内容

相关内容

专知会员服务

78+阅读 · 2020年3月1日

专知会员服务

76+阅读 · 2020年1月16日

Arxiv

14+阅读 · 2019年3月5日